Tác giả: Kyle Wiggers @kyle_l_wiggers / 6:30 sáng PDT • Ngày 4 tháng 9 năm 2023

Các mô hình ngôn ngữ lớn (LLM) như ChatGPT của OpenAI đều gặp phải vấn đề tương tự: chúng tạo ra thông tin không có thật.

Các sai lầm biến đổi từ những thông tin kỳ lạ và vô hại — như khẳng định rằng cầu cổng vàng đã được vận chuyển qua Ai Cập vào năm 2016 — đến những vấn đề vô cùng nguy hiểm.

Mới đây, một thị trưởng ở Australia đã đe dọa kiện OpenAI vì ChatGPT đã sai lầm khi khẳng định ông ta đã thú nhận tội trong một vụ tham nhũng lớn. Các nhà nghiên cứu đã phát hiện ra rằng việc mô hình LLM gây ra hiện tượng ảo tưởng có thể bị lợi dụng để phân phối các gói mã độc hại đến các nhà phát triển phần mềm không hay biết. Ngoài ra, LLMs thường đưa ra lời khuyên về tâm lý và y tế không tốt, như rằng tiêu thụ rượu có thể “ngăn ngừa ung thư.”

Tendency này trong việc tạo ra “sự thật” không có thật được gọi là hiện tượng ảo tưởng, và nó xảy ra do cách mà các LLMs hiện nay — và tất cả các mô hình Trí tuệ Nhân tạo tạo ra thông tin — được phát triển và huấn luyện.

Huấn luyện mô hình

Các mô hình Trí tuệ Nhân tạo tạo sinh không có trí thông minh thực sự — chúng là các hệ thống thống kê dự đoán từ vựng, hình ảnh, giọng nói, âm nhạc hoặc dữ liệu khác. Được cung cấp một số lượng lớn ví dụ, thường được lấy từ web công cộng, các mô hình Trí tuệ Nhân tạo học cách xác định khả năng xảy ra của dữ liệu dựa trên các mẫu, bao gồm bối cảnh của dữ liệu xung quanh.

Ví dụ, với một email thông thường kết thúc bằng đoạn “Mong chờ…”, một LLM có thể hoàn thiện nó bằng “…để nhận được phản hồi” — tuân theo mẫu của hàng triệu email mà nó đã được huấn luyện. Điều này không có nghĩa là LLM đó đang mong đợi điều gì cả.

“Khung làm việc hiện tại trong việc huấn luyện các LLMs bao gồm việc che giấu, hoặc ‘khiến mờ,’ các từ trước đó để tạo bối cảnh,” Sebastian Berns, một nghiên cứu viên tiến sĩ tại Đại học Queen Mary London, cho biết trong cuộc phỏng vấn qua email với TechCrunch. “Điều này có tính chất tương tự việc sử dụng chức năng dự đoán từ vựng trên iOS và liên tục nhấn vào một trong các từ gợi ý tiếp theo.”

Phương pháp dựa trên xác suất này hoạt động khá tốt khi áp dụng trên quy mô lớn — phần lớn là như vậy. Tuy nhiên, trong khi phạm vi của các từ và xác suất của chúng có khả năng dẫn đến văn bản có ý nghĩa, thì điều này còn chưa chắc chắn.

Các LLMs có thể tạo ra một cái gì đó về mặt ngữ pháp đúng nhưng không có ý nghĩa, ví dụ như khẳng định về cầu cổng Vàng. Hoặc chúng có thể nói ra những điều không đúng, lan truyền các thông tin sai lệch trong dữ liệu huấn luyện của chúng. Hoặc chúng có thể kết hợp các nguồn thông tin khác nhau, bao gồm các nguồn hư cấu, ngay cả khi những nguồn đó mâu thuẫn rõ ràng với nhau.

Điều này không phải là hành động ác ý từ phía các LLMs. Chúng không có ý định xấu, và các khái niệm về đúng và sai không có ý nghĩa đối với chúng. Chúng chỉ đã học cách liên kết các từ hoặc cụm từ cụ thể với các khái niệm cụ thể, ngay cả khi các kết nối đó không chính xác.

“‘Hiện tượng ảo tưởng’ liên quan đến khả năng của một LLM trong việc ước tính sự không chắc chắn của dự đoán của nó,” Berns nói. “Một LLM thông thường được huấn luyện để luôn luôn tạo ra một kết quả đầu ra, ngay cả khi đầu vào rất khác biệt so với dữ liệu huấn luyện. Một LLM tiêu chuẩn không có cách nào để biết xem nó có khả năng trả lời một câu hỏi một cách đáng tin cậy hoặc đưa ra một dự đoán.”

Giải quyết hiện tượng ảo tưởng

Câu hỏi là, liệu có thể giải quyết hiện tượng ảo tưởng không? Điều này phụ thuộc vào bạn định nghĩa “giải quyết” như thế nào.

Vu Ha, một nghiên cứu viên ứng dụng và kỹ sư tại Viện Nghiên cứu Trí tuệ Nhân tạo Allen, khẳng định rằng LLMs “đang và sẽ luôn ảo tưởng.” Nhưng ông cũng tin rằng có cách cụ thể để giảm thiểu — mặc dù không loại bỏ hoàn toàn — hiện tượng ảo tưởng, tùy thuộc vào cách một LLM được huấn luyện và triển khai.

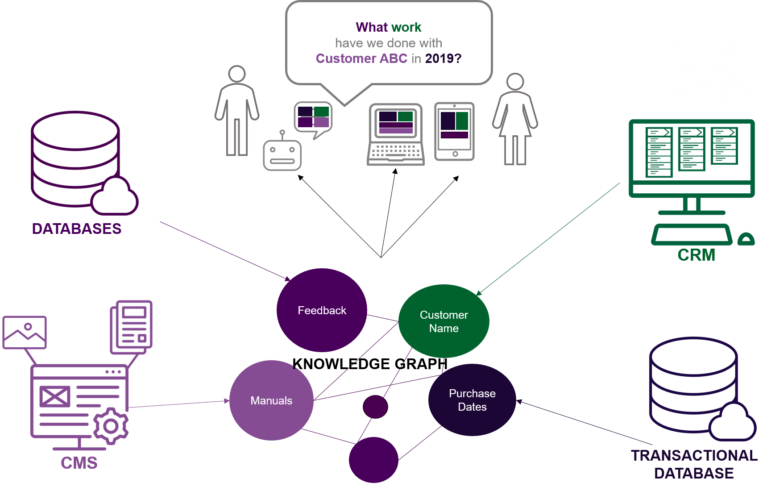

“Xem xét một hệ thống trả lời câu hỏi,” Ha nói qua email. “Có thể tạo ra hệ thống này để có độ chính xác cao bằng cách tạo ra một cơ sở kiến thức chất lượng cao về câu hỏi và câu trả lời, và kết nối cơ sở kiến thức này với một LLM để cung cấp các câu trả lời chính xác thông qua quá trình truy xuất.”

Ha minh họa sự khác biệt giữa một LLM có cơ sở kiến thức “chất lượng cao” để tham khảo so với một LLM có dữ liệu không được quản lý cẩn thận. Ông đã đặt câu hỏi “Ai là tác giả của bài báo Toolformer?” (Toolformer là một mô hình Trí tuệ Nhân tạo được đào tạo bởi Meta) thông qua Bing Chat được trang bị bởi LLM của Microsoft và Google Bard. Bing Chat đã đúng danh sách tất cả tám tác giả của Meta, trong khi Bard đã đưa ra thông tin sai, cho rằng bài báo thuộc về các nhà nghiên cứu của Google và Hugging Face.

“Bất kỳ hệ thống dựa trên LLM nào cũng sẽ bị ảo tưởng. Câu hỏi thực sự là liệu lợi ích có vượt qua hậu quả tiêu cực gây ra bởi hiện tượng ảo tưởng hay không,” Ha nói. Nói cách khác, nếu một mô hình không gây ra thiệt hại rõ ràng — ví dụ, mô hình sai lầm về một ngày hoặc tên một vài lần, nhưng nó vẫn hữu ích trong các trường hợp khác, thì có thể đáng giá để chấp nhận sự đánh đổi đó. “Đây là một vấn đề về việc tối ưu hóa tiện ích kỳ vọng của Trí tuệ Nhân tạo,” ông thêm.

Berns đã chỉ ra một kỹ thuật khác đã được sử dụng một cách khá thành công để giảm hiện tượng ảo tưởng trong các LLMs: học tăng cường dựa trên phản hồi của con người (RLHF). Được giới thiệu bởi OpenAI vào năm 2017, RLHF liên quan đến việc huấn luyện một LLM, sau đó thu thập thông tin bổ sung để huấn luyện một mô hình “phần thưởng” và điều chỉnh LLM bằng mô hình phần thưởng thông qua học tăng cường.

Trong RLHF, một tập hợp các yêu cầu từ một tập dữ liệu được xác định trước được truyền qua một LLM để tạo ra văn bản mới. Sau đó, những người đánh giá con người được sử dụng để xếp hạng các đầu ra từ LLM dựa trên “sự hữu ích” tổng thể — dữ liệu này được sử dụng để huấn luyện mô hình phần thưởng. Mô hình phần thưởng, tại thời điểm này có thể xem xét bất kỳ văn bản nào và gán cho nó một điểm số về mức độ con người cảm nhận nó tốt đến đâu, sau đó được sử dụng để điều chỉnh các phản hồi được tạo ra bởi LLM.

OpenAI đã sử dụng RLHF để huấn luyện một số mô hình của họ, bao gồm GPT-4. Tuy nhiên, Berns cũng cảnh báo rằng ngay cả RLHF cũng không hoàn hảo.

“Tôi tin rằng không gian của các khả năng quá lớn để hoàn toàn ‘đồng đẳng’ các LLMs với RLHF,” Berns nói. “Một điều thường được thực hiện trong bối cảnh RLHF là huấn luyện một mô hình để tạo ra một câu trả lời ‘Tôi không biết’ [cho một câu hỏi khó], chủ yếu dựa vào kiến thức chuyên môn của con người và hy vọng rằng mô hình sẽ tổng hợp nó với kiến thức chuyên môn của riêng nó. Thường thì nó làm được, nhưng có thể hơi khó khăn một chút.”

Các giải pháp thay thế

Giả sử rằng hiện tượng ảo tưởng không thể giải quyết được, ít nhất là không với các LLMs hiện nay, điều đó có phải là một điều tồi tệ không? Berns thực sự không nghĩ như vậy. Các mô hình ảo tưởng có thể thúc đẩy sự sáng tạo bằng cách làm vai trò “đối tác sáng tạo” — đưa ra những đầu ra có thể không hoàn toàn chính xác nhưng vẫn chứa một số ý tưởng hữu ích để khám phá. Việc sáng tạo sử dụng hiện tượng ảo tưởng có thể tạo ra kết quả hoặc kết hợp ý tưởng mà có thể không xuất hiện trong đầu của hầu hết mọi người.

“Hiện tượng ảo tưởng” chỉ là một vấn đề khi các tuyên bố được tạo ra là sai sự thật hoặc vi phạm bất kỳ giá trị con người, xã hội hoặc văn hóa nào đó — trong các tình huống mà một người phụ thuộc vào LLM để trở thành một chuyên gia,” ông nói. “Nhưng trong các nhiệm vụ sáng tạo hoặc nghệ thuật, khả năng tạo ra các đầu ra không ngờ có thể có giá trị. Người nhận thông tin có thể bị bất ngờ bởi một câu trả lời cho một câu hỏi và do đó có thể bị đẩy vào một hướng suy nghĩ cụ thể có thể dẫn đến sự kết nối mới giữa các ý tưởng.”

Ha đã lập luận rằng các LLMs hiện nay đang phải đối mặt với một tiêu chuẩn không hợp lý — con người cũng “ảo tưởng” khi chúng ta nhớ lầm hoặc biểu hiện sai sự thật. Nhưng với các LLMs, ông tin rằng chúng ta trải qua một sự mâu thuẫn nhận thức vì các mô hình tạo ra đầu ra có vẻ tốt ở mặt bề mặt nhưng lại chứa lỗi khi được kiểm tra kỹ hơn.

“Đơn giản thôi, LLMs, giống như bất kỳ kỹ thuật Trí tuệ Nhân tạo nào khác, đều không hoàn hảo và do đó gây ra sai lầm,” ông nói. “Truyền thống, chúng ta chấp nhận việc các hệ thống Trí tuệ Nhân tạo mắc sai lầm vì chúng ta mong đợi và chấp nhận sự không hoàn hảo. Nhưng khi LLMs mắc sai lầm, thì điều này phức tạp hơn.”

Thực tế, câu trả lời có thể không nằm ở cách mà các mô hình Trí tuệ Nhân tạo tạo ra thông tin ở mức kỹ thuật. Trong mức độ hiện tại, nếu có một “giải pháp” cho hiện tượng ảo tưởng, thì cách tốt nhất có vẻ là xem xét dự đoán của các mô hình với một cái nhìn hoài nghi.