Tác giả: Ben Dickson

Ngày 29 tháng 5 năm 2023

Ngay khi có vẻ như các công ty công nghệ lớn sẽ chiếm lĩnh thị trường mô hình ngôn ngữ lớn (LLM), một làn sóng mới của LLM mã nguồn mở đã chứng minh họ sai. Cộng đồng mã nguồn mở đã nỗ lực lớn để tạo ra các mô hình có thể đáp ứng nhiều yêu cầu về tính toán, bảo mật và dữ liệu. Những mô hình này là một sự lựa chọn thay thế cho ChatGPT và các LLM khác chỉ có thể truy cập thông qua giao diện API.

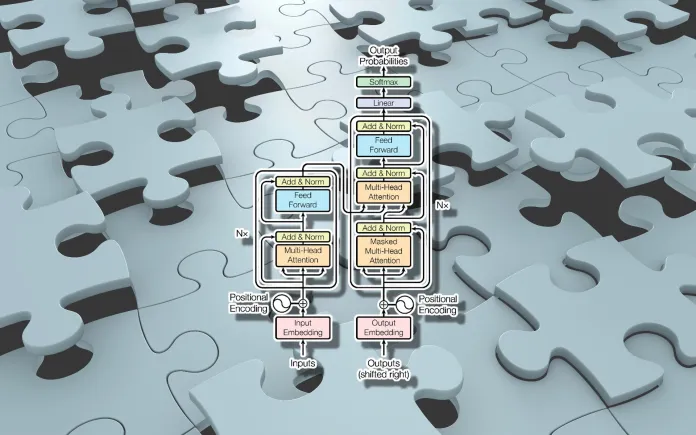

Trong một cuộc phỏng vấn gần đây với TechTalks, Andrew Feldman, CEO của Cerebras Systems, đã thảo luận về những tác động của các mô hình đóng cửa và những nỗ lực để tạo ra các LLM mã nguồn mở. Cerebras tạo ra các bộ xử lý chuyên dụng để huấn luyện và chạy mạng nơ-ron. Gần đây, họ đã phát hành Cerebras-GPT, một dòng LLM mã nguồn mở, hiệu quả về tính toán. Feldman chia sẻ kinh nghiệm và bài học từ việc tạo ra các LLM mã nguồn mở và các ứng dụng mới mà những mô hình này sẽ mở ra.

Mô hình ngôn ngữ nguồn đóng và nguồn mở

Cho đến gần đây, đã có một lượng lớn thông tin và sự chia sẻ trong cộng đồng trí tuệ nhân tạo. Với áp lực gia tăng đối với các phòng thí nghiệm trí tuệ nhân tạo để thương mại hóa công nghệ của họ hoặc tìm cách tài trợ cho nghiên cứu của họ, một phân đoạn của cộng đồng đã di chuyển hướng ít mở cửa hơn. Một ví dụ mô tả là bản báo cáo kỹ thuật cho GPT-4, LLM mới nhất của OpenAI, bao gồm rất ít chi tiết về kiến trúc của mô hình, dữ liệu đào tạo và chi phí.

“Những gì chúng tôi bắt đầu thấy là một thay đổi cơ bản. Khi những công ty lớn này tiêu hàng chục, thậm chí hàng tỷ đô la để đào tạo những mô hình này, họ trở nên ngày càng không muốn chia sẻ,” Feldman nói.

Cuộc đua để thống trị thị trường trí tuệ nhân tạo tạo động lực cho các công ty công nghệ lớn và các phòng thí nghiệm liên quan của họ giữ kín nghiên cứu của họ để có lợi thế so với đối thủ của họ, đặc biệt khi đào tạo và kiểm tra các mô hình rất lớn có chi phí rất cao. Các API và ứng dụng Blackbox dần trở thành mô hình mặc định cho việc phát hành các mô hình mới.

Nhưng trong những tháng gần đây, chúng ta đã thấy sự ra mắt của một loạt mô hình mã nguồn mở cung cấp sự lựa chọn thay thế cho các sản phẩm thương mại đóng cửa như DALL-E 2 và ChatGPT. Cộng đồng LLM đã hoạt động mạnh mẽ, với việc phát hành các mô hình như Alpaca, Vicuna, Dolly 2, MPT-7B và Cerebras-GPT. Những mô hình này cho phép các tổ chức có nhiều tùy chọn để khám phá khi triển khai LLM trong ứng dụng của họ.

“Tôi không nghĩ rằng các công ty – cả các doanh nghiệp lớn và nhỏ – muốn phụ thuộc vào một hoặc hai nhà cung cấp cho mô hình ngôn ngữ của họ. Họ muốn kiểm soát số phận của họ,” Feldman nói. “Các mô hình ngôn ngữ siêu lớn rất giỏi ở nhiều điều. Nhưng điều mà ngành công nghiệp đã thể hiện là các mô hình nhỏ hơn nhiều có thể vượt trội trong các nhiệm vụ cụ thể trong một lĩnh vực, và khả năng đào tạo và điều chỉnh các mô hình trong phạm vi từ 1-40 tỷ tham số trên một tỷ token hoàn toàn nằm trong tầm tay của hầu hết các công ty. Và vì vậy, có một sự bùng nổ của mã nguồn mở, một phần là do phản ứng trước việc đóng cửa hoặc sự đe dọa về việc đóng cửa các dự án trí tuệ nhân tạo.”

Việc kiểm soát mô hình, dữ liệu đào tạo và ứng dụng của nó là một trong những điểm thu hút của các mô hình ngôn ngữ mã nguồn mở. Và vì các mô hình mã nguồn mở nhỏ hơn hàng trăm lần so với các LLM rất lớn, chúng dễ dàng hơn để chạy và tùy chỉnh.

“Những gì chúng tôi tìm thấy là các doanh nghiệp lớn muốn đào tạo các mô hình này với dữ liệu độc quyền của họ và xây dựng các mô hình có sự tập trung hẹp và cụ thể cho một lĩnh vực cụ thể và được điều chỉnh chính xác cho những gì họ muốn,” Feldman nói.

Cách mà các LLM mã nguồn mở trở nên thành công

Andrew Feldman – CEO của Cerebras Andrew Feldman, CEO tại Cerebras “Trong một thời gian dài, ngành công nghiệp cho rằng càng nhiều tham số càng tốt. Và tôi nghĩ OpenAI đã tiên phong trong tư duy đó. Và một cách tổng quan, điều đó đúng,” Feldman nói. “Nhưng một cách cụ thể, nó hoàn toàn sai.”

Vào năm 2022, một bài báo do các nhà nghiên cứu tại DeepMind viết đã cho thấy bạn có thể cải thiện hiệu suất của mô hình ngôn ngữ bằng cách đào tạo nó trên nhiều dữ liệu hơn thay vì làm cho nó lớn hơn. Mô hình Chinchilla, được giới thiệu trong bài báo, có từ 16 đến 70 tỷ tham số. Chinchilla đã được đào tạo trên 1,4 nghìn tỷ token, khoảng 20 token cho mỗi tham số. So với GPT-3 với 175 tham số, nó đã được đào tạo trên 300 tỷ token, khoảng hai token cho mỗi tham số. Kết quả là, Chinchilla đã vượt trội so với các mô hình lớn hơn như GPT-3 trong nhiều nhiệm vụ. Đồng thời, việc chạy và điều chỉnh nó cho các nhiệm vụ downstream có chi phí ít hơn nhiều.

“[Chinchilla] đã dẫn đến khả năng đào tạo các mô hình nhỏ hơn trên nhiều dữ liệu để đạt được kết quả thực sự ấn tượng và tạo ra và chia sẻ các bộ dữ liệu lớn,” Feldman nói. “Sự nhận thức rằng dữ liệu có lẽ mạnh mẽ hơn tham số khi được cố định ngân sách đã dẫn đến một lượng công việc lớn trong phạm vi từ 1 đến 40 tỷ tham số và ít hơn nhiều công việc trong phạm vi từ 100 đến 500 tỷ tham số trong cộng đồng mã nguồn mở.”

Sự thành công của LLaMA, một dòng mô hình được phát hành bởi Meta, là một ví dụ khác về sức mạnh của dữ liệu đào tạo hơn là kích thước mô hình. Xây dựng trên những bài học từ Chinchilla, Meta tiếp tục tăng số lượng token đào tạo cho mỗi tham số của mô hình.

“Trong bài báo về LLaMA, họ đã cho thấy bạn có thể tiếp tục tạo lợi thế bằng cách sử dụng nhiều dữ liệu hơn – 50 hoặc 100 token cho mỗi tham số,” Feldman nói. “Sau khoảng 20 hoặc 30 token cho mỗi tham số, bạn sẽ không có nhiều giá trị hơn. Nhưng nếu bạn sẵn sàng chi tiêu chu kỳ tính toán, chi tiêu tiền cho tính toán đào tạo, mô hình của bạn tiếp tục cải thiện độ chính xác.”

Điều này mang lại sự linh hoạt hơn cho các nhà phát triển về loại mô hình và chế độ đào tạo mà họ có thể sử dụng dựa trên ngân sách, ứng dụng, dữ liệu và tần suất sử dụng. Ví dụ, nếu bạn muốn tính toán nhanh và sử dụng thường xuyên, bạn có thể muốn dành ngân sách của mình để đào tạo một mô hình nhỏ hơn trên nhiều dữ liệu hơn. Điều này tăng chi phí đào tạo nhưng giảm chi phí suy luận. Hoặc nếu bạn ít quan tâm đến chi phí suy luận, bạn có thể giảm chi phí đào tạo bằng cách đào tạo một mô hình lớn hơn trên ít token hơn. Thay vào đó, bạn sẽ trả nhiều hơn vào thời gian suy luận.

“Feldman nói, “Bạn có một tập hợp các sự đánh đổi thực sự thú vị cho những người đang làm công việc sản xuất.”

Điều chỉnh các LLM mã nguồn mở

Khác với nghiên cứu khoa học, thường đánh giá các mô hình trên các chỉ số thước đo rất tổng quát, sự chuyên môn rất quan trọng đối với ứng dụng thực tế.

“Phần lớn trong các ứng dụng sản xuất, tính tổng quát không giúp đỡ ai cả. Hầu hết các doanh nghiệp muốn giải quyết một vấn đề rất cụ thể, chẳng hạn như một loạt câu hỏi tài chính, câu hỏi thuế, câu hỏi pháp lý hoặc câu hỏi y tế,” Feldman nói. “Đây là những nhiệm vụ rất cụ thể và vì vậy khả năng của mô hình phải tổng quát ít quan trọng hơn nhiều.”

Đồng thời, nhiều doanh nghiệp sở hữu dữ liệu độc quyền mà họ muốn đào tạo mô hình của mình. Một trong những cơ hội thú vị của các mô hình mã nguồn mở là tính hiệu quả trong việc điều chỉnh. Sau khi bạn đã đào tạo một mô hình cơ sở trên một bộ dữ liệu rất lớn, việc điều chỉnh nó cho các nhiệm vụ downstream sẽ rất hiệu quả về chi phí. Trong khi các LLM rất lớn đòi hỏi các ngăn xếp tính toán đắt đỏ để điều chỉnh, nhiều LLM mã nguồn mở có thể được điều chỉnh với chi phí rất thấp và thậm chí trên GPU cấu hình tiêu dùng.

Những nghiên cứu viên đã phát triển các kỹ thuật tiết kiệm tham số như kỹ thuật thích ứng low-rank (LoRA), có thể thực hiện điều chỉnh tốn một phần nhỏ so với chi phí bình thường.

“Với một số tiền không nhiều, bạn có thể xây dựng trên cơ sở mô hình mã nguồn mở này bằng cách đào tạo với dữ liệu cụ thể, rất sạch và hướng đến một lĩnh vực cụ thể,” Feldman nói. “Và không ngạc nhiên, mô hình rất chính xác trong lĩnh vực cụ thể đó. Đó là một yếu tố mạnh mẽ, và chúng ta sẽ thấy nhiều công việc cụ thể về lĩnh vực hơn. Tôi nghĩ đó là một trong những hướng đi của tương lai.”

Cerebras-GPT

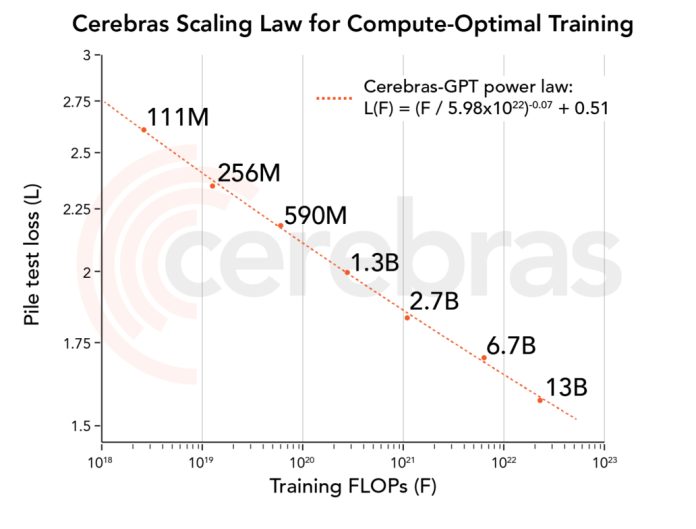

Cerebras đã phát hành Cerebras-GPT, một dòng bảy mô hình ngôn ngữ mã nguồn mở có từ 111 triệu đến 13 tỷ tham số. Các mô hình đã được đào tạo trước trên bộ dữ liệu nguồn mở Pile. Đội ngũ Cerebras đã sử dụng hướng dẫn từ bài báo Chinchilla và các kỹ thuật để tối ưu hóa quy mô của các mô hình. Đội ngũ đã phát hành các mô hình, trọng lượng, mã và công thức đào tạo.

Các mô hình đã được tải xuống hơn 400.000 lần và trở nên rất phổ biến.

Một số điểm làm cho Cerebras-GPT đặc biệt thú vị. Trước hết, Cerebras đã phát hành các mô hình dưới giấy phép Apache 2.0, điều này có nghĩa không có hạn chế trong việc sử dụng chúng cho mục đích nghiên cứu hoặc thương mại. Điều này khác biệt so với một số mô hình mã nguồn mở khác, chẳng hạn như LLaMA, có giấy phép hạn chế hơn.

Hơn nữa, Cerebras-GPT cung cấp thông tin rất thú vị về các quy tắc tỷ lệ của LLM và các tính toán cho phép bạn đánh giá các sự đánh đổi giữa chi phí đào tạo và suy luận. Họ đã tạo ra một công thức đào tạo và tỷ lệ cho phép bạn dự đoán hiệu suất của các mô hình một cách chính xác mà không phải lãng phí tài nguyên đắt tiền để đào tạo chúng.

Và cuối cùng, Cerebras đã sử dụng phần cứng trí tuệ nhân tạo của họ để đào tạo các mô hình. Ngăn xếp tính toán Cerebras sử dụng bộ xử lý CS-2 hiệu quả cao, đã được thiết kế đặc biệt để giải quyết một số thách thức lớn nhất trong việc thiết lập ngăn xếp tính toán để đào tạo và chạy các LLM.

“GPU là một máy tính tương đối nhỏ, và nếu bạn muốn sử dụng 400 hoặc 600 hoặc 1.000 chiếc, bạn phải tiêu rất nhiều thời gian và tiền bạc để phân phối công việc trên chúng,” Feldman nói. “Chúng tôi nghĩ rằng đó là một ý tưởng không tốt từ mọi phía. Điều bạn nên làm là xây dựng phần cứng không cần điều đó.”

Đó là điều mà ngăn xếp phần cứng và phần mềm của Cerebras làm. Bạn có thể dễ dàng mở rộng mô hình và các nút tính toán mà không cần lo lắng về tính toán phân tán và chỉ với một lệnh đơn. Trong nhiều trường hợp, việc điều chỉnh ngăn xếp tính toán chỉ đòi hỏi một thay đổi duy nhất trong tệp cấu hình.

“Đó là cách chúng tôi đã đưa bảy mô hình vào cộng đồng chỉ trong vài tuần làm việc,” Feldman nói. “Khi bạn xây dựng cơ sở hạ tầng và đưa nó vào cộng đồng mã nguồn mở, điều bạn muốn là để mọi người tạo ra những thứ thú vị với sáng chế của bạn. Sau đó, bạn có thể sử dụng nó để giải quyết các vấn đề thú vị và chúng tôi rất tự hào về những gì đã được thực hiện.”