Tác giả: Aayush Mittal

ngày 4 tháng 10 năm 2023

Mistral AI – đến từ công ty có trụ sở tại Paris – gia nhập sân chơi với Mô hình Ngôn ngữ Mới mạnh mẽ và Miễn phí gửi tới các đối thủ đã thành danh trên thị trường lời thách thức không thể bỏ qua.

Các mô hình Ngôn ngữ Lớn (LLMs) đã gần đây nắm giữ vị trí trung tâm, nhờ vào các hiệu suất nổi bật như ChatGPT. Khi Meta giới thiệu các mô hình Llama của họ, đã làm bùng nổ sự quan tâm mới đối với các LLM mã nguồn mở. Mục tiêu? Tạo ra các LLM mã nguồn mở giá cả phải chăng, có khả năng sánh ngang với các mô hình hàng đầu như GPT-4, nhưng không cần phải bỏ ra số tiền lớn hoặc phức tạp.

Sự kết hợp giữa tính phải chăng và hiệu suất không chỉ mở ra những cơ hội mới cho các nhà nghiên cứu và phát triển mà còn đặt nền tảng cho một kỷ nguyên mới của sự tiến bộ công nghệ trong xử lý ngôn ngữ tự nhiên.

Gần đây, các startup về trí tưởng tượng trí tuệ nhân tạo đã nhận được một lượng lớn vốn đầu tư. Cộng đồng huy động được 20 triệu đô la, với mục tiêu định hình trí tuệ nhân tạo mã nguồn mở. Anthropic cũng đã huy động được số tiền ấn tượng là 450 triệu đô la, và Cohere, hợp tác với Google Cloud, đã đảm bảo 270 triệu đô la vào tháng Sáu năm nay.

Giới thiệu về Mistral 7B: Kích thước và Sự sẵn sàng

Mistral AI, có trụ sở tại Paris và được thành lập bởi các cựu sinh viên đến từ DeepMind của Google và Meta, đã thông báo mô hình ngôn ngữ lớn đầu tiên của họ: Mistral 7B. Mô hình này có thể dễ dàng được tải xuống bởi bất kỳ ai từ GitHub và thậm chí thông qua một tập tin torrent có dung lượng 13.4 gigabyte.

Công ty khởi nghiệp này đã đạt được mức kỷ lục về vốn đầu tư ngay trước khi họ sản phẩm đầu tiên của họ ra mắt. Mô hình đầu tiên của Mistral AI với 7 tỷ tham số vượt qua hiệu suất của Llama 2 với 13 tỷ tham số trong tất cả các kiểm tra và vượt trội Llama 1 với 34 tỷ tham số trong nhiều chỉ số.

So sánh với các mô hình khác như Llama 2, Mistral 7B cung cấp khả năng tương tự hoặc tốt hơn nhưng với ít áp lực tính toán hơn. Trong khi các mô hình cơ bản như GPT-4 có thể đạt được hiệu suất cao hơn, chúng đi kèm với chi phí cao hơn và không thân thiện với người dùng bởi vì chúng chủ yếu được truy cập thông qua các giao diện lập trình ứng dụng (APIs).

Khi đề cập đến các nhiệm vụ lập trình, Mistral 7B thể hiện sự cạnh tranh đáng kể so với CodeLlama 7B. Hơn nữa, với kích thước chỉ 13.4 GB, nó đủ nhỏ gọn để chạy trên các máy tính tiêu chuẩn.

Bên cạnh đó, phiên bản Mistral 7B Instruct, được điều chỉnh đặc biệt cho các tập dữ liệu hướng dẫn trên Hugging Face, đã thể hiện hiệu suất xuất sắc. Nó vượt trội so với các mô hình 7B khác trên MT-Bench và đứng bên cạnh các mô hình trò chuyện 13B.

Kiểm tra Hiệu suất

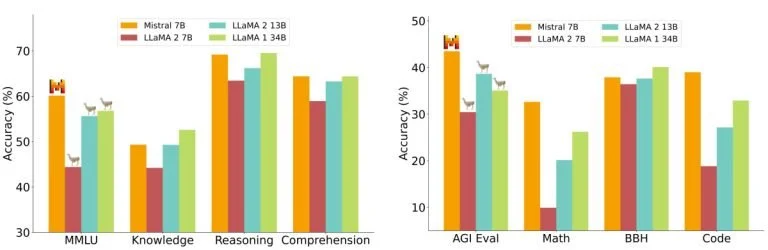

Trong một phân tích hiệu suất chi tiết, Mistral 7B đã được đánh giá so sánh với các mô hình thuộc gia đình Llama 2. Kết quả rất rõ ràng: Mistral 7B đã vượt xa Llama 2 13B ở tất cả các tiêu chuẩn. Thực tế, nó đạt được hiệu suất tương đương với Llama 34B, đặc biệt là nổi bật trong các tiêu chuẩn về mã lập trình và lý luận.

Các tiêu chuẩn được tổ chức thành nhiều loại, chẳng hạn như Lý luận Sáng tạo, Kiến thức thế giới, Đọc hiểu, Toán học và Mã lập trình, và nhiều loại khác. Một quan sát đáng chú ý đặc biệt là chỉ số hiệu suất theo chi phí của Mistral 7B, được gọi là “kích thước mô hình tương đương”. Trong các lĩnh vực như lý luận và hiểu biết, Mistral 7B đã thể hiện hiệu suất tương tự một mô hình Llama 2 lớn hơn ba lần về kích thước, tượng trưng cho khả năng tiết kiệm bộ nhớ và tăng cường thời lượng xử lý. Tuy nhiên, ở các tiêu chuẩn kiến thức, Mistral 7B đã sát với Llama 2 13B, có thể là do giới hạn về tham số ảnh hưởng đến khả năng nén kiến thức của nó.

Ứng dụng Mistral 7B có điểm mạnh gì thật sự so với hầu hết các Mô hình Ngôn ngữ khác?

Giản thể hóa Cơ chế Tập trung

Mặc dù các chi tiết phức tạp của cơ chế tập trung có tính kỹ thuật cao, ý tưởng cơ bản của chúng là tương đối đơn giản. Hãy tưởng tượng khi bạn đọc một cuốn sách và ghi chú những câu quan trọng; điều này tương tự như cách cơ chế tập trung “gạch chân” hoặc quan trọng hóa các điểm dữ liệu cụ thể trong một chuỗi.

Trong ngữ cảnh của các mô hình ngôn ngữ, những cơ chế này cho phép mô hình tập trung vào các phần quan trọng nhất của dữ liệu đầu vào, đảm bảo đầu ra là mạch lạc và phù hợp ngữ cảnh.

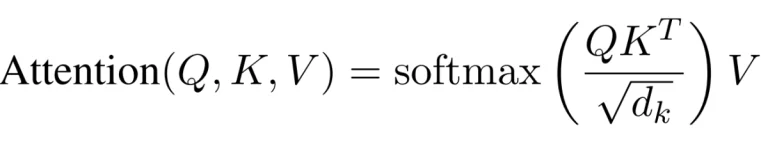

Trong các bộ biến đổi tiêu chuẩn, điểm tập trung được tính bằng công thức:

Công thức tính toán điểm tập trung này bao gồm một bước quan trọng – nhân ma trận của Q và K. Thách thức ở đây là khi độ dài chuỗi tăng lên, cả hai ma trận đều mở rộng theo cách tương ứng, dẫn đến một quá trình tính toán mất nhiều tài nguyên. Vấn đề về tính mở rộng này là một trong những lý do chính khiến cho các bộ biến đổi tiêu chuẩn có thể chậm, đặc biệt là khi xử lý các chuỗi dài.

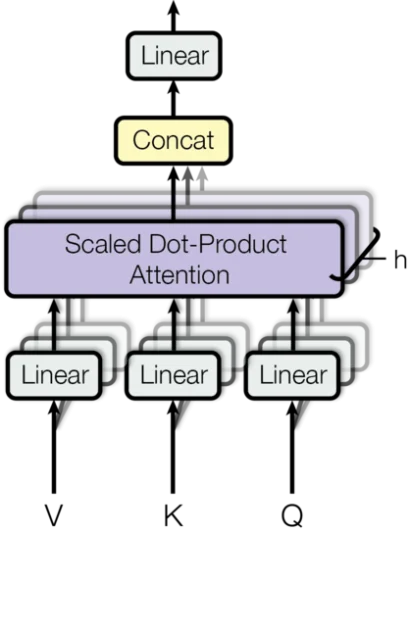

Cơ chế tập trung của bộ biến đổi giúp mô hình tập trung vào các phần cụ thể của dữ liệu đầu vào. Thông thường, các cơ chế này sử dụng ‘đầu’ để quản lý sự tập trung này. Càng nhiều ‘đầu’ bạn có, sự tập trung càng cụ thể hơn, nhưng cũng trở nên phức tạp và chậm hơn. Để hiểu sâu hơn về các bộ biến đổi và cơ chế tập trung, bạn có thể đọc thêm tại đây.

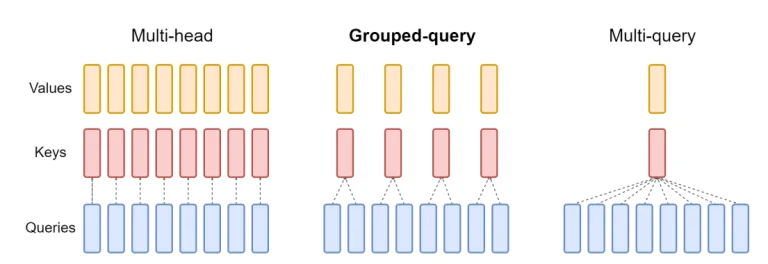

Sự tập trung đa truy vấn (MQA) giúp tăng tốc quá trình bằng cách sử dụng một bộ ‘đầu khóa-giá trị’ nhưng đôi khi đánh đổi chất lượng. Bây giờ, bạn có thể tự hỏi, tại sao không kết hợp tốc độ của MQA với chất lượng của tập trung đa đầu? Đó là lý do Grouped-query attention (GQA) ra đời.

Grouped-query Attention (GQA)

Grouped-query Attention (GQA) là một giải pháp trung gian. Thay vì chỉ sử dụng một hoặc nhiều ‘đầu khóa-giá trị’, GQA nhóm chúng lại. Như vậy, GQA đạt được hiệu suất gần giống với tập trung đa đầu chi tiết nhưng với tốc độ của MQA. Đối với các mô hình như Mistral, điều này có nghĩa là hiệu suất hiệu quả mà không cần đánh đổi quá nhiều về chất lượng.

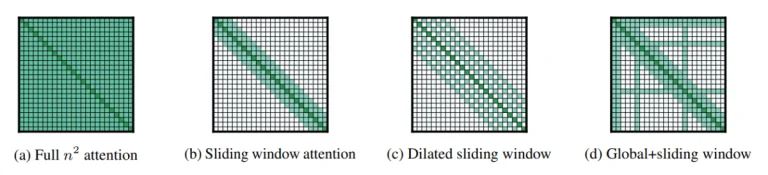

Sliding Window Attention (SWA)

Cửa sổ trượt (Sliding Window) là một phương pháp khác được sử dụng trong xử lý trình tự tập trung. Phương pháp này sử dụng một cửa sổ tập trung cố định có kích thước quanh mỗi mã thông báo trong trình tự. Với nhiều lớp xếp cửa sổ tập trung này, các lớp cao nhất cuối cùng đạt được một góc nhìn rộng hơn, bao gồm thông tin từ toàn bộ đầu vào. Cơ chế này tương tự như các lĩnh vực thu hút được thấy trong Mạng nơ-ron tích chập (CNN).

Mặt khác, “cửa sổ tập trung trượt mở rộng” của mô hình Longformer, mà theo khái niệm tương tự với phương pháp cửa sổ trượt, tính toán chỉ vài đường chéo của ma trận QKT. Sự thay đổi này dẫn đến việc sử dụng bộ nhớ tăng tuyến tính thay vì bình phương, làm cho nó trở thành một phương pháp hiệu quả hơn đối với các trình tự dài hơn.

Mistral AI: Sự Ttransparency so với Mối lo ngại về An toàn trong Quá trình Phi Tập trung

Trong thông báo của họ, Mistral AI cũng nhấn mạnh về sự minh bạch với tuyên bố: “Không có chiêu trò, không có dữ liệu độc quyền.” Tuy nhiên, vào thời điểm này, mô hình duy nhất có sẵn của họ, ‘Mistral-7B-v0.1,’ là một mô hình cơ bản được đào tạo trước, do đó nó có thể tạo ra phản ứng cho bất kỳ truy vấn nào mà không cần kiểm duyệt, điều này đặt ra mối lo ngại về an toàn tiềm năng. Trong khi các mô hình như GPT và Llama có cơ chế để phân biệt khi nào nên phản hồi, tính phi tập trung hoàn toàn của Mistral có thể bị lợi dụng bởi những người có ý định xấu.

Tuy nhiên, việc phi tập trung hóa của các Mô hình Ngôn ngữ Lớn cũng có những lợi ích riêng. Mặc dù có người có thể lạm dụng nó, nhưng mọi người có thể tận dụng sức mạnh này cho mục tiêu xã hội và làm cho trí thông minh trở nên dễ tiếp cận đối với tất cả mọi người.

Khả năng Triển khai Linh hoạt

Một trong những điểm nổi bật là Mistral 7B có sẵn dưới giấy phép Apache 2.0. Điều này có nghĩa không có rào cản thực sự trong việc sử dụng nó – dù bạn sử dụng nó cho mục đích cá nhân, một tập đoàn lớn, hoặc thậm chí một cơ quan chính phủ. Bạn chỉ cần có hệ thống phù hợp để chạy nó, hoặc bạn có thể phải đầu tư vào tài nguyên đám mây.

Mặc dù có các giấy phép khác như Giấy phép MIT đơn giản hơn và Giấy phép CC BY-SA-4.0 hợp tác, yêu cầu việc ghi công và giấy phép tương tự cho các phần tạo ra từ nền tảng gốc, giấy phép Apache 2.0 cung cấp một nền tảng mạnh mẽ cho các dự án quy mô lớn.

Thay lời kết

Sự nổi lên của các Mô hình Ngôn ngữ Lớn mã nguồn mở như Mistral 7B đánh dấu một sự chuyển đổi quan trọng trong ngành công nghiệp Trí tuệ Nhân tạo, làm cho các mô hình ngôn ngữ chất lượng cao trở nên dễ tiếp cận hơn cho đông đảo người dùng. Các phương pháp đổi mới của Mistral AI, chẳng hạn như Grouped-query attention và Sliding Window Attention, hứa hẹn hiệu suất hiệu quả mà không cần đánh đổi chất lượng.

Mặc dù tính phi tập trung của Mistral đặt ra một số thách thức, tính linh hoạt và việc sử dụng mã nguồn mở của nó nhấn mạnh tiềm năng làm dân chủ hóa Trí tuệ Nhân tạo. Khi bối cảnh ngành công nghiệp phát triển, sự tập trung tất yếu sẽ là việc cân nhắc sự cân bằng giữa sức mạnh của các mô hình này với các yếu tố đạo đức và cơ chế an toàn.

Về tương lai của Mistral? Mô hình 7B chỉ là sự khởi đầu. Đội ngũ đặt ra mục tiêu sớm ra mắt các mô hình lớn hơn. Nếu những mô hình mới này sánh ngang với hiệu suất của 7B, Mistral có thể nhanh chóng trở thành một người chơi hàng đầu trong ngành chỉ trong vòng một năm đầu tiên của họ.