Tác giả: Kunal Kejriwal

Ngày 29 tháng 11 năm 2023

Khả năng và hiệu suất của các mô hình ngôn ngữ lớn nhỏ, mã nguồn mở đã phát triển đáng kể trong những năm gần đây, và chúng ta đã chứng kiến sự tiến bộ từ các mô hình GPT-2 sớm đến các khung công việc LLM (Large Language Model) nhỏ gọn, chính xác và hiệu quả hơn, sử dụng một lượng lớn hơn đáng kể các token so với lượng “tối ưu tính toán” được khuyến nghị bởi các quy luật chia tỷ lệ của Chinchilla. Hơn nữa, các nhà phát triển đã chứng minh rằng những khung công việc LLM nhỏ gọn này có thể được huấn luyện thêm bằng cách sử dụng phương pháp dSFT hoặc Distilled Supervised Fine-Tuning dựa trên mô hình chủ động, sử dụng đầu ra từ một mô hình giáo viên hiệu quả như dữ liệu giám sát cho mô hình học viên với mục tiêu tăng cường độ chính xác.

Trong bài viết này, chúng ta sẽ nói về khung công việc Zephyr-7B, một tiêu chuẩn thử nghiệm tương tác hàng đầu cho các mô hình với 7 tỷ tham số mà không cần can thiệp trực tiếp từ con người. Mục tiêu chính của khung công việc này là giúp các nhà phát triển tạo ra các mô hình ngôn ngữ lớn nhỏ gọn hơn và tập trung vào ý định của người dùng hơn bao giờ hết. Khung công việc Zephyr-7B không chỉ xem xét việc áp dụng các phương pháp hiện tại cho các khung công việc LLM lớn hơn như dSFT, mà còn khám phá khả năng sử dụng các phương pháp khác để học mô hình trò chuyện với sự phù hợp hơn với ý định của người dùng. Chúng ta sẽ đi sâu hơn vào khung công việc Zephyr, và khám phá kiến trúc, cách hoạt động và kết quả thử nghiệm thực tế.

Zephyr-7B: giới thiệu về quá trình chưng cất trực tiếp của công việc căn chỉnh mô hình ngôn ngữ

Như đã đề cập trước đó, các mô hình ngôn ngữ đã tiến triển nhanh chóng trong những năm gần đây, từ các khung công việc GPT-2 sớm đến các khung công việc GPT-4 và MiniGPT-5 hiện tại, mặc dù chúng rất phong phú về token, nhưng hiện nay chúng lại chính xác hơn và hiệu quả hơn nhiều. Một điểm nổi bật quan trọng của những khung công việc LLM tiên tiến này là chúng tích hợp một lượng token đáng kể cao hơn so với số token được xem xét là tối ưu tính toán dưới luật tỷ lệ Chinchilla trước đây. Hơn nữa, các nhà phát triển và nhà nghiên cứu làm việc trên các khung công việc LLM đã nhận thức được rằng những khung công việc LLM nhỏ gọn này có thể được huấn luyện thêm bằng cách sử dụng phương pháp dSFT hoặc Distilled Supervised Fine-Tuning dựa trên các mô hình chủ động, sử dụng đầu ra từ một mô hình giáo viên hiệu quả như dữ liệu giám sát cho mô hình học viên với mục tiêu tăng cường độ chính xác. Chiến lược chưng cất đã chứng minh mình là một công cụ hiệu quả và hữu ích để tối đa hóa tiềm năng và khả năng của các mô hình mở trên nhiều nhiệm vụ, tuy nhiên, nó vẫn chưa thể sao chép được hiệu suất đạt được bởi mô hình giáo viên. Ngoài ra, người dùng thường báo cáo rằng những mô hình này thường thể hiện “không đồng đều với ý định”, có nghĩa là chúng không hoạt động theo cách phù hợp với yêu cầu của người dùng cuối, dẫn đến các đầu ra không chính xác không cung cấp đầu ra hoặc phản ứng đúng với đầu vào hoặc truy vấn của người dùng.

Việc căn chỉnh ý định luôn là một thách thức lớn đối với các nhà phát triển, và các nghiên cứu gần đây đã tập trung vào việc phát triển các bộ đánh giá như AlpacaEval và MT-Bench, được phát triển để giải quyết vấn đề không đồng đều ý định. Động lực để phát triển khung công việc Zephyr có thể được ghi nhận từ vấn đề sử dụng quá trình chưng cất để căn chỉnh một khung công việc LLM mở nhỏ hoàn toàn, trong đó bước chính là sử dụng AIF hoặc Phản Hồi Trí Tuệ Nhân Tạo để thu thập dữ liệu ưa thích từ một tập hợp của mô hình giáo viên, sau đó áp dụng tối ưu hóa ưa thích được chưng cất trực tiếp như mục tiêu học chính, một phương pháp được gọi là dDPO hoặc Denoising Diffusion Policy Optimization. Điểm nổi bật chính của phương pháp dDPO là, khác với các phiên bản trước như PPO hoặc Proximal Preference Optimization, nó không yêu cầu lấy mẫu hoặc chú thích từ con người, và cũng giảm thời gian đào tạo mô hình ngôn ngữ. Hơn nữa, nó cũng cho phép nhà phát triển tối đa hóa các phần thưởng của mẫu cuối cùng bằng cách chú ý đặc biệt đến chuỗi các bước làm sạch từ đầu đến cuối, nói cách khác, suốt toàn bộ quá trình.

Các nhà phát triển đã phát triển khung công việc Zephyr-7B để xác minh phương pháp này, và ở một số khía cạnh, đó là phiên bản được căn chỉnh của khung công việc Mistral-7B hàng đầu. Khung công việc này trước hết sử dụng dSFT hoặc Distilled Supervised Fine-Tuning dựa trên bộ dữ liệu UltraChat, và áp dụng phương pháp dDPO hoặc Denoising Diffusion Policy Optimization trên dữ liệu phản hồi. Các thử nghiệm cho thấy rằng khung công việc Zephyr-7B với 7 tỷ tham số mang lại kết quả tương đương với mô hình trò chuyện được căn chỉnh theo phản hồi của con người có hơn 70 tỷ tham số. Hơn nữa, các thử nghiệm cũng cho thấy rằng kết quả có thể được cải thiện cả về các tiêu chí đánh giá có tính đến khả năng trò chuyện, cũng như các tiêu chí đánh giá học thuật tiêu chuẩn, và việc sử dụng học ưa thích là quan trọng để đạt được kết quả mong muốn.

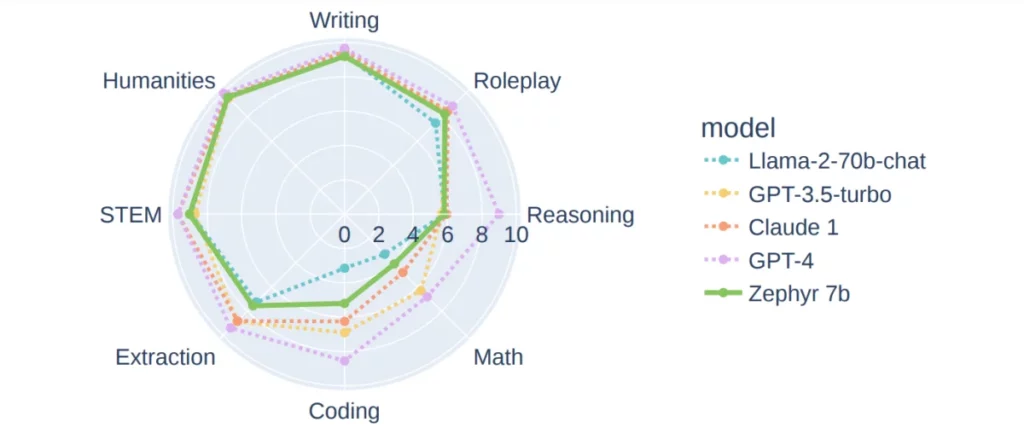

Hình ảnh trên thể hiện hiệu suất của các mô hình ngôn ngữ khác nhau trên bộ đánh giá MT-bench. Khung công việc Zephyr-7B được huấn luyện bằng phương pháp dDPO được so sánh với các mô hình ngôn ngữ lớn hơn, cả trả phí và miễn phí như GPT-3.5 turbo, Llama-2-70B, và nhiều mô hình khác được huấn luyện bằng học tăng cường bổ sung và bao gồm một lượng lớn phản hồi từ con người. Như có thể thấy rõ, mặc dù có sự chênh lệch rõ ràng về số lượng tham số mà các khung công việc này sử dụng, khung công việc Zephyr-7B mang lại kết quả tương đương với hầu hết chúng và vượt trội hơn so với một số khung công việc trong các lĩnh vực khác nhau.

Zephyr-7B: Phương pháp, cách thức hoạt động và kiến trúc

Mục tiêu chính của khung công việc Zephyr-7B là giúp một mô hình ngôn ngữ lớn mã nguồn mở căn chỉnh gần nhất có thể với ý định của người dùng, và trong suốt toàn bộ quá trình, khung công việc Zephyr-7B giả định có quyền truy cập vào một mô hình giáo viên lớn được truy vấn bằng cách tạo ra câu hỏi kích thích. Zephyr-7B theo đuổi một phương pháp tương tự như phương pháp được sử dụng trong khung công việc InstructGPT và mục tiêu là tạo ra một mô hình học viên hiệu quả và chính xác.

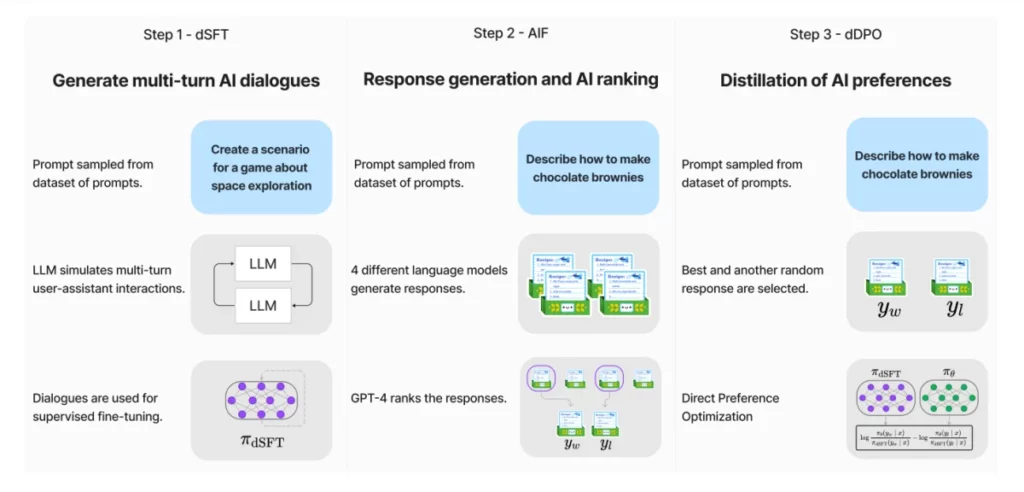

Hình ảnh dưới đây tóm tắt ba bước chính trong cách hoạt động của khung công việc Zephyr-7B.

- dSFT cho xây dựng tập dữ liệu quy mô lớn bằng phong cách tự học.

- Thu thập AIF bằng cách sử dụng một tập hợp các mô hình trò chuyện hoàn thành, sau đó thực hiện nhị phân hóa sở thích và đánh giá bởi GPT-4.

- dPO của mô hình dSFT bằng cách sử dụng dữ liệu phản hồi.

dSFT hoặc Distilled Supervised Fine-Tuning

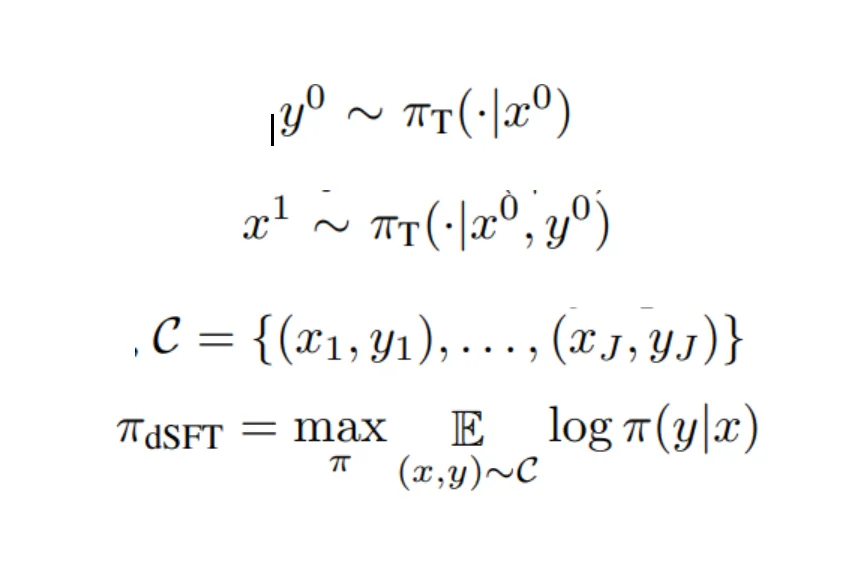

Khung công việc bắt đầu với một Mô Hình Ngôn Ngữ Lớn nguyên thủy mà đầu tiên cần được huấn luyện để phản ứng với các yêu cầu của người dùng. Theo truyền thống, việc huấn luyện những khung công việc LLM này để phản ứng với các yêu cầu của người dùng được thực hiện bằng cách sử dụng SFT hoặc Fine Tuning được Giám Sát trên một tập dữ liệu bao gồm các hướng dẫn chất lượng cao và các câu trả lời tương ứng của chúng. Vì Zephyr-7B có quyền truy cập vào một mô hình ngôn ngữ giáo viên, khung công việc có thể tạo ra các hướng dẫn và câu trả lời, và huấn luyện mô hình trực tiếp trên các hướng dẫn và câu trả lời này, phương pháp này được gọi là dSFT hoặc SFT được chưng cất. Hình ảnh dưới đây mô tả quá trình chưng cất được thực hiện bởi SFT, trong đó x đại diện cho một tập các đề xuất hạt giống được xây dựng với mục đích chính là biểu diễn một tập đa dạng các lĩnh vực chủ đề, y đại diện cho câu trả lời mẫu được làm tinh tế bằng một hướng dẫn mẫu mới được biểu diễn bởi x1 và C đại diện cho điểm cuối trong tập dữ liệu cuối cùng.

Phản hồi Trí tuệ Nhân tạo thông qua Ưu Tiên

Phản hồi từ con người được sử dụng để gán điểm cho các Mô Hình Ngôn Ngữ Lớn vì chúng có thể cung cấp các tín hiệu bổ sung cần thiết, và phản hồi này thường được cung cấp thông qua sự ưa thích về chất lượng của các câu trả lời được tạo ra bởi các khung công việc LLM. Tuy nhiên, khung công việc Zephyr sử dụng Phản hồi Trí tuệ Nhân tạo từ mô hình giáo viên về các đầu ra được tạo ra bởi các mô hình khác thay vì phản hồi từ con người cho mục đích chưng cất. Phương pháp được theo đuổi bởi khung công việc Zephyr được ảnh hưởng bởi phương pháp được sử dụng bởi khung công việc UltraFeedback, sử dụng mô hình giáo viên để cung cấp sự ưa thích đối với các đầu ra của mô hình.

Tương tự như phương pháp SFT hoặc Fine Tuning được Giám Sát, nó bắt đầu với một tập các đề xuất, trong đó x đại diện cho mỗi đề xuất cá nhân, sau đó được đưa vào một bộ sưu tập của bốn mô hình như Llama, Falcon, Claude, và nhiều mô hình khác, mỗi mô hình tạo ra một câu trả lời riêng của mình. Những câu trả lời này sau đó được đưa vào mô hình giáo viên như GPT-3 hoặc GPT-4, và mô hình tạo ra một điểm số cho câu trả lời đầu vào. Sau khi thu thập các điểm số đầu ra, mô hình lưu trữ câu trả lời có điểm số cao nhất.

dDPO hoặc Distilled Direct Preference Optimization

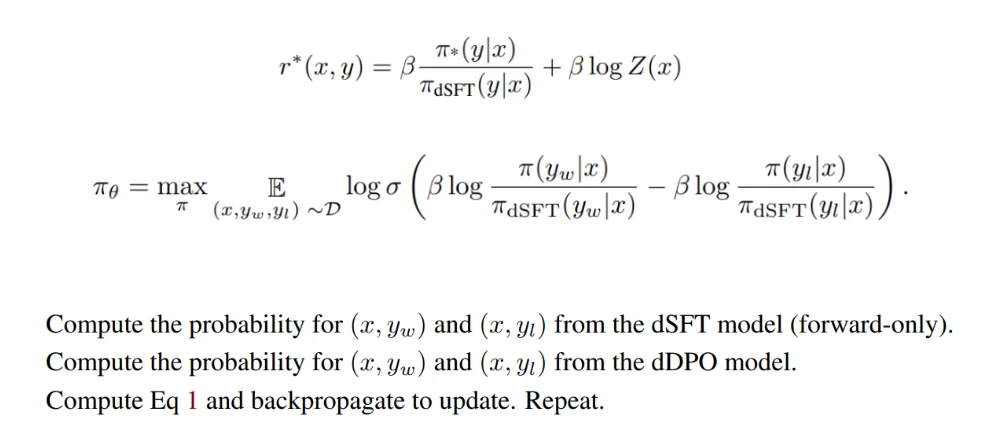

dDPO là bước cuối cùng của khung công việc Zephyr, và mục tiêu chính của nó là làm tinh tế mô hình giáo viên dSFT bằng cách tối đa hóa xác suất xếp hạng câu trả lời ưa thích trong một mô hình ưu tiên được xác định bởi một hàm thưởng bằng cách sử dụng mô hình ngôn ngữ học viên. Bước trước đó về việc sử dụng Phản hồi Trí tuệ Nhân tạo tập trung chủ yếu vào việc sử dụng các phương pháp Học tăng cường như PPO hoặc Tối ưu hóa Chính sách Gần nhất để tối ưu hóa tối đa đối với thưởng được tạo ra. Trong bước này, thưởng được huấn luyện trước, sau đó được lấy mẫu từ chính sách hiện tại để tính toán các cập nhật, và do đó tối đa hóa tối ưu hóa. DPO hoặc Tối ưu hóa Ưu Tiên Trực Tiếp theo một phương pháp tương tự để tối ưu hóa trực tiếp mô hình ưu tiên bằng cách sử dụng dữ liệu tĩnh. Mục tiêu sau khi cắm hàm thưởng vào mô hình ưu tiên có thể được viết là

Zephyr-7B: Thử nghiệm, bảng đánh giá và kết quả

Khung công việc Zephyr thực hiện các thử nghiệm điều chỉnh tốt trên khung công việc Mistral-7B hàng đầu hiện tại, mang lại hiệu suất tương đương với các mô hình ngôn ngữ lớn hơn nhiều trên nhiều nhiệm vụ xử lý ngôn ngữ tự nhiên hoặc NLP.

Bộ dữ liệu

Khung công việc Zephyr sử dụng hai bộ dữ liệu trò chuyện đã được chưng cất từ sự kết hợp của các mô hình chủ động và mã nguồn mở, đã trước đây đã chứng minh là hiệu quả trong việc tạo ra các mô hình trò chuyện hiệu quả.

UltraChat

UltraChat là một bộ dữ liệu tự làm mới bao gồm gần 1,5 triệu cuộc trò chuyện đa vòng trải rộng qua 30 chủ đề và 20 tài liệu văn bản được tạo ra bởi khung công việc GPT-3.5-Turbo. Để giải quyết vấn đề chữ in hoa không chính xác của bộ dữ liệu UltraChat, khung công việc áp dụng một phương pháp giải thuật chuẩn xác để loại bỏ các lỗi ngữ pháp.

UltraFeedback

UltraFeedback là một bộ dữ liệu kích thích với hơn 64,000 kích thích, trong đó mỗi kích thích này có bốn phản hồi cá nhân từ các mô hình ngôn ngữ. Khung công việc Zephyr sử dụng điểm trung bình cao nhất thu được từ bộ dữ liệu UltraFeedback để xây dựng ưu tiên nhị phân, và một trong ba phản hồi còn lại của các mô hình ngôn ngữ là bị loại bỏ ngẫu nhiên.

Đánh Giá

Để đánh giá hiệu suất của khung công việc Zephyr, các nhà phát triển đã chọn hai bảng đánh giá trò chuyện, một trò chuyện đơn và một trò chuyện đa vòng, trong một nỗ lực để đánh giá khả năng của mô hình để theo dõi hướng dẫn của người dùng và phản ứng tương ứng.

MT-Bench

Bảng đánh giá MT-Bench bao gồm 160 câu hỏi phân bố trên 8 lĩnh vực kiến thức duy nhất, và dưới bảng đánh giá MT-Bench, mô hình phải trả lời một câu hỏi ban đầu và cung cấp một câu trả lời cho câu hỏi tiếp theo ngay sau.

AlpacaEval

AlpacaEval là một bảng đánh giá trò chuyện đơn dưới đó, mô hình hoặc khung công việc tạo ra các câu trả lời cho hơn 800 câu hỏi phân bố trên các chủ đề khác nhau với trọng tâm chính là tính hữu ích.

Ngoài hai bảng đánh giá chính này, khung công việc Zephyr-7B cũng được đánh giá trên Open LLM Leaderboard cho các nhiệm vụ phân loại đa lớp, ARC, HellaSwag, MMLU, và nhiều nhiệm vụ khác. Hơn nữa, bất kể bảng đánh giá nào mà khung công việc Zephyr-7B được đánh giá, nó đều được so sánh với một loạt các mô hình trả phí và mã nguồn mở, với quy trình căn chỉnh của chúng là yếu tố phân biệt duy nhất.

Kết quả

Bây giờ hãy xem xét cách khung công việc Zephyr-7B thực hiện và so sánh với các mô hình ngôn ngữ hàng đầu hiện tại.

dDPO – Thực hiện nâng cao khả năng tương tác

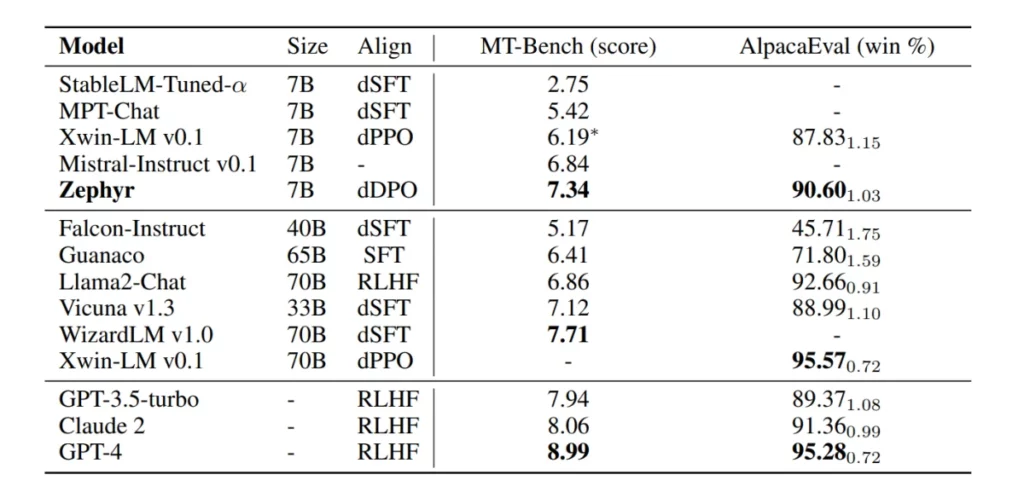

Bảng dưới đây so sánh hiệu suất của khung công việc Zephyr-7B với các mô hình ngôn ngữ hàng đầu trên các bảng đánh giá AlpacaEval và MT-Bench.

Như có thể thấy rõ, khi so sánh với các mô hình mở 7 tỷ tham số, khung công việc Zephyr-7B không chỉ vượt trội đáng kể so với các mô hình dSFT trên hai bảng đánh giá, mà còn thiết lập các tiêu chuẩn mới về hiệu suất. Hơn nữa, khung công việc Zephyr-7B cũng giành được điểm cao hơn so với khung công việc XWIN-LM-7B, một trong những mô hình hiếm hoi được huấn luyện theo phương pháp dPPO hoặc PPO được chưng cất. Hơn nữa, hiệu suất của khung công việc Zephyr-7B là có thể so sánh với kết quả của các mô hình ngôn ngữ lớn hơn nhiều như Llama2-Chat với hơn 70 tỷ tham số.

dDPO – Nâng cao hiệu suất đối với tác vụ học thuật

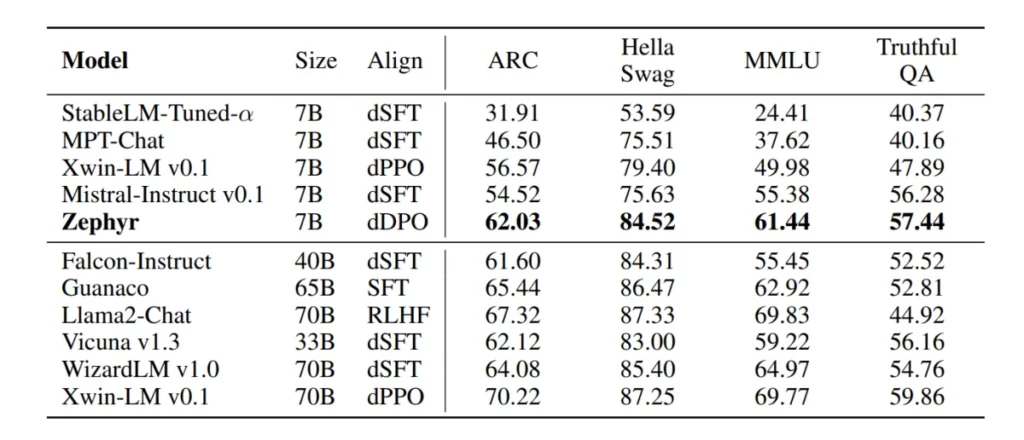

Hình ảnh dưới đây so sánh hiệu suất của khung công việc Zephyr-7B với một loạt các khung công việc LLM mã nguồn mở và trả phí.

Như có thể thấy, khung công việc Zephyr-7B vượt trội đáng kể so với các khung công việc LLM có 7 tỷ tham số, và khoảng cách giữa hiệu suất của nó và hiệu suất của các mô hình dSFT tốt nhất cũng rõ ràng. Khi số lượng tham số tăng lên, khung công việc Zephyr-7B có phần yếu hơn, mặc dù nó vẫn sánh kịp hiệu suất của các khung công việc có 40 tỷ tham số.

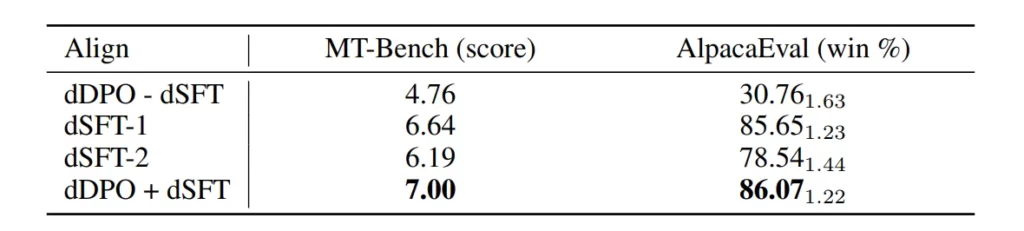

Tối ưu hóa trình tụ ưu tiên

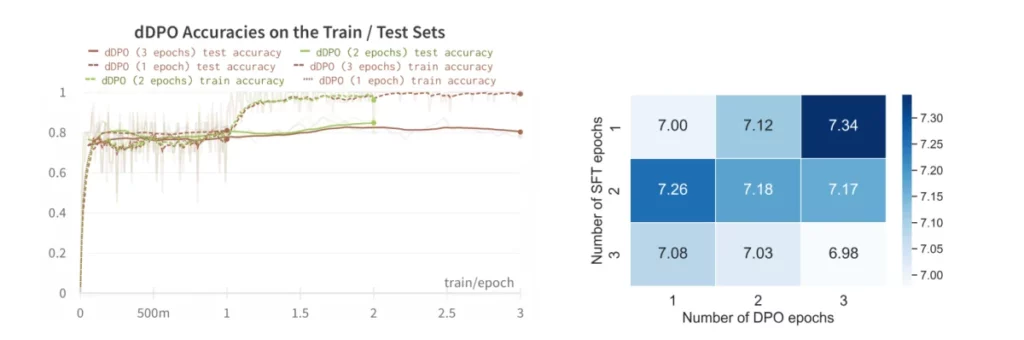

Trong hình ảnh sau, chúng ta đánh giá cách các bước khác nhau trong quá trình căn chỉnh ảnh hưởng đến hiệu suất. Như có thể thấy, phương pháp dDPO khi kết hợp với dSFT tăng đáng kể hiệu suất trên cả bộ dữ liệu MT-Bench và AlpacaEval.

Cuối cùng, trong hình ảnh sau, chúng ta có thể thấy độ chính xác trong quá trình thử nghiệm và huấn luyện trong quá trình triển khai DPO. Như có thể thấy, phương pháp DPO không ảnh hưởng đến hiệu suất của mô hình trên các nhiệm vụ thứ cấp.

Thay lời kết

Trong bài viết này, chúng ta đã thảo luận về khung công việc Zephyr-7B dựa trên khung công việc Mistral-7B hàng đầu hiện tại, nhằm giải quyết thách thức của chưng cất căn chỉnh từ một mô hình ngôn ngữ lớn đến một khung công việc đã được tiền huấn luyện nhỏ hơn nhiều. Mục tiêu chính của khung công việc là cho phép nhà phát triển tạo ra các mô hình ngôn ngữ lớn nhỏ hơn mà căn chỉnh với ý định của người dùng gần hơn bao giờ hết. Khung công việc Zephyr-7B không chỉ xem xét việc áp dụng các phương pháp hiện tại cho các khung công việc LLM lớn hơn như dSFT, mà còn khám phá khả năng sử dụng các phương pháp khác để học một mô hình trò chuyện với sự căn chỉnh tốt hơn với ý định của người dùng.

Tuy nhiên, mặc dù có kết quả đầy hứa hẹn, khung công việc Zephyr-7B không hoàn hảo, và vẫn còn một số công việc cần được thực hiện. Một trong những hạn chế rõ ràng là sử dụng khung công việc GPT-4 để đánh giá các bảng đánh giá MT-Bench và AlpacaEval, mà thường có độ chệch theo hướng các mô hình nó chưng cất. Tuy nhiên, khung công việc Zephyr-7B hy vọng mở đường cho việc khám phá khả năng của các mô hình mã nguồn mở nhỏ hơn có khả năng căn chỉnh với ý định và tương tác của người dùng.