Tác gỉa Haziqa Sajid

Ngày 3 tháng 1 năm 2024

Các Mô Hình Ngôn Ngữ Lớn (LLMs) đã đóng góp vào việc tiến xa trong lĩnh vực xử lý ngôn ngữ tự nhiên (NLP), tuy nhiên vẫn tồn tại một khoảng trống trong việc hiểu ngữ cảnh. LLMs đôi khi có thể tạo ra các phản ứng không chính xác hoặc không đáng tin cậy, hiện tượng này được biết đến là “ảo giác” (hallucinations).

Ví dụ, với ChatGPT, sự xuất hiện của các ảo giác được ước lượng là khoảng 15% đến 20%, xấp xỉ 80% trong thời gian.

Retrieval Augmented Generation (RAG) là một khung nhìn Trí Tuệ Nhân Tạo (AI) mạnh mẽ được thiết kế để giải quyết khoảng trống ngữ cảnh bằng cách tối ưu hóa đầu ra của LLM. RAG tận dụng kiến thức ngoại vi rộng lớn thông qua việc truy xuất, nâng cao khả năng của LLMs để tạo ra những phản ứng chính xác, đáng tin cậy và giàu ngữ cảnh.

Hãy khám phá ý nghĩa của RAG trong hệ thống AI, để hiểu rõ khả năng của nó trong việc cách mạng hóa việc hiểu và tạo ra ngôn ngữ.

Retrieval Augmented Generation (RAG) là gì?

Là một khung nhìn lai đặc biệt, RAG kết hợp những ưu điểm của mô hình tạo ra và mô hình truy xuất. Sự kết hợp này tận dụng nguồn thông tin từ bên thứ ba để hỗ trợ các biểu diễn nội tại và tạo ra các câu trả lời chính xác và đáng tin cậy hơn.

Kiến trúc của RAG là độc đáo, kết hợp mô hình chuỗi-qua-chuỗi (seq2seq) với các thành phần Dense Passage Retrieval (DPR). Sự kết hợp này giúp mô hình tạo ra những phản ứng có liên quan ngữ cảnh, dựa trên thông tin chính xác.

RAG xây dựng tính minh bạch thông qua cơ chế mạnh mẽ để kiểm tra và xác minh thông tin, đảm bảo tính đáng tin cậy và độ chính xác.

Cách thức hoạt động của RAG (Retrieval Augmented Generation)?

Năm 2020, Meta giới thiệu khung nhìn RAG để mở rộng khả năng của LLMs ngoài dữ liệu đào tạo của chúng. Giống như một kỳ thi mở sách, RAG cho phép LLMs tận dụng kiến thức chuyên sâu để có những phản ứng chính xác hơn bằng cách truy cập thông tin thế giới thực để trả lời câu hỏi, thay vì chỉ dựa vào những sự thật được ghi nhớ.

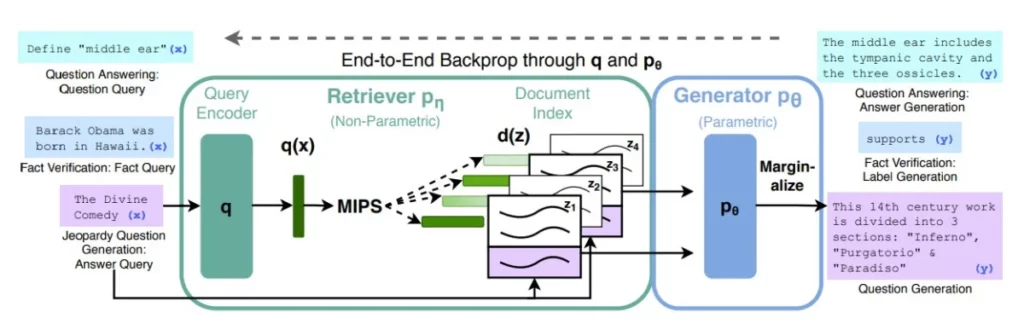

Mô Hình RAG Gốc của Meta (Nguồn Hình Ảnh)

Kỹ thuật độc đáo này rời xa khỏi phương pháp dựa trên dữ liệu, tích hợp các thành phần dựa trên kiến thức, tăng cường độ chính xác, độ chính xác và hiểu biết ngữ cảnh của các mô hình ngôn ngữ.

Ngoài ra, RAG hoạt động trong ba bước, nâng cao khả năng của các mô hình ngôn ngữ.

- Truy xuất (Retrieval): Các mô hình truy xuất tìm kiếm thông tin liên quan đến câu hỏi của người dùng để tăng cường phản ứng của mô hình ngôn ngữ. Điều này bao gồm việc so khớp đầu vào của người dùng với các tài liệu liên quan, đảm bảo truy cập vào thông tin chính xác và hiện đại. Các kỹ thuật như Dense Passage Retrieval (DPR) và độ tương đồng cosine đóng góp vào việc truy xuất hiệu quả trong RAG và làm sắc nét thêm thông tin bằng cách hạn chế phạm vi.

- Bổ sung (Augmentation): Sau quá trình truy xuất, mô hình RAG tích hợp truy vấn của người dùng với dữ liệu đã truy xuất được, sử dụng các kỹ thuật kỹ thuật kỹ thuật như trích xuất từ khóa, vv. Bước này giao tiếp thông tin và ngữ cảnh một cách hiệu quả với LLM, đảm bảo sự hiểu biết toàn diện để tạo ra kết quả đầu ra chính xác.

- Tạo ra (Generation): Trong giai đoạn này, thông tin được bổ sung được giải mã bằng cách sử dụng một mô hình phù hợp, chẳng hạn như một mô hình chuỗi-qua-chuỗi, để tạo ra phản ứng cuối cùng. Bước tạo ra đảm bảo rằng đầu ra của mô hình là một cách logic, chính xác và được tùy chỉnh theo câu hỏi của người dùng.

Lợi ích của RAG

RAG giải quyết những thách thức quan trọng trong lĩnh vực NLP, như giảm thiểu sự không chính xác, giảm sự phụ thuộc vào các bộ dữ liệu tĩnh và nâng cao hiểu biết ngữ cảnh để tạo ra ngôn ngữ chính xác và tinh tế hơn.

Khung nhìn độc đáo của RAG tăng cường độ chính xác và độ tin cậy của nội dung được tạo ra, cải thiện hiệu suất và tính linh hoạt của các hệ thống AI.

1. Giảm ảo giác của LLM

Bằng cách tích hợp nguồn thông tin bên ngoài trong quá trình tạo câu hỏi, RAG đảm bảo rằng các phản ứng được cố định trên thông tin chính xác và có liên quan ngữ cảnh. Các phản ứng cũng có thể bao gồm các trích dẫn hoặc tham chiếu, giúp người dùng tự mình xác minh thông tin. Phương pháp này đáng kể tăng cường tính đáng tin cậy của nội dung do AI tạo ra và giảm thiểu ảo giác.

2. Phản ứng chính xác và cập nhật

RAG giảm thiểu thời gian cắt của dữ liệu đào tạo hoặc nội dung sai lầm bằng cách liên tục truy xuất thông tin thời gian thực. Những người phát triển có thể tích hợp một cách mượt mà những nghiên cứu mới nhất, thống kê hoặc tin tức trực tiếp vào các mô hình tạo ra. Hơn nữa, nó kết nối LLMs với các nguồn cung cấp trực tuyến như dòng thời sự trên mạng xã hội, trang tin tức và các nguồn thông tin động. Tính năng này biến RAG thành một công cụ quý giá cho các ứng dụng đòi hỏi thông tin chính xác và thời gian thực.

3. Hiệu quả chi phí

Phát triển chatbot thường liên quan đến việc sử dụng các mô hình cơ sở là LLMs có thể truy cập qua API với quá trình đào tạo rộng lớn. Tuy nhiên, việc đào tạo lại những mô hình cơ sở này cho dữ liệu cụ thể của lĩnh vực đòi hỏi chi phí tính toán và tài chính cao. RAG tối ưu hóa việc sử dụng nguồn lực và truy xuất thông tin một cách chọn lọc khi cần, giảm thiểu các tính toán không cần thiết và nâng cao hiệu suất tổng thể. Điều này cải thiện tính khả thi kinh tế của việc triển khai RAG và đóng góp vào tính bền vững của các hệ thống AI.

4. Tổng hợp thông tin

RAG tạo ra các phản ứng toàn diện và có liên quan bằng cách kết hợp thông tin đã truy xuất một cách mượt mà với khả năng tạo ra. Sự tổng hợp này từ các nguồn thông tin đa dạng tăng cường độ sâu của hiểu biết của mô hình, mang lại các đầu ra chính xác hơn.

5. Dễ dàng đào tạo

Tính thân thiện với người sử dụng của RAG thể hiện rõ trong sự dễ đào tạo của nó. Những người phát triển có thể điều chỉnh mô hình một cách dễ dàng, điều chỉnh nó cho các lĩnh vực hoặc ứng dụng cụ thể. Sự đơn giản trong quá trình đào tạo này giúp tích hợp RAG một cách mượt mà vào nhiều hệ thống AI khác nhau, biến nó thành một giải pháp linh hoạt và dễ tiếp cận để nâng cao khả năng hiểu và tạo ngôn ngữ.

Khả năng của RAG trong việc giải quyết vấn đề ảo giác của LLM và vấn đề cập nhật dữ liệu làm cho nó trở thành một công cụ quan trọng cho các doanh nghiệp muốn tăng cường độ chính xác và độ tin cậy của hệ thống AI của họ.

Các ứng dụng điển hình

Khả năng thích ứng của RAG mang đến những giải pháp biến đổi với tác động thực tế, từ các công cụ máy tìm kiếm đến việc nâng cao khả năng tìm kiếm.

1. Hệ thống kiến thức

RAG có thể biến đổi các mô hình ngôn ngữ truyền thống thành các hệ thống kiến thức toàn diện cho việc tạo nội dung mới nhất và đáng tin cậy. Điều này đặc biệt quan trọng trong các tình huống đòi hỏi thông tin mới nhất, như trong các nền tảng giáo dục, môi trường nghiên cứu, hoặc các ngành công nghiệp đòi hỏi thông tin lớn.

2. Bổ sung tìm kiếm

Bằng cách tích hợp LLMs với các máy tìm kiếm, việc làm giàu kết quả tìm kiếm bằng các câu trả lời được tạo ra bởi LLM cải thiện độ chính xác của phản ứng đối với các truy vấn thông tin. Điều này cải thiện trải nghiệm người dùng và tối ưu hóa luồng công việc, làm cho việc truy cập thông tin cần thiết cho nhiệm vụ của họ trở nên dễ dàng hơn.

3. Tóm tắt văn bản

RAG có thể tạo ra các bản tóm tắt súc tích và thông tin từ các lượng văn bản lớn. Hơn nữa, RAG giúp người dùng tiết kiệm thời gian và công sức bằng cách cho phép phát triển các bản tóm tắt văn bản chính xác và toàn diện bằng cách thu thập dữ liệu liên quan từ nguồn thông tin của bên thứ ba.

4. Chatbot Hỏi & Đáp

Việc tích hợp LLMs vào chatbot biến đổi các quy trình theo dõi bằng cách cho phép trích xuất tự động thông tin chính xác từ các tài liệu và cơ sở kiến thức của công ty. Điều này nâng cao hiệu suất của chatbot trong việc giải quyết các câu hỏi của khách hàng một cách chính xác và nhanh chóng.

Triển vọng tương lai và đổi mới trong RAG

Với sự tập trung ngày càng nhiều vào các phản ứng cá nhân hóa, tổng hợp thông tin thời gian thực, và giảm phụ thuộc vào việc đào tạo liên tục, RAG hứa hẹn những tiến triển cách mạng trong mô hình ngôn ngữ để hỗ trợ tương tác AI linh hoạt và có nhận thức ngữ cảnh.

Khi RAG phát triển, khả năng tích hợp mượt mà của nó vào nhiều ứng dụng khác nhau với độ chính xác tăng cao mang lại cho người dùng trải nghiệm tương tác tinh tế và đáng tin cậy.