Tác giả: Sergey Karayev & Charles Frye.

ngày 30 tháng 10 năm 2023.

Thảo luận về trang này trên Hacker News, ngày 21 tháng 5 năm 2023.

Huấn luyện và chạy các mạng neural thường đòi hỏi sự gia tốc phần cứng, và trình gia tốc phần cứng phổ biến nhất là bộ xử lý đồ họa (GPU) đáng kính.

Chúng tôi đã tổng hợp tất cả thông tin về giá cả từ các nhà cung cấp dịch vụ GPU trên đám mây vào các bảng, có thể sắp xếp và lọc theo ý muốn của bạn!

Chúng tôi đã chia các ưu đãi từ nhà cung cấp thành hai lớp:

- Máy chủ đám mây với GPU, đó là các máy chạy liên tục (nhưng có thể bị gián đoạn trước khi hoàn thành) và

- GPU không máy chủ (Serverless GPUs), đó là các máy chạy tự động tắt khi không có lưu lượng truy cập (giống như AWS Lambda hoặc Google Cloud Function).

Chúng tôi rất hoan nghênh sự giúp đỡ của bạn trong việc thêm các nhà cung cấp dịch vụ GPU trên đám mây và duy trì thông tin giá cả hiện tại.

Vui lòng tạo một vấn đề (issue) hoặc đề xuất (pull request) trên kho lưu trữ (repo) này, chỉnh sửa tệp tin này để cập nhật nội dung trên trang này hoặc một trong những tệp CSV để cập nhật dữ liệu: cloud-gpus.csv cho máy chủ và serverless-gpus.csv cho tùy chọn không máy chủ.

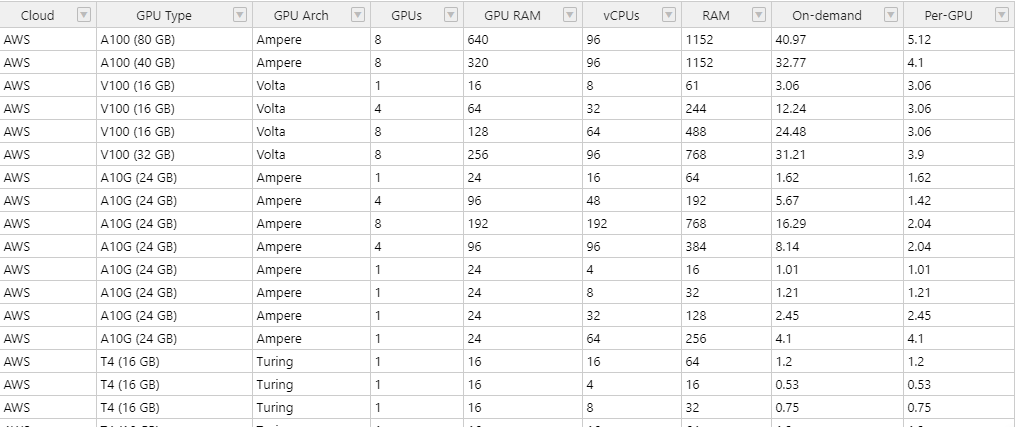

So sánh Máy chủ đám mây với GPU

Ghi chú

Bảng dưới đây không bao gồm tất cả các cấu hình có thể của tất cả các nhà cung cấp, vì các nhà cung cấp khác nhau trong chiến lược cấu hình của họ.

- Đa số các nhà cung cấp, bao gồm AWS, Azure và Lambda, cung cấp các trường hợp với cấu hình được thiết lập trước.

- Trên GCP, bất kỳ máy phù hợp nào có thể được kết nối với một cấu hình của GPU.

- Trên các nhà cung cấp khác, như Oblivus Cloud, Cudo Compute và RunPod, người dùng có kiểm soát chính xác về tài nguyên mà họ yêu cầu. Lưu ý rằng RunPod’s Community Cloud, Oblivus và Cudo đều là “đám mây mở”, có nghĩa là tính toán được cung cấp bởi bên thứ ba.

- Đối với các nhà cung cấp không có cấu hình trường hợp được thiết lập trước, chúng tôi đã chọn các cấu hình xấp xỉ với các tùy chọn của AWS. Thường thì các cấu hình này phù hợp cho các tải công việc yêu cầu giao tiếp mạnh giữa các GPU.

- Khi có thể, các vùng đã được đặt ở phía tây hoặc trung tâm của Hoa Kỳ. Sự có sẵn của GPU phụ thuộc vào vùng đó.

- Dữ liệu gốc có thể được tìm thấy trong tệp CSV trên GitHub.

- Chi phí có thể được giảm đáng kể thông qua khôi phục sau khi bị gián đoạn và khôi phục chuyển đổi giữa các đám mây. Nếu bạn không muốn tự tạo, hãy xem xét sử dụng một công cụ như SkyPilot. Xem thảo luận về việc ra mắt của họ trên Hacker News, ngày 13 tháng 12 năm 2022.

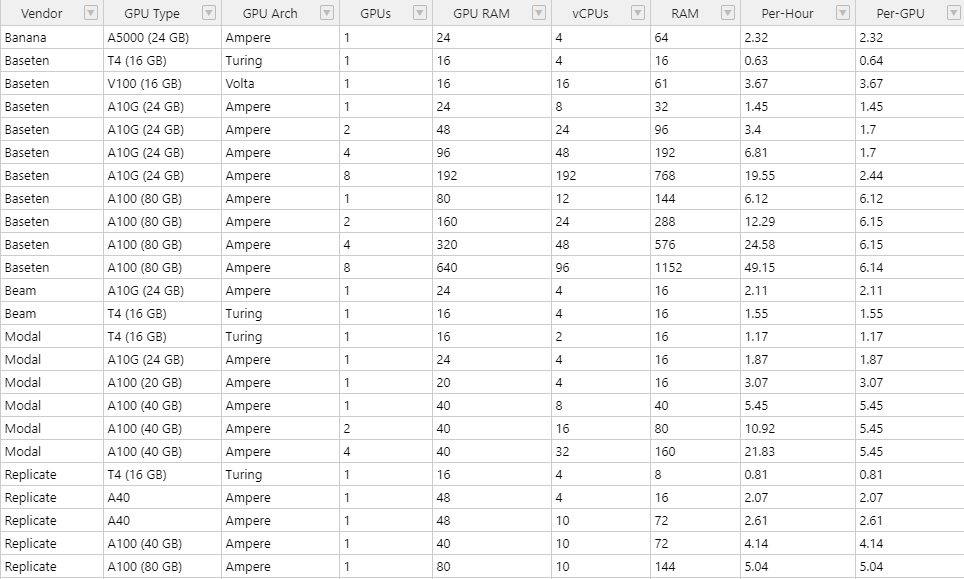

GPU không máy chủ (Serverless GPUs)

Ghi chú

Chúng tôi sử dụng định nghĩa cổ điển của “serverless”, nhờ vào thông báo ban đầu từ AWS về tính năng tính toán không máy chủ: không quản lý máy chủ, tự động co giãn linh hoạt, khả năng sẵn có cao, và không có khả năng không hoạt động. Chúng tôi chỉ bao gồm các dịch vụ phù hợp với tiêu chí này trong các tùy chọn dưới đây.

Hơn nữa, chúng tôi chỉ bao gồm các dịch vụ cung cấp GPU không máy chủ, có thể sử dụng để chạy công việc tùy chỉnh, không chỉ là dự đoán trong các mô hình cụ thể dưới dạng dịch vụ.

- So sánh giá trực tiếp có thể phức tạp hơn đối với các tùy chọn không máy chủ: thời gian khởi động lạnh và logic tự động co giãn có thể ảnh hưởng đáng kể đến chi phí của lưu lượng.

- Một số nhà cung cấp cho phép cấu hình tài nguyên CPU và RAM. Chúng tôi đã chọn các giá trị mặc định hợp lý, thường tương tự như các tùy chọn cố định của các nhà cung cấp khác.

- Bạn có thể tìm thấy trang giá cả cho các nhà cung cấp tại đây: Banana, Baseten, Beam, Modal, Replicate, RunPod

- GPU không máy chủ là một công nghệ mới hơn, vì vậy các chi tiết thay đổi nhanh chóng và bạn có thể mong đợi sự cố/lộn xộn trong quá trình phát triển. Hãy giữ tinh thần lạnh lẽo!

- Dữ liệu gốc có thể được tìm thấy trong một tệp CSV trên GitHub.

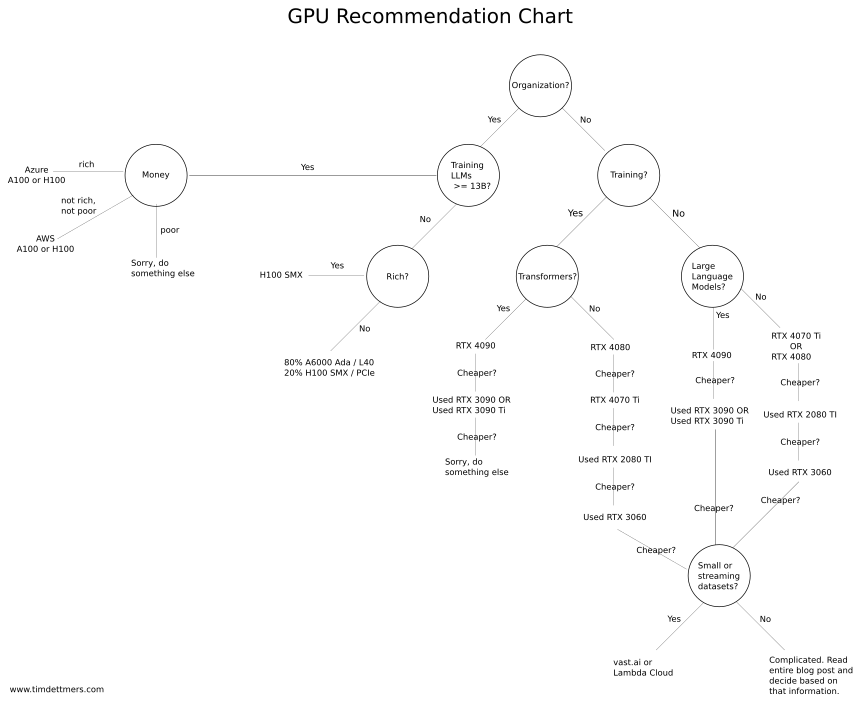

Làm thế nào để chọn GPU?

Trang này được thiết kế để theo dõi và khám phá tình hình giá cả và phần cứng hiện tại cho các GPU trên đám mây.

Nếu bạn muốn tư vấn về máy tính và thẻ GPU nào phù hợp nhất cho trường hợp sử dụng của bạn, chúng tôi khuyên bạn nên đọc bài viết trên blog của Tim Dettmer về GPU cho deep learning.

Toàn bài viết là một hướng dẫn và câu hỏi thường gặp về GPU cho mạng neural sâu (DNNs), nhưng nếu bạn chỉ muốn biết về các hướng dẫn quyết định cuối cùng, xem phần “GPU Recommendations” (Gợi ý về GPU), đó là nguồn thông tin cho biểu đồ dưới đây.

Bảng dữ liệu hiệu suất dịch vụ GPU

Dưới đây là các số liệu TFLOPs gốc của các GPU khác nhau có sẵn từ các nhà cung cấp dịch vụ đám mây.

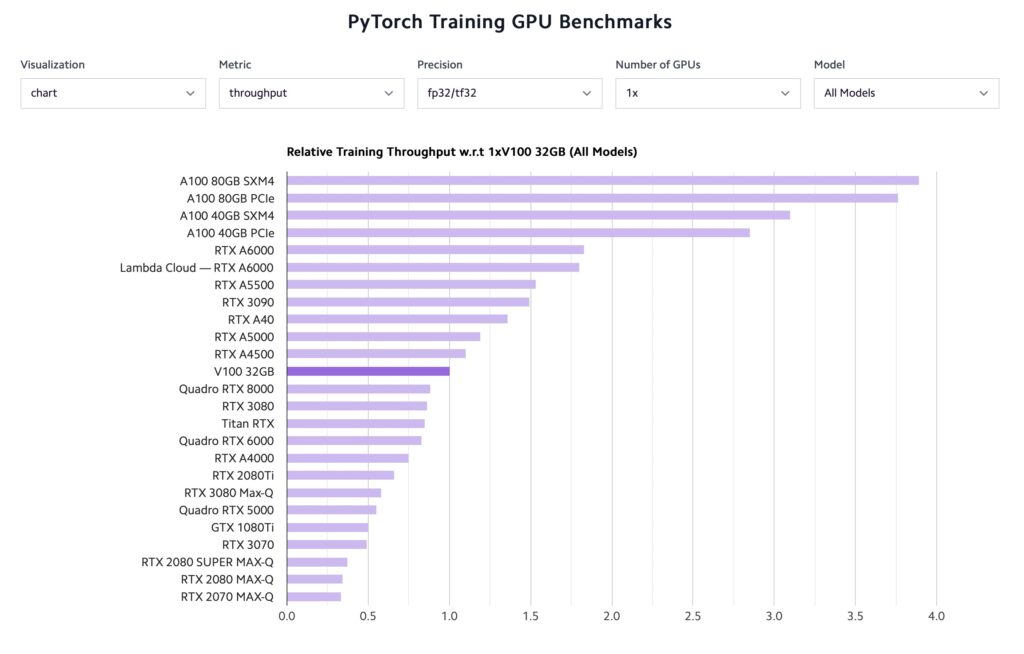

Bảng đánh giá hiệu suất GPU

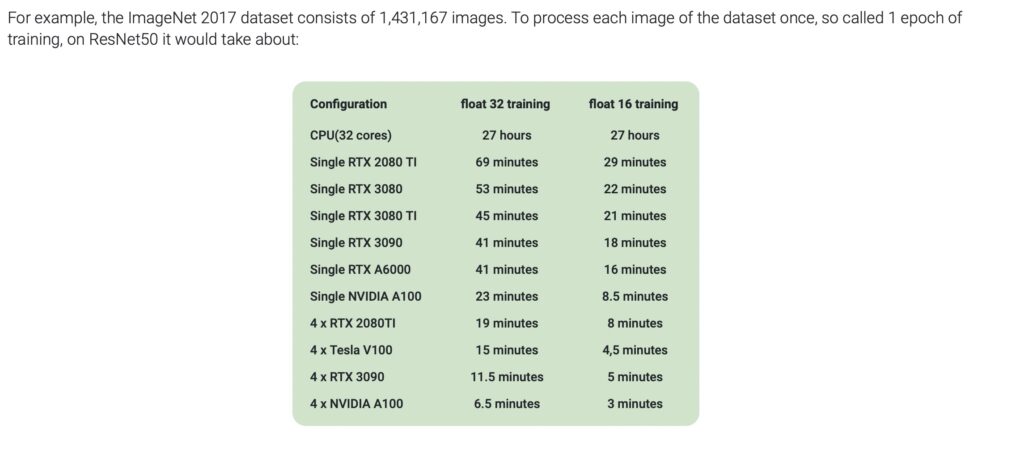

Dưới đây là một số tiêu chí kiểm tra hiệu suất cơ bản cho các GPU trong các công việc học sâu phổ biến.