Tác giả: Daniel Vila (dvilasuero)

TL;DR

Việc chọn đúng mô hình LLM mã nguồn mở không phải là tìm model “tốt nhất” theo nghĩa tuyệt đối, mà là chọn model phù hợp nhất với trường hợp sử dụng cụ thể, phần cứng, ngân sách và các hạn chế của bạn. Hướng dẫn này giới thiệu cách đánh giá dựa trên các tiêu chí như điểm benchmark, khả năng triển khai thực tế, và còn chỉ cách sử dụng AI Sheets để thử nghiệm hàng nghìn mô hình cùng các inference provider tốt nhất hiện nay. Hugging Face

1. Tại sao cần hướng dẫn này

Với hơn 2 triệu mô hình công khai trên Hugging Face và hàng tuần lại có thêm nhiều model mới, việc chọn mô hình phù hợp có thể khiến bạn cảm thấy quá tải. Nhiều hướng dẫn chỉ liệt kê các model phổ biến, nhưng thực tế, bạn cần một khung đánh giá dựa trên các hạn chế và yêu cầu thực tế của mình. Hugging Face

2. Những điều cần xác định trước khi bắt đầu

Bạn nên trả lời rõ các câu hỏi sau:

- Phần cứng: GPU bạn có là gì? Bạn chạy model trên máy cá nhân hay trên đám mây? VRAM bạn có thực tế là bao nhiêu?

- Mục đích sử dụng: Bạn muốn model để làm gì (viết code, sáng tác, phân tích, chat…)? Chất lượng quan trọng hơn tốc độ, hay ngược lại? Có cần khả năng xử lý đa phương thức (multimodal) không?

- Hạn chế thực tế: Ngân sách inference như thế nào? Cần fine-tune không? Có yêu cầu về tuân thủ quy định hoặc bảo mật dữ liệu không? Hugging Face

3. Tiêu chí đánh giá thực sự quan trọng

- Hiệu suất theo nhiệm vụ (không chỉ benchmark)

– Đừng chỉ nhìn vào điểm MMLU. Model có thể xuất sắc trên benchmark nhưng lại hoạt động kém với dữ liệu đặc thù của bạn. Với tác vụ code nên dùng HumanEval, SWE-bench; viết lách thì EQBench Creative Writing hoặc WritingBench; trợ lý văn bản thì dựng tập dữ liệu đánh giá riêng từ trường hợp thực tế. Hugging Face - Yêu cầu phần cứng

– Kích thước model và lượng VRAM cần thiết rất khác nhau:- 1–3 tỷ tham số (3–6 GB FP16) phù hợp với RTX 3060, sử dụng cho chat cơ bản và phân loại.

- 7–8 tỷ (14–16 GB FP16, ~6–8 GB nếu 4-bit quant) phù hợp với RTX 4080/4090 hoặc A6000—dùng được cho assistant tổng hợp, tóm tắt, viết code.

- 13–14 tỷ (26–28 GB) mạnh hơn về suy luận, phù hợp cho reasoning phức tạp.

- 70 tỷ trở lên (140 GB VRAM, ~35–40 GB nếu 4-bit) chỉ khả thi trên multi-GPU—phù hợp ứng dụng doanh nghiệp.

– Quantization (4-bit hoặc 8-bit) có thể giảm VRAM đáng kể với chỉ mất nhẹ về chất lượng. Hugging Face

- Tốc độ inference và hiệu năng của từng nhà cung cấp

– Các nhà cung cấp tối ưu như Groq, Cerebras cho tốc độ truy vấn siêu nhanh, phù hợp lĩnh vực real-time.

– Đám mây tiêu chuẩn như AWS, Azure, GCP phù hợp cho quy mô doanh nghiệp.

– Các inference provider chung (Together AI, Replicate) cân bằng được tốc độ, chi phí và dễ sử dụng.

– Triển khai cục bộ (local): nhanh chóng, bảo mật tuyệt đối – phù hợp dữ liệu nhạy cảm.

– Tốc độ còn phụ thuộc vào kích cỡ model, độ dài context, xử lý hàng loạt vs độ trễ, vị trí địa lý server… Hugging Face - Độ phức tạp khi triển khai

– Chạy local: dễ bắt đầu, kiểm soát tốt, nhưng bị giới hạn phần cứng. Các công cụ hỗ trợ bao gồm vLLM, llamacpp…

– Inference providers: dễ chuyển model, trả theo sử dụng. Không cần lo hạ tầng.

– Đám mây: quy mô lớn hơn, chi phí dự đoán được, có thể dùng Hugging Face Inference Endpoints cho doanh nghiệp. Hugging Face - Cộng đồng và hệ sinh thái

– Chọn model có cộng đồng mạnh, có tài liệu, hỗ trợ fine-tune, cập nhật thường xuyên.

– Hỗ trợ API chuẩn (như OpenAI) và các công cụ như transformers, agents, RAG frameworks… Hugging Face

4. Những sai lầm thường gặp

- Không phải model mới nhất là tốt nhất.

- Bỏ qua tốc độ inference — model chậm có thể vô dụng cho ứng dụng tương tác.

- Không thử với dữ liệu thật — benchmark tổng quát không phản ánh định dạng, phong cách hay edge-case của bạn.

- Không tính tới độ phức tạp triển khai khi lên production. Hugging Face

5. Quy trình thực tế đề xuất

- Bước 1: Ghi rõ các hạn chế (phần cứng, thời gian phản hồi, ngân sách…).

- Bước 2: Chọn sơ bộ 3–5 model phù hợp theo hiệu suất nhiệm vụ.

- Bước 3: Test với dữ liệu thật — mà không cần code phức tạp nhờ AI Sheets. Tải lên file CSV, tạo các cột câu hỏi cho mỗi model, so sánh kết quả trực quan, thêm “giám khảo LLM” để đánh giá và cải tiến. Hugging Face

- Bước 4: So sánh tổng chi phí sở hữu — inference, fine-tune, bảo trì…

- Bước 5: Bắt đầu từ giải pháp đơn giản, sau đó mở rộng khi cần. Hugging Face

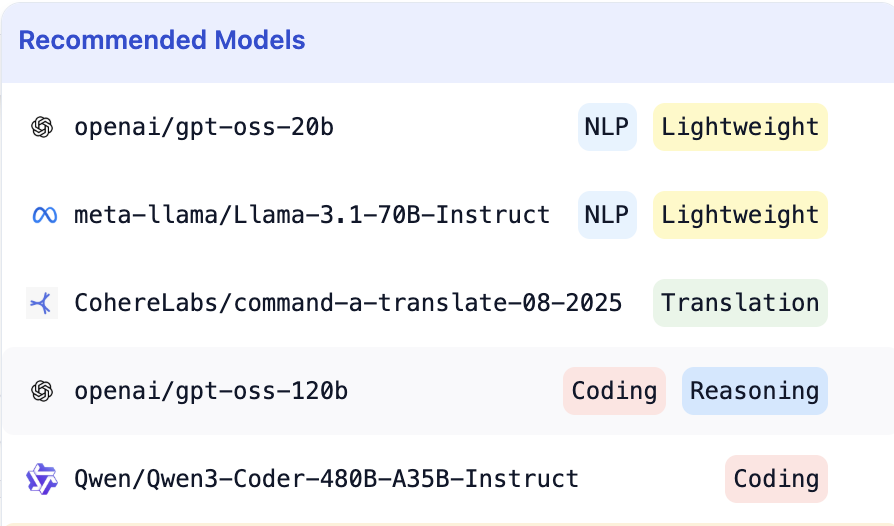

6. Một số mô hình được AI Sheets gợi ý để bắt đầu thử

- General purpose & reasoning:

- openai/gpt-oss-20b — model nhẹ, toàn diện

- openai/gpt-oss-120b — mạnh hơn về suy luận

- meta-llama/Llama-3.1-70B-Instruct — model chủ lực, đáng tin cậy

- Chuyên về code:

- Qwen/Qwen3-Coder-480B-A35B-Instruct

- Chuyên về dịch thuật:

- CohereLabs/command-a-translate-08-2025 Hugging Face

7. Hướng đi tương lai

Thay vì tìm “mô hình hoàn hảo”, hãy xây quy trình đánh giá lặp lại để bạn dễ dàng thích nghi khi có model mới. Quan trọng là có bộ dữ liệu đánh giá tốt và pipeline triển khai ổn định trước khi quyết định chọn model dài hạn. Hugging Face