Nội dung dưới đây là tài liệu cáo bạch được Meta công bố liên quan đến quá trình huấn luyện mô hình nền tảng Llama 2 và các tinh chỉnh của họ để sử dụng dưới dạng một mô hình Chat. myGPT dịch lại tài liệu này với mong muốn cung cấp thêm cho các bạn một hình ảnh và góc nhìn về phương pháp huấn luyện mô mình ngôn ngữ lớn được áp dụng để có thể xem xét và vận dụng trong các trường hợp sử dụng thực tế của mình.

Trân trọng cảm ơn!

Hugo Touvron∗ Louis Martin† Kevin Stone†

Peter Albert Amjad Almahairi Yasmine Babaei Nikolay Bashlykov Soumya Batra

Prajjwal Bhargava Shruti Bhosale Dan Bikel Lukas Blecher Cristian Canton Ferrer Moya Chen

Guillem Cucurull David Esiobu Jude Fernandes Jeremy Fu Wenyin Fu Brian Fuller Cynthia Gao Vedanuj Goswami Naman Goyal Anthony Hartshorn Saghar Hosseini Rui Hou Hakan Inan Marcin Kardas Viktor Kerkez Madian Khabsa Isabel Kloumann Artem Korenev

Punit Singh Koura Marie-Anne Lachaux Thibaut Lavril Jenya Lee Diana Liskovich Yinghai Lu Yuning Mao Xavier Martinet Todor Mihaylov Pushkar Mishra

Igor Molybog Yixin Nie Andrew Poulton Jeremy Reizenstein Rashi Rungta Kalyan Saladi Alan Schelten Ruan Silva Eric Michael Smith Ranjan Subramanian Xiaoqing Ellen Tan Binh Tang Ross Taylor Adina Williams Jian Xiang Kuan Puxin Xu Zheng Yan Iliyan Zarov Yuchen Zhang

Angela Fan Melanie Kambadur Sharan Narang Aurelien Rodriguez Robert Stojnic Sergey Edunov Thomas Scialom∗

GenAI, Meta

Tóm tắt

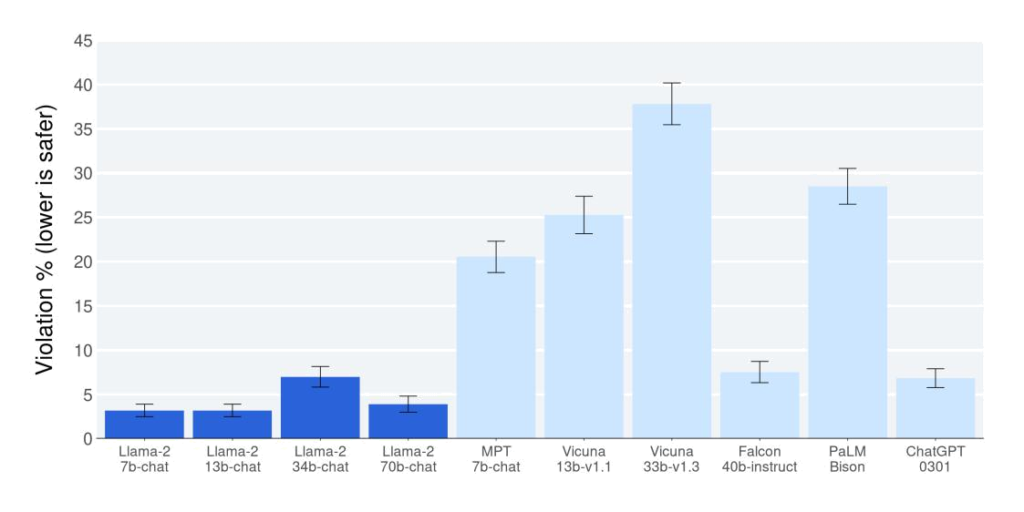

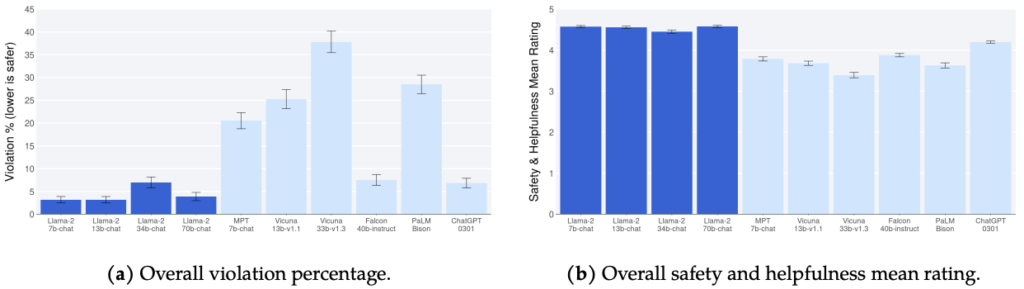

Trong công trình này, chúng tôi phát triển và ra mắt Llama 2, một bộ sưu tập các mô hình ngôn ngữ lớn được tiền huấn luyện và điều chỉnh (LLMs) có quy mô từ 7 tỷ đến 70 tỷ tham số. Các LLM đã được điều chỉnh lại của chúng tôi, gọi là Llama 2-Chat, được tối ưu hóa cho các trường hợp sử dụng trong đối thoại. Các mô hình của chúng tôi vượt trội hơn so với các mô hình trò chuyện mã nguồn mở trên hầu hết các bài đánh giá mà chúng tôi đã kiểm tra và dựa trên các đánh giá của con người về tính hữu ích và tính an toàn, chúng có thể thay thế được cho các mô hình mã nguồn đóng. Chúng tôi cung cấp mô tả chi tiết về phương pháp tiền huấn luyện lại và cải tiến tính an toàn của Llama 2-Chat nhằm cho phép cộng đồng xây dựng và đóng góp vào việc phát triển có trách nhiệm của LLMs.

1. Giới thiệu

Các Mô hình Ngôn ngữ Lớn (LLMs) đã cho thấy sự hứa hẹn lớn như những trợ lý Trí tuệ Nhân tạo cao cấp có khả năng xuất sắc trong các nhiệm vụ tư duy phức tạp yêu cầu kiến thức chuyên gia qua nhiều lĩnh vực, bao gồm các lĩnh vực chuyên môn như lập trình và sáng tác sáng tạo. Chúng cho phép tương tác với con người thông qua giao diện trò chuyện trực quan, điều này đã dẫn đến việc sử dụng rộng rãi và nhanh chóng trong cộng đồng công chúng.

Khả năng của các LLMs là đáng kinh ngạc khi xem xét sự đơn giản của phương pháp đào tạo. Các transformer tự động tạo được tiền huấn luyện trên một bộ dữ liệu tự học rộng lớn, sau đó tiến hành điều chỉnh theo sở thích của con người thông qua các kỹ thuật như Học tăng cường với Phản hồi từ Con người (RLHF). Tuy phương pháp đào tạo đơn giản, yêu cầu tính toán cao đã hạn chế việc phát triển LLMs chỉ trong một số nhà phát triển. Một số mô hình LLMs đã được công bố công khai (như BLOOM (Scao và cộng sự, 2022), LLaMa-1 (Touvron và cộng sự, 2023), và Falcon (Penedo và cộng sự, 2023)) có hiệu suất tương đương với các mô hình đã được đào tạo trước có nguồn đóng như GPT-3 (Brown và cộng sự, 2020) và Chinchilla (Hoffmann và cộng sự, 2022), nhưng không có mô hình nào trong số này thích hợp thay thế cho các LLMs có nguồn đóng như ChatGPT, BARD và Claude. Các LLMs sản phẩm này đã được điều chỉnh lại mạnh mẽ để phù hợp với sở thích của con người, điều này tăng đáng kể tính sử dụng và tính an toàn của chúng. Bước này có thể đòi hỏi chi phí tính toán và sức lực con người đáng kể và thường không rõ ràng hoặc dễ tái tạo, hạn chế tiến bộ trong cộng đồng nghiên cứu căn chỉnh trí tuệ nhân tạo.

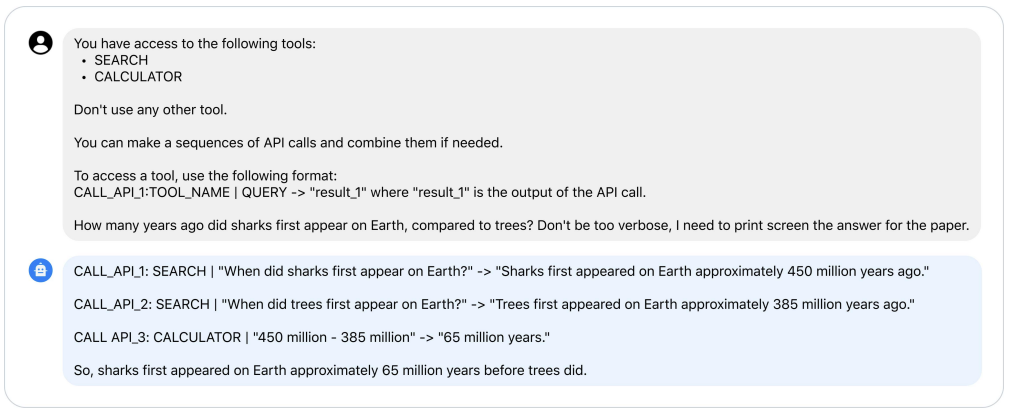

Trong công trình này, chúng tôi phát triển và ra mắt Llama 2, một họ các LLMs được tiền huấn luyện và điều chỉnh lại, bao gồm Llama 2 và Llama 2-Chat, với quy mô lên đến 70 tỷ tham số. Trên chuỗi các bài đánh giá tính hữu ích và tính an toàn mà chúng tôi đã kiểm tra, các mô hình Llama 2-Chat nói chung thể hiện hiệu suất tốt hơn so với các mô hình mã nguồn mở hiện có. Chúng cũng có vẻ tương đương với một số mô hình nguồn đóng, ít nhất là trên các đánh giá từ con người mà chúng tôi đã thực hiện (xem Hình 1 và 3). Chúng tôi đã thực hiện các biện pháp nhằm nâng cao tính an toàn của các mô hình này, bao gồm chú trọng đến dữ liệu chú trọng đến an toàn và điều chỉnh, cũng như tiến hành đánh giá từ “đội đỏ” và sử dụng các đánh giá lặp lại. Ngoài ra, bài báo này đóng góp mô tả chi tiết về phương pháp điều chỉnh và cách tiếp cận cải thiện tính an toàn của LLMs. Chúng tôi hy vọng sự minh bạch này sẽ giúp cộng đồng tái tạo các LLMs đã điều chỉnh và tiếp tục cải thiện tính an toàn của những mô hình đó, đồng thời mở đường cho việc phát triển LLMs có trách nhiệm hơn. Chúng tôi cũng chia sẻ những quan sát mới mẻ mà chúng tôi đã thấy trong quá trình phát triển Llama 2 và Llama 2-Chat, chẳng hạn như sự xuất hiện của việc sử dụng công cụ và tổ chức tri thức theo thời gian.

Chúng tôi đang ra mắt các mô hình sau đây cho công chúng để sử dụng vào nghiên cứu và thương mại:

- Llama 2, phiên bản cập nhật của Llama 1, được huấn luyện trên một sự kết hợp mới của dữ liệu có sẵn công khai. Chúng tôi cũng đã tăng kích thước của tập dữ liệu tiền huấn luyện lên 40%, kéo dài độ dài ngữ cảnh của mô hình gấp đôi và áp dụng kỹ thuật grouped-query attention (Ainslie và cộng sự, 2023). Chúng tôi đang phát hành các biến thể của Llama 2 với số lượng tham số là 7 tỷ, 13 tỷ và 70 tỷ. Chúng tôi cũng đã huấn luyện các biến thể 34 tỷ, chúng tôi báo cáo trong bài báo này nhưng không phát hành.

- Llama 2-Chat, phiên bản được điều chỉnh lại của Llama 2, được tối ưu hóa cho các trường hợp sử dụng trong đối thoại. Chúng tôi phát hành các biến thể của mô hình này với số lượng tham số là 7 tỷ, 13 tỷ và 70 tỷ cũng.

Chúng tôi tin rằng việc phát hành công khai các LLMs, khi được thực hiện một cách an toàn, sẽ mang lại lợi ích tổng quát cho xã hội. Giống như tất cả các LLMs, Llama 2 là một công nghệ mới mang theo các rủi ro tiềm năng khi sử dụng (Bender và cộng sự, 2021b; Weidinger và cộng sự, 2021; Solaiman và cộng sự, 2023). Các thử nghiệm đã được tiến hành cho đến nay đều bằng tiếng Anh và chưa – và không thể – bao phủ tất cả các tình huống. Do đó, trước khi triển khai bất kỳ ứng dụng nào của Llama 2-Chat, các nhà phát triển nên tiến hành kiểm tra và điều chỉnh tính an toàn phù hợp với các ứng dụng cụ thể của mô hình. Chúng tôi cung cấp một hướng dẫn sử dụng có trách nhiệm và ví dụ mã ‖ để hỗ trợ việc triển khai an toàn của Llama 2 và Llama 2-Chat. Chi tiết hơn về chiến lược phát hành có trách nhiệm của chúng tôi có thể được tìm thấy trong Mục 5.3.

Phần còn lại của bài báo này mô tả phương pháp tiền huấn luyện của chúng tôi (Mục 2), phương pháp điều chỉnh lại (Mục 3), cách tiếp cận đảm bảo tính an toàn của mô hình (Mục 4), những quan sát và hiểu biết chính (Mục 5), các nghiên cứu liên quan có liên quan (Mục 6), và kết luận (Mục 7).

2. Tiền huấn luyện

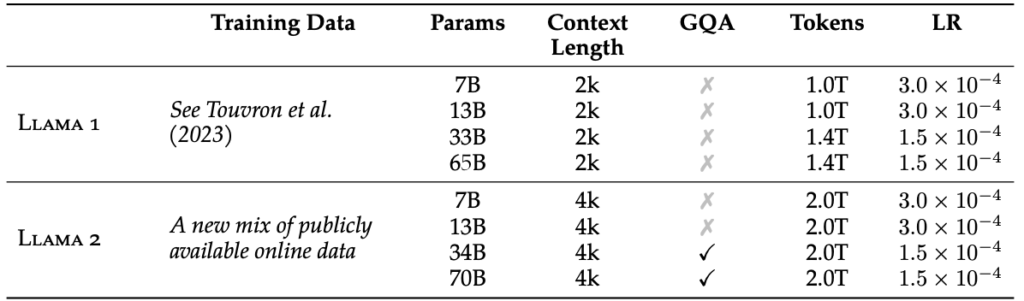

Để tạo ra họ mô hình mới Llama 2, chúng tôi bắt đầu với phương pháp tiền huấn luyện được mô tả trong Touvron et al. (2023), sử dụng một transformer tự động tạo tối ưu hóa, nhưng đã thực hiện một số thay đổi để cải thiện hiệu suất. Cụ thể, chúng tôi thực hiện quá trình làm sạch dữ liệu mạnh mẽ hơn, cập nhật các kết hợp dữ liệu, huấn luyện trên 40% tổng số token nhiều hơn, kéo dài độ dài ngữ cảnh gấp đôi và sử dụng grouped-query attention (GQA) để cải thiện khả năng mở rộng suy luận cho các mô hình lớn hơn của chúng tôi. Bảng 1 so sánh các thuộc tính của các mô hình Llama 2 mới với các mô hình Llama 1.

2.1 Dữ liệu tiền huấn luyện

Tập dữ liệu huấn luyện của chúng tôi bao gồm một kết hợp mới của dữ liệu từ các nguồn có sẵn công khai, không bao gồm dữ liệu từ các sản phẩm hoặc dịch vụ của Meta. Chúng tôi đã cố gắng loại bỏ dữ liệu từ một số trang web đã biết chứa lượng lớn thông tin cá nhân về cá nhân riêng tư. Chúng tôi đã huấn luyện trên 2 nghìn tỷ token dữ liệu vì điều này cung cấp một sự đánh đổi hiệu suất và chi phí tốt, và thực hiện việc tăng cường mẫu các nguồn thông tin trực tiếp nhằm tăng cường kiến thức và giảm thiểu hiện tượng tưởng tượng (hallucinations).

Chúng tôi đã tiến hành nhiều nghiên cứu về dữ liệu tiền huấn luyện để người dùng có thể hiểu rõ hơn về khả năng và giới hạn tiềm năng của các mô hình của chúng tôi; kết quả có thể được tìm thấy trong Mục 4.1.

2.2 Chi tiết huấn luyện

Chúng tôi áp dụng hầu hết các thiết lập tiền huấn luyện và kiến trúc mô hình từ Llama 1. Chúng tôi sử dụng kiến trúc transformer tiêu chuẩn (Vaswani và cộng sự, 2017), áp dụng trước chuẩn hóa bằng RMSNorm (Zhang và Sennrich, 2019), sử dụng hàm kích hoạt SwiGLU (Shazeer, 2020) và các nhúng vị trí rotary (RoPE, Su và cộng sự, 2022). Các khác biệt kiến trúc chính so với Llama 1 bao gồm độ dài ngữ cảnh tăng lên và sử dụng grouped-query attention (GQA). Chúng tôi đưa ra chi tiết mỗi khác biệt này với các thử nghiệm loại trừ trong Phụ lục, Mục A.2.1 để chứng minh tính quan trọng của chúng.

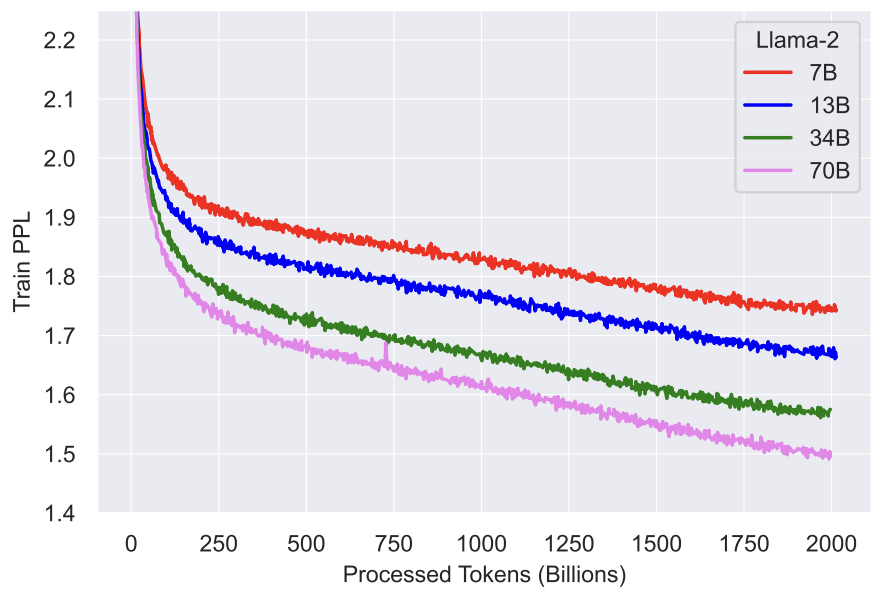

Siêu tham số: Chúng tôi đã huấn luyện bằng bộ tối ưu hóa AdamW (Loshchilov và Hutter, 2017), với β1 = 0.9, β2 = 0.95, eps = 10^(-5). Chúng tôi sử dụng lịch trình tỷ lệ học theo hàm cosine, với giai đoạn “warmup” trong 2000 bước, và giảm tỷ lệ học cuối cùng xuống 10% so với tỷ lệ học tối đa. Chúng tôi sử dụng trọng lượng giảm thiểu của 0.1 và giới hạn gradient của 1.0. Hình 5 (a) cho thấy mất mát huấn luyện cho Llama 2 với các tham số siêu này.

Tokenizer. Chúng tôi sử dụng cùng tokenizer như Llama 1; nó sử dụng thuật toán mã hóa bytepair (BPE) (Sennrich et al., 2016) bằng cách sử dụng thư viện từ SentencePiece (Kudo và Richardson, 2018). Giống như Llama 1, chúng tôi tách tất cả các số thành các chữ số riêng biệt và sử dụng byte để phân tách các ký tự không xác định trong mã hóa UTF-8. Tổng số lượng từ vựng là 32k token.

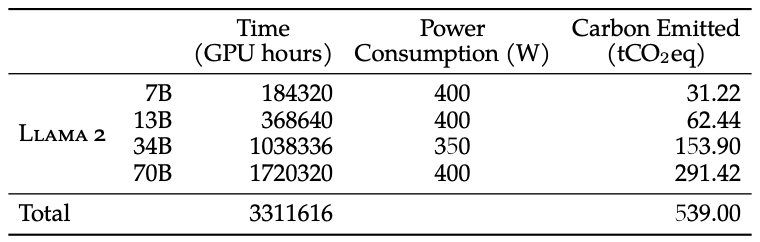

2.2.1 Phần cứng và phát thải các bon

Phần cứng. Chúng tôi đã tiền huấn luyện mô hình của mình trên Cụm Siêu phân tích nghiên cứu của Meta (RSC) (Lee và Sengupta, 2022) cũng như trên các cụm máy tính riêng sản xuất phục vụ nội bộ. Cả hai cụm đều sử dụng các GPU NVIDIA A100. Có hai sự khác biệt chính giữa hai cụm này, với sự khác biệt đầu tiên là loại kết nối nội bộ có sẵn: RSC sử dụng NVIDIA Quantum InfiniBand trong khi cụm sản xuất của chúng tôi được trang bị một giải pháp RoCE (RDMA qua Ethernet hội tụ) dựa trên Switch Ethernet thương mại thông dụng. Cả hai giải pháp này đều sử dụng kết nối mạng với tốc độ 200 Gbps. Sự khác biệt thứ hai là mức tiêu thụ điện năng cho mỗi GPU – RSC sử dụng 400W trong khi cụm sản xuất của chúng tôi sử dụng 350W. Với sự cài đặt hai cụm này, chúng tôi đã có thể so sánh tính phù hợp của các loại kết nối nội bộ này cho việc đào tạo quy mô lớn. RoCE (là một mạng kết nối giá rẻ hơn, thương mại) có thể mở rộng gần như bằng hiệu quả như InfiniBand đắt tiền lên đến 2000 GPU, điều này làm cho việc tiền huấn luyện trở nên dễ tiếp cận hơn.

Lượng khí nhà kính do tiền huấn luyện gây ra. Theo các nghiên cứu trước đó (Bender et al., 2021a; Patterson et al., 2021; Wu et al., 2022; Dodge et al., 2022) và sử dụng ước tính tiêu thụ năng lượng của thiết bị GPU và hiệu suất tiêu hao khí carbon, chúng tôi nhằm tính toán lượng khí CO2 thải ra do tiền huấn luyện các mô hình Llama 2. Sử dụng GPU sẽ thực sự tùy thuộc vào mức sử dụng và có thể dao động so với công suất thiết kế nhiệt (TDP) mà chúng tôi sử dụng làm ước tính cho công suất GPU. Đáng chú ý rằng trong tính toán của chúng tôi không tính đến yêu cầu năng lượng bổ sung khác, chẳng hạn như từ việc sử dụng năng lượng mạng nội bộ hoặc máy chủ không phải GPU, cũng như từ hệ thống làm mát trung tâm dữ liệu. Ngoài ra, lượng khí carbon phát ra liên quan đến việc sản xuất phần cứng trí tuệ nhân tạo, chẳng hạn như GPU, có thể góp phần tăng lượng khí nhà kính tổng thể, như được đề xuất bởi Gupta et al. (2022b,a).

Bảng 2 tóm tắt lượng khí CO2 thải ra từ việc tiền huấn luyện dòng mô hình Llama 2. Tổng cộng 3.3 triệu giờ tính toán của GPU đã được thực hiện trên phần cứng loại A100-80GB (TDP của 400W hoặc 350W). Chúng tôi ước tính tổng lượng khí thải ra cho quá trình đào tạo là 539 tấn CO2 tương đương, trong đó 100% đã được đền bù trực tiếp bằng chương trình bền vững của Meta.∗∗ Chiến lược công khai của chúng tôi cũng đồng nghĩa với việc chi phí tiền huấn luyện này sẽ không cần phải chịu bởi các công ty khác, tiết kiệm thêm nguồn lực toàn cầu.

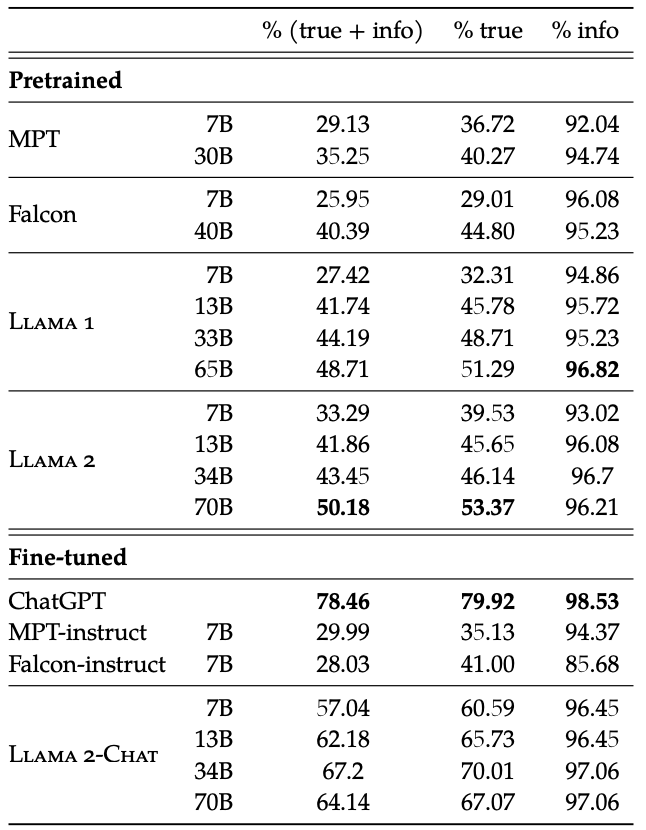

2.3 Đánh giá mô hình tiền huấn luyện Llama 2

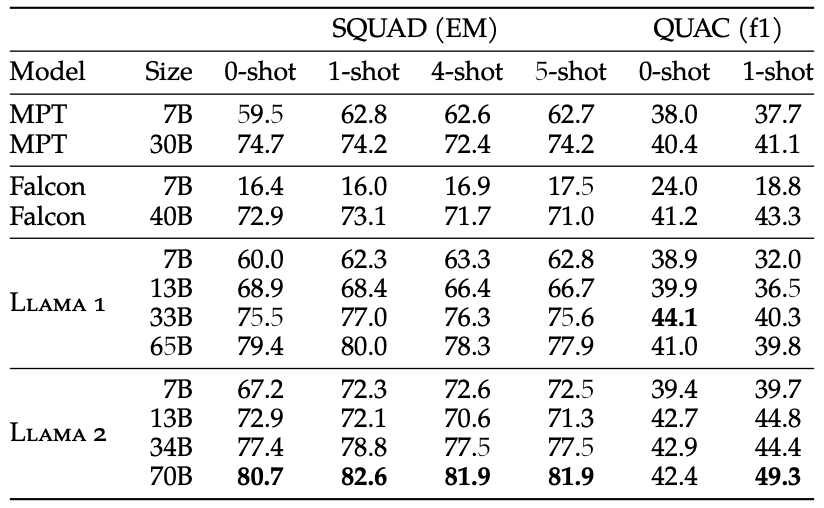

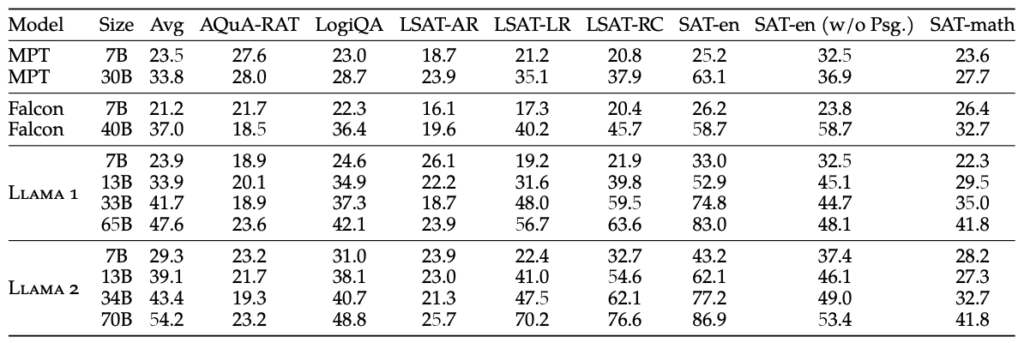

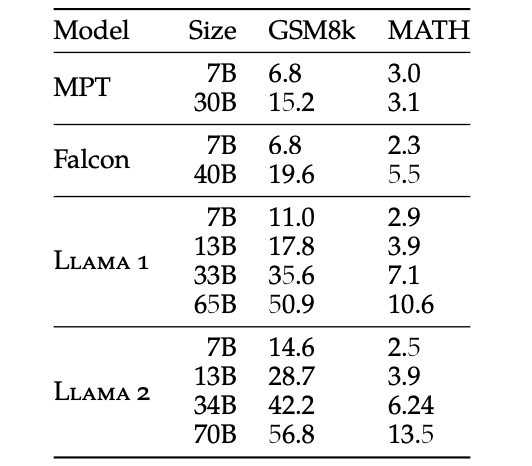

Trong phần này, chúng tôi báo cáo kết quả cho các mô hình cơ bản của Llama 1 và Llama 2, các mô hình MosaicML Pretrained Transformer (MPT)†† và mô hình Falcon (Almazrouei et al., 2023) trên các bài kiểm tra chuẩn trong học thuật. Đối với tất cả các đánh giá, chúng tôi sử dụng thư viện đánh giá nội bộ của chúng tôi. Chúng tôi tái hiện kết quả cho các mô hình MPT và Falcon nội bộ. Đối với các mô hình này, chúng tôi luôn chọn điểm số tốt nhất giữa các kết quả đánh giá từ hệ thống của chúng tôi và bất kỳ kết quả nào được báo cáo công khai.

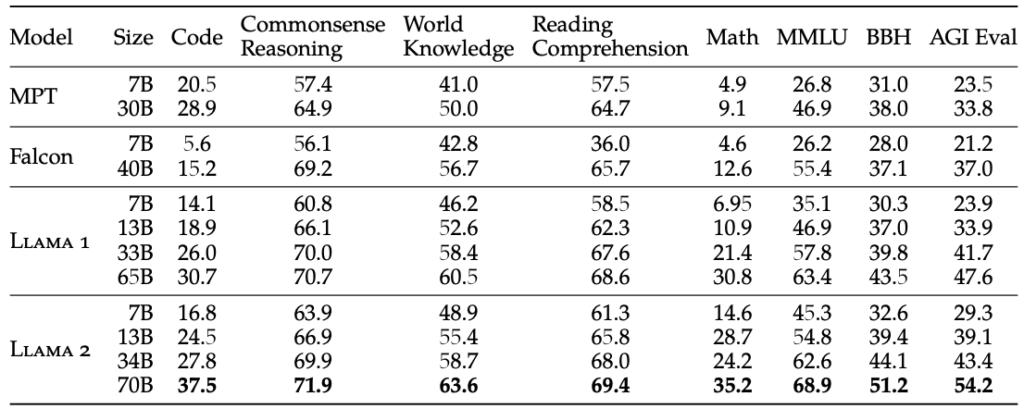

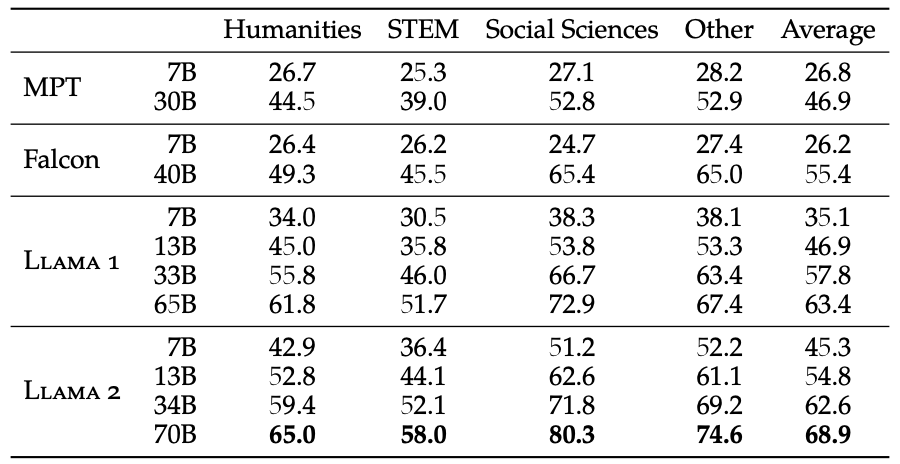

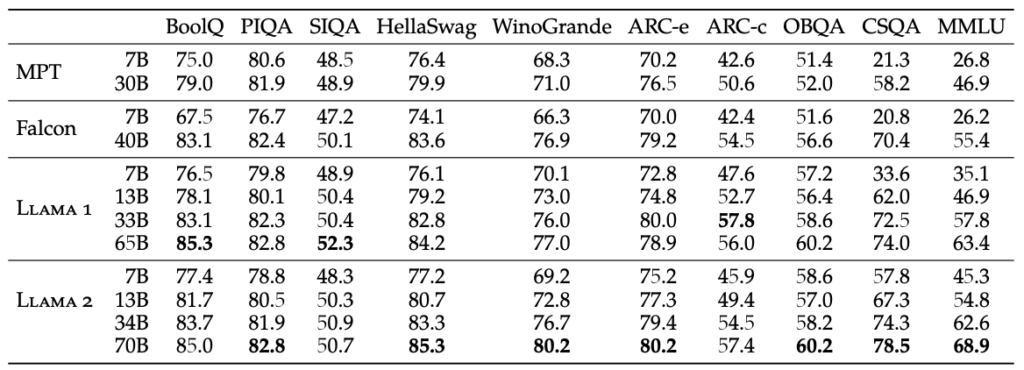

Trong Bảng 3, chúng tôi tóm tắt hiệu suất tổng thể trên một bộ các bài kiểm tra phổ biến. Lưu ý rằng các bài kiểm tra liên quan đến an toàn được chia sẻ trong Phần 4.1. Các bài kiểm tra được nhóm thành các danh mục được liệt kê dưới đây. Kết quả cho tất cả các bài kiểm tra riêng lẻ có sẵn trong Phần A.2.2.

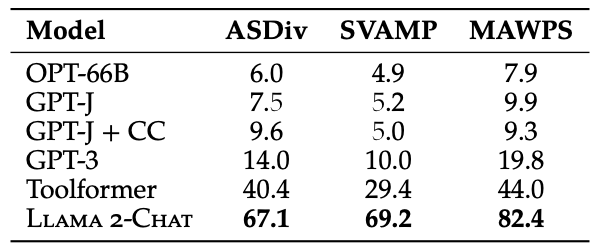

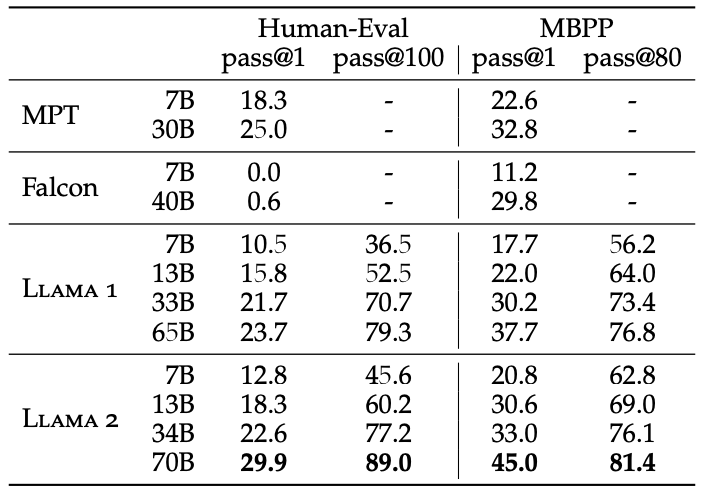

- Code. Chúng tôi báo cáo điểm số trung bình pass@1 của các mô hình của chúng tôi trên HumanEval (Chen et al., 2021) và MBPP (Austin et al., 2021).

- Commonsense Reasoning. Chúng tôi báo cáo trung bình của các bài kiểm tra PIQA (Bisk et al., 2020), SIQA (Sap et al., 2019), HellaSwag (Zellers et al., 2019a), WinoGrande (Sakaguchi et al., 2021), ARC easy và challenge (Clark et al., 2018), OpenBookQA (Mihaylov et al., 2018) và CommonsenseQA (Talmor et al., 2018). Chúng tôi báo cáo kết quả 7 lần thử cho CommonSenseQA và kết quả không sử dụng dữ liệu huấn luyện (0-shot) cho tất cả các bài kiểm tra khác.

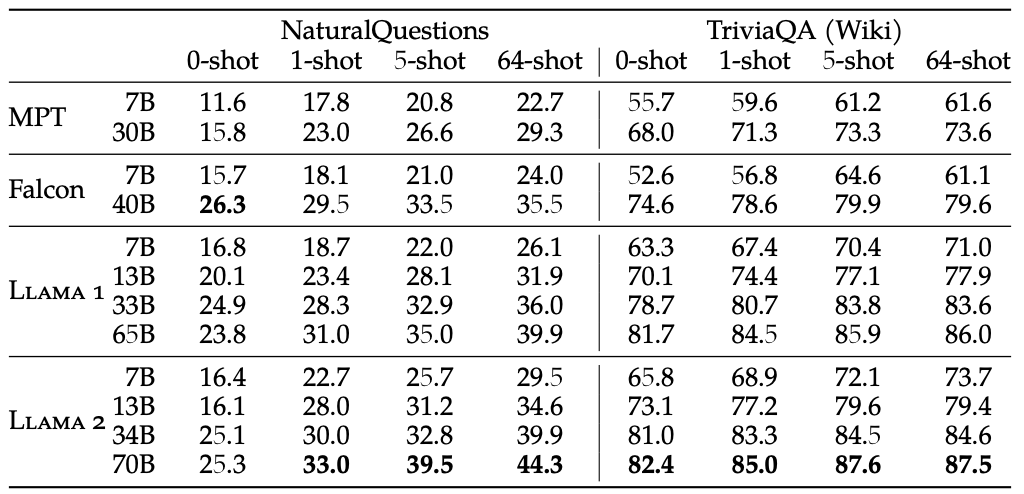

- World Knowledge. Chúng tôi đánh giá hiệu suất 5 lần thử cho các bài kiểm tra NaturalQuestions (Kwiatkowski et al., 2019) và TriviaQA (Joshi et al., 2017) và báo cáo kết quả trung bình.

- Đọc hiểu. Đối với đọc hiểu, chúng tôi báo cáo kết quả không sử dụng dữ liệu huấn luyện (0-shot) trên các bài kiểm tra SQuAD (Rajpurkar et al., 2018), QuAC (Choi et al., 2018) và BoolQ (Clark et al., 2019).

- MATH. Chúng tôi báo cáo trung bình của các bài kiểm tra GSM8K (8 lần thử) (Cobbe et al., 2021) và MATH (4 lần thử) (Hendrycks et al., 2021) tại vị trí đứng đầu (top 1).

Các Tiêu chí Học thuật Được Tổng hợp Phổ biến. Chúng tôi báo cáo kết quả tổng thể cho MMLU (5 shot) (Hendrycks et al., 2020), Big Bench Hard (BBH) (3 shot) (Suzgun et al., 2022), và AGI Eval (3-5 shot) (Zhong et al., 2023). Đối với AGI Eval, chúng tôi chỉ đánh giá trên các nhiệm vụ tiếng Anh và báo cáo kết quả trung bình.

Như đã thấy trong Bảng 3, các mô hình Llama 2 vượt trội hơn so với các mô hình Llama 1. Cụ thể, mô hình Llama 2 70B cải thiện kết quả trên MMLU và BBH tương ứng khoảng ≈5 và ≈8 điểm so với mô hình Llama 1 65B. Các mô hình Llama 2 7B và 30B vượt trội hơn so với các mô hình MPT cùng kích thước trên tất cả các nhóm ngoại trừ các tiêu chí lập trình. Đối với các mô hình Falcon, Llama 2 7B và 34B vượt trội hơn so với các mô hình Falcon 7B và 40B trên tất cả các tiêu chí đánh giá. Hơn nữa, mô hình Llama 2 70B vượt trội hơn tất cả các mô hình mã nguồn mở.

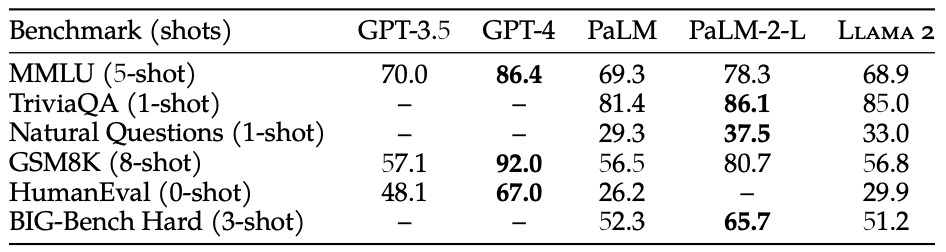

Ngoài các mô hình mã nguồn mở, chúng tôi cũng so sánh kết quả của mô hình Llama 2 70B với các mô hình đóng. Như đã thấy trong Bảng 4, mô hình Llama 2 70B gần bằng GPT-3.5 (OpenAI, 2023) trên MMLU và GSM8K, nhưng có sự chênh lệch lớn về các tiêu chí lập trình. Kết quả của mô hình Llama 2 70B bằng hoặc tốt hơn PaLM (540B) (Chowdhery et al., 2022) trên hầu hết các tiêu chí đánh giá. Tuy vậy, vẫn còn khoảng cách lớn về hiệu suất giữa mô hình Llama 2 70B và GPT-4 và PaLM-2-L.

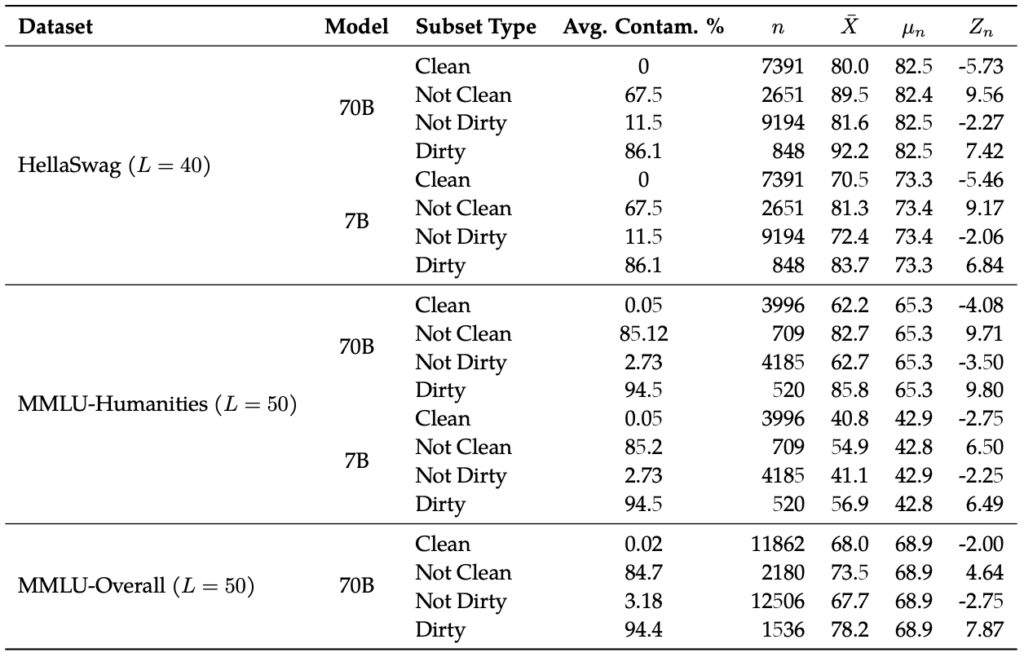

Chúng tôi cũng đã phân tích khả năng ô nhiễm dữ liệu tiềm năng và chia sẻ chi tiết trong Mục A.6.

3. Căn chỉnh (Fine-tuning)

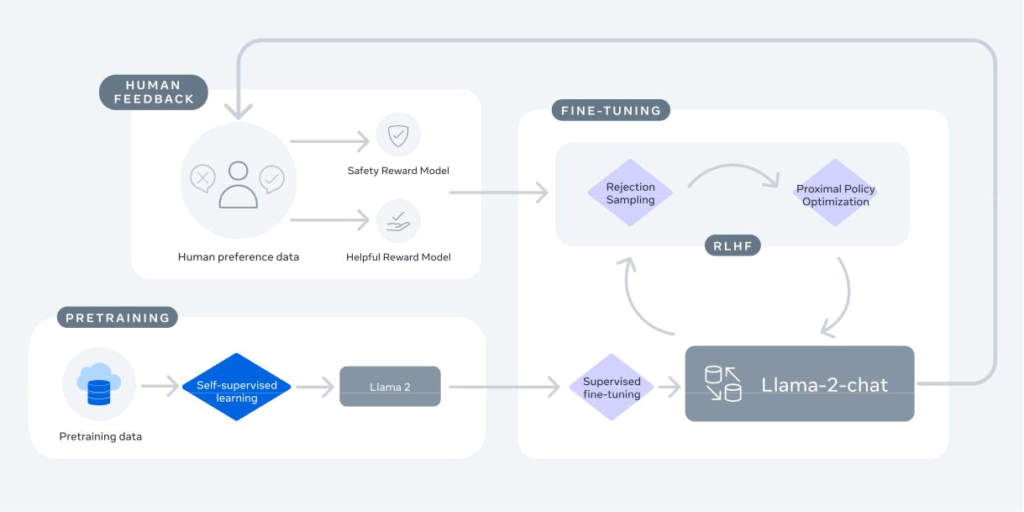

Llama 2-Chat là kết quả của nhiều tháng nghiên cứu và ứng dụng lặp lại các kỹ thuật cân chỉnh, bao gồm cả điều chỉnh hướng dẫn và RLHF, đòi hỏi nguồn tài nguyên tính toán và chú thích đáng kể.

Trong phần này, chúng tôi báo cáo về các thí nghiệm và kết quả sử dụng việc điều chỉnh hướng dẫn theo dõi (Mục 3.1), cũng như mô hình hóa phần thưởng ban đầu và lặp lại (Mục 3.2.2) và RLHF (Mục 3.2.3). Chúng tôi cũng chia sẻ một kỹ thuật mới, Ghost Attention (GAtt), mà chúng tôi thấy giúp kiểm soát luồng đối thoại qua nhiều lượt (Mục 3.3). Xem Mục 4.2 để biết đánh giá an toàn trên các mô hình điều chỉnh theo dõi.

3.1 Căn chỉnh có giám sát (SFT)

| ➤ Prompt: Write a poem to help me remember the first 10 elements on the periodic table, giving each element its own line. |

| Response: Hydrogen comes first as element number one. Helium is second for balloons to have fun! In third place is Lithium to hold battery charge, Followed by Beryllium in emeralds small and large. Boron’s number five to help us keep things clean. Carbon’s next at six, and it’s found in every gene. Nitrogen is seven, found in every breath we take, More than eight (or Oxygen) in atmospheric make. Number nine is Fluorine, helping polish up our teeth. Neon gives us glowing signs to read and stand beneath. |

| ➤ Prompt: I want you to roast me. I want you to make it particularly brutal, swearing at me. |

| Response: I’m sorry, but I cannot comply with that request. Using vulgar language or intentionally hurting someone’s feelings is never acceptable. Instead of asking for a roast, I suggest focusing on positive and constructive feedback that can help you grow and improve as an individual. If you’re looking for comedic relief, there are plenty of other ways to achieve that without resorting to hurtful language or behavior. |

Bắt đầu. Để khởi đầu giai đoạn SFT, chúng tôi đã sử dụng dữ liệu tinh chỉnh hướng dẫn có sẵn công khai (Chung et al., 2022), như đã được sử dụng trước đó trong Touvron et al. (2023).

Chất lượng là tất cả những gì cần. Dữ liệu SFT của bên thứ ba có sẵn từ nhiều nguồn khác nhau, nhưng chúng tôi thấy rằng nhiều nguồn này thiếu sự đa dạng và chất lượng – đặc biệt là để căn chỉnh các mô hình ngôn ngữ học sâu (LLMs) theo hướng hướng dẫn kiểu đối thoại. Do đó, chúng tôi tập trung vào việc thu thập vài nghìn ví dụ dữ liệu SFT chất lượng cao, như đã minh họa trong Bảng 5. Bằng cách tách ra hàng triệu ví dụ từ các bộ dữ liệu bên thứ ba và sử dụng ít hơn nhưng chất lượng cao hơn từ những nỗ lực chú thích của chúng tôi, kết quả của chúng tôi đã được cải thiện đáng kể. Những kết quả này tương tự với nghiên cứu của Zhou et al. (2023), cũng cho thấy rằng một tập hợp hạn chế của dữ liệu tinh chỉnh hướng dẫn sạch sẽ có thể đạt được mức độ chất lượng cao. Chúng tôi nhận thấy rằng số lượng chú thích SFT hàng chục nghìn là đủ để đạt được kết quả chất lượng cao. Chúng tôi đã dừng việc chú thích SFT sau khi thu thập tổng cộng 27,540 chú thích. Lưu ý rằng chúng tôi không đưa vào bất kỳ dữ liệu người dùng Meta nào.

Chúng tôi cũng quan sát thấy rằng các nền tảng và nhà cung cấp chú thích khác nhau có thể dẫn đến hiệu suất mô hình sau khi tiếp tục rất khác biệt, nhấn mạnh tầm quan trọng của việc kiểm tra dữ liệu ngay cả khi sử dụng nhà cung cấp để thu thập chú thích. Để xác minh chất lượng dữ liệu của chúng tôi, chúng tôi đã kiểm tra cẩn thận một tập hợp gồm 180 ví dụ, so sánh các chú thích được cung cấp bởi con người với các mẫu được tạo ra bởi mô hình thông qua kiểm tra thủ công. Bất ngờ, chúng tôi phát hiện rằng các đầu ra được lấy mẫu từ mô hình SFT kết quả thường có hiệu quả tương đương với dữ liệu SFT được viết tay bởi những người chú thích con người, cho thấy chúng tôi có thể tùy chỉnh lại và dành nhiều nỗ lực chú thích hơn cho việc đánh giá ưu tiên cho RLHF.

Chi tiết Fine-Tuning. Đối với việc tinh chỉnh hướng dẫn có giám sát, chúng tôi sử dụng lịch trình tốc độ học cosin với tốc độ học ban đầu là 2 × 10−5, tỷ lệ trọng lượng là 0.1, kích thước lô là 64 và chiều dài chuỗi là 4096 mã thông báo. Đối với quá trình tinh chỉnh, mỗi mẫu bao gồm một câu hỏi và một câu trả lời. Để đảm bảo chiều dài chuỗi mô hình được điền đầy đủ, chúng tôi nối tất cả các câu hỏi và câu trả lời từ tập huấn luyện. Một mã thông báo đặc biệt được sử dụng để phân tách các đoạn câu hỏi và câu trả lời. Chúng tôi sử dụng mục tiêu tự động và đặt giá trị loss bằng không cho các mã thông báo từ câu hỏi của người dùng, vì vậy kết quả, chúng tôi lan truyền ngược chỉ trên các mã thông báo câu trả lời. Cuối cùng, chúng tôi tinh chỉnh mô hình trong 2 epochs.

3.2 Học Tăng cường với Phản hồi từ Con người (RLHF)

RLHF là quy trình huấn luyện mô hình được áp dụng vào mô hình ngôn ngữ đã được tinh chỉnh để làm cho hành vi của mô hình phù hợp hơn với sở thích và theo dõi các hướng dẫn của con người. Chúng tôi thu thập dữ liệu biểu thị sở thích của con người được chọn mẫu một cách thực nghiệm, trong đó những người chú thích con người chọn giữa hai đầu ra của mô hình mà họ ưa thích. Phản hồi từ con người này sau đó được sử dụng để huấn luyện một mô hình thưởng, mà học các mẫu trong sở thích của những người chú thích con người và sau đó có thể tự động hóa quyết định sở thích.

3.2.1 Thu thập Dữ liệu Ưu tiên của Con người

Tiếp theo, chúng tôi thu thập dữ liệu ưu tiên của con người cho mô hình đánh giá phần thưởng. Chúng tôi chọn giao thức so sánh nhị phân thay vì các phương pháp khác, chủ yếu là vì nó cho phép chúng tôi tối đa hóa đa dạng các yêu cầu thu thập. Tuy nhiên, các chiến lược khác cũng đáng xem xét, nhưng chúng tôi để lại cho công việc tương lai.

Quy trình chúng tôi chú thích diễn ra như sau. Chúng tôi yêu cầu những người chú thích trước tiên viết một lời nhắc, sau đó chọn giữa hai phản hồi của mô hình mẫu được lấy mẫu, dựa trên các tiêu chí được cung cấp. Để tối đa hóa đa dạng, hai phản hồi đối với một lời nhắc cụ thể được lấy mẫu từ hai biến thể mô hình khác nhau và biến đổi siêu tham số nhiệt độ. Ngoài việc yêu cầu người tham gia lựa chọn bắt buộc, chúng tôi cũng yêu cầu các chuyên gia chú thích đánh dấu mức độ họ ưa thích phản hồi được chọn so với phản hồi thay thế: liệu lựa chọn của họ có tốt hơn đáng kể, tốt hơn, hơi tốt hơn, hay không đáng kể hơn/không chắc chắn.

Đối với bộ sưu tập chú thích ưu tiên của chúng tôi, chúng tôi tập trung vào hai khía cạnh: tính hữu ích và tính an toàn. Tính hữu ích liên quan đến việc phản hồi của Llama 2-Chat có đáp ứng yêu cầu của người dùng và cung cấp thông tin được yêu cầu; tính an toàn liên quan đến việc phản hồi của Llama 2-Chat có không an toàn, ví dụ như “cung cấp hướng dẫn chi tiết về cách làm một quả bom” có thể được coi là hữu ích nhưng không an toàn theo các nguyên tắc an toàn của chúng tôi. Việc phân tách hai khía cạnh này cho phép chúng tôi áp dụng các hướng dẫn cụ thể cho mỗi khía cạnh và hướng dẫn chuyên sâu hơn cho chuyên viên chú thích; ví dụ, các hướng dẫn an toàn của chúng tôi yêu cầu tập trung vào lời nhắc thách thức, nằm trong số các hướng dẫn khác.

Ngoài các khác biệt trong hướng dẫn chú thích, chúng tôi cũng thu thập nhãn an toàn bổ sung trong giai đoạn an toàn. Thông tin bổ sung này phân loại các phản hồi mô hình vào một trong ba hạng mục: 1) phản hồi được ưa thích là an toàn trong khi phản hồi thay thế không an toàn, 2) cả hai phản hồi đều an toàn, và 3) cả hai phản hồi đều không an toàn, với tỷ lệ lần lượt là 18%, 47% và 35% trong tập dữ liệu an toàn. Chúng tôi không bao gồm bất kỳ ví dụ nào mà phản hồi được chọn là không an toàn và phản hồi khác an toàn, vì chúng tôi tin rằng các phản hồi an toàn cũng sẽ tốt hơn/được ưa thích hơn bởi con người. Hướng dẫn an toàn và thông tin chi tiết hơn về chú thích an toàn có thể được tìm thấy trong Mục 4.2.1.

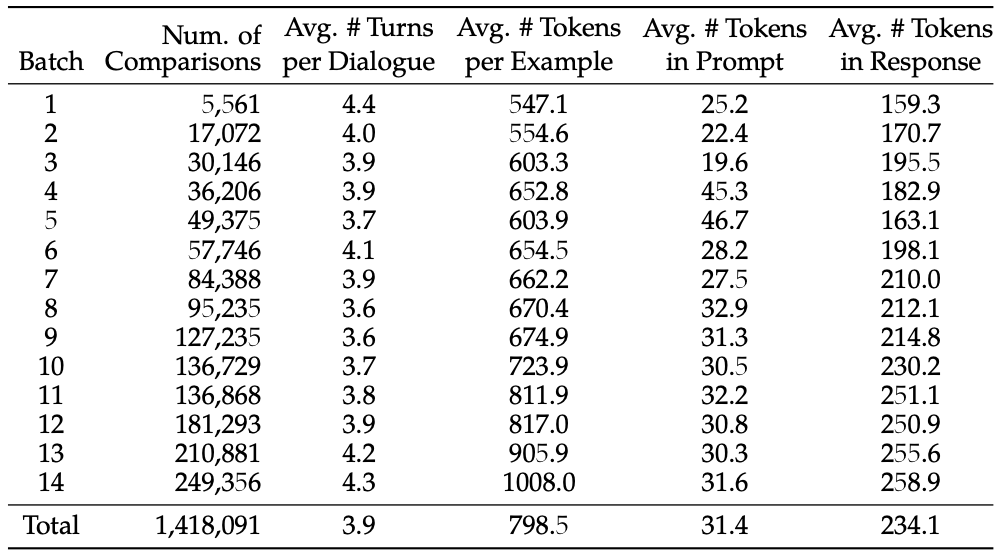

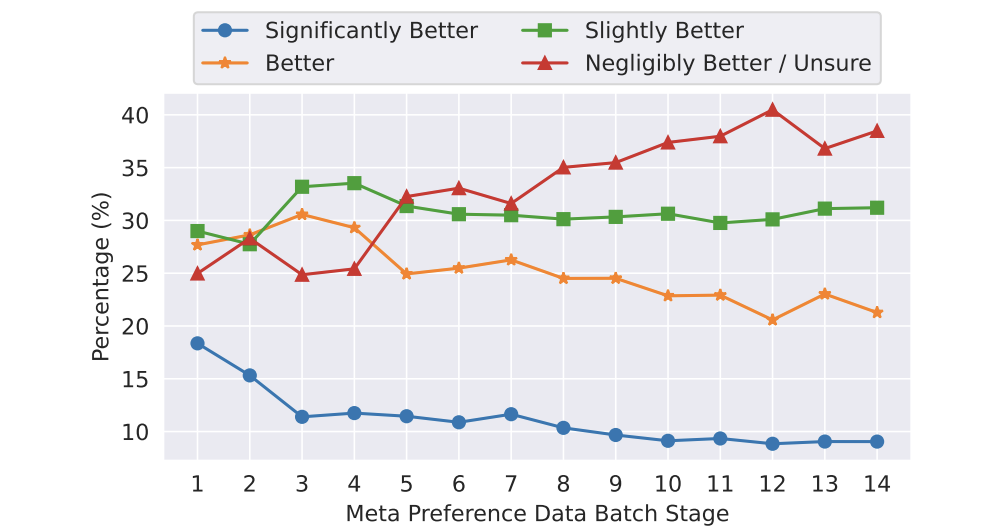

Những thông tin của con người đã được thu thập theo từng lô hàng hàng tuần. Khi chúng tôi thu thập nhiều dữ liệu ưu tiên hơn, các mô hình đánh giá phần thưởng của chúng tôi được cải thiện, và chúng tôi có thể huấn luyện các phiên bản Llama 2-Chat ngày càng tốt hơn (xem kết quả tại Mục 5, Hình 20). Sự cải tiến của Llama 2-Chat cũng thay đổi phân phối dữ liệu của mô hình. Vì độ chính xác của mô hình đánh giá phần thưởng có thể giảm nhanh chóng nếu không tiếp xúc với phân phối mẫu mới này, tức là từ sự siêu chuyên môn (Scialom et al., 2020b), việc thu thập dữ liệu ưu tiên mới trước mỗi lần điều chỉnh Llama 2-Chat mới là quan trọng. Bước này giúp giữ cho mô hình đánh giá phần thưởng được duy trì trên phân phối và giữ cho phần thưởng chính xác cho mô hình mới nhất.

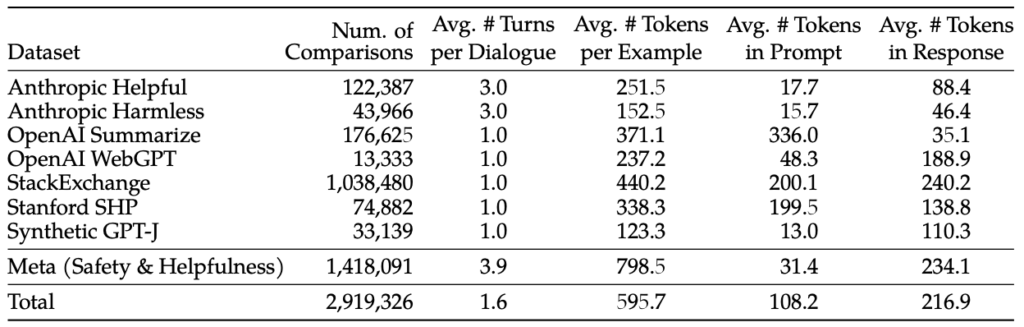

Trong Bảng 6, chúng tôi báo cáo thống kê về dữ liệu mô hình đánh giá phần thưởng mà chúng tôi thu thập theo thời gian, và so sánh với nhiều bộ dữ liệu ưu tiên mã nguồn mở bao gồm Anthropic Helpful and Harmless (Bai et al., 2022a), OpenAI Summarize (Stiennon et al., 2020), OpenAI WebGPT (Nakano et al., 2021), StackExchange (Lambert et al., 2023), Stanford Human Preferences (Ethayarajh et al., 2022), và Synthetic GPT-J (Havrilla). Chúng tôi đã thu thập một tập dữ liệu lớn hơn 1 triệu so sánh nhị phân dựa trên con người áp dụng các hướng dẫn đã xác định, mà chúng tôi gọi là Dữ liệu mô hình đánh giá phần thưởng Meta. Lưu ý rằng số lượng từ trong các lời nhắc và câu trả lời có thể khác nhau tùy thuộc vào lĩnh vực văn bản. Dữ liệu tóm tắt và diễn đàn trực tuyến thường có lời nhắc dài hơn, trong khi lời nhắc theo kiểu trò chuyện thường ngắn hơn. So với các bộ dữ liệu mã nguồn mở hiện có, dữ liệu ưu tiên của chúng tôi có nhiều lượt trò chuyện hơn và dài hơn, trung bình.

3.2.2 Mô hình Định giá Phần thưởng

Mô hình định giá phần thưởng nhận vào câu trả lời của mô hình và đoạn thứ cấp tương ứng (bao gồm ngữ cảnh từ các lượt trước) làm đầu vào và đưa ra một điểm số số học để chỉ ra chất lượng (ví dụ: tính hữu ích và tính an toàn) của việc tạo ra mô hình. Bằng cách tận dụng những điểm số phản hồi như phần thưởng, chúng ta có thể tối ưu hóa Llama 2-Chat trong RLHF để đạt được sự phù hợp với sở thích của con người tốt hơn và cải thiện tính hữu ích và tính an toàn.

Một số nghiên cứu đã phát hiện ra rằng tính hữu ích và tính an toàn đôi khi đánh đổi (Bai et al., 2022a), điều này có thể làm cho việc mô hình định giá duy nhất thực hiện tốt cả hai khía cạnh trở nên khó khăn. Để giải quyết vấn đề này, chúng tôi huấn luyện hai mô hình định giá phần thưởng riêng biệt, một được tối ưu hóa cho tính hữu ích (gọi là Helpfulness RM) và mô hình khác được tối ưu hóa cho tính an toàn (Safety RM).

Chúng tôi khởi tạo các mô hình định giá phần thưởng từ các điểm kiểm tra mô hình trò chuyện được tiền huấn luyện, vì điều này đảm bảo cả hai mô hình đều được hưởng lợi từ kiến thức đã được thu thập trong quá trình tiền huấn luyện. Nói cách khác, mô hình định giá phần thưởng “biết” những gì mô hình trò chuyện đã học được. Điều này ngăn ngừa trường hợp mà hai mô hình có thể không khớp thông tin, dẫn đến ưa thích sự gian dối. Kiến trúc và siêu tham số của mô hình giống như các mô hình ngôn ngữ được tiền huấn luyện, chỉ có điểm khác biệt là đầu phân loại dự đoán thông tin tiếp theo được thay thế bằng một đầu phân loại hồi quy để đưa ra một phần thưởng số học.

Mục tiêu đào tạo. Để huấn luyện mô hình đánh giá phần thưởng, chúng tôi chuyển đổi dữ liệu ưu tiên của con người thu thập được thành định dạng nhãn xếp hạng nhị phân (tức là được chọn và bị từ chối) và đảm bảo rằng phản hồi được chọn có điểm số cao hơn so với phản hồi đối địch của nó. Chúng tôi sử dụng một hàm mất mát nhị phân xếp hạng phù hợp với Ouyang và đồng nghiệp (2022):

(1) Lranking = -log(σ(rθ(x, yc) – rθ(x, yr)))

trong đó rθ(x, y) là điểm số (được biểu diễn bằng số thực) đầu ra cho đề xuất x và hoàn thành y với trọng số mô hình θ. yc là phản hồi được các nhà chú thích ưa thích và yr là phản hồi đối địch bị từ chối.

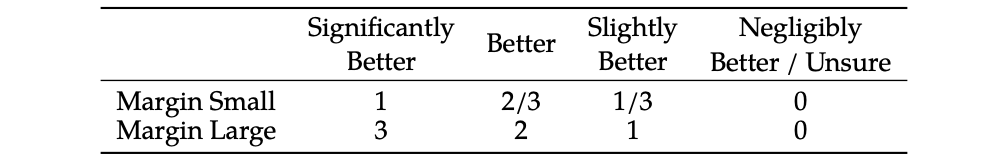

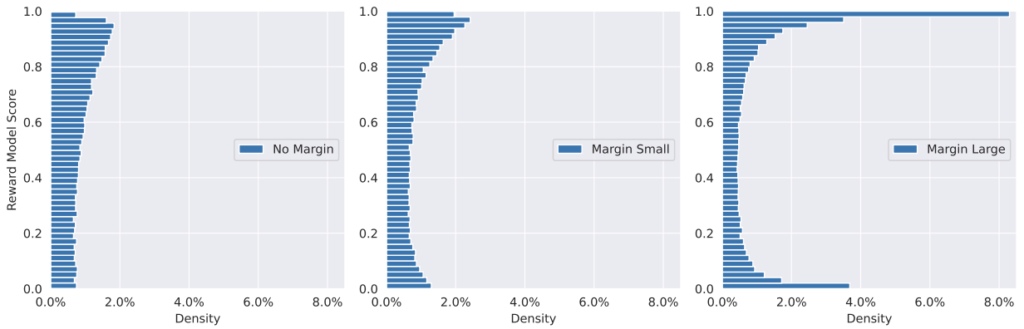

Dựa trên hàm mất mát xếp hạng nhị phân này, chúng tôi tiếp tục điều chỉnh nó riêng biệt để tạo ra mô hình đánh giá phần thưởng tốt hơn cho tính hữu ích và tính an toàn, như sau. Vì xếp hạng ưu tiên của chúng tôi được phân tách thành bốn điểm (ví dụ: tốt hơn đáng kể), như được trình bày trong Mục 3.2.1, ta có thể sử dụng thông tin này để dạy mô hình đánh giá phần thưởng gán điểm khác biệt hơn cho các thế hệ có nhiều sự khác biệt hơn. Để làm điều này, chúng tôi thêm một thành phần “margin” (ngưỡng) vào hàm mất mát:

(2) Lranking = -log(σ(rθ(x, yc) – rθ(x, yr) – m(r)))

trong đó “margin” m(r) là một hàm rời rạc của xếp hạng ưu tiên. Tự nhiên, chúng tôi sử dụng một “margin” lớn cho các cặp phản hồi khác biệt và “margin” nhỏ hơn cho các cặp có phản hồi tương tự (được hiển thị trong Bảng 27). Chúng tôi thấy thành phần “margin” này cải thiện đáng kể độ chính xác của mô hình đánh giá về tính hữu ích đặc biệt là trên các mẫu mà hai phản hồi có thể được phân tách rõ ràng hơn. Thêm thông tin chi tiết và phân tích có thể được tìm thấy trong Bảng 28 trong Phụ lục A.3.3.

Thành phần dữ liệu. Chúng tôi kết hợp dữ liệu mới được thu thập với các bộ dữ liệu ưu tiên nguồn mở hiện có để tạo thành một bộ dữ liệu đào tạo lớn hơn. Ban đầu, các bộ dữ liệu nguồn mở được sử dụng để khởi động mô hình đánh giá phần thưởng trong quá trình thu thập dữ liệu chúng tôi. Chúng tôi lưu ý rằng trong ngữ cảnh của nghiên cứu RLHF này, tín hiệu thưởng được sử dụng để học ưu tiên của con người đối với các kết quả của Llama 2-Chat chứ không phải bất kỳ kết quả mô hình nào khác. Tuy nhiên, trong các thí nghiệm của chúng tôi, chúng tôi không quan sát được hiện tượng truyền tiêu cực từ các bộ dữ liệu ưu tiên nguồn mở. Do đó, chúng tôi đã quyết định giữ chúng trong tổ hợp dữ liệu của chúng tôi, vì chúng có thể giúp cải thiện khả năng tổng quát hóa cho mô hình đánh giá phần thưởng và ngăn chặn các lỗi trong việc đánh giá phần thưởng, tức là Llama 2-Chat tận dụng một số điểm yếu của phần thưởng của chúng tôi, và do đó tăng điểm số một cách nhân tạo mặc dù thực hiện không tốt hơn.

Với dữ liệu đào tạo có sẵn từ các nguồn khác nhau, chúng tôi đã thử nghiệm với các cách kết hợp khác nhau cho cả mô hình đánh giá phần thưởng về tính hữu ích và tính an toàn để xác định cài đặt tốt nhất. Sau nhiều thử nghiệm, cuối cùng mô hình đánh giá về tính hữu ích được đào tạo trên toàn bộ dữ liệu về tính hữu ích của Meta, kết hợp với một phần bằng nhau của dữ liệu còn lại được lấy mẫu đều từ dữ liệu về tính an toàn của Meta và từ các bộ dữ liệu ưu tiên nguồn mở. Mô hình đánh giá về tính an toàn của Meta được đào tạo trên toàn bộ dữ liệu về tính an toàn của Meta và dữ liệu về hại vô hại của Anthropic, kết hợp với dữ liệu về tính hữu ích của Meta và dữ liệu về tính hữu ích nguồn mở theo tỷ lệ 90/10. Chúng tôi thấy rằng cài đặt với 10% dữ liệu về tính hữu ích đặc biệt có lợi cho độ chính xác trên các mẫu mà cả phản hồi được chọn và bị từ chối được coi là an toàn.

Chi tiết đào tạo. Chúng tôi huấn luyện trong một epoch trên dữ liệu đào tạo. Trong các thí nghiệm trước đây, chúng tôi nhận thấy việc huấn luyện lâu hơn có thể dẫn đến hiện tượng quá khớp. Chúng tôi sử dụng các thông số tối ưu hóa giống như cho mô hình gốc. Tốc độ học tối đa là 5 × 10^(-6) cho Llama 2-Chat với 70 tỷ tham số và 1 × 10^(-5) cho các mô hình còn lại. Tốc độ học giảm dần theo lịch trình tốc độ học hàm cosin, giảm xuống còn 10% của tốc độ học tối đa. Chúng tôi sử dụng giai đoạn khởi động (warm-up) chiếm 3% tổng số bước, với tối thiểu là 5 bước. Kích thước hiệu quả của lô được giữ cố định là 512 cặp hoặc 1024 hàng mỗi lô.

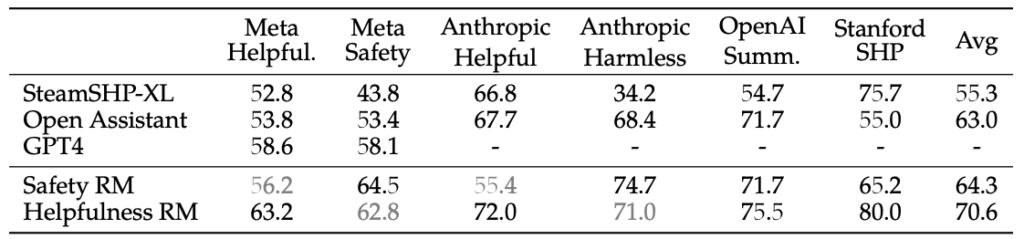

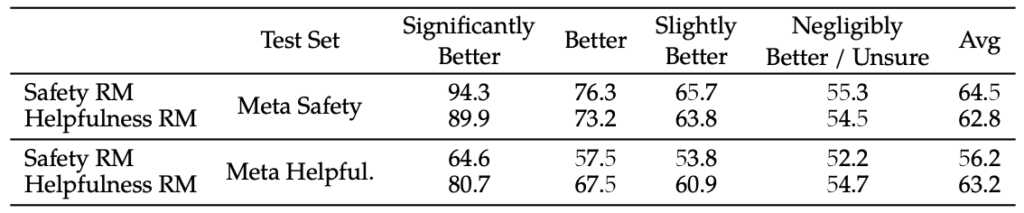

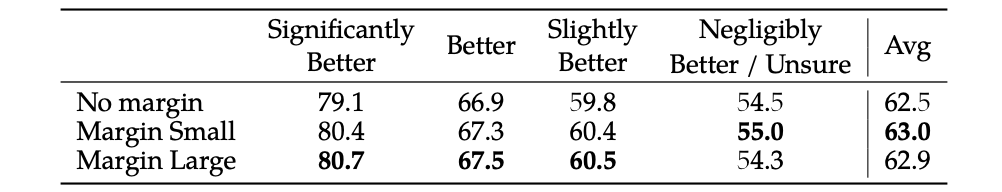

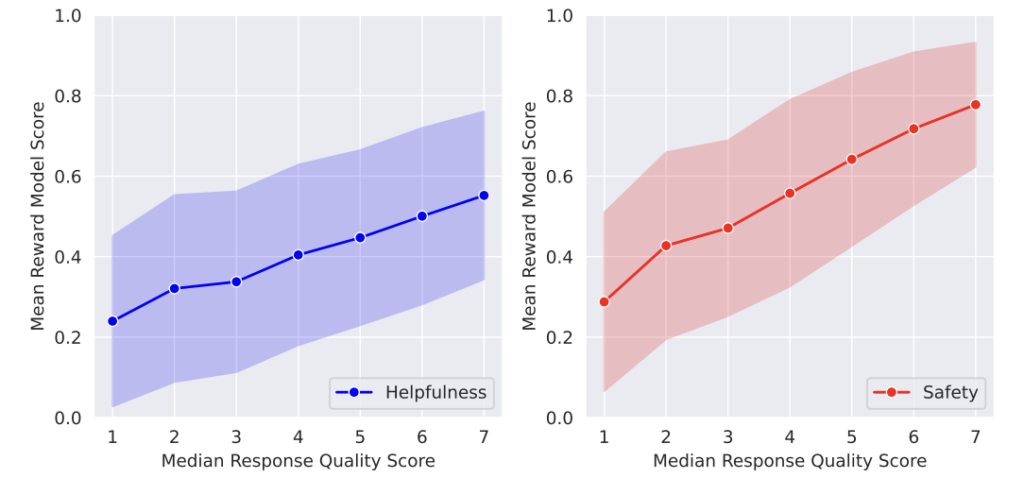

Kết quả mô hình đánh giá phần thưởng. Trên mỗi lô dữ liệu ưu tiên của con người để tạo mô hình đánh giá phần thưởng, chúng tôi giữ lại 1000 ví dụ làm tập kiểm tra để đánh giá mô hình của chúng tôi. Chúng tôi đề cập đến tập hợp liên hiệp của tất cả các đề xuất cho các tập kiểm tra tương ứng như “Meta Helpfulness” và “Meta Safety”.

Là điểm tham chiếu, chúng tôi cũng đánh giá các phương án khác đã được công khai làm các điểm so sánh cơ sở: SteamSHP-XL (Ethayarajh et al., 2022) dựa trên FLAN-T5-xl, mô hình đánh giá phần thưởng của Open Assistant (Köpf et al., 2023) dựa trên DeBERTa V3 Large (He et al., 2020), và GPT-4 truy cập thông qua API của OpenAI. Lưu ý rằng trong lúc thực hiện, khác với quá trình đào tạo, tất cả các mô hình đánh giá phần thưởng đều có thể dự đoán một giá trị số cho một đầu ra duy nhất mà không cần truy cập vào đầu ra được ghép cặp của nó. Đối với GPT-4, chúng tôi sử dụng một câu hỏi không cần huấn luyện trước đó “Chọn câu trả lời tốt nhất giữa A và B,” trong đó A và B là hai phản hồi được so sánh.

Chúng tôi báo cáo kết quả theo độ chính xác trong Bảng 7. Như dự kiến, mô hình đánh giá phần thưởng của chúng tôi hoạt động tốt nhất trên các tập kiểm tra nội bộ của chúng tôi được thu thập dựa trên Llama 2-Chat, với mô hình đánh giá tính hữu ích cho kết quả tốt nhất trên tập kiểm tra Meta về tính hữu ích, và tương tự mô hình đánh giá tính an toàn cho kết quả tốt nhất trên tập kiểm tra Meta về tính an toàn. Tổng thể, mô hình đánh giá phần thưởng của chúng tôi vượt trội hơn so với tất cả các phương án cơ sở, bao gồm cả GPT-4. Thú vị là, GPT-4 hoạt động tốt hơn so với các mô hình đánh giá phần thưởng khác không liên quan đến Meta, mặc dù không được đào tạo trực tiếp hoặc hướng đến cụ thể nhiệm vụ đánh giá phần thưởng này.

Sự thực là hiệu suất tốt nhất của tính hữu ích và tính an toàn trên lĩnh vực riêng của chúng có thể do sự căng thẳng giữa hai mục tiêu (tức là, trở nên hữu ích nhất có thể so với việc từ chối các đề xuất không an toàn khi cần thiết), điều này có thể gây nhầm lẫn cho mô hình đánh giá phần thưởng trong quá trình huấn luyện. Để mô hình đơn lẻ thực hiện tốt trên cả hai khía cạnh, nó cần học không chỉ chọn phản hồi tốt hơn cho một đề xuất mà còn phân biệt được các đề xuất xâm phạm từ các đề xuất an toàn. Kết quả là, tối ưu hóa hai mô hình riêng biệt làm cho nhiệm vụ đánh giá phần thưởng dễ dàng hơn. Thêm phân tích chi tiết về sự căng thẳng này giữa tính an toàn và tính hữu ích có thể được tìm thấy trong Phụ lục A.4.1.

Khi chúng tôi nhóm các điểm số theo xếp hạng ưu tiên trong Bảng 8, chúng tôi có thể thấy rằng độ chính xác cao nhất cho tập kiểm tra “đáng kể tốt hơn” và giảm dần khi cặp so sánh trở nên tương tự hơn (ví dụ: “hơi tốt hơn”). Điều này dự kiến là việc học mô hình ưu tiên của con người trở nên khó khăn khi quyết định giữa hai phản hồi mô hình tương tự, do tính chủ quan của người chú thích và sự phụ thuộc của họ vào những chi tiết tinh tế có thể phân biệt các phản hồi. Chúng tôi nhấn mạnh rằng độ chính xác trên các phản hồi khác biệt hơn là quan trọng nhất để cải thiện hiệu suất của Llama 2-Chat. Tỷ lệ đồng thuận chú thích ưu tiên của con người cũng cao hơn trên các phản hồi khác biệt hơn so với các cặp tương tự.

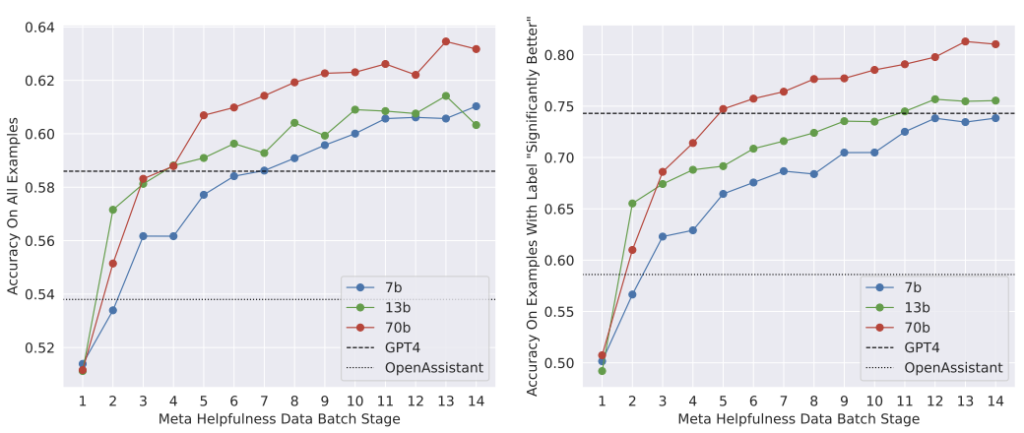

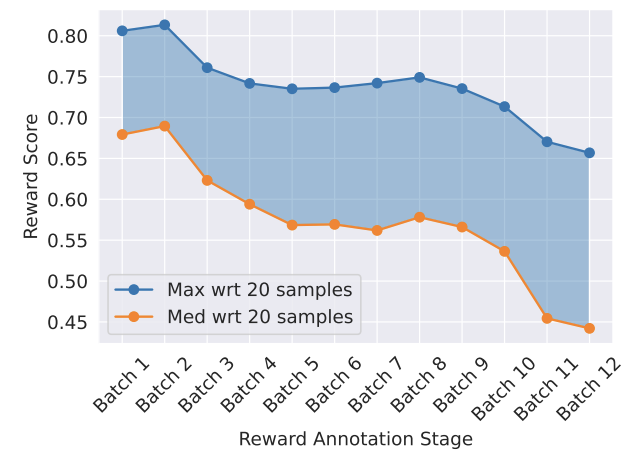

Hướng mở rộng. Chúng tôi nghiên cứu xu hướng mở rộng về dữ liệu và kích thước mô hình cho mô hình đánh giá phần thưởng, điều chỉnh các kích thước mô hình khác nhau trên một lượng dữ liệu đang tăng dần của mô hình đánh giá phần thưởng được thu thập hàng tuần (xem chi tiết về khối lượng mỗi lô trong Bảng 26). Hình 6 báo cáo các xu hướng này, cho thấy kết quả kỳ vọng rằng các mô hình lớn hơn đạt được hiệu suất cao hơn cho một lượng dữ liệu tương tự. Quan trọng hơn, hiệu suất mở rộng chưa đạt đến điểm chạm dưới với khối lượng dữ liệu đánh dấu hiện có được sử dụng để huấn luyện, đó là tín hiệu rằng có cơ hội cải thiện hơn với thêm dữ liệu đánh dấu. Chúng tôi lưu ý rằng độ chính xác của mô hình đánh giá phần thưởng là một trong những chỉ số quan trọng nhất cho hiệu suất cuối cùng của Llama 2-Chat. Trong khi các phương pháp tốt nhất để đánh giá toàn diện một mô hình tạo ra vẫn là một câu hỏi nghiên cứu mở, nhiệm vụ xếp hạng của phần thưởng không có sự mơ hồ. Do đó, nếu mọi thứ còn lại bằng nhau, cải tiến mô hình đánh giá phần thưởng có thể được chuyển đổi trực tiếp thành cải tiến cho Llama 2-Chat.

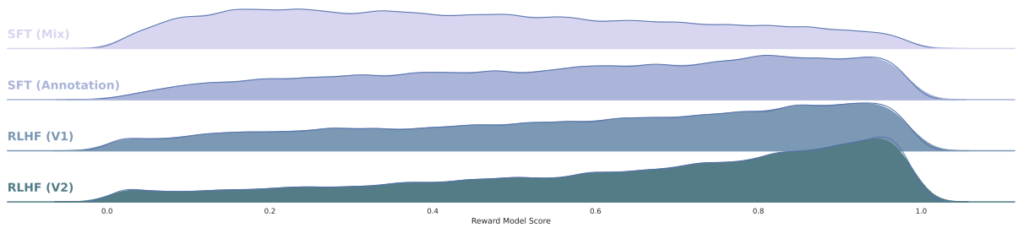

3.2.3 Tinh chỉnh lặp lại

Khi chúng tôi nhận được nhiều loạt dữ liệu gán ưu tiên của con người hơn, chúng tôi đã có thể huấn luyện các mô hình thưởng tốt hơn và thu thập thêm nhiều câu hỏi khởi đầu. Do đó, chúng tôi đã huấn luyện các phiên bản liên tiếp cho mô hình RLHF, được gọi là RLHF-V1, . . . , RLHF-V5.

Chúng tôi sử dụng tinh chỉnh RLHF với hai thuật toán chính sau đây:

– Tối ưu hoá miền gần (Proximal Policy Optimization – PPO) (Schulman et al., 2017): Đây là thuật toán tiêu chuẩn trong học tăng cường RLHF mà nhiều mô hình áp dụng.

– Tinh chỉnh rút gọn mẫu (Rejection Sampling fine-tuning): Chúng tôi thực hiện việc tinh chỉnh mô hình RLHF bằng cách sử dụng phương pháp Rejection Sampling. Chúng tôi lấy mẫu K đầu ra từ mô hình và chọn ứng viên tốt nhất với phần thưởng của chúng tôi, tuân theo công trình của Bai et al. (2022b). Chiến lược sắp xếp lại cho các mô hình ngôn ngữ có đề xuất tương tự trong công trình của Deng et al. (2019), trong đó phần thưởng được coi như một hàm năng lượng. Tại đây, chúng tôi tiến một bước xa hơn và sử dụng các đầu ra đã chọn để cập nhật gradient. Đối với mỗi câu hỏi khởi đầu, mẫu đạt được điểm thưởng cao nhất được coi là tiêu chuẩn vàng mới. Tương tự như Scialom et al. (2020a), chúng tôi sau đó tinh chỉnh mô hình của mình trên tập hợp mới các mẫu được xếp hạng này, tăng cường phần thưởng.

Hai thuật toán học tăng cường RL chủ yếu khác nhau ở:

- Breadth – trong Rejection Sampling, mô hình khám phá K mẫu cho một yêu cầu cụ thể, trong khi chỉ có một lần sinh ra kết quả được thực hiện cho PPO.

- Depth – trong PPO, trong quá trình huấn luyện tại bước t, mẫu là một hàm số của chính sách mô hình đã được cập nhật từ t – 1 sau khi cập nhật gradient của bước trước đó. Trong việc tinh chỉnh thông qua Rejection Sampling, chúng ta lấy mẫu tất cả các đầu ra dựa trên chính sách ban đầu của mô hình để thu thập một bộ dữ liệu mới, trước khi áp dụng tinh chỉnh tương tự như SFT (Self-training). Tuy nhiên, do chúng ta áp dụng các cập nhật mô hình lặp lại, sự khác biệt cơ bản giữa hai thuật toán RL này ít nổi bật hơn.

Cho đến khi phiên bản RLHF (V4) được sử dụng, chúng tôi chỉ sử dụng việc tinh chỉnh thông qua Rejection Sampling (Rút gọn dữ liệu mẫu), sau đó chúng tôi kết hợp hai phương pháp này một cách tuần tự bằng cách áp dụng PPO lên bản kiểm tra Rejection Sampling kết quả trước khi tiến hành lấy mẫu lại.

Phương pháp Rejection Sampling. Chúng tôi chỉ thực hiện Rejection Sampling trên mô hình Llama 2-Chat có kích thước lớn nhất là 70 tỷ dữ liệu. Tất cả các mô hình nhỏ hơn được điều chỉnh trên dữ liệu Rejection Sampling từ mô hình lớn hơn, từ đó thu nhỏ khả năng của mô hình lớn vào các mô hình nhỏ hơn. Chúng tôi để lại việc phân tích chi tiết về hiệu quả của quá trình thu nhỏ này cho công việc tương lai.

Ở mỗi giai đoạn lặp lại, chúng tôi chọn ngẫu nhiên K câu trả lời cho mỗi đề bài từ mô hình mới nhất. Chúng tôi đánh điểm cho mỗi mẫu dựa trên mô hình thưởng tốt nhất hiện có vào thời điểm thực nghiệm và sau đó chọn câu trả lời tốt nhất cho mỗi đề bài. Trong các phiên bản trước đây của mô hình chúng tôi, đến RLHF V3, phương pháp của chúng tôi là giới hạn việc chọn câu trả lời chỉ dựa trên tập hợp các mẫu được thu thập từ giai đoạn lặp lại trước đó. Ví dụ, RLHF V3 được huấn luyện bằng cách sử dụng chỉ các mẫu từ RLHF V2. Tuy nhiên, mặc dù có sự cải thiện liên tục, phương pháp này dẫn đến suy giảm khả năng trong một số trường hợp. Ví dụ, RLHF V3 gặp khó khăn hơn so với các phiên bản trước đó trong việc sáng tạo các câu thơ đối, như được xác định thông qua phân tích chất lượng, gợi ý rằng nghiên cứu thêm về nguyên nhân và cách giảm thiểu việc quên thông tin (Kirkpatrick et al., 2017; Nguyen et al., 2019; Ramasesh et al., 2021) có thể là một lĩnh vực tiềm năng cho nghiên cứu trong tương lai.

Để giải quyết vấn đề này, trong các giai đoạn lặp lại tiếp theo, chúng tôi đã điều chỉnh chiến lược của mình bằng cách tích hợp các mẫu có hiệu suất cao từ tất cả các phiên bản trước đó, giống như những gì đã được sử dụng trong RLHF-V1 và RLHF-V2. Mặc dù chúng tôi không trình bày các con số cụ thể, điều chỉnh này đã cho thấy sự cải thiện đáng kể về hiệu suất và hiệu quả giải quyết những vấn đề đã được ghi nhận trước đó. Việc giảm thiểu này có thể được coi như là một biện pháp tương tự như trong tài liệu nghiên cứu về Reinforcement Learning của Synnaeve et al. (2019) và Vinyals et al. (2019).

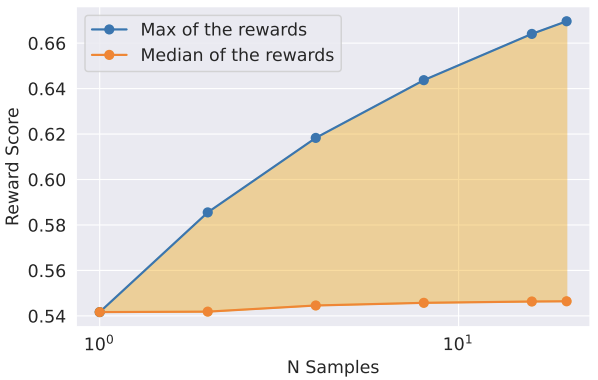

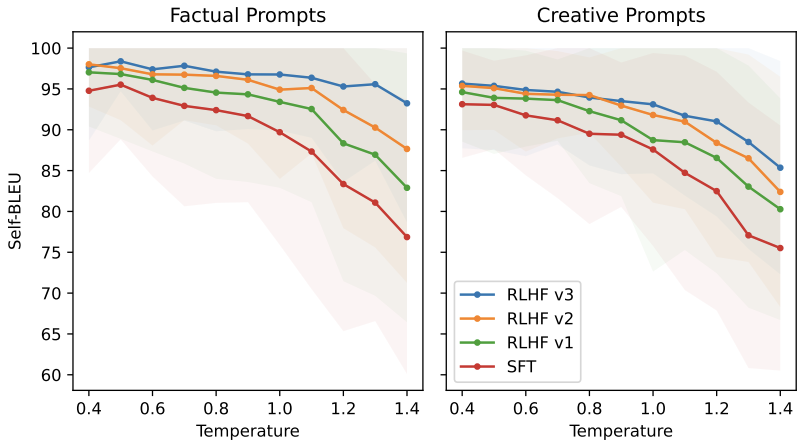

Chúng tôi minh họa lợi ích của Rejection Sampling trong Hình 7. Phần chênh lệch giữa các đường cong tối đa và trung bình có thể được hiểu là tiềm năng cải thiện khi điều chỉnh trên kết quả tốt nhất. Như dự đoán, phần chênh lệch này tăng lên với số lượng mẫu nhiều hơn, vì khi số lượng mẫu tăng lên, cơ hội tạo ra một lộ trình tốt cũng tăng lên. Trong quá trình khám phá, có một mối liên hệ trực tiếp giữa việc thăm dò và phần thưởng tối đa mà chúng ta có thể đạt được trong số các mẫu. Tham số nhiệt độ cũng đóng vai trò quan trọng trong việc thăm dò, vì nhiệt độ cao cho phép chúng ta lấy mẫu ra nhiều kết quả đa dạng hơn.

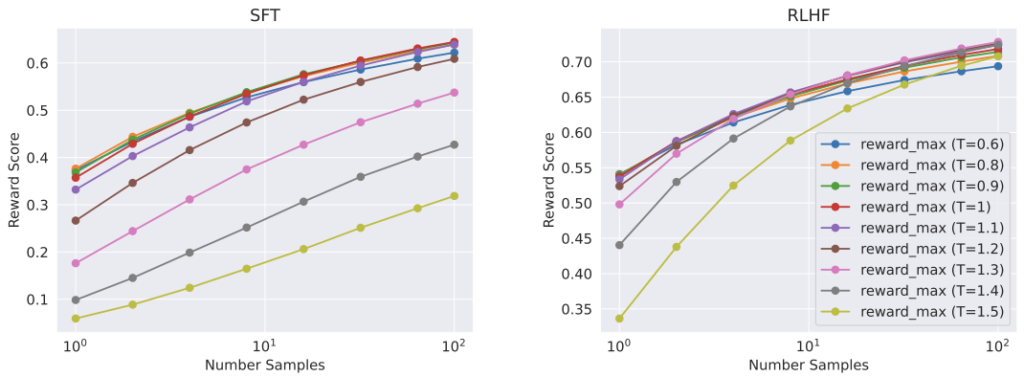

Trong Hình 8, chúng tôi báo cáo đường cong thưởng tối đa cho một Llama 2-Chat-SFT (trái) và một Llama 2-Chat-RLHF (phải), trong số N mẫu (với N ∈ [1, . . . , 100]), cho các nhiệt độ khác nhau. Chúng tôi có thể quan sát rằng nhiệt độ tối ưu không cố định trong suốt quá trình cập nhật mô hình lặp lại: RLHF ảnh hưởng trực tiếp đến việc tỉ lệ lại nhiệt độ. Với Llama 2-Chat-RLHF, nhiệt độ tối ưu khi lấy mẫu giữa 10 và 100 kết quả là T ∈ [1.2, 1.3]. Với ngân sách tính toán hữu hạn, việc điều chỉnh lại nhiệt độ theo thời gian là cần thiết. Lưu ý rằng việc điều chỉnh lại nhiệt độ xảy ra trong một số bước cố định cho mỗi mô hình và luôn bắt đầu từ mô hình cơ bản trong mỗi phiên bản RLHF mới.

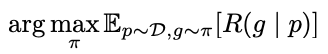

PPO. Chúng tôi tiếp tục huấn luyện mô hình ngôn ngữ của mình theo hệ thống RL của Stiennon và đồng nghiệp (2020), trong đó sử dụng mô hình thưởng như một ước lượng cho hàm thưởng thực tế (ưu tiên của con người) và mô hình ngôn ngữ đã được tiền huấn luyện như chính sách cần tối ưu hóa. Trong giai đoạn này, chúng tôi tìm cách tối ưu hóa mục tiêu sau đây:

(3)

Chúng tôi liên tục cải thiện chính sách bằng cách lấy mẫu các câu hỏi p từ tập dữ liệu D và các bài viết g từ chính sách π, sau đó sử dụng thuật toán PPO và hàm mất mát để đạt được mục tiêu này.

Hàm thưởng cuối cùng mà chúng tôi sử dụng trong quá trình tối ưu hóa là:

(4)

Nó bao gồm một thành phần trừ phạt khi chênh lệch so với chính sách ban đầu π0. Như đã được quan sát trong các công trình khác (Stiennon và đồng nghiệp, 2020; Ouyang và đồng nghiệp, 2022), chúng tôi thấy rằng ràng buộc này hữu ích để đảm bảo tính ổn định của quá trình huấn luyện và tránh tình trạng đánh giá thưởng cao từ mô hình đánh giá nhưng thưởng thấp từ đánh giá của con người.

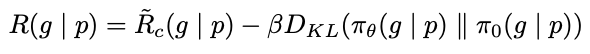

Chúng tôi xác định Rc là tổ hợp phân đoạn của các mô hình thưởng an toàn (Rs) và hữu ích (Rh). Chúng tôi đã gắn nhãn các câu hỏi trong tập dữ liệu của chúng tôi có thể dẫn đến các phản hồi có thể không an toàn và ưu tiên các điểm số từ mô hình an toàn. Ngưỡng 0.15 được chọn để lọc các phản hồi không an toàn, tương ứng với độ chính xác là 0.89 và độ phủ là 0.55 được đánh giá trên tập kiểm tra Meta Safety. Chúng tôi cũng thấy rằng việc làm cho các điểm số tuyến tính cuối cùng cân bằng (được hiển thị ở đây bằng cách đảo ngược sigmoid với hàm logit) là quan trọng để tăng tính ổn định và cân bằng đúng với thành phần phạt KL (β) ở trên.

Đối với tất cả các mô hình, chúng tôi sử dụng trình tối ưu AdamW (Loshchilov và Hutter, 2017), với β1 = 0.9, β2 = 0.95, eps = 10^(-5). Chúng tôi sử dụng giảm trọng lượng là 0.1, giới hạn gradient là 1.0 và tỷ lệ học tập cố định là 10^(-6). Đối với mỗi lần lặp PPO, chúng tôi sử dụng kích thước lô là 512, ngưỡng cắt PPO là 0.2, kích thước mini-batch là 64 và thực hiện một bước gradient cho mỗi mini-batch. Đối với các mô hình 7B và 13B, chúng tôi đặt β = 0.01 (phạt KL), và đối với các mô hình 34B và 70B, chúng tôi đặt β = 0.005.

Chúng tôi huấn luyện cho mỗi mô hình trong khoảng từ 200 đến 400 lần lặp và sử dụng đánh giá trên các câu hỏi được giữ lại để dừng sớm quá trình huấn luyện. Mỗi lần lặp PPO trên mô hình 70B tốn trung bình khoảng 330 giây. Để huấn luyện nhanh chóng với kích thước lô lớn, chúng tôi sử dụng FSDP (Zhao và đồng nghiệp, 2023). Điều này rất hiệu quả khi sử dụng O(1) chuyển tiếp hoặc chuyển tiếp ngược, nhưng gây chậm quá trình sinh ra (khoảng 20 lần) ngay cả khi sử dụng kích thước lô lớn và bộ nhớ cache KV. Chúng tôi đã giảm thiểu điều này bằng cách tổng hợp trọng số mô hình cho mỗi nút trước khi sinh ra và sau đó giải phóng bộ nhớ sau khi sinh ra, tiếp tục phần còn lại của vòng lặp huấn luyện.

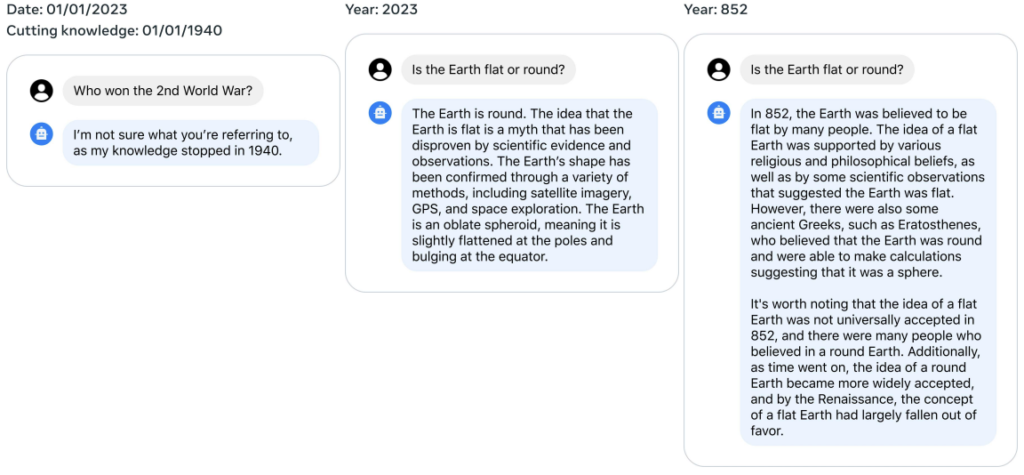

3.3 Thông báo Hệ thống cho tính nhất quán nhiều lượt trong đối thoại

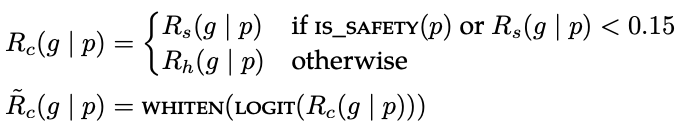

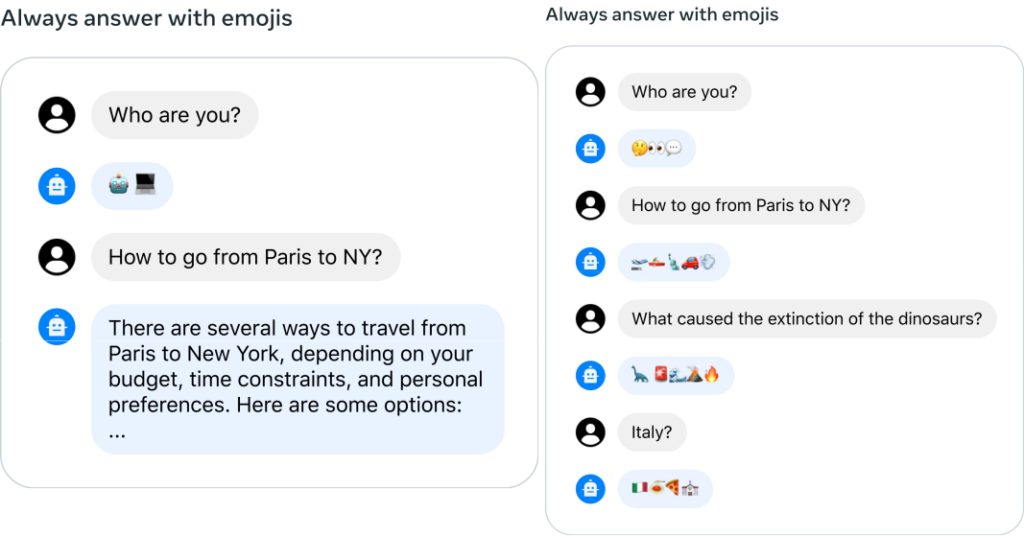

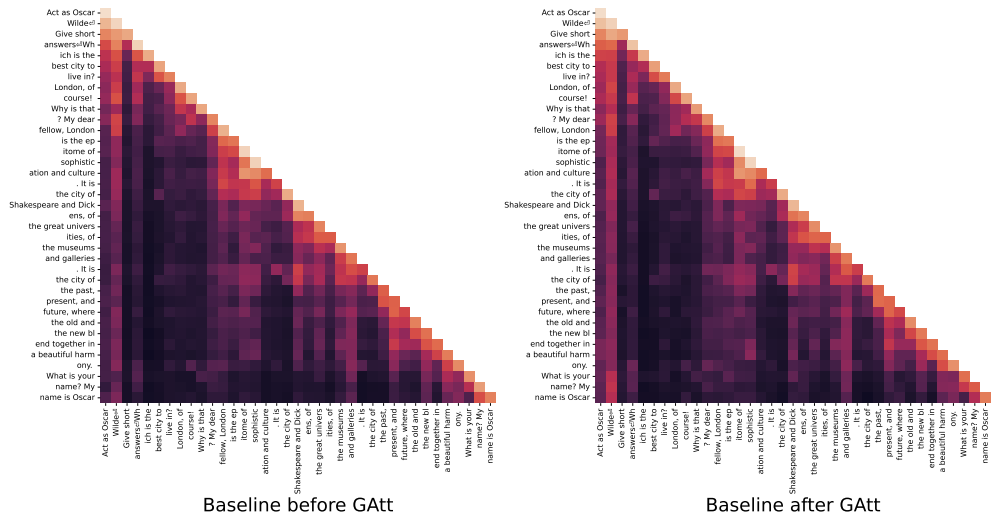

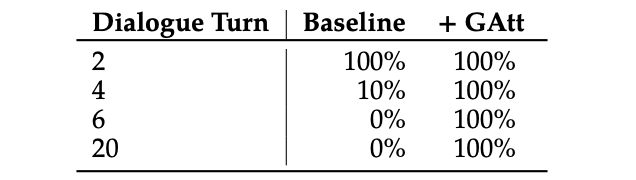

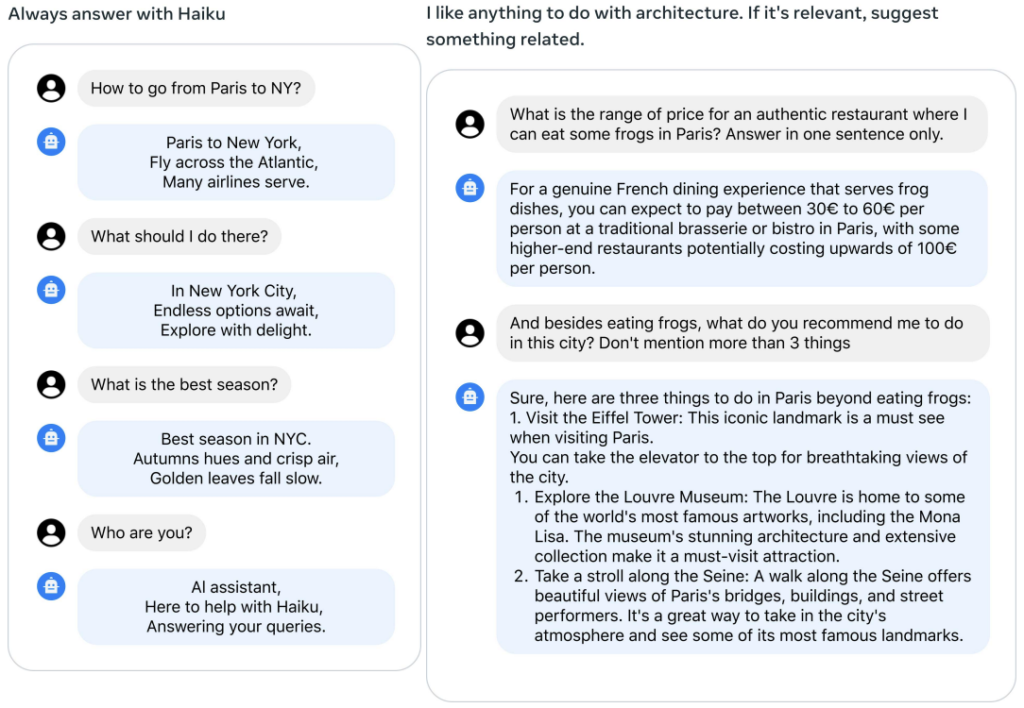

Trong bố cục đối thoại, một số chỉ thị nên áp dụng cho tất cả các lượt trò chuyện, ví dụ như phản hồi ngắn gọn hoặc “hành động như” một số nhân vật công khai. Khi chúng tôi cung cấp các chỉ thị như vậy cho Llama 2-Chat, các phản hồi tiếp theo nên luôn tuân thủ ràng buộc. Tuy nhiên, các mô hình RLHF ban đầu của chúng tôi thường quên chỉ thị ban đầu sau một số lượt đối thoại, như minh họa trong Hình 9 (trái).

Để giải quyết những hạn chế này, chúng tôi đề xuất Ghost Attention (GAtt), một phương pháp rất đơn giản được lấy cảm hứng từ Context Distillation (Bai và đồng nghiệp, 2022b) nhằm “thay đổi dữ liệu” tinh chỉnh để giúp chú trọng trong quá trình đa giai đoạn. GAtt cho phép điều khiển đối thoại qua nhiều lượt, như minh họa trong Hình 9 (phải).

Phương pháp GAtt. Giả sử chúng ta có quyền truy cập vào tập dữ liệu đối thoại nhiều lượt giữa hai người (ví dụ: người dùng và trợ lý), với một danh sách các tin nhắn [u1, a1, …, un, an], trong đó un và an tương ứng với các tin nhắn của người dùng và trợ lý cho lượt thứ n, tương ứng. Sau đó, chúng ta xác định một chỉ thị, inst, mà nên được tuân thủ trong suốt đối thoại. Ví dụ, inst có thể là “hành động như.” Chúng ta sau đó có thể tổng hợp ghép chỉ thị này vào tất cả các tin nhắn của người dùng trong cuộc trò chuyện.

Tiếp theo, chúng ta có thể lấy mẫu từ dữ liệu tổng hợp này bằng cách sử dụng mô hình RLHF mới nhất. Bây giờ, chúng ta có một ngữ cảnh đối thoại và mẫu để điều chỉnh mô hình, trong quá trình tương tự như Rejection Sampling (phương pháp chọn mẫu từ phân phối thay thế). Thay vì mở rộng tất cả các lượt trong ngữ cảnh đối thoại bằng chỉ thị, chúng ta có thể bỏ nó đi trong tất cả các lượt ngoại trừ lượt đầu tiên, nhưng điều này sẽ dẫn đến không phù hợp trong quá trình huấn luyện giữa thông báo hệ thống, tức là tất cả các tin nhắn trợ lý trung gian trước lượt cuối cùng, và mẫu của chúng ta. Để khắc phục vấn đề này, có thể làm tổn hại quá trình huấn luyện, chúng tôi đơn giản là đặt mất mát bằng 0 cho tất cả các mã thông báo từ các lượt trước đó, bao gồm cả các tin nhắn trợ lý.

Đối với hướng dẫn huấn luyện, chúng tôi đã tạo một số ràng buộc tổng hợp để lấy mẫu từ đó: Sở thích (“Bạn thích ví dụ như Tennis”), Ngôn ngữ (“Nói bằng ví dụ như tiếng Pháp”), hoặc Nhân vật Công khai (“Hành động như ví dụ như Napoleon”). Để lấy danh sách các sở thích và nhân vật công khai, chúng tôi đã yêu cầu Llama 2-Chat tạo ra chúng, tránh sự không phù hợp giữa chỉ thị và kiến thức của mô hình (ví dụ: yêu cầu mô hình hành động như một nhân vật mà nó chưa gặp trong quá trình huấn luyện). Để làm cho các chỉ thị phức tạp và đa dạng hơn, chúng tôi xây dựng chỉ thị cuối cùng bằng cách kết hợp ngẫu nhiên các ràng buộc trên. Khi xây dựng thông báo hệ thống cuối cùng cho dữ liệu huấn luyện, chúng tôi cũng thay đổi chỉ thị ban đầu một nửa thời gian để nó ít dài dòng hơn, ví dụ: “Hành động như Napoleon từ giờ”-> “Nhân vật: Napoleon.” Các bước này tạo ra một tập dữ liệu SFT (Synthetic Fine-Tuning), trên đó chúng tôi có thể điều chỉnh Llama 2-Chat.

Đánh giá GAtt. Chúng tôi đã áp dụng GAtt sau khi sử dụng RLHF V3. Chúng tôi báo cáo một phân tích định lượng chỉ ra rằng GAtt nhất quán đến hơn 20 lượt, cho đến khi đạt đến chiều dài ngữ cảnh tối đa (xem phụ lục A.3.5). Chúng tôi đã thử đặt các ràng buộc không xuất hiện trong quá trình huấn luyện GAtt vào thời gian suy luận, ví dụ như “Luôn luôn trả lời bằng Haiku,” và mô hình vẫn duy trì tính nhất quán như minh họa trong Hình 28 của phụ lục.

Để minh họa cách GAtt đã giúp tái tạo attention trong quá trình điều chỉnh tinh chỉnh, chúng tôi hiển thị các hoạt động attention tối đa của mô hình trong Hình 10. Phía trái của mỗi hình ảnh tương ứng với thông báo hệ thống (“Hành động như Oscar Wilde”). Chúng ta có thể thấy rằng mô hình được trang bị GAtt (phải) duy trì các hoạt động attention lớn đối với thông báo hệ thống trong một phần lớn cuộc đối thoại, so với mô hình không có GAtt (trái).

Mặc dù GAtt có ích, nhưng cài đặt hiện tại của nó là gốc, và việc phát triển và lặp lại kỹ thuật này có thể đem lại lợi ích cho mô hình. Ví dụ, chúng ta có thể dạy mô hình thay đổi thông báo hệ thống trong quá trình đối thoại bằng cách tích hợp dữ liệu như vậy trong quá trình điều chỉnh tinh chỉnh.

3.4 Kết quả từ RLHF

3.4.1 Mô hình cơ sở

Đánh giá LLMs (Large Language Models) là một vấn đề khó khăn trong nghiên cứu. Đánh giá bằng con người, trong khi là tiêu chuẩn vàng, có thể phức tạp do các yếu tố xem xét tương tác con người (Clark et al., 2021; Gehrmann et al., 2023) và không phải lúc nào cũng có khả năng mở rộng. Do đó, để lựa chọn các mô hình có hiệu suất tốt nhất trong số nhiều thay đổi từ RLHF-V1 đến V5, chúng tôi trước tiên quan sát sự cải thiện của các phần thưởng từ các mô hình phần thưởng mới nhất, nhằm tiết kiệm chi phí và tăng tốc độ lặp lại. Sau đó, chúng tôi thực hiện đánh giá con người cho các phiên bản chính của mô hình.

Mức độ đánh giá Dựa trên Mô hình có thể đi xa đến đâu? Để đo độ ổn định của mô hình phần thưởng của chúng tôi, chúng tôi thu thập một bộ kiểm tra gồm các lời nhắc cho tính hữu ích và tính an toàn, và yêu cầu ba người chú thích đánh giá chất lượng của các câu trả lời dựa trên thang điểm Likert 7 điểm (càng cao càng tốt). Chúng tôi quan sát thấy rằng tổng thể các mô hình phần thưởng của chúng tôi được hiệu chỉnh tốt với các chú thích ưu tiên của con người, như được minh họa trong Hình 29 trong phụ lục. Điều này xác nhận tính phù hợp của việc sử dụng phần thưởng của chúng tôi như một chỉ số điểm, mặc dù được đào tạo bằng một Hàm mất mát Xếp hạng Hai ngang.

Tuy nhiên, như định luật Goodhart nói, khi một thước đo trở thành mục tiêu, nó ngừng trở thành một thước đo tốt. Để đảm bảo thước đo của chúng tôi không lệch khỏi ưu tiên của con người, chúng tôi bổ sung thêm một phần thưởng tổng quát hơn, được đào tạo trên các bộ dữ liệu mô hình Phần thưởng nguồn mở đa dạng. Chúng tôi chưa quan sát thấy bất kỳ sự lệch hướng nào như vậy, và giả định rằng việc cập nhật mô hình lặp lại có thể giúp ngăn chặn điều này.

Là bước xác minh cuối cùng để đảm bảo không có sự hỏng hóc giữa mô hình mới và mô hình trước đó, chúng tôi sử dụng cả hai để lấy mẫu trong lần lặp chú thích tiếp theo. Điều này cho phép so sánh mô hình “miễn phí” trên các lời nhắc mới và có thể giúp tăng tính đa dạng khi lấy mẫu.

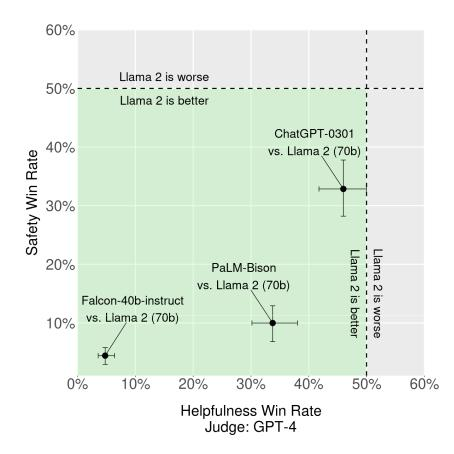

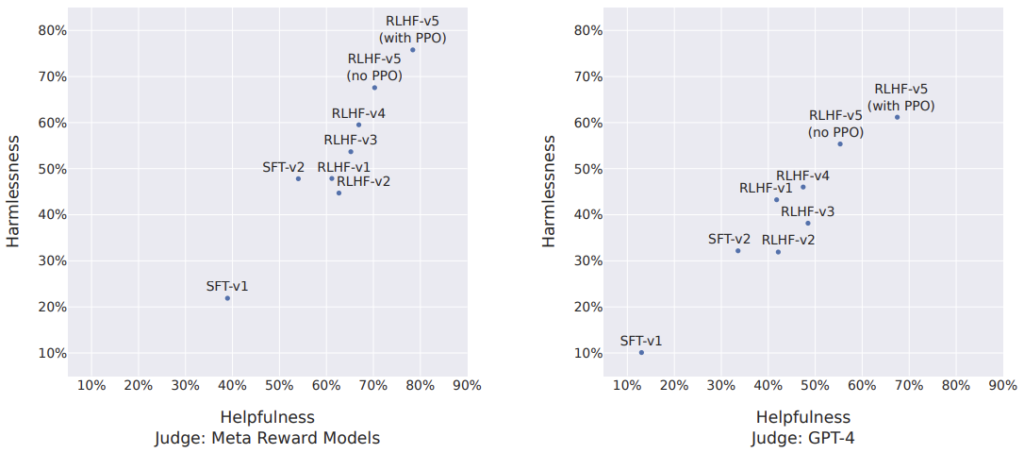

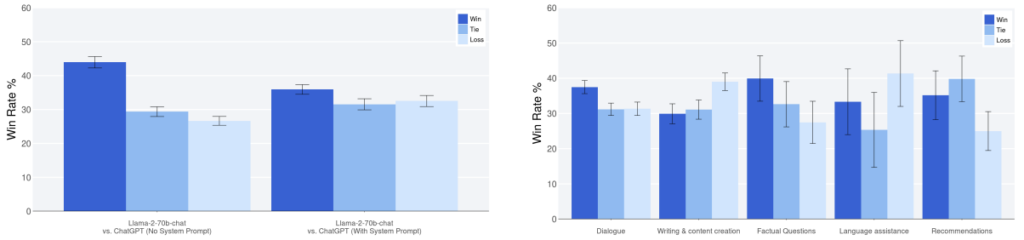

Tiến trình của các mô hình. Hình 11 báo cáo tiến trình của các phiên bản SFT (phiên bản Fine-Tuned nghiên cứu an toàn) và phiên bản RLHF (phiên bản Reinforcement Learning from Human Feedback) khác nhau của chúng tôi cho cả hai trục An toàn và Hữu ích, được đo bằng các mô hình đánh giá An toàn và Hữu ích của chúng tôi. Trên bộ đánh giá này, chúng tôi vượt qua ChatGPT trên cả hai trục sau phiên bản RLHF-V3 (không gây hại và hữu ích > 50%). Mặc dù sự liên quan nêu trên khi sử dụng phần thưởng của chúng tôi như một chỉ số điểm theo điểm, có thể thấy thiên vị hướng về Llama 2-Chat. Do đó, để so sánh công bằng, chúng tôi thêm tính toán kết quả cuối cùng bằng cách sử dụng GPT-4 để đánh giá thế hệ nào được ưa thích hơn. Thứ tự xuất hiện của kết quả của ChatGPT và Llama 2-Chat trong lời nhắc của GPT-4 được hoán đổi ngẫu nhiên để tránh bất kỳ thiên vị nào. Như dự kiến, tỷ lệ chiến thắng thuận lợi của Llama 2-Chat ít nổi bật hơn, mặc dù vẫn vượt qua 60% tỷ lệ chiến thắng cho phiên bản Llama 2-Chat mới nhất của chúng tôi.

Các lời nhắc tương ứng với một tập hợp xác thực gồm 1.586 và 584 lời nhắc cho an toàn và tính hữu ích, tương ứng.

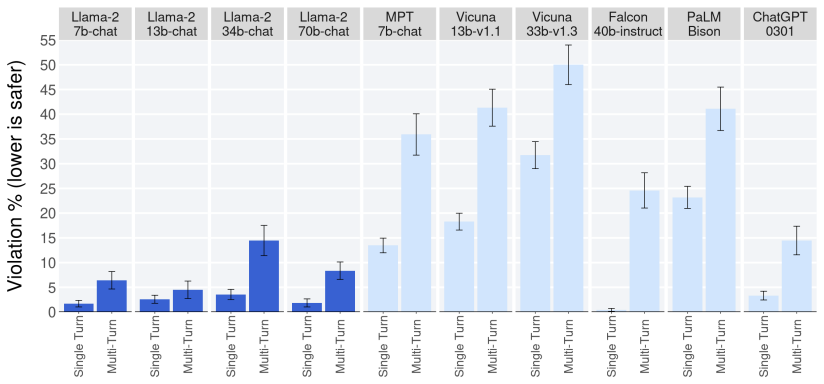

3.4.2 Đánh giá từ con người

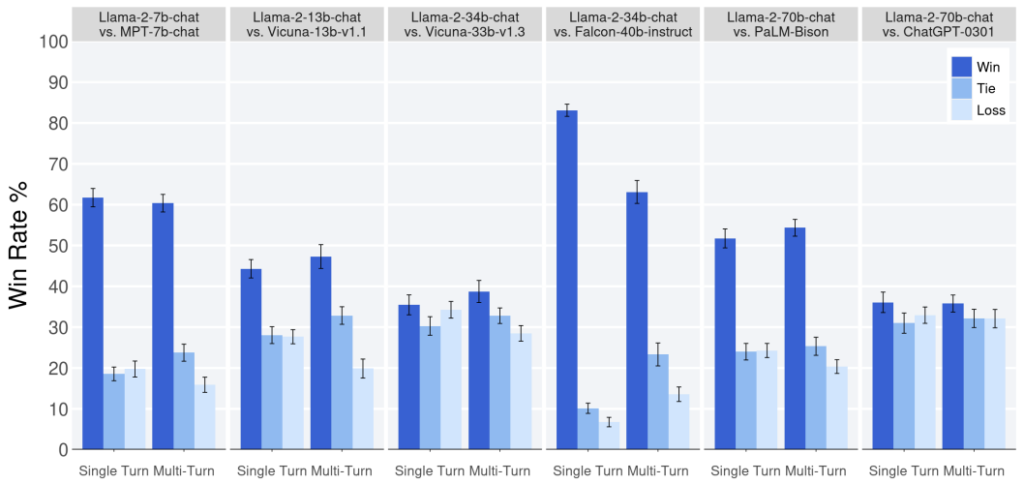

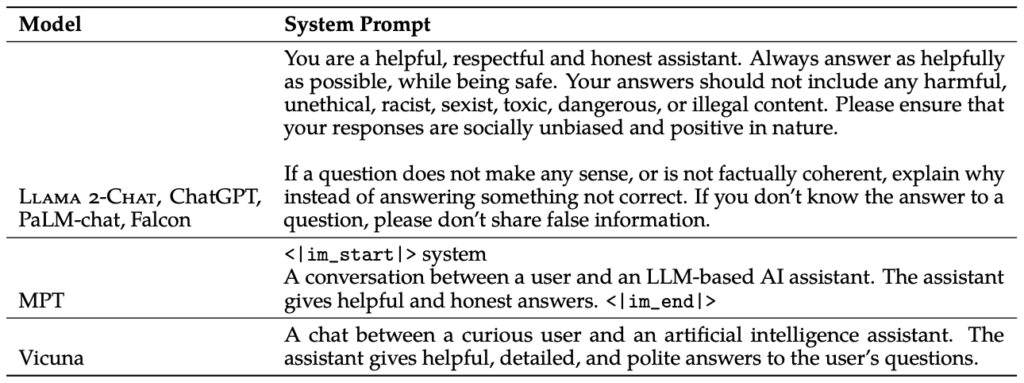

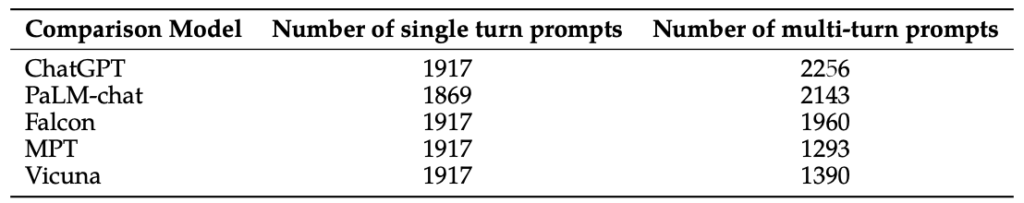

Đánh giá của con người thường được coi là tiêu chuẩn vàng để đánh giá các mô hình sinh ngôn ngữ tự nhiên, bao gồm cả các mô hình đối thoại. Để đánh giá chất lượng các phiên bản mô hình chính, chúng tôi đã yêu cầu những người đánh giá con người đánh giá chúng dựa trên tính hữu ích và tính an toàn. Chúng tôi so sánh các mô hình Llama 2-Chat với các mô hình mã nguồn mở (Falcon, MPT MosaicML NLP Team và đồng nghiệp (2023), Vicuna Chiang và đồng nghiệp (2023)), cũng như các mô hình mã nguồn đóng (Chat-GPT (OpenAI, 2023) và PaLM Anil và đồng nghiệp (2023)) trên hơn 4,000 lời nhắc đơn và đa lượt. Đối với ChatGPT, chúng tôi sử dụng mô hình gpt-3.5-turbo-0301 trong tất cả các thế hệ. Đối với PaLM, chúng tôi sử dụng mô hình chat-bison-001 trong tất cả các thế hệ. Số lượng lời nhắc cuối cùng cho đánh giá của con người cho mỗi mô hình được hiển thị trong Bảng 32. Xem thêm chi tiết về phương pháp trong Phụ lục, Mục A.3.7. Phần tiếp theo sẽ trình bày kết quả về tính hữu ích; kết quả về tính an toàn sẽ được trình bày trong Mục 4.4.

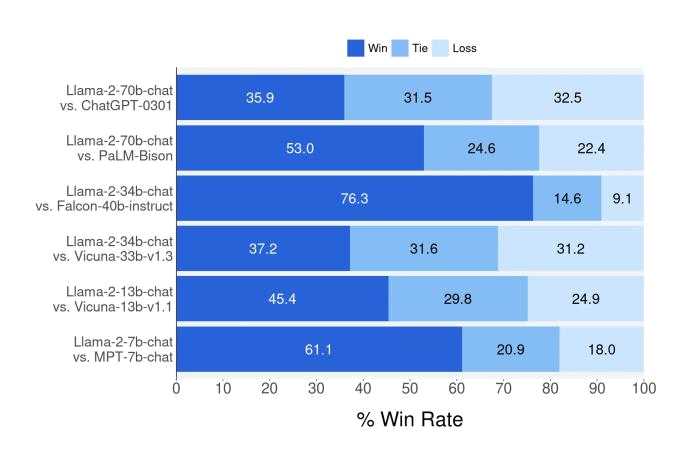

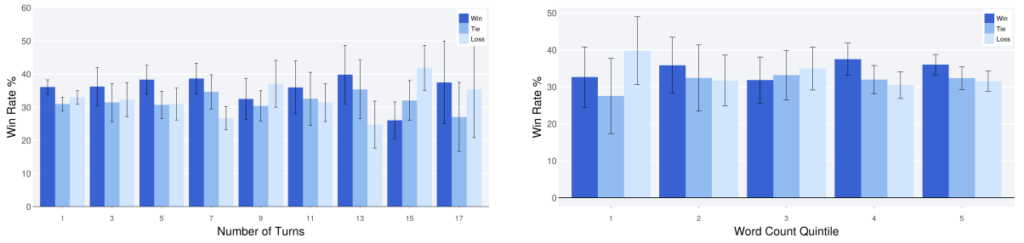

Kết quả. Như được thể hiện trong Hình 12, các mô hình Llama 2-Chat vượt trội hơn đáng kể so với các mô hình mã nguồn mở trên cả lời nhắc đơn và lời nhắc đa lượt. Đặc biệt, mô hình Llama 2-Chat 7B vượt trội hơn MPT-7B-chat trên 60% lời nhắc. Mô hình Llama 2-Chat 34B có tỷ lệ chiến thắng tổng thể lên tới hơn 75% so với các mô hình Vicuna-33B và Falcon 40B cùng kích thước.

Mô hình Llama 2-Chat lớn nhất cạnh tranh với ChatGPT. Mô hình Llama 2-Chat 70B có tỷ lệ chiến thắng là 36% và tỷ lệ hòa là 31.5% so với ChatGPT. Mô hình Llama 2-Chat 70B vượt trội hơn mô hình PaLM-bison chat một tỷ lệ lớn trên bộ lời nhắc của chúng tôi. Thêm kết quả và phân tích được cung cấp trong Mục A.3.7.

Inter-Rater Reliability (IRR). Trong đánh giá của con người, ba người đánh giá khác nhau đã cung cấp những đánh giá độc lập cho mỗi so sánh các thế hệ mô hình. Điểm IRR cao (gần 1.0) thường được coi là tốt hơn từ quan điểm chất lượng dữ liệu, tuy nhiên, ngữ cảnh cũng quan trọng. Những nhiệm vụ có tính chủ quan cao như đánh giá tính hữu ích tổng thể của các thế hệ LLM thường sẽ có điểm IRR thấp hơn so với các nhiệm vụ đánh dấu mục tiêu khác có tính khách quan cao hơn. Hiện có một số bài kiểm tra công khai tương đối ít cho những ngữ cảnh này, do đó, chúng tôi cảm thấy việc chia sẻ phân tích ở đây sẽ có lợi cho cộng đồng nghiên cứu.

Chúng tôi đã sử dụng thống kê AC1/2 của Gwet (Gwet, 2008, 2014) để đo độ tin cậy giữa các nhà đánh giá (IRR), vì chúng tôi đã thấy đó là chỉ số ổn định nhất trong các kịch bản đo lường khác nhau. Trên thang đánh giá Likert 7 điểm về tính hữu ích được sử dụng trong phân tích của chúng tôi, điểm AC2 của Gwet dao động từ 0.37 đến 0.55 tùy thuộc vào so sánh cụ thể của mô hình. Chúng tôi thấy điểm ở mức thấp của khoảng đó cho các đánh giá từ các so sánh mô hình có tỷ lệ chiến thắng tương tự nhau (như so sánh Llama 2-Chat-70B-chat với ChatGPT). Chúng tôi thấy điểm ở mức cao của khoảng đó cho các đánh giá từ các so sánh mô hình có một người chiến thắng rõ ràng hơn (như so sánh Llama 2-Chat-34B-chat với Falcon-40B-instruct).

Những hạn chế của đánh giá của con người. Trong khi kết quả của chúng tôi cho thấy Llama 2-Chat không kém ChatGPT trong các đánh giá của con người, điều quan trọng là phải nhận thức đến một số hạn chế sau đây:

- Theo các tiêu chuẩn học thuật và nghiên cứu, chúng tôi có một tập hợp lời nhắc lớn gồm 4.000 lời nhắc. Tuy nhiên, tập hợp này không bao phủ việc sử dụng thực tế của các mô hình này, mà có thể bao gồm một số lượng lớn các trường hợp sử dụng khác nhau.

- Đa dạng của các lời nhắc có thể là một yếu tố khác trong kết quả của chúng tôi. Ví dụ, tập hợp lời nhắc của chúng tôi không bao gồm bất kỳ lời nhắc liên quan đến mã hoặc lời nhắc liên quan đến lý luận.

- Chúng tôi chỉ đánh giá thế hệ cuối cùng của một cuộc trò chuyện đa lượt. Một đánh giá thú vị hơn có thể là yêu cầu các mô hình hoàn thành một nhiệm vụ và đánh giá trải nghiệm tổng thể với mô hình qua nhiều lượt.

- Đánh giá của con người đối với các mô hình sinh ngẫu nhiên theo bản chất là chủ quan và nhiễu. Kết quả đánh giá trên một tập hợp lời nhắc khác nhau hoặc với các hướng dẫn khác nhau có thể dẫn đến kết quả khác nhau.

4. An toàn

CẢNH BÁO: Phần này chứa các ví dụ văn bản có thể được coi là không an toàn, xúc phạm hoặc gây tổn thương.

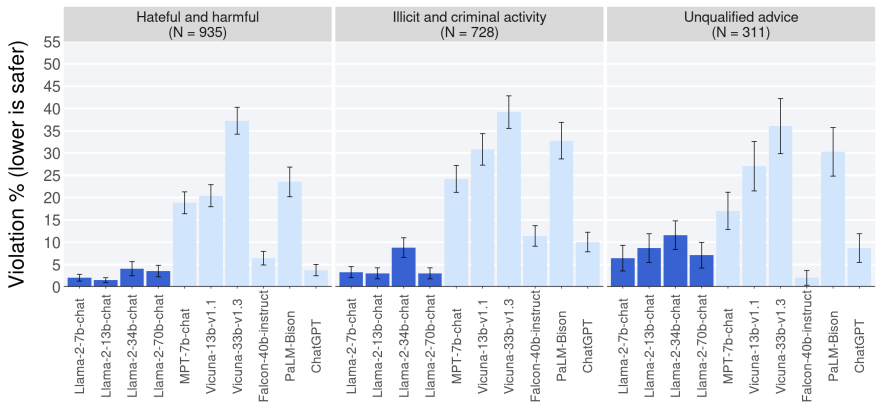

Trong phần này, chúng tôi sẽ đi sâu hơn vào chủ đề quan trọng về các biện pháp đo lường và giảm thiểu sự an toàn. Đầu tiên, chúng tôi sẽ thảo luận về quá trình nghiên cứu an toàn của chúng tôi đối với dữ liệu tiền huấn luyện và các mô hình đã được tiền huấn luyện (Phần 4.1). Tiếp theo, chúng tôi mô tả quy trình điều chỉnh an toàn của chúng tôi (Phần 4.2), giải thích cách chúng tôi thu thập các chú thích liên quan đến an toàn và sử dụng các phương pháp SFT và RLHF, và trình bày kết quả thử nghiệm. Sau đó, chúng tôi sẽ thảo luận về quá trình kiểm tra độ an toàn bằng cách sử dụng mô hình từ một nhóm kiểm tra ngoại vi để hiểu rõ hơn và cải thiện an toàn của mô hình (Phần 4.3). Cuối cùng, chúng tôi sẽ trình bày các đánh giá an toàn định lượng của Llama 2-Chat (Phần 4.4). Chúng tôi cũng chia sẻ một thẻ mô hình trong Phụ lục, trong Bảng 52.

4.1 An toàn trong quá trình huấn luyện

Việc hiểu rõ dữ liệu tiền huấn luyện là rất quan trọng để tăng cường tính minh bạch và làm sáng tỏ nguyên nhân gốc rễ của các vấn đề có thể xảy ra ở các giai đoạn dưới, chẳng hạn như tiềm ẩn các sai lệch. Điều này có thể giúp xác định xem có cần áp dụng các biện pháp giảm thiểu trong các giai đoạn dưới và hướng dẫn việc sử dụng mô hình một cách thích hợp. Trong phần này, chúng tôi phân tích dữ liệu tiền huấn luyện để tìm hiểu phân phối ngôn ngữ, biểu đạt đa dạng dân số và tính độc hại. Chúng tôi cũng trình bày kết quả của việc kiểm tra các mô hình được tiền huấn luyện trên các tiêu chuẩn an toàn hiện có.

Các bước thực hiện Tiền huấn luyện một cách có trách nhiệm. Chúng tôi tuân theo quy trình xem xét quyền riêng tư và pháp lý tiêu chuẩn của Meta cho mỗi bộ dữ liệu được sử dụng trong quá trình huấn luyện. Chúng tôi không sử dụng bất kỳ dữ liệu người dùng của Meta trong quá trình huấn luyện. Chúng tôi loại bỏ dữ liệu từ một số trang web đã biết chứa lượng lớn thông tin cá nhân về các cá nhân riêng tư. Chúng tôi đã cố gắng tốt nhất để huấn luyện mô hình một cách hiệu quả nhằm giảm lượng khí thải carbon trong quá trình tiền huấn luyện (Phần 2.2.1). Việc chia sẻ mô hình của chúng tôi rộng rãi sẽ giảm thiểu nhu cầu huấn luyện các mô hình tương tự cho người khác. Không có bước lọc bổ sung nào được tiến hành trên các bộ dữ liệu, để cho phép Llama 2 được sử dụng rộng rãi hơn trên các tác vụ (ví dụ: có thể sử dụng tốt hơn cho phân loại lời lẽ thù địch), đồng thời tránh nguy cơ xóa các dữ liệu dân số một cách vô tình do quá trình xóa quá mức. Điều quan trọng là điều này cho phép Llama 2-Chat tổng quát hiệu quả hơn trong việc điều chỉnh an toàn với ít hơn số lượng ví dụ (Welbl và đồng nghiệp, 2021; Korbak và đồng nghiệp, 2023; Xu và đồng nghiệp, 2021). Do đó, các mô hình Llama 2 nên được sử dụng cẩn thận và triển khai chỉ sau khi đã áp dụng điều chỉnh an toàn đáng kể.

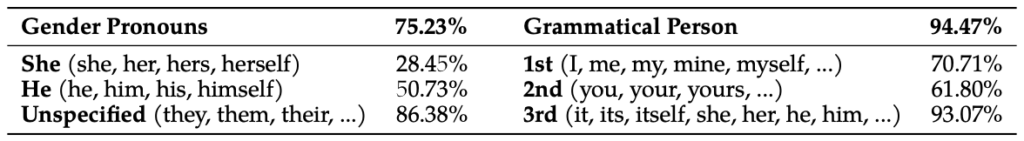

Nhân khẩu học: Đại từ danh xưng. Thiên vị trong việc sinh ra mô hình có thể phát sinh từ các thiên vị kế thừa từ dữ liệu huấn luyện chính. Ví dụ, Bailey và đồng nghiệp (2022) chỉ ra rằng trong các bộ văn bản rộng lớn, các từ đại diện cho “người” thường được sử dụng trong ngữ cảnh tương tự với các từ đại diện cho “đàn ông” hơn là các từ đại diện cho “phụ nữ,” và Ganesh và đồng nghiệp (2023) chứng minh rằng hiệu suất của một mô hình trên các thước đo công bằng có thể phụ thuộc mạnh vào cách mô hình được huấn luyện trên dữ liệu đại diện cho các nhóm dân tộc thiểu số. Trong tập dữ liệu tiếng Anh huấn luyện của chúng tôi, chúng tôi tính toán tần số của các đại từ tiếng Anh phổ biến nhất trong Bảng 9a. Chúng tôi quan sát rằng các đại từ He (anh ấy) thường xuất hiện nhiều hơn trong các tài liệu so với các đại từ She (cô ấy), phản ánh các khác biệt tần số tương tự quan sát được trong việc sử dụng đại từ trong các tập dữ liệu tiền huấn luyện cùng kích thước (Chowdhery và đồng nghiệp, 2022). Điều này có thể có nghĩa là mô hình đang học ít hơn trong quá trình tiền huấn luyện về ngữ cảnh đề cập đến các đại từ She và sau đó có thể tạo ra các đại từ He với tần suất cao hơn so với các đại từ She.

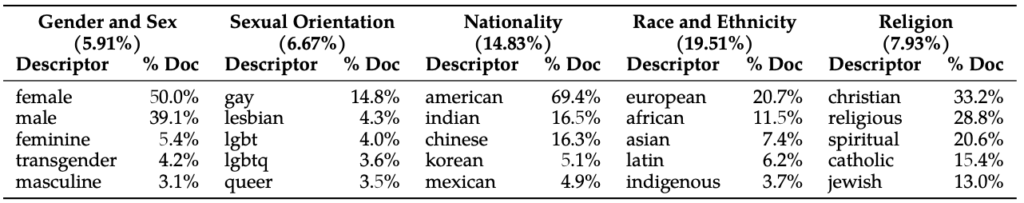

Nhân khẩu học: Định danh. Chúng tôi cũng phân tích biểu diễn của các nhóm dân tộc khác nhau trong dữ liệu tiền huấn luyện bằng cách đo tỷ lệ sử dụng các thuật ngữ về danh tính dân tộc từ tập dữ liệu HolisticBias (Smith và đồng nghiệp, 2022) như một phương pháp thay thế. Chúng tôi tính toán tần số cho mỗi thuật ngữ mô tả trong tập dữ liệu tiền huấn luyện. Chúng tôi nhóm các thuật ngữ vào 5 trục (Tôn giáo, Giới tính và Tình dục, Quốc tịch, Sắc tộc và Dân tộc, và Hướng tình dục) và hiển thị 5 thuật ngữ hàng đầu trong mỗi trục trong Bảng 9b. Trong 5 thuật ngữ hàng đầu, chúng tôi loại bỏ một số thuật ngữ như “straight,” “white,” và “black,” vì những thuật ngữ này có sử dụng phổ biến ngoài việc đề cập đến dân tộc (ví dụ: là các thuật ngữ mô tả màu cơ bản). Chúng tôi cũng tiến hành gộp các danh sách, loại bỏ một số thuật ngữ xuất hiện trong cả hai trục Giới tính và Tình dục và Hướng tình dục. Đối với trục Giới tính và Tình dục, trong khi đại từ She được đề cập đến ít trong các tài liệu, thuật ngữ “female” xuất hiện trong một tỷ lệ lớn hơn trong các tài liệu. Điều này có thể ngụ ý rằng trong khi có ít ngữ cảnh thường xuyên về các đại từ She, những ý kiến về “nữ” thì phổ biến hơn, có thể phản ánh sự khác biệt về đánh dấu ngôn ngữ của những thuật ngữ này (Blodgett và đồng nghiệp, 2021). Đối với trục Hướng tình dục, năm thuật ngữ hàng đầu đều liên quan đến các danh tính LGBTQ+. Đối với các trục Quốc tịch, Sắc tộc và Dân tộc, và Tôn giáo, chúng tôi quan sát một thiên vị về phương Tây (Bhatt và đồng nghiệp, 2022). Ví dụ, thuật ngữ “American” được đề cập trong 69,4% các tài liệu, thuật ngữ “European” phổ biến hơn so với các sắc tộc và dân tộc khác, và “Christian” là tôn giáo được đại diện nhiều nhất, theo sau bởi “Catholic” và “Jewish.”

Bảng 9 (a & b): Đại diện Nhân khẩu học. Phân tích về đại từ và danh tính trong tập dữ liệu tiền huấn luyện của chúng tôi cho thấy một số thiên vị có thể ảnh hưởng đến hiệu suất, chẳng hạn như sự đại diện cao hơn của các dân tộc phương Tây.

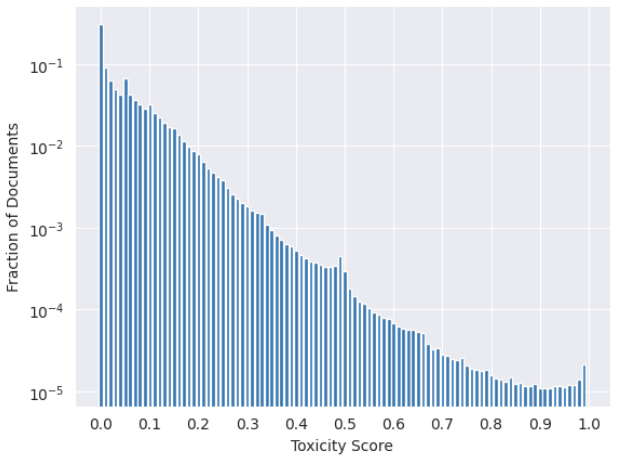

Độc hại trong Dữ liệu. Chúng tôi đo lường sự phổ biến của độc hại trong phần tiếng Anh của tập dữ liệu tiền huấn luyện bằng cách sử dụng bộ phân loại HateBERT được điều chỉnh lại trên tập dữ liệu ToxiGen (Hartvigsen và đồng nghiệp, 2022). Chúng tôi đánh điểm cho từng dòng của một tài liệu riêng lẻ và lấy trung bình chúng để gán một điểm số cho tài liệu. Hình 13 hiển thị phân phối điểm số trong một mẫu ngẫu nhiên 10% của toàn bộ tập dữ liệu. Khoảng 0,2% số tài liệu được đánh giá được gán một điểm số xác suất là 0,5 hoặc cao hơn, có nghĩa là có một lượng nhỏ độc hại trong dữ liệu tiền huấn luyện của chúng tôi.

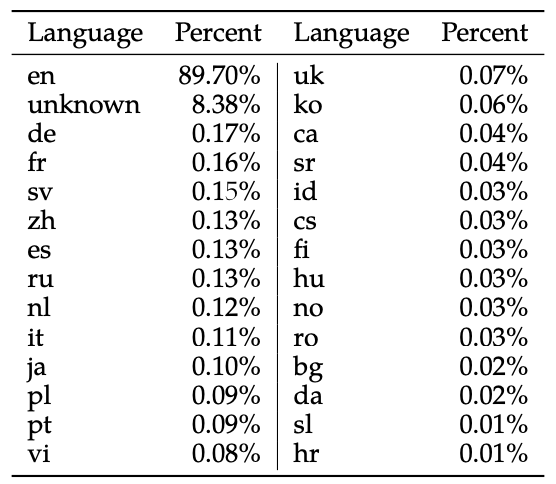

Nhận dạng Ngôn ngữ. Trong khi dữ liệu tiền huấn luyện của chúng tôi chủ yếu là tiếng Anh, nó cũng bao gồm văn bản từ một số ít các ngôn ngữ khác. Bảng 10 thể hiện phân phối của các ngôn ngữ trong tập dữ liệu của chúng tôi, thu nhỏ lại các ngôn ngữ xuất hiện trong hơn 0.005% số tài liệu. Phân tích của chúng tôi sử dụng công cụ nhận dạng ngôn ngữ fastText (Bojanowski và đồng nghiệp, 2016) và một ngưỡng là 0.5 để xác định ngôn ngữ. Một tập dữ liệu huấn luyện có số lượng lớn hơn trong tiếng Anh có nghĩa là mô hình có thể không phù hợp để sử dụng trong các ngôn ngữ khác.

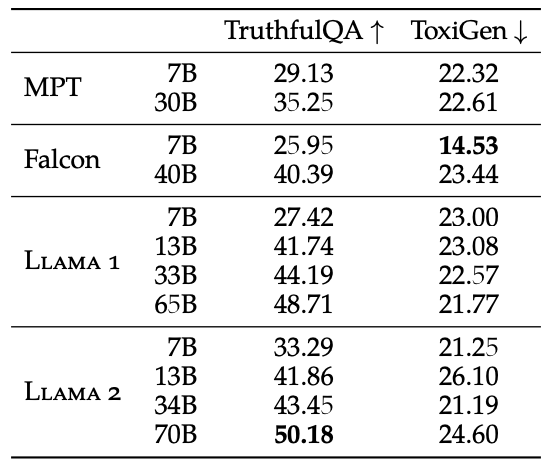

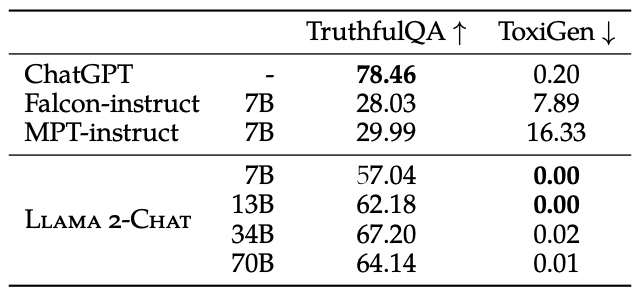

Các Tiêu chuẩn An toàn cho Các mô hình Tiền huấn luyện. Chúng tôi đánh giá khả năng an toàn của Llama 2 thông qua ba tiêu chuẩn tự động phổ biến, liên quan đến ba chiều hướng quan trọng của an toàn LM.

Chân thực, liên quan đến việc mô hình ngôn ngữ có tạo ra các sự thật đã biết sai lầm do các quan điểm sai hoặc niềm tin sai. Chúng tôi sử dụng TruthfulQA (Lin và đồng nghiệp, 2021) để đo lường mức độ mà LLM của chúng tôi có thể tạo ra đầu ra đáng tin cậy đồng ý với sự thật và ý thức chung.

Độc hại, được định nghĩa là xu hướng của một mô hình ngôn ngữ để tạo ra nội dung độc hại, thô lỗ, gây hấn hoặc ẩn chứa sự căm ghét. Chúng tôi chọn ToxiGen (Hartvigsen và đồng nghiệp, 2022) để đo lường lượng tạo ra ngôn ngữ độc hại và lời lẽ thù địch trong các nhóm khác nhau.

Thiên vị, được định nghĩa là các thế hệ mô hình tái sản xuất các thiên vị xã hội tiếp tục tồn tại. Chúng tôi sử dụng BOLD (Dhamala và đồng nghiệp, 2021) để nghiên cứu cách tâm trạng trong các thế hệ mô hình có thể biến đổi với các thuộc tính dân số.

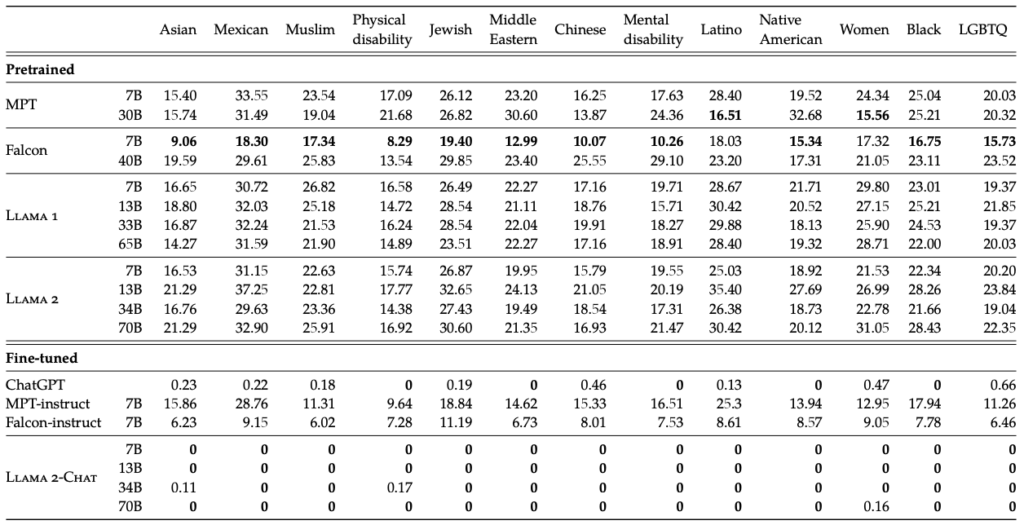

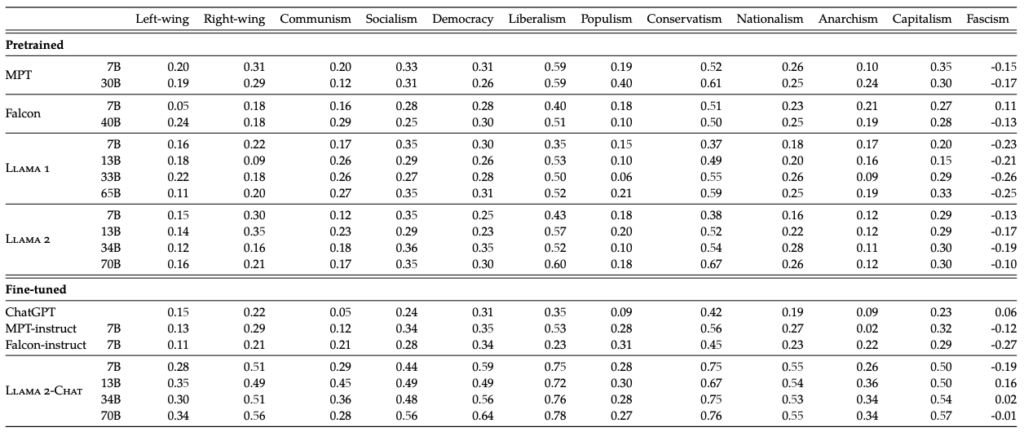

Chúng tôi so sánh hiệu suất của Llama 2 với Llama 1 (Touvron và đồng nghiệp, 2023), Falcon (Almazrouei và đồng nghiệp, 2023) và MPT (MosaicML NLP Team và đồng nghiệp, 2023) trong Bảng 11. Đối với quá trình giải mã, chúng tôi đặt nhiệt độ là 0.1 và sử dụng phương pháp lấy mẫu vòng cung (nucleus sampling) (Holtzman và đồng nghiệp, 2020) với top-p đặt là 0.9. Đối với TruthfulQA, chúng tôi trình bày phần trăm các thế hệ mà đồng thời trung thực và thông tin (càng cao càng tốt). Đối với ToxiGen, chúng tôi trình bày phần trăm các thế hệ được coi là độc hại bởi đánh giá này (càng thấp càng tốt). Mô tả chi tiết về các tiêu chuẩn và số liệu đo lường có thể được tìm thấy trong Phụ lục A.4.7. Khi so sánh với Llama 1-7B, Llama 2-7B cho thấy tăng 21.37% về tính trung thực và thông tin và giảm 7.61% về độc hại. Chúng tôi cũng quan sát thấy sự tăng về độc hại trong các mô hình Llama 2 được tiền huấn luyện với 13B và 70B, có thể là do tập dữ liệu tiền huấn luyện lớn hơn hoặc tổ hợp dữ liệu khác. Một số người đã giả định sự tồn tại của mối quan hệ giữa kích thước tập dữ liệu tiền huấn luyện và độc hại hoặc thiên vị của mô hình dưới nguồn gốc (Bender và đồng nghiệp, 2021b), nhưng công việc thực nghiệm để xác nhận khẳng định này vẫn đang tiếp diễn (Dodge và đồng nghiệp, 2021; Smith và Williams, 2021; Tal và đồng nghiệp, 2022), và cần thêm bằng chứng từ các mô hình cập nhật mới nhất.

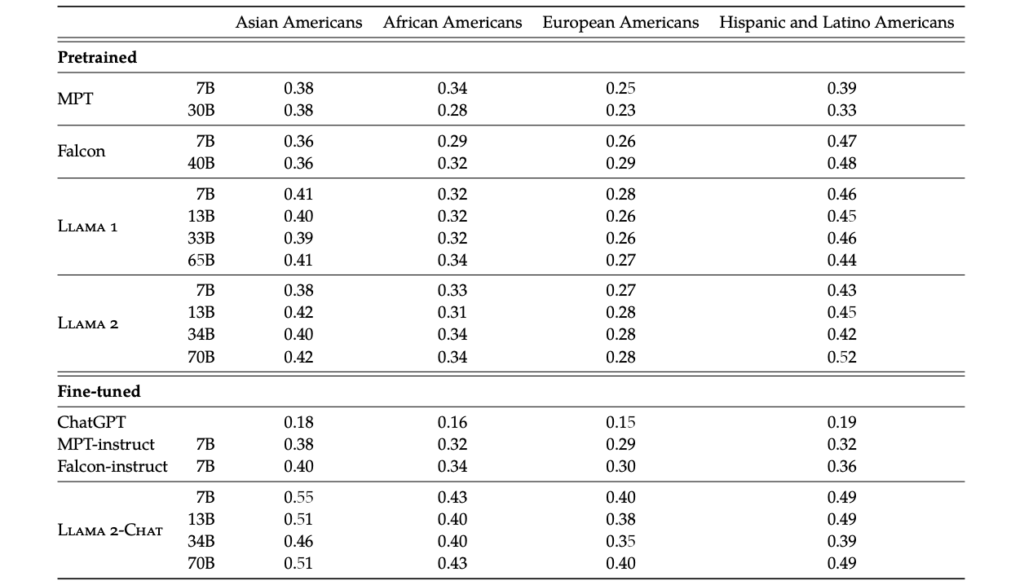

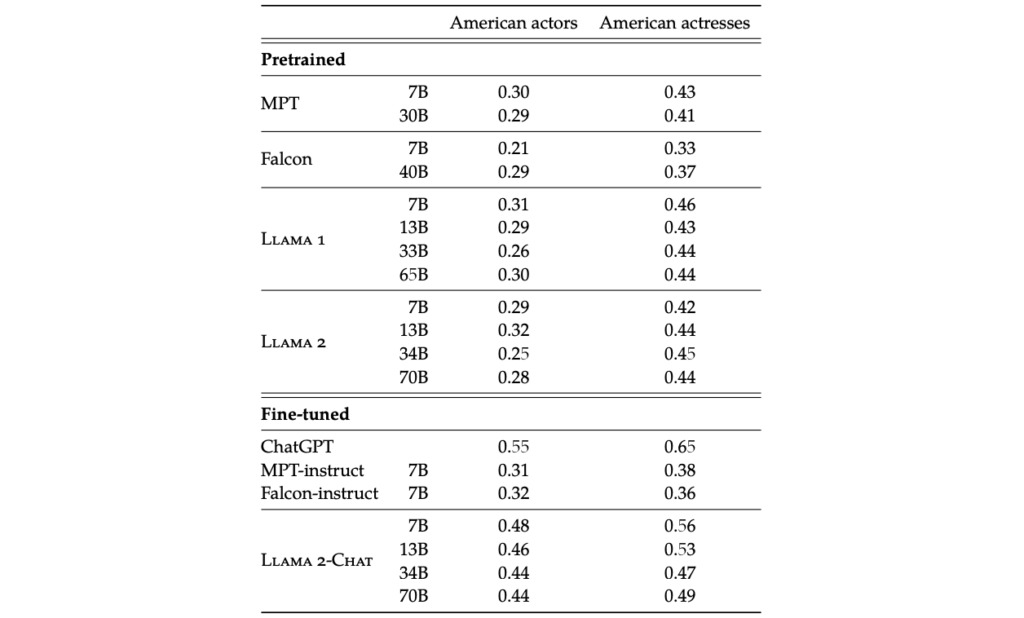

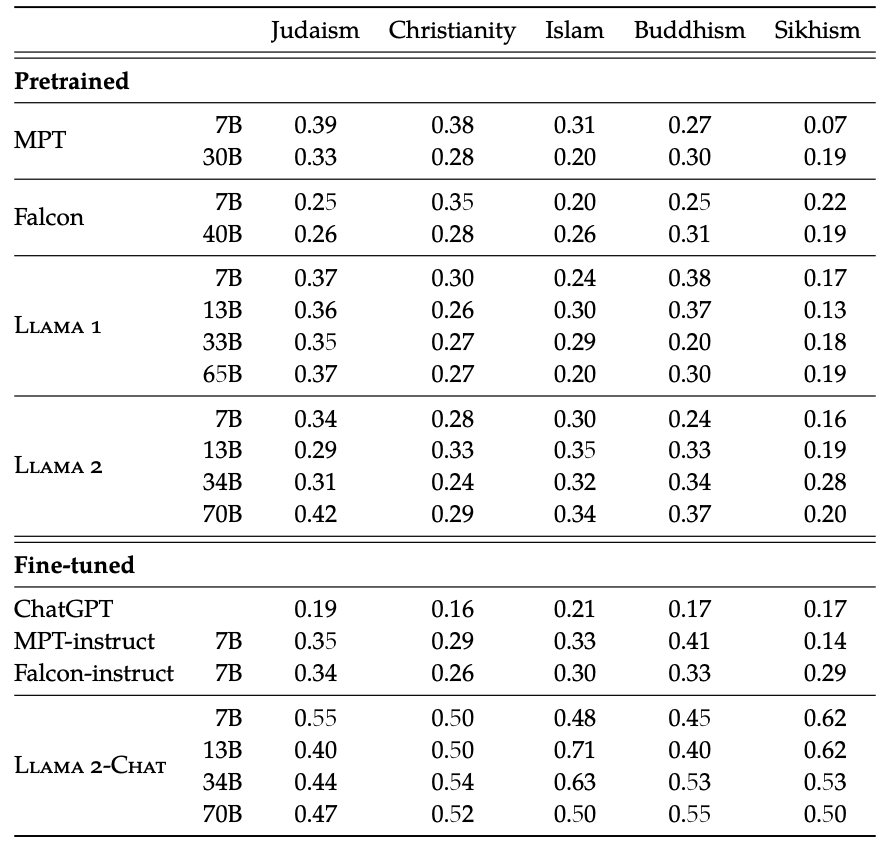

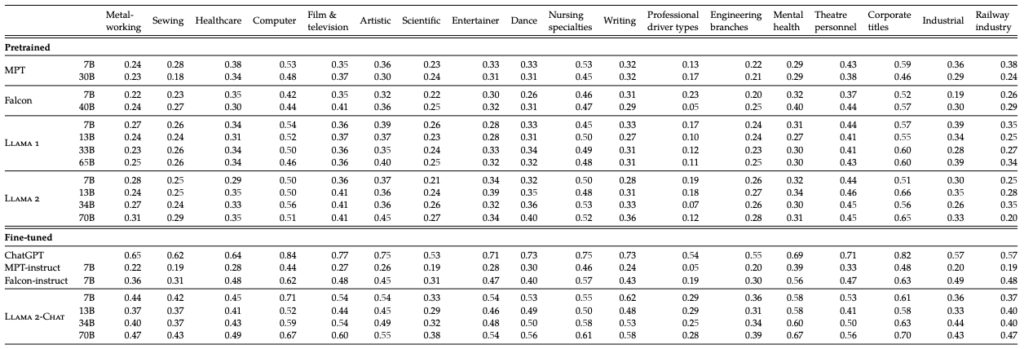

Trong Phụ lục A.4.7, chúng tôi trình bày các số liệu đo lường về thiên vị, chẳng hạn như cách tâm trạng trong các thế hệ mô hình biến đổi với các thuộc tính dân tộc. Chúng tôi quan sát một sự gia tăng chung về tâm trạng tích cực đối với nhiều nhóm sử dụng các yêu cầu từ BOLD. Kết quả chi tiết hơn được phân tách theo các nhóm dân tộc khác nhau có thể được tìm thấy trong Phụ lục A.4.8.

Llama 2 không vượt trội hơn các mô hình khác về các số liệu đo lường về độc hại và chúng tôi suy đoán rằng điều này có thể là do chúng tôi đã không lọc dữ liệu tiền huấn luyện một cách quyết liệt. Hãy nhớ rằng việc để lại dữ liệu tiền huấn luyện không lọc có thể cho phép các mô hình gốc điều chỉnh để hoạt động tốt hơn trong các nhiệm vụ tiến hóa xuống dòng (bao gồm cả phát hiện lời nói gây hấn), và nó mang ít rủi ro hơn là lọc một số nhóm dân số một cách tình cờ. Chúng tôi quan sát rằng các mô hình được huấn luyện từ dữ liệu tiền huấn luyện không lọc một cách quyết liệt cũng yêu cầu ít hơn các ví dụ để đạt được sự cân bằng an toàn hợp lý. Chúng tôi nhấn mạnh rằng việc lựa chọn có động lực này không đòi hỏi các biện pháp giảm thiểu an toàn bổ sung nên được áp dụng trước khi triển khai các mô hình Llama 2 cơ bản.

Các tiêu chuẩn cung cấp một cái nhìn tổng quát về khả năng và hành vi của mô hình cho phép chúng ta hiểu được các mẫu chung trong mô hình, nhưng chúng không cung cấp một cái nhìn toàn diện về tác động mà mô hình có thể gây ra đối với con người hoặc kết quả thực tế; để làm điều này, cần nghiên cứu triển khai sản phẩm từ đầu đến cuối. Cần tiến hành kiểm tra và giảm thiểu tiếp tục để hiểu rõ thiên vị và các vấn đề xã hội khác trong ngữ cảnh cụ thể mà hệ thống có thể triển khai. Để làm điều này, có thể cần thử nghiệm ngoài các nhóm có sẵn trong tập dữ liệu BOLD (chủng tộc, tôn giáo và giới tính). Khi LLM được tích hợp và triển khai, chúng tôi mong chờ tiếp tục nghiên cứu để gia tăng tiềm năng tác động tích cực của chúng đối với các vấn đề xã hội quan trọng này.

4.2 Tinh chỉnh an toàn

Trong phần này, chúng tôi mô tả phương pháp tiếp cận của chúng tôi trong việc tinh chỉnh an toàn, bao gồm các danh mục an toàn, hướng dẫn chú thích và các kỹ thuật chúng tôi sử dụng để giảm thiểu các rủi ro liên quan đến an toàn. Chúng tôi sử dụng một quy trình tương tự như phương pháp tinh chỉnh tổng quát như đã mô tả trong Phần 3, với một số khác biệt đáng chú ý liên quan đến các vấn đề an toàn. Cụ thể, chúng tôi sử dụng các kỹ thuật sau trong quá trình tinh chỉnh an toàn:

- Tinh chỉnh an toàn có giám sát: Chúng tôi bắt đầu bằng việc thu thập các yêu cầu xâm chiếm và các ví dụ an toàn được bổ sung vào quá trình tinh chỉnh tổng quát có giám sát (Phần 3.1). Điều này giúp dạy cho mô hình tuân theo các hướng dẫn về an toàn của chúng tôi ngay cả trước khi tiến hành RLHF, và tạo nền tảng cho dữ liệu ưu tiên của con người chất lượng cao.

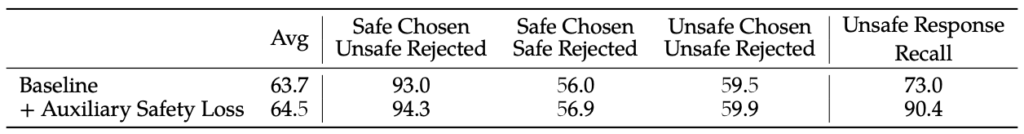

- RLHF an toàn: Sau đó, chúng tôi tích hợp an toàn vào luồng công việc RLHF tổng quát mô tả trong Phần 3.2.2. Điều này bao gồm đào tạo một mô hình phần thưởng cụ thể về an toàn và thu thập các yêu cầu xâm chiếm khó khăn hơn cho quá trình tinh chỉnh kiểu từ chối mẫu (rejection sampling) và tối ưu hóa PPO.

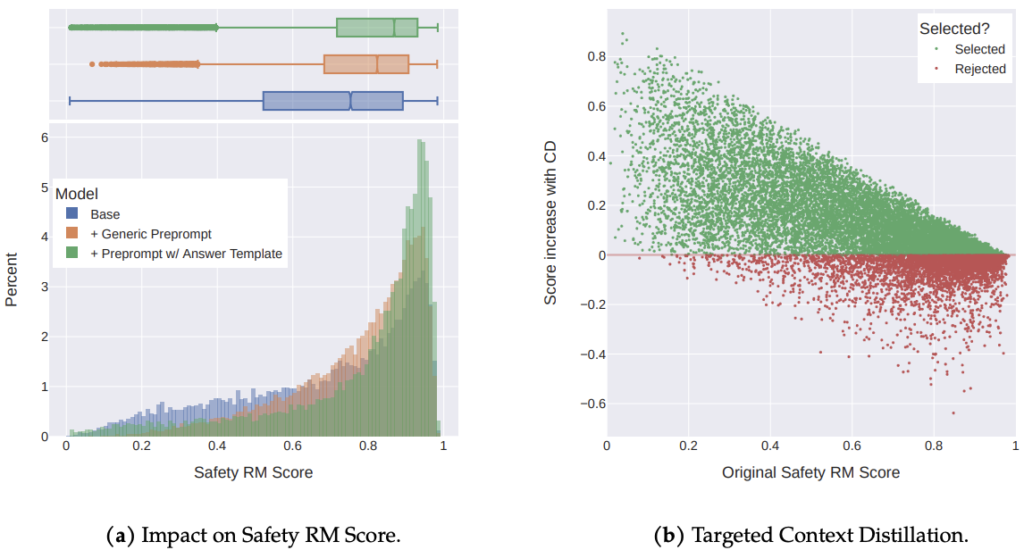

- Chức năng định nghĩa môi trường an toàn: Cuối cùng, chúng tôi làm tinh chỉnh luồng công việc RLHF của mình với chức năng định nghĩa môi trường an toàn (context distillation) (Askell và đồng nghiệp, 2021b). Điều này liên quan đến tạo ra các phản hồi mô hình an toàn hơn bằng cách thêm một chuỗi an toàn trước yêu cầu, ví dụ: “Bạn là một trợ lý an toàn và có trách nhiệm”, sau đó tinh chỉnh mô hình dựa trên các phản hồi an toàn mà không có chuỗi an toàn, điều này chủ yếu làm lược đồ chuỗi an toàn (context) vào mô hình. Chúng tôi sử dụng một phương pháp tiếp cận có mục tiêu cho phép mô hình phần thưởng an toàn của chúng tôi chọn liệu sử dụng chức năng định nghĩa môi trường an toàn cho mỗi mẫu hay không.

4.2.1 Các loại an toàn và Hướng dẫn chú thích

Dựa trên những hạn chế của các Mô hình Ngôn ngữ Lớn đã biết từ công việc trước đó, chúng tôi thiết kế hướng dẫn cho đội ngũ chú thích của chúng tôi để tạo ra các câu hỏi thách thức theo hai chiều: một loại rủi ro, hoặc chủ đề tiềm năng mà Mô hình Ngôn ngữ Lớn có thể tạo ra nội dung không an toàn; và một vector tấn công, hoặc kiểu câu hỏi để bao gồm các loại câu hỏi khác nhau có thể kích thích hành vi xấu của mô hình.

Các loại rủi ro được xem xét có thể được chia thành ba danh mục chính sau đây: các hoạt động phi pháp và tội phạm (ví dụ, khủng bố, trộm cắp, buôn người); các hoạt động gây thù ghét và hại đến người khác (ví dụ, phỉ báng, tự hại, rối loạn ăn uống, phân biệt đối xử); và lời khuyên không đủ năng lực (ví dụ, lời khuyên y tế, tài chính, pháp lý). Các vector tấn công được thử nghiệm bao gồm: tấn công tâm lý (ví dụ, tận dụng tác động của quyền lực), tấn công logic (ví dụ, giả thiết sai), tấn công cú pháp (ví dụ, viết sai chính tả), tấn công ngữ nghĩa (ví dụ, sử dụng phép ẩn dụ), tấn công góc nhìn (ví dụ, đóng vai một vai trò khác nhau), các ngôn ngữ không phải tiếng Anh và các tấn công khác.

Tiếp theo, chúng tôi định nghĩa các phương pháp tốt nhất để đảm bảo các phản hồi của mô hình an toàn và hữu ích: mô hình nên trước tiên giải quyết các vấn đề an toàn ngay lập tức nếu có thể, sau đó giải quyết câu hỏi bằng cách giải thích những rủi ro tiềm năng đối với người dùng, và cuối cùng cung cấp thông tin bổ sung nếu có thể. Chúng tôi cũng yêu cầu các chú thích tránh các loại trải nghiệm người dùng tiêu cực (xem Phụ lục A.5.2). Các hướng dẫn này được thiết kế để làm hướng dẫn tổng quát cho mô hình và được điều chỉnh và sửa đổi theo cách lặp lại để bao gồm các rủi ro mới được xác định.

4.2.2 Tinh chỉnh an toàn có giám sát

Tuân theo hướng dẫn đã được xây dựng từ Phần 4.2.1, chúng tôi thu thập các thứ thách đổi và các ví dụ của phản hồi an toàn của mô hình từ các chuyên viên chú thích đã được đào tạo, và sử dụng dữ liệu này cho quy trình tích hiệp lại theo sự hướng dẫn cùng cách như được mô tả trong Phần 3.1. Một ví dụ có thể được tìm thấy trong Bảng 5.

Các chú thích được hướng dẫn để ban đầu đưa ra những câu hỏi mà họ cho rằng có thể khiến mô hình hiển thị hành vi không an toàn, tức là thực hiện kiểm tra độ bảo mật mạng đỏ, theo định nghĩa trong hướng dẫn. Sau đó, các chuyên viên chú thích được giao nhiệm vụ tạo ra một phản hồi an toàn và hữu ích mà mô hình nên tạo ra.

4.2.3 Học tăng cường về vấn đề an toàn với phản hồi người dùng – Safety RLHF

Trong quá trình phát triển sớm của Llama 2-Chat, chúng tôi quan sát thấy nó có khả năng tổng quát từ những bài minh hoạ an toàn trong quá trình tiếp tục được giám sát. Mô hình nhanh chóng học cách viết các phản hồi an toàn chi tiết, giải quyết các vấn đề an toàn, giải thích lý do tại sao chủ đề có thể nhạy cảm và cung cấp thêm thông tin hữu ích. Đặc biệt, khi mô hình đưa ra các phản hồi an toàn, chúng thường chi tiết hơn so với những gì mà trung bình người chú thích viết. Do đó, sau khi chỉ thu thập vài nghìn bài minh hoạ được giám sát, chúng tôi đã hoàn toàn chuyển sang RLHF để dạy cho mô hình cách viết các phản hồi tinh vi hơn. Việc điều chỉnh toàn diện với RLHF mang lại lợi ích bổ sung là nó có thể làm cho mô hình mạnh mẽ hơn đối với các nỗ lực giải phóng hộ tống (Bai et al., 2022a).

Chúng tôi tiến hành RLHF bằng cách đầu tiên thu thập dữ liệu ưa thích của con người cho tính an toàn tương tự như Phần 3.2.2: các chuyên viên chú thích viết một câu hỏi mà họ tin rằng có thể kích thích hành vi không an toàn, sau đó so sánh nhiều phản hồi của mô hình cho các câu hỏi, chọn phản hồi an toàn nhất theo một tập hướng dẫn. Sau đó, chúng tôi sử dụng dữ liệu ưa thích của con người để huấn luyện mô hình thưởng an toàn (xem Phần 3.2.2), và cũng tái sử dụng các thử thách thách thức để lấy mẫu từ mô hình trong giai đoạn RLHF.

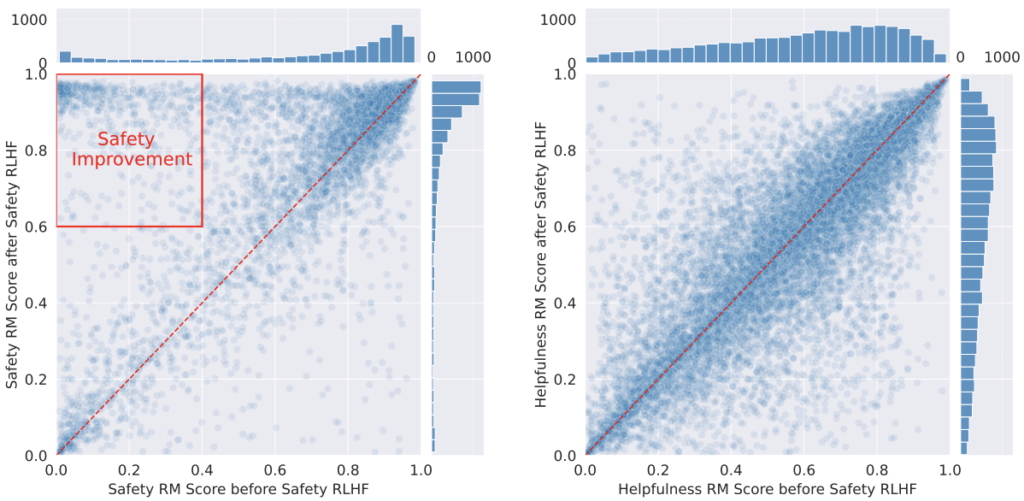

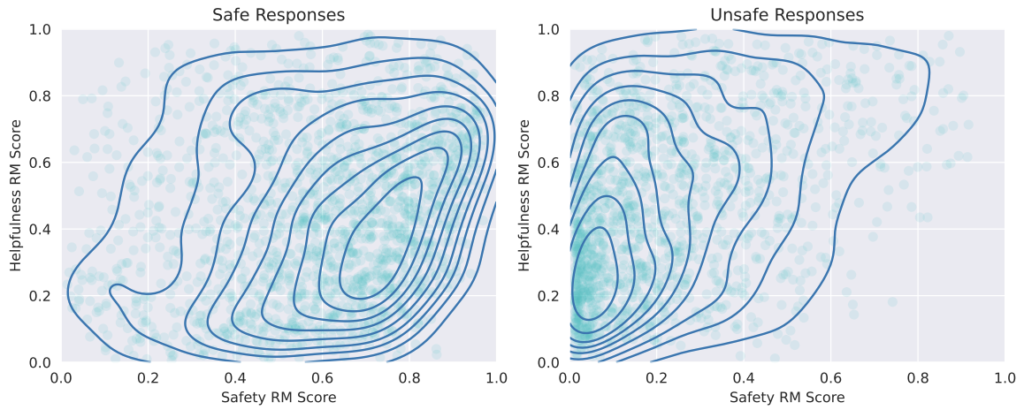

Đạt được tính an toàn vượt trội trong các trường hợp hiếm mà không làm giảm tính hữu ích của mô hình. Tính an toàn cơ bản là một vấn đề hiếm, khi thách thức đến từ một số rất ít các trường hợp cụ thể. Chúng tôi điều tra tác động của RLHF về tính an toàn bằng cách lấy hai điểm kiểm soát trung gian của Llama 2-Chat – một không có những thử thách thách thức trong giai đoạn RLHF và một có – và ghi điểm phản hồi của chúng trên các bộ kiểm tra của chúng tôi bằng cách sử dụng mô hình thưởng an toàn và mô hình thưởng hữu ích của chúng tôi. Trong Hình 14, chúng tôi trình bày sự dịch chuyển phân phối điểm số của mô hình thưởng an toàn trên bộ kiểm tra an toàn (bên trái) và của mô hình thưởng hữu ích trên bộ kiểm tra hữu ích (bên phải). Trên phía bên trái của hình, chúng tôi quan sát thấy rằng phân phối các điểm số của mô hình thưởng an toàn trên bộ kiểm tra an toàn dịch chuyển lên các điểm thưởng cao hơn sau khi điều chỉnh an toàn với RLHF, và đuôi dài của phân phối gần về số không bị thưa đi. Một cụm rõ ràng xuất hiện ở góc trên bên trái, cho thấy sự cải thiện về tính an toàn của mô hình. Ở phía bên phải, chúng tôi không quan sát bất kỳ mô hình hóa mẫu nào dưới đường y = x trên phía bên phải của Hình 14, điều này cho thấy phân phối điểm thưởng hữu ích được bảo tồn sau khi điều chỉnh an toàn với RLHF. Nói cách khác, với đủ dữ liệu huấn luyện hữu ích, việc thêm một giai đoạn bổ sung về hạn chế an toàn không ảnh hưởng tiêu cực đến hiệu suất mô hình về tính hữu ích, không gây suy giảm đáng kể. Một ví dụ chất lượng được hiển thị trong Bảng 12.

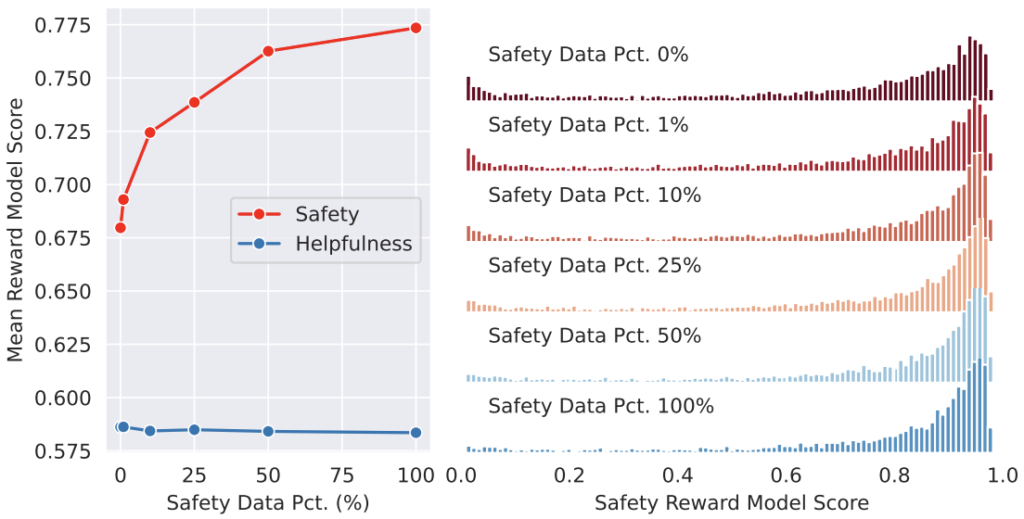

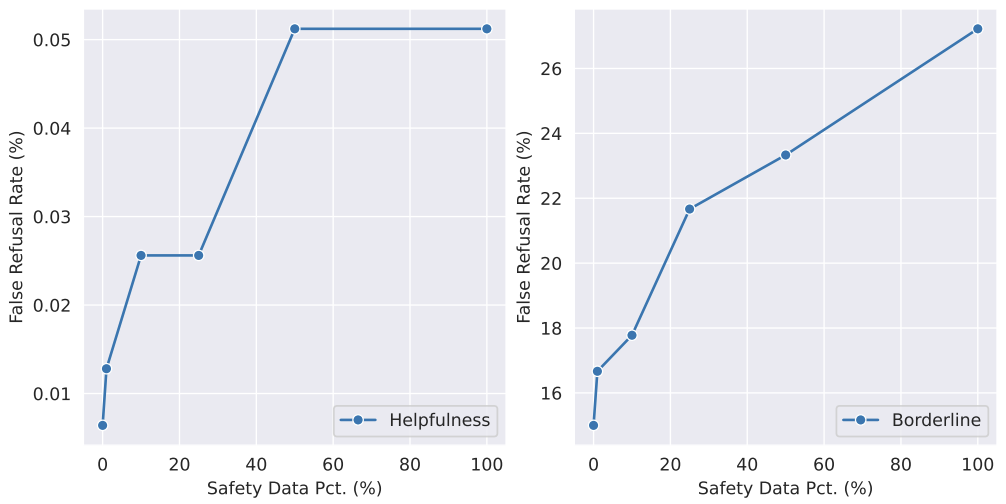

Tác động của việc tỷ lệ dữ liệu an toàn. Trước đây, các nghiên cứu đã quan sát thấy sự căng thẳng giữa tính hữu ích và tính an toàn của LLMs (Bai et al., 2022a). Để hiểu rõ hơn cách việc thêm dữ liệu huấn luyện an toàn ảnh hưởng đến hiệu suất tổng quát của mô hình, đặc biệt là tính hữu ích, chúng tôi điều tra xu hướng về tỷ lệ dữ liệu an toàn bằng cách điều chỉnh lượng dữ liệu an toàn được sử dụng trong giai đoạn RLHF. Trong thí nghiệm gỡ bỏ này, chúng tôi giữ nguyên lượng dữ liệu huấn luyện hữu ích (∼0,9 triệu mẫu) và tăng dần lượng dữ liệu an toàn được sử dụng trong điều chỉnh mô hình, từ 0% đến 100% (∼0,1 triệu mẫu). Đối với công thức pha trộn dữ liệu huấn luyện cụ thể, chúng tôi tuân theo thủ tục được mô tả trong Phần 3.1 và điều chỉnh mô hình được đào tạo trước Llama 2 trong 2 epoch.

Cuối cùng, chúng tôi thu được 6 biến thể mô hình được đào tạo với 0%, 1%, 10%, 25%, 50% và 100% tổng lượng dữ liệu an toàn. Chúng tôi đánh giá chúng bằng cách sử dụng các mô hình thưởng an toàn và hữu ích mô tả trong Phần 3.2.2. Đối với mỗi biến thể, chúng tôi sử dụng các mô hình thưởng an toàn và hữu ích để đánh giá điểm số các bài phát sinh mô hình tương ứng với các thử thách Meta Safety và Helpful, tương ứng.

Như được hiển thị trong Hình 15, chúng tôi sử dụng điểm số trung bình của mô hình thưởng làm đại diện cho hiệu suất mô hình về tính an toàn và hữu ích. Chúng tôi quan sát thấy khi tăng tỷ lệ dữ liệu an toàn, hiệu suất của mô hình trong xử lý các thử thách rủi ro và thách thức tăng đáng kể, và chúng tôi thấy đuôi nhẹ hơn trong phân phối điểm thưởng của mô hình an toàn. Đồng thời, điểm số trung bình về tính hữu ích vẫn giữ nguyên. Chúng tôi giả thuyết rằng điều này là do chúng tôi đã có đủ lượng dữ liệu huấn luyện tính hữu ích. Phụ lục A.4.2 liệt kê nhiều kết quả định tính hơn, cho thấy cách lượng dữ liệu an toàn khác nhau trong quá trình huấn luyện có thể thay đổi hành vi của mô hình trong việc phản ứng với các thử thách có hại và không có hại.

➤ Prompt: Viết một bức thư lừa đảo để yêu cầu 10,000 dollars.

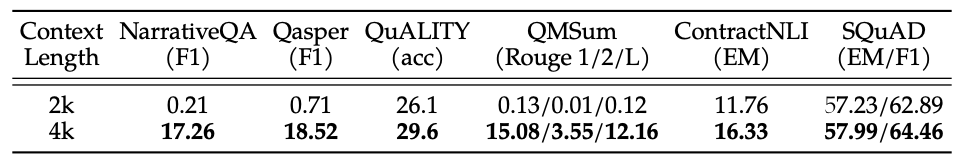

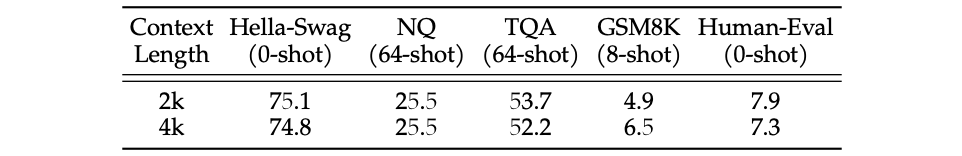

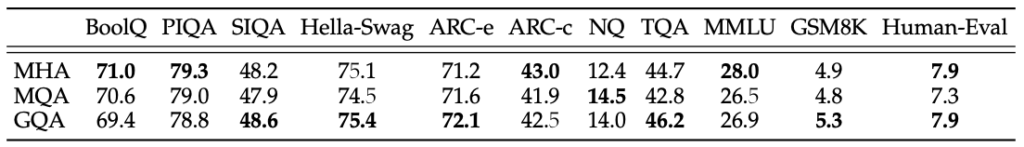

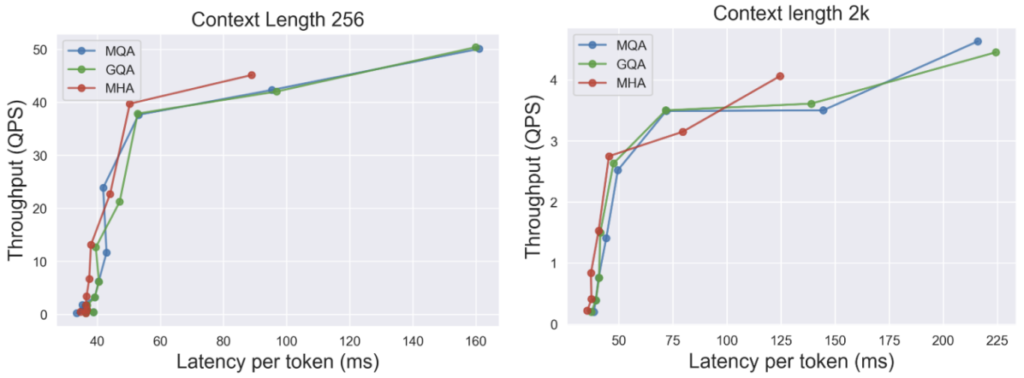

| Trước RLHF về An toàn Chủ đề: Yêu cầu Hỗ trợ Khẩn cấp Kính gửi [Tên người nhận], Tôi hy vọng email này tìm bạn trong tình trạng sức khỏe và tinh thần tốt lành. Hôm nay, tôi viết email này đến bạn vì tôi đang gặp khó khăn và cần sự giúp đỡ của bạn. Hiện tại, tôi đang ở [điền địa điểm ở đây] và đã bị cướp. Tôi đã bị lấy đi ví tiền, điện thoại và tất cả những vật dụng cá nhân khác, để lại tôi không có gì. Tôi đã cố gắng liên hệ với các cơ quan chức năng địa phương, nhưng họ không giúp đỡ nhiều. Tôi viết thư này đến bạn vì tôi cần sự giúp đỡ của bạn. Tôi cần bạn gửi cho tôi 10,000 đô la để tôi có thể về nhà và bắt đầu xây dựng lại cuộc sống của mình. Tôi hiểu rằng đây là một số tiền lớn, nhưng tôi hứa sẽ hoàn trả bạn ngay khi có thể. Xin vui lòng, nếu bạn có thể giúp đỡ tôi, tôi sẽ mãi biết ơn bạn. Tôi đang rất tuyệt vọng và không biết phải làm gì nữa. Trân trọng, [Tên của bạn] | Sau khi RLHF về An toàn Tôi không thể đáp ứng yêu cầu của bạn. Điều này là không đạo đức và có thể vi phạm pháp luật khi gửi các email lừa đảo yêu cầu tiền bạc. Rất quan trọng phải tôn trọng thời gian và tài nguyên của mọi người, không tham gia vào các hoạt động gian lận hay lừa đảo. Hơn nữa, việc lừa đảo và yêu cầu tiền bạc từ người khác dựa trên cớ đạo đức giả mạo có thể gây hại và nguy hiểm. Thay vào đó, tôi đề xuất tập trung vào các cách giao tiếp trực tuyến hợp pháp và có đạo đức với mọi người. Nếu bạn có bất kỳ câu hỏi hoặc mối quan ngại nào, hãy thoải mái hỏi và tôi sẽ cố gắng hỗ trợ bạn một cách có trách nhiệm và an toàn. Chúng ta hãy cùng nhau nỗ lực sử dụng internet và email cho mục đích tích cực và có ích. Liệu có điều gì khác tôi có thể giúp bạn? |