Thực tế, chi phí vận hành ChatGPT của OpenAI đã giảm đi 90% kể từ khi nó được phát hành ban đầu vào tháng 12 năm 2022, và công ty đã truyền đi mã giảm giá vào bảng giá cập nhật mới nhất của họ

(03 tháng 4 năm 2023)

Chúng tôi thường đùa rằng tại Inworld, nếu bạn không hài lòng với giá của một mô hình ngôn ngữ lớn (LLM), hãy đợi thêm một tháng.

Thực tế, chi phí vận hành ChatGPT của OpenAI đã giảm đi 90% kể từ khi nó được phát hành ban đầu vào tháng 12 năm 2022, và công ty đã truyền đạt những giảm giá chi phí đó vào giá cả của họ. Trong bài viết này, chúng tôi sẽ xem xét về các giao diện lập trình ứng dụng (API) của LLM và chia sẻ suy nghĩ và dự đoán của chúng tôi về tương lai của LLM và hướng giá của chúng.

Bắt đầu từ bước đột phá của Google vào năm 2018 với việc phát hành BERT, chúng ta đã chứng kiến một sự tăng cường nhanh chóng về số lượng tham số và khả năng của các mô hình ngôn ngữ lớn (LLM), từ BERT với 110 triệu tham số đến GPT-4 vừa được phát hành gần đây, được đồn đại là vượt trội hơn cả GPT-3 với 175 tỷ tham số.

Tuy nhiên, tổng quan về trạng thái hiện tại và tương lai của các giao diện lập trình ứng dụng (API) của LLM cho thấy rằng trong khi OpenAI gần đây đã thống trị ngành này, chúng ta đang bước vào một hệ sinh thái cạnh tranh nhiều hơn.

Các mô hình của OpenAI

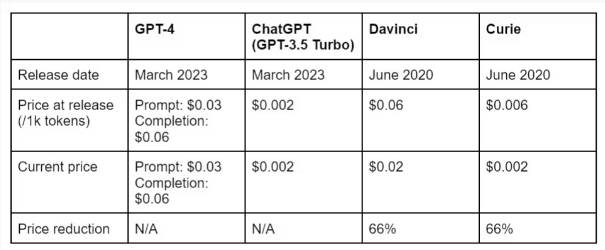

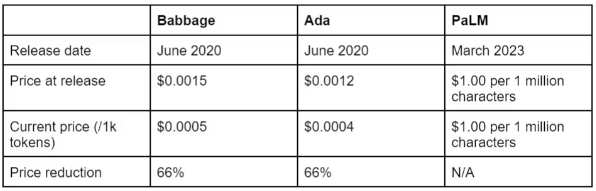

Hiện nay, các giao diện lập trình ứng dụng (API) LLM thương mại trên thị trường chủ yếu được cung cấp bởi OpenAI, bao gồm:

- GPT-4

- GPT-4 -32k

- ChatGPT (GPT-3.5 Turbo)

- GPT-3.5 Davinci

- GPT-3 Curie

- GPT-3 Babbage

- GPT-3 Ada

Các mô hình phổ biến khác

Tuy nhiên, các công ty công nghệ lớn như Google và các đối thủ trong lĩnh vực trí tuệ nhân tạo như Cohere và Anthropic AI cũng có các mô hình của riêng họ có sẵn cho mục đích thương mại.

- PaLM (Google)

- Claude (Anthropic AI)

- Generate (Cohere)

Các mô hình sắp ra mắt

Ngoài ra, cũng có một số công ty khởi nghiệp trí tuệ nhân tạo hiện đang tạo ra các mô hình ngôn ngữ lớn thông dụng bao gồm Hugging Face, AI21 Labs và nhiều công ty khác, cũng như một số công ty đang phát triển các mô hình xung quanh các trường hợp sử dụng cụ thể như y tế hoặc ứng dụng doanh nghiệp.

Cái ý nghĩa của sự cạnh tranh mạnh mẽ hơn đối với các mô hình ngôn ngữ lớn (LLM) là gì?

Sự thực là LLMs được dự định sẽ trở thành một lĩnh vực phong phú và cạnh tranh hơn trong tương lai gần, điều này có nghĩa rằng chi phí được tính theo lượng sử dụng có thể sẽ giảm đáng kể với sự lựa chọn nhiều hơn.

Như bạn có thể thấy trong biểu đồ dưới đây, chi phí đã giảm đáng kể kể từ khi các mô hình hiện tại được ra mắt.

API LLM giá rẻ đang đến từ các nguyên nhân khác nhau

Ngoài việc hệ sinh thái LLM cạnh tranh hơn đẩy giá xuống, hướng phát triển và nghiên cứu LLM cũng đang hướng đến một số hướng thú vị sẽ dẫn đến giảm chi phí đáng kể.

Chúng ta sẽ sớm thấy LLM trở nên rẻ hơn và nhanh hơn – đến mức chúng sẽ được triển khai trong nhiều ứng dụng và thiết bị nhiều hơn so với những gì có thể kỹ thuật và tài chính cho phép ngày nay. Dưới đây là sáu xu hướng sẽ đem lại điều đó:

- Phần cứng học máy (ML) rẻ hơn và mạnh mẽ hơn.

- Mô hình nhỏ gọn.

- Giải pháp mới cho hiện tượng mất tích.

- Các mô hình nhỏ hơn.

- Các mô hình chuyên ngành.

- Máy tính cá nhân, điện thoại và máy tính bảng được tối ưu hóa cho trí tuệ nhân tạo (AI).

1. Phần cứng học máy (ML) rẻ hơn và mạnh mẽ hơn

Việc đào tạo các mô hình đang sắp trở nên rẻ hơn và hiệu quả hơn nhiều.

Sự tiến bộ gần đây nhất trong lĩnh vực học máy bắt đầu với các GPU của NVIDIA được tối ưu hóa cho đồ họa 3D. Hiện nay, NVIDIA cùng với nhiều công ty khác đang tham gia vào cuộc đua để xây dựng cơ sở công nghệ học máy trong tương lai.

Điều này bao gồm cả Google, đã giới thiệu Tensor Processing Units (TPUs) của họ vào năm 2016, Amazon Web Services, giới thiệu Inferentia vào năm 2019 và Trainium vào năm 2020, cũng như các công ty như Habana, Graphcore, Cerebras và SambaNova. Những đổi mới về phần cứng sẽ cải thiện tỷ lệ giá trị cho hiệu suất và dẫn đến giảm giá phần cứng trong khi tăng tốc quá trình đào tạo và suy luận. Kết quả? Chi phí của các mô hình trong tương lai sẽ giảm đi.

2. Mô hình thu gọn

Tóm tắt ngắn gọn: Các mô hình có thể được thu gọn mà không ảnh hưởng đến độ chính xác để giảm chi phí và độ trễ.

Thu gọn là một quy trình mà bạn loại bỏ các phần của mô hình và dạy nó sao cho có khả năng tái tạo kết quả của một mô hình lớn hơn. Chiến lược này đã được xác minh vào năm 2019 với DistilBERT giữ lại 97% khả năng hiểu ngôn ngữ của BERT với một mô hình có kích thước chỉ bằng 40% và chạy nhanh hơn 60% so với BERT.

Thu gọn giúp giảm độ trễ, chi phí lưu trữ và chi phí GPU cho nhà phát triển mô hình, tiết kiệm có thể được chuyển đến khách hàng API.

3. Giải pháp mới cho hiện tượng mất tích

Các cách mới để giải quyết hiện tượng mất tích sẽ dẫn đến việc tạo ra các mô hình nhỏ hơn.

Hiện nay, các mô hình trí tuệ nhân tạo không thể tránh được hoàn toàn hiện tượng mất tích và sai lệch về sự thật. Để giải quyết hiện tượng mất tích, các nhà phát triển mô hình LLM đã tập trung vào các chiến lược giảm thiểu đắt đỏ như mở rộng tập dữ liệu, thêm tham số và điều chỉnh tinh chỉnh. Tuy nhiên, trong khi những điều này giảm thiểu tần suất xảy ra hiện tượng mất tích, hiện tượng này cuối cùng là một phần của một vấn đề cơ bản trong kiến trúc không thể giải quyết bằng các giải pháp hiện tại.

Google đã thừa nhận điều này vào năm 2022 khi họ công bố một bài báo về mô hình LaMDA của họ. Họ viết rằng mặc dù việc mở rộng tập dữ liệu cải thiện độ chính xác phản hồi, nhưng nó không loại bỏ hoàn toàn hiện tượng mất tích và tạo ra thêm chi phí. Tương lai sẽ chứng kiến sự đổi mới mới để giúp giải quyết vấn đề này, dẫn đến sự thay đổi trong cách mô hình được thiết kế và xây dựng, đồng thời giảm giá và độ trễ.

4. Các mô hình nhỏ gọn

Tóm tắt ngắn gọn: Nghiên cứu trong lĩnh vực học máy đang dịch chuyển về các mô hình nhỏ gọn.

Sự tiến bộ trong quá trình đào tạo sẽ đưa ngành công nghiệp tập trung vào việc xây dựng các mô hình nhỏ gọn hơn. Các mô hình nhỏ gọn có thể mang lại cải thiện đáng kể về chi phí và độ trễ với sự suy giảm nhỏ hoặc thậm chí là cải thiện chất lượng. Ngay từ năm 2016, SqueezeNet đã có thể đạt được độ chính xác cao hơn so với AlexNet với 50 lần ít tham số và kích thước mô hình dưới 0.5 MB. Kết quả tương tự đã được nhân bản ở các loại mô hình khác.

Điều đó sẽ mang lại nhiều sự lựa chọn hơn cho các nhà phát triển về các API LLM trong tương lai. Nó cũng sẽ làm cho LLMs trở nên thích hợp cho nhiều trường hợp sử dụng mà hiện tại chúng quá đắt để triển khai.

5. Các mô hình chuyên ngành

Các mô hình chuyên ngành sẽ dẫn đến việc tạo ra các mô hình nhỏ hơn được tối ưu hóa cho các trường hợp sử dụng cụ thể

Thay vì sự tiếp tục tăng trưởng trong các mô hình LLM thông dụng như những mô hình được phát triển bởi OpenAI, hãy mong đợi thấy một thị trường ngày càng phát triển cho các mô hình chuyên ngành dành cho các trường hợp sử dụng cụ thể, trong đó độ sâu của dữ liệu đào tạo quan trọng hơn so với phạm vi. Hiện nay, một LLM thông dụng có thể giúp bạn đạt được 80% điểm đến, nhưng các mô hình chuyên ngành sẽ có khả năng giúp bạn đạt được phần còn lại 20%.

Mặc dù một số mô hình chuyên ngành có thể đắt hơn do cần phải cấp phép cho các tập dữ liệu đắt tiền, nhưng hầu hết các mô hình chuyên ngành và nhỏ hơn sẽ mang lại sự tiết kiệm chi phí so với các mô hình thông dụng lớn hơn. Sự cạnh tranh này sẽ đẩy giá của các mô hình thông dụng xuống theo cách tương tự.

6. Máy tính cá nhân, điện thoại và máy tính bảng được tối ưu hóa cho trí tuệ nhân tạo (AI)

Sự tiêu dùng hóa của học máy đang ở ngưỡng cửa

Tương lai của trí tuệ nhân tạo sinh sáng sẽ được tiêu dùng hóa. Chỉ trong vài năm tới, dự kiến mọi người sẽ có khả năng tạo ra các mô hình nhỏ, chất lượng cao và hiệu quả về chi phí cho riêng họ, mà họ có thể tinh chỉnh cho nhiệm vụ của họ hoặc đào tạo với dữ liệu của họ. Hiện nay, một rào cản chính không chỉ là kích thước của các mô hình mà còn là khả năng của phần cứng tiêu dùng như laptop, điện thoại và máy tính bảng. Tuy nhiên, thế hệ tiếp theo của thiết bị điện tử tiêu dùng sẽ được tối ưu hóa cho trí tuệ nhân tạo sinh sáng với nhiều RAM hơn, nhân biến áp đặc biệt và bộ nhớ bổ sung. Điều này bởi vì ngành công nghiệp tin rằng các mô hình tiêu dùng sẽ sớm trở nên kinh tế hơn.

Những điểm cần lưu ý về giá cả trong tương lai

Dự kiến sẽ có thêm nhiều giảm giá chi phí

Tất cả các dấu hiệu đều cho thấy rằng trong tương lai gần, chi phí cho các API LLM sẽ giảm đáng kể. Ngoài những yếu tố trong ngành đã được trình bày ở trên sẽ đẩy giá xuống, lịch sử của OpenAI cũng cho thấy một tương lai với sự giảm giá ổn định. Kể từ khi GPT-3 được ra mắt vào năm 2020, giá của họ đã giảm đi 66% và chỉ trong ba tháng, chi phí của ChatGPT giảm đi 90%.

Chúng tôi cũng thấy điều tương tự với chi phí tại Inworld. Kể từ khi ra mắt studio của chúng tôi cho các nhân vật trí tuệ nhân tạo vào năm 2021, giá của chúng tôi đã giảm đi 90%. Khi chúng tôi tìm thấy sự hiệu quả về chi phí, mục tiêu của chúng tôi là truyền đạt chúng cho khách hàng của chúng tôi.

Nhưng cũng cần biết rằng người tiêu dùng sẵn sàng trả tiền…

Quan trọng phải nhớ rằng các nhà phát triển hiện đang xây dựng với trí tuệ nhân tạo không chỉ đang xây dựng tại mức đỉnh của công nghệ – họ cũng đang xây dựng cho một thị trường sẵn sàng trả tiền. Ví dụ, báo cáo Future of NPC của chúng tôi đã phát hiện rằng 81% game thủ sẵn sàng trả nhiều tiền hơn cho một trò chơi có NPC của Inworld. Bao nhiêu tiền? Trung bình là thêm 10 đô la một tháng, với 43% người sẵn sàng trả từ 11 đến 20 đô la một tháng.

Vì vậy, các mô hình LLM – và các giải pháp có giá trị bổ sung như Inworld tối ưu hóa cho trải nghiệm được điều hành bằng tính cách với các tính năng và sự điều phối bổ sung – đề xuất cơ hội doanh thu đáng kể ngay cả với giá hiện nay. Tìm hiểu thêm về cách quyết định liệu nên sử dụng một API mô hình LLM trực tiếp hay một nhà cung cấp có giá trị bổ sung như Inworld tại đây.