Tác giả: Alex McFarland

ngày 24 tháng 04 năm 2024

Microsoft đã giới thiệu Phi-3, một dòng mô hình ngôn ngữ nhỏ (SLMs) mới nhằm mục tiêu mang lại hiệu suất cao và hiệu quả chi phí trong các ứng dụng AI. Những mô hình này đã cho thấy kết quả mạnh mẽ qua các chỉ số đánh giá trong việc hiểu ngôn ngữ, suy luận, lập trình và toán học so với các mô hình cùng kích thước và lớn hơn. Việc ra mắt Phi-3 mở rộng các lựa chọn có sẵn cho các nhà phát triển và doanh nghiệp muốn tận dụng AI trong khi cân nhắc hiệu suất và chi phí.

Dòng Mô Hình Phi-3 và Sự Sẵn Sàng

Mô hình đầu tiên trong dòng sản phẩm Phi-3 là Phi-3-mini, một mô hình có 3.8 tỷ tham số hiện đã có sẵn trên Azure AI Studio, Hugging Face và Ollama. Phi-3-mini đã được điều chỉnh chỉ dẫn, cho phép sử dụng “ngay từ hộp” mà không cần điều chỉnh tinh chỉnh chi tiết. Nó có cửa sổ ngữ cảnh lên đến 128K mã thông báo, dài nhất trong các lớp kích thước của nó, cho phép xử lý đầu vào văn bản lớn hơn mà không làm giảm hiệu suất.

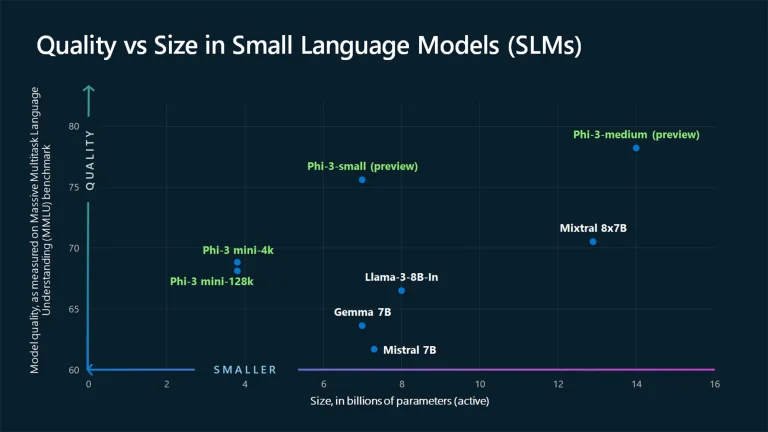

Để tối ưu hiệu suất trên các thiết lập phần cứng khác nhau, Phi-3-mini đã được điều chỉnh tinh chỉnh cho ONNX Runtime và GPU NVIDIA. Microsoft dự định sớm mở rộng dòng sản phẩm Phi-3 với việc ra mắt Phi-3-small (7 tỷ tham số) và Phi-3-medium (14 tỷ tham số). Các mô hình bổ sung này sẽ cung cấp một loạt các lựa chọn để đáp ứng nhu cầu và ngân sách đa dạng.

Hiệu Suất và Phát Triển của Phi-3

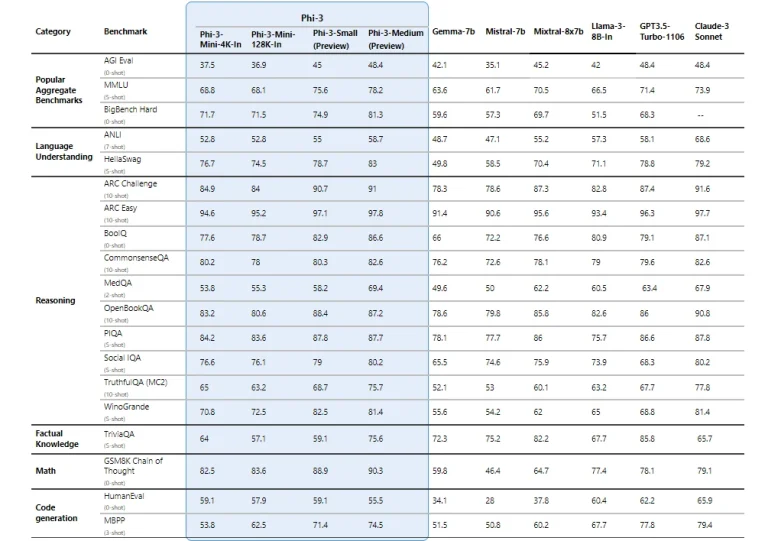

Microsoft báo cáo rằng các mô hình Phi-3 đã thể hiện sự cải thiện đáng kể về hiệu suất so với các mô hình cùng kích thước và thậm chí là các mô hình lớn hơn qua các chỉ số đánh giá khác nhau. Theo công ty, Phi-3-mini đã vượt qua các mô hình gấp đôi kích thước của nó trong các nhiệm vụ hiểu và tạo ngôn ngữ, trong khi Phi-3-small và Phi-3-medium đã vượt qua các mô hình lớn hơn nhiều, như GPT-3.5T, trong một số đánh giá nhất định.

Microsoft khẳng định rằng việc phát triển các mô hình Phi-3 đã tuân theo các nguyên tắc và tiêu chuẩn AI có trách nhiệm của công ty, nhấn mạnh về sự chịu trách nhiệm, minh bạch, công bằng, đáng tin cậy, an toàn, riêng tư, bảo mật và tính bao gồm. Các mô hình được báo cáo đã trải qua quá trình huấn luyện, đánh giá và đội ngũ thử nghiệm để đảm bảo tuân thủ các quy tắc triển khai AI có trách nhiệm.

Ứng Dụng và Tiềm Năng của Phi-3

Gia đình Phi-3 được thiết kế để xuất sắc trong các tình huống nơi tài nguyên bị hạn chế, thời gian chờ đợi thấp là cần thiết, hoặc tính hiệu quả chi phí là ưu tiên. Những mô hình này có tiềm năng để cho phép suy luận trên thiết bị, cho phép các ứng dụng được cung cấp sức mạnh bởi AI chạy hiệu quả trên một loạt các thiết bị, bao gồm cả những thiết bị có công suất tính toán hạn chế. Kích thước nhỏ của các mô hình Phi-3 cũng có thể làm cho việc tinh chỉnh và tùy chỉnh trở nên phải chăng hơn đối với các doanh nghiệp, giúp họ điều chỉnh các mô hình cho các trường hợp sử dụng cụ thể của họ mà không gây ra chi phí cao.

Trong các ứng dụng nơi thời gian phản hồi nhanh là quan trọng, các mô hình Phi-3 cung cấp một giải pháp hứa hẹn. Kiến trúc được tối ưu hóa và xử lý hiệu quả của chúng có thể kích hoạt việc tạo ra kết quả nhanh chóng, nâng cao trải nghiệm người dùng và mở ra các khả năng cho tương tác AI thời gian thực. Ngoài ra, khả năng suy luận và logic mạnh mẽ của Phi-3-mini làm cho nó phù hợp cho các nhiệm vụ phân tích, như phân tích dữ liệu và tạo ra thông tin.

Khi các ứng dụng thực tế của các mô hình Phi-3 xuất hiện, tiềm năng của những mô hình này để thúc đẩy sự đổi mới và làm cho AI trở nên dễ truy cập hơn trở nên rõ ràng hơn. Gia đình Phi-3 đại diện cho một cột mốc trong việc dân chủ hóa AI, trao quyền cho doanh nghiệp và nhà phát triển để khai thác sức mạnh của các mô hình ngôn ngữ tiên tiến trong khi duy trì hiệu suất và tính hiệu quả chi phí.

Với việc ra mắt Phi-3, Microsoft đã mở rộng ranh giới về những gì có thể thực hiện được với các mô hình ngôn ngữ nhỏ, mở đường cho một tương lai nơi mà AI có thể được tích hợp một cách mạch lạc vào một loạt các ứng dụng và thiết bị thông minh.