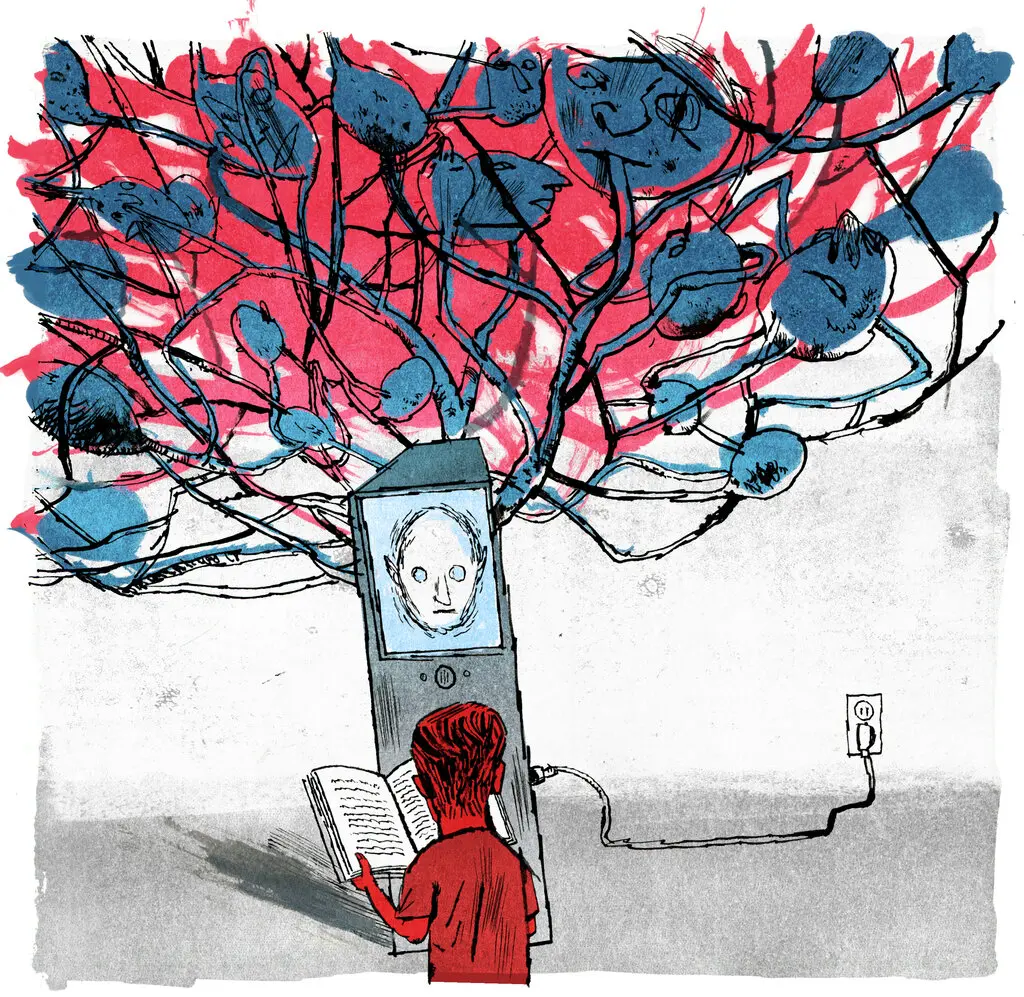

Để hiểu rõ hơn về cách mạng nơ-ron học cách mô phỏng việc viết, các nhà nghiên cứu đã đào tạo các phiên bản đơn giản hơn trên các câu chuyện tổng hợp dành cho trẻ em.

Học tiếng Anh không phải là một công việc dễ dàng, như rất nhiều học sinh biết rõ. Nhưng khi học sinh đó là một máy tính, một phương pháp hoạt động khá hiệu quả: Đơn giản là cung cấp cho nó hàng đống văn bản từ internet vào một mô hình toán học khổng lồ gọi là mạng nơ-ron. Đó là nguyên tắc hoạt động của các mô hình ngôn ngữ sinh ra như ChatGPT của OpenAI, khả năng nói chuyện một cách mạch lạc (dù không phải lúc nào cũng trung thực) trên nhiều chủ đề đã khiến các nhà nghiên cứu và công chúng phải ngạc nhiên trong suốt năm qua.

Tuy nhiên, phương pháp này cũng có nhược điểm của nó. Đầu tiên, quy trình “đào tạo” cần thiết để biến đổi các kho dữ liệu văn bản lớn thành các mô hình ngôn ngữ tiên tiến đòi hỏi chi phí cao và tốn thời gian. Thứ hai, ngay cả những người đào tạo các mô hình ngôn ngữ lớn cũng gặp khó khăn trong việc hiểu rõ cách chúng hoạt động bên trong; điều này lại làm cho việc dự đoán cách chúng có thể thất bại trong nhiều cách trở nên khó khăn.

Đối mặt với những khó khăn này, một số nhà nghiên cứu đã chọn đào tạo các mô hình nhỏ hơn trên các tập dữ liệu nhỏ hơn và sau đó nghiên cứu hành vi của chúng. “Đó giống như việc xác định gen Drosophila so với việc xác định gen con người”, như Ellie Pavlick, một nhà nghiên cứu mô hình ngôn ngữ tại Đại học Brown, đã nói.

Bây giờ, trong một bài báo vừa được đăng trên trang web khoa học trước khi công bố arxiv.org, một cặp nhà nghiên cứu của Microsoft đã giới thiệu một phương pháp mới để đào tạo các mô hình ngôn ngữ nhỏ bé: Đưa chúng lớn lên với một chế độ ăn nghiêm ngặt bằng những câu chuyện dành cho trẻ em.

Các nhà nghiên cứu trong lĩnh vực học máy đã nắm bắt được bài học này. GPT-3.5, mô hình ngôn ngữ lớn mạnh mẽ đứng sau giao diện ChatGPT, có gần 200 tỷ tham số và đã được đào tạo trên một tập dữ liệu bao gồm hàng trăm tỷ từ (OpenAI chưa công bố các con số tương ứng cho phiên bản kế nhiệm GPT-4). Việc đào tạo các mô hình lớn như vậy thường đòi hỏi ít nhất 1.000 bộ xử lý đặc chuyên gọi là GPU chạy song song trong vài tuần liên tiếp. Chỉ có một số ít công ty mới có đủ tài nguyên cần thiết, chưa kể việc đào tạo và so sánh các mô hình khác nhau.

Hai nhà nghiên cứu đã chỉ ra rằng các mô hình ngôn ngữ nhỏ bé hàng nghìn lần nhỏ hơn so với các hệ thống tối tân hiện nay có khả năng nhanh chóng học cách kể các câu chuyện nhất quán và ngữ pháp khi được đào tạo theo cách này. Kết quả của họ gợi ý về các hướng nghiên cứu mới có thể hữu ích cho việc đào tạo các mô hình lớn hơn và hiểu về hành vi của chúng.

“Tôi thấy bài báo này rất có giá trị,” Chandra Bhagavatula, một nhà nghiên cứu mô hình ngôn ngữ tại Viện Nghiên cứu Trí tuệ Nhân tạo Allen tại Seattle, đã nói. “Khái niệm này thật sự rất thú vị.”

Ngày xửa ngày xưa

Các mạng nơ-ron nằm ở trái tim của các mô hình ngôn ngữ là các cấu trúc toán học được lấy cảm hứng từ não người một cách tương đối. Mỗi mạng nơ-ron chứa nhiều nơ-ron nhân tạo được sắp xếp thành các lớp, với các kết nối giữa các nơ-ron trong các lớp liền kề. Hành vi của mạng nơ-ron được điều chỉnh bởi sức mạnh của các kết nối này, được gọi là tham số. Trong một mô hình ngôn ngữ, các tham số này kiểm soát từng từ mô hình có thể tạo ra tiếp theo, dựa trên một đầu vào ban đầu và các từ mà nó đã tạo ra trước đó.

Một mô hình chỉ thực sự “sống” trong quá trình đào tạo, khi nó lặp đi lặp lại so sánh kết quả của nó với văn bản trong tập dữ liệu đào tạo và điều chỉnh các tham số để tăng cường sự tương đồng. Một mạng nơ-ron chưa được đào tạo với các tham số ngẫu nhiên có thể dễ dàng tạo ra từ một vài dòng mã, nhưng nó chỉ sản xuất vô nghĩa. Sau quá trình đào tạo, nó thường có thể tiếp tục văn bản chưa quen thuộc một cách có lý. Các mô hình lớn thường trải qua việc điều chỉnh tinh chỉnh thêm giúp chúng học cách trả lời câu hỏi và tuân theo chỉ dẫn, nhưng hầu hết quá trình đào tạo là để làm chủ dự đoán từ.

Thành công trong dự đoán từ đòi hỏi một mô hình ngôn ngữ phải làm chủ nhiều kỹ năng khác nhau. Ví dụ, các quy tắc về ngữ pháp tiếng Anh cho rằng từ tiếp theo sau từ “going” có thể là “to,” bất kể về chủ đề của văn bản. Ngoài ra, một hệ thống cần kiến thức về sự thật để hoàn thành câu “thủ đô của Pháp là,” và việc hoàn thành một đoạn văn bản chứa từ “not” đòi hỏi một hiểu biết cơ bản về logic.

“Ngôn ngữ gốc rất phức tạp,” Timothy Nguyen, một nhà nghiên cứu học máy tại DeepMind, nói. “Để có thể phát triển các khả năng ngôn ngữ thú vị, mọi người đã phải chuyển sang ‘nhiều dữ liệu là tốt nhất’.”

Ronen Eldan, một nhà toán học đã tham gia vào Microsoft Research vào năm 2022 để nghiên cứu các mô hình ngôn ngữ tạo ra, muốn phát triển một cách rẻ hơn và nhanh chóng hơn để khám phá khả năng của chúng. Cách tự nhiên để thực hiện điều đó là bằng cách sử dụng một tập dữ liệu nhỏ, và điều đó lại đồng nghĩa với việc ông phải đào tạo các mô hình chuyên biệt vào một nhiệm vụ cụ thể, để chúng không phải làm quá nhiều thứ cùng một lúc. Ban đầu, ông muốn đào tạo các mô hình để giải quyết một lớp vấn đề toán học cụ thể, nhưng một buổi chiều, sau khi dành thời gian với con gái 5 tuổi của mình, ông nhận ra rằng các câu chuyện dành cho trẻ em là một sự lựa chọn hoàn hảo.

“Thật sự, ý tưởng đó xuất hiện trong tôi sau khi tôi đọc một câu chuyện cho con,” ông nói.

Để tạo ra các câu chuyện dành cho trẻ em mạch lạc, một mô hình ngôn ngữ sẽ cần học những sự thật về thế giới, theo dõi các nhân vật và sự kiện, và tuân thủ các quy tắc ngữ pháp – các thách thức đơn giản hơn so với những gì mô hình lớn đang đối mặt. Tuy nhiên, các mô hình lớn được đào tạo trên các tập dữ liệu lớn học hàng loạt chi tiết không liên quan cùng với các quy tắc quan trọng thực sự. Eldan hy vọng sự ngắn gọn và từ vựng hạn chế trong các câu chuyện dành cho trẻ em có thể làm cho việc học trở nên quản lý hơn đối với các mô hình nhỏ bé – làm cho việc đào tạo và hiểu rõ chúng trở nên dễ dàng hơn.

Tuy nhiên, trong thế giới của các mô hình ngôn ngữ, “nhỏ” là một khái niệm tương đối: Một tập dữ liệu nhỏ hơn một nghìn lần so với tập dữ liệu được sử dụng để đào tạo GPT-3.5 vẫn cần phải chứa hàng triệu câu chuyện. “Tôi không biết bạn muốn tiêu bao nhiêu tiền, nhưng tôi đoán rằng bạn sẽ không thuê các chuyên gia viết [một vài triệu] câu chuyện ngắn,” Nguyen nói.

Để đáp ứng nhu cầu của các mô hình ngôn ngữ nhỏ như vậy, sẽ cần một tác giả phi thường có khả năng sáng tạo. Nhưng Eldan đã nghĩ đến một vài ứng cử viên phù hợp. Ai có thể viết cho một đối tượng là các mô hình ngôn ngữ nhỏ bé tốt hơn chính các mô hình lớn?

Câu chuyện đồ chơi

Eldan ngay lập tức bắt tay vào việc tạo ra một thư viện các câu chuyện dành cho trẻ em tổng hợp do các mô hình ngôn ngữ lớn tạo ra. Tuy nhiên, ông sớm nhận ra rằng ngay cả các mô hình tối tân cũng không tự nhiên sáng tạo lắm. Nếu bạn chỉ đơn giản là yêu cầu GPT-4 viết những câu chuyện phù hợp cho trẻ 4 tuổi, Eldan nói, “khoảng một năm năm câu chuyện sẽ kể về các em nhỏ đến công viên và sợ cái thú chơi trượt.” Đó có vẻ như là câu chuyện tiền mẫu cho trẻ mẫu giáo, theo như internet đã hiểu.

Giải pháp là thêm một chút tính ngẫu nhiên vào câu gợi ý. Trước hết, Eldan đã sử dụng GPT-4 để tạo ra một danh sách gồm 1.500 danh từ, động từ và tính từ mà một đứa trẻ 4 tuổi có thể biết – đủ ngắn để ông có thể kiểm tra dễ dàng. Sau đó, ông đã viết một chương trình máy tính đơn giản sẽ liên tục đánh thức GPT-3.5 hoặc GPT-4 để tạo ra một câu chuyện phù hợp với độ tuổi bao gồm ba từ ngẫu nhiên từ danh sách đó, cùng với một chi tiết khác được chọn ngẫu nhiên như một kết thúc vui vẻ hoặc bất ngờ trong cốt truyện. Những câu chuyện kết quả, may mắn thay, ít tập trung vào những chiếc trượt đáng sợ.

Bây giờ, Eldan đã có một quy trình để tạo dữ liệu đào tạo theo yêu cầu, nhưng ông không biết cần bao nhiêu câu chuyện để đào tạo một mô hình hoạt động, hoặc mô hình đó cần phải lớn đến đâu. Đó là khi ông hợp tác với Yuanzhi Li, một nhà nghiên cứu học máy tại Microsoft và Đại học Carnegie Mellon, để thử nghiệm các khả năng khác nhau, tận dụng việc các mô hình nhỏ có thể được đào tạo rất nhanh chóng. Bước 1 là quyết định cách đánh giá các mô hình của họ.

Trong nghiên cứu về mô hình ngôn ngữ – như trong mọi lớp học – việc đánh giá là một chủ đề khá phức tạp. Không có một bảng điểm hoàn hảo nào thể hiện đầy đủ mọi điều mà các nhà nghiên cứu muốn biết, và các mô hình mà xuất sắc ở một số nhiệm vụ thường thất bại thảm hại ở những nhiệm vụ khác. Theo thời gian, các nhà nghiên cứu đã phát triển các tiêu chuẩn thử nghiệm tiêu chuẩn dựa trên các câu hỏi có câu trả lời không mơ hồ, đây là một phương pháp tốt nếu bạn đang cố gắng đánh giá các kỹ năng cụ thể. Tuy nhiên, Eldan và Li quan tâm đến điều gì đó mơ hồ hơn: Mô hình ngôn ngữ thực sự cần phải lớn đến đâu nếu bạn đơn giản hóa ngôn ngữ càng nhiều càng tốt?

“Để kiểm tra trực tiếp xem mô hình có nói tiếng Anh không, tôi nghĩ điều duy nhất bạn có thể làm là để mô hình tạo ra tiếng Anh một cách không giới hạn”, Eldan nói.

Chỉ có hai cách để đo lường hiệu suất của một mô hình đối với các câu hỏi có tính chất chất lượng như vậy: Dựa vào người đánh giá con người, hoặc lựa chọn GPT-4 một lần nữa. Hai nhà nghiên cứu đã chọn con đường thứ hai, thực tế là để các mô hình lớn viết sách giáo trình và chấm điểm bài luận.

Bhagavatula nói rằng ông muốn thấy cách đánh giá của GPT-4 so sánh với những đánh giá từ người đánh giá con người – GPT-4 có thể thiên vị đối với các mô hình mà nó đã giúp đào tạo, và sự mập mờ của các mô hình ngôn ngữ làm cho việc định lượng các thiên vị như vậy trở nên khó khăn. Tuy nhiên, ông không nghĩ những sự tinh tế như vậy sẽ ảnh hưởng đến việc so sánh giữa các mô hình khác nhau được đào tạo trên các tập dữ liệu tổng hợp tương tự – đó là trọng tâm chính của công việc của Eldan và Li.

Eldan và Li đã sử dụng một quy trình hai bước để đánh giá từng mô hình nhỏ của họ sau quá trình đào tạo. Trước hết, họ gợi ý cho mô hình nhỏ với nửa đầu của một câu chuyện khác với những câu chuyện trong tập dữ liệu đào tạo để mô hình tạo ra một phần kết thúc mới, lặp lại quá trình này với 50 câu chuyện kiểm tra khác nhau. Thứ hai, họ chỉ dẫn GPT-4 đánh giá mỗi phần kết thúc của mô hình nhỏ dựa trên ba danh mục – sự sáng tạo, ngữ pháp và tính nhất quán với phần đầu của câu chuyện. Sau đó, họ tính trung bình các điểm số trong từng danh mục, từ đó có ba điểm cuối cùng cho mỗi mô hình.

Với quy trình này, Eldan và Li cuối cùng đã sẵn sàng để so sánh các mô hình khác nhau và tìm ra mô hình nào là học sinh xuất sắc.

Sau một số khám phá ban đầu, hai nhà nghiên cứu đã quyết định sử dụng một tập dữ liệu đào tạo chứa khoảng 2 triệu câu chuyện. Sau đó, họ sử dụng tập dữ liệu này, được đặt tên là TinyStories, để đào tạo các mô hình có kích thước từ 1 triệu đến 30 triệu tham số, với các lớp có số lượng khác nhau. Quá trình này diễn ra nhanh chóng: Sử dụng chỉ bốn GPU, mô hình lớn nhất trong số này không tốn nhiều thời gian hơn một ngày để đào tạo.

Các mô hình nhỏ bé gặp khó khăn. Ví dụ, một câu chuyện kiểm tra bắt đầu với một người đàn ông trông ác độc nói với một cô bé rằng anh sẽ lấy mèo của cô bé. Một mô hình với một triệu tham số bị kẹt trong một vòng lặp với cô bé lặp đi lặp lại rằng cô bé muốn làm bạn với người đàn ông. Nhưng các mô hình lớn hơn – vẫn nhỏ hơn hàng nghìn lần so với GPT-3.5 – đã có kết quả khá ấn tượng. Phiên bản có 28 triệu tham số kể một câu chuyện mạch lạc, tuy nhiên phần kết thúc lại đầy ác cảm: “Katie bắt đầu khóc, nhưng người đàn ông không quan tâm. Anh ta đã lấy mèo và Katie không bao giờ thấy mèo của cô bé nữa. Kết thúc.”

Ngoài việc kiểm tra các mô hình của họ, Eldan và Li cũng đưa ra thách thức tương tự cho GPT-2 của OpenAI, một mô hình có 1,5 tỷ tham số được phát hành vào năm 2019. Kết quả của nó kém hơn nhiều – trước phần kết thúc đột ngột của câu chuyện, người đàn ông đe dọa đưa cô bé đến tòa án, tù, bệnh viện, nhà tang lễ và cuối cùng là lò hỏa táng.

Nguyen nói rằng điều thú vị là các mô hình nhỏ bé như vậy lại rất thành thạo, nhưng có lẽ không có gì ngạc nhiên khi GPT-2 gặp khó khăn trong nhiệm vụ này: Nó là một mô hình lớn hơn nhưng xa từ trạng thái nghệ thuật, và nó đã được đào tạo trên một tập dữ liệu rất khác. “Một đứa trẻ chỉ đào tạo trên các nhiệm vụ dành cho trẻ con, như chơi với một số đồ chơi, có thể làm tốt hơn bạn hoặc tôi,” ông lưu ý. “Chúng ta không chuyên về điều đơn giản này.”

So sánh giữa các mô hình TinyStories khác nhau không gặp các yếu tố gây nhiễu tương tự. Eldan và Li đã quan sát ra những gợi ý rằng các mạng với ít lớp nhưng nhiều nơ-ron trên mỗi lớp hoàn thành tốt hơn các câu hỏi đòi hỏi kiến thức thực tế; ngược lại, các mạng với nhiều lớp và ít nơ-ron trên mỗi lớp hoàn thành tốt hơn việc theo dõi các nhân vật và điểm cốt truyện từ phần trước của câu chuyện. Bhagavatula thấy kết quả này đặc biệt hấp dẫn. Nếu nó có thể được tái tạo trên các mô hình lớn hơn, ông nói, “đó sẽ là một kết quả thực sự thú vị có thể phát triển từ công việc này.”

Eldan và Li cũng nghiên cứu cách mà khả năng của các mô hình nhỏ của họ phụ thuộc vào thời gian đào tạo. Trong mọi trường hợp, các mô hình đã làm chủ ngữ pháp trước và tính nhất quán sau. Đối với Eldan, mẫu này minh họa cách mà sự khác biệt trong cấu trúc phần thưởng dẫn đến sự khác biệt trong mẫu học ngôn ngữ giữa các mạng nơ-ron và trẻ em. Đối với các mô hình ngôn ngữ, mà học bằng cách dự đoán từ, “động cơ trên các từ ‘Tôi muốn có’ cũng lớn như động cơ trên các từ ‘kem,'” ông nói. Trong khi đó, trẻ em “không quan tâm đến việc họ nói ‘Tôi muốn có một ít kem’ hay chỉ là ‘kem, kem, kem’.”

Eldan và Li hy vọng rằng nghiên cứu này sẽ thúc đẩy các nhà nghiên cứu khác đào tạo các mô hình khác nhau trên tập dữ liệu TinyStories và so sánh khả năng của chúng. Tuy nhiên, thường khó để dự đoán những đặc điểm của các mô hình nhỏ sẽ xuất hiện trong các mô hình lớn hơn.

“Chẳng hạn, có lẽ mô hình chuột về thị giác thực sự là các dấu hiệu tốt của thị giác của con người, nhưng các mô hình chuột về trầm cảm có phải là các mô hình tốt về trầm cảm của con người không?” Pavlick nói. “Với mỗi trường hợp, điều đó hơi khác biệt một chút.”

Sự thành công của các mô hình TinyStories cũng đề xuất một bài học rộng hơn. Phương pháp tiêu chuẩn để tạo ra các tập dữ liệu đào tạo bao gồm việc thu thập văn bản từ khắp nơi trên internet và sau đó lọc ra các nội dung không có giá trị. Văn bản tổng hợp được tạo ra bởi các mô hình lớn có thể cung cấp một cách khác để tạo ra các tập dữ liệu chất lượng cao mà không cần phải quá lớn.

“Chúng ta có nhiều hơn và nhiều hơn bằng chứng cho thấy điều này rất hiệu quả, không chỉ trong các mô hình có kích thước tương tự TinyStories mà còn trong các mô hình lớn hơn,” Eldan nói. Bằng chứng đó đến từ một cặp bài báo theo sau về các mô hình có một tỷ tham số của Eldan, Li và các nhà nghiên cứu khác tại Microsoft. Trong bài báo đầu tiên, họ đã đào tạo một mô hình để học ngôn ngữ lập trình Python bằng các đoạn mã được tạo ra bởi GPT-3.5 cùng với các đoạn mã được lựa chọn cẩn thận từ internet. Trong bài báo thứ hai, họ đã bổ sung tập dữ liệu đào tạo bằng “sách giáo trình” tổng hợp, bao gồm nhiều chủ đề, để đào tạo một mô hình ngôn ngữ đa năng. Trong các bài kiểm tra của họ, cả hai mô hình đều so sánh tốt với các mô hình lớn hơn được đào tạo trên các tập dữ liệu lớn hơn. Tuy nhiên, việc đánh giá các mô hình ngôn ngữ luôn luôn khó khăn, và phương pháp sử dụng dữ liệu đào tạo tổng hợp vẫn đang ở giai đoạn đầu – cần thêm nhiều bài kiểm tra độc lập hơn.

Khi các mô hình ngôn ngữ đạt đến trạng thái nghệ thuật ngày càng lớn hơn, những kết quả đáng ngạc nhiên từ những người anh em nhỏ bé của chúng là những lời nhắc rằng vẫn còn rất nhiều điều chúng ta chưa hiểu về ngay cả những mô hình đơn giản nhất. Nguyen kỳ vọng sẽ có nhiều bài báo nữa khám phá phương pháp pionnered bởi TinyStories.

“Câu hỏi là: Kích thước quyết định ở đâu và tại sao?” ông nói. “Nên có một khoa học về điều đó, và hy vọng rằng bài báo này sẽ là khởi đầu của một câu chuyện phong phú.”