Tác giả: Melissa Heikkilätrang

Ngày 20 tháng 12 năm 2022

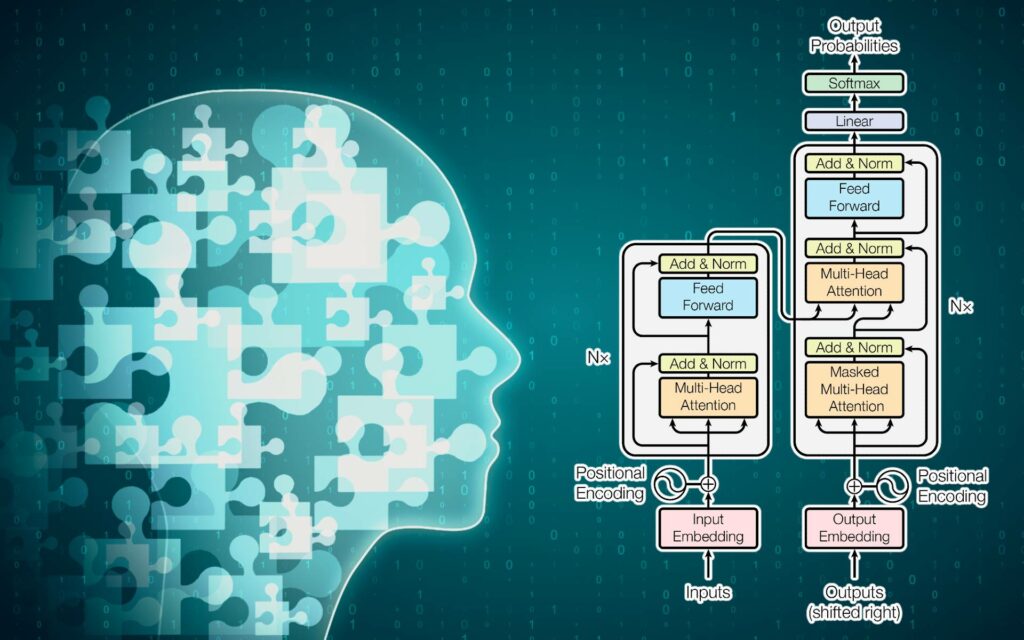

Các mô hình ngôn ngữ lớn được đào tạo trên các tập dữ liệu được xây dựng bằng cách thu thập dữ liệu từ internet, bao gồm tất cả những điều người dùng đã viết trực tuyến, bao gồm cả những nội dung độc hại, ngớ ngẩn, sai lệch và ác ý. Các mô hình trí tuệ nhân tạo đã hoàn thành này phát ra những thông tin sai lệch này như sự thật và sản phẩm của chúng lan truyền khắp mọi nơi trên internet. Các công ty công nghệ thu thập lại dữ liệu từ internet một lần nữa, thu thập các đoạn văn bản được viết bởi trí tuệ nhân tạo và sử dụng chúng để đào tạo các mô hình lớn hơn, thuyết phục hơn, mà con người có thể sử dụng để tạo ra thêm nhiều thông tin vô nghĩa trước khi nó lại bị thu thập lần nữa và lần nữa, đến mức khiến người ta buồn nôn.

Năm nay đã là một năm bùng nổ cho trí tuệ nhân tạo. Nếu bạn đã dành nhiều thời gian trực tuyến, bạn có thể đã bắt gặp các hình ảnh được tạo ra bởi các hệ thống trí tuệ nhân tạo như DALL-E 2 hoặc Stable Diffusion, hoặc những lời nói đùa, bài luận, hoặc văn bản khác được viết bởi ChatGPT, phiên bản mới nhất của mô hình ngôn ngữ lớn GPT-3 của OpenAI.

Đôi khi, việc một hình ảnh hoặc một đoạn văn đã được tạo ra bởi trí tuệ nhân tạo là rất rõ ràng. Nhưng ngày càng nhiều, những sản phẩm mà các mô hình này tạo ra có thể dễ dàng đánh lừa chúng ta, làm cho chúng ta tưởng rằng chúng được tạo ra bởi con người. Đặc biệt, các mô hình ngôn ngữ lớn đặc biệt tự tin: chúng tạo ra văn bản có vẻ đúng đắn nhưng thực tế có thể chứa đựng nhiều thông tin sai lệch.

Mặc dù điều này không quan trọng nếu nó chỉ là một chút vui thú, nhưng nó có thể có hậu quả nghiêm trọng nếu các mô hình trí tuệ nhân tạo được sử dụng để cung cấp lời khuyên về sức khỏe không được lọc hoặc cung cấp các dạng thông tin quan trọng khác. Các hệ thống trí tuệ nhân tạo cũng có thể làm cho việc sản xuất hàng loạt thông tin sai lệch, lạm dụng và rác thải trở nên ngu ngốc dễ dàng, biến tình thông tin chúng ta tiêu thụ và thậm chí cảm giác thực tế của chúng ta. Điều này có thể đặc biệt đáng lo ngại trong các cuộc bầu cử chẳng hạn.

Sự phát triển của các mô hình ngôn ngữ lớn dễ dàng tiếp cận này đặt ra một câu hỏi quan trọng: Làm thế nào chúng ta sẽ biết được liệu những gì chúng ta đọc trực tuyến có được viết bởi con người hay máy móc? Tôi vừa mới xuất bản một bài viết nghiên cứu về các công cụ hiện tại mà chúng ta có để phát hiện văn bản được tạo ra bởi trí tuệ nhân tạo. Để tiết lộ trước: Bộ công cụ phát hiện hiện nay là quá kém cỏi khi phải đối mặt với ChatGPT.

Tuy nhiên, có một tác động dài hạn nghiêm trọng hơn. Chúng ta có thể đang chứng kiến, trong thời gian thực, sự ra đời của một loạt thông tin sai lệch ngày càng lớn.

Các mô hình ngôn ngữ lớn được đào tạo trên các tập dữ liệu được xây dựng bằng cách thu thập dữ liệu từ internet, bao gồm tất cả những điều người dùng đã viết trực tuyến, bao gồm cả những nội dung độc hại, ngớ ngẩn, sai lệch và ác ý. Các mô hình trí tuệ nhân tạo đã hoàn thành này phát ra những thông tin sai lệch này như sự thật và sản phẩm của chúng lan truyền khắp mọi nơi trên internet. Các công ty công nghệ thu thập lại dữ liệu từ internet một lần nữa, thu thập các đoạn văn bản được viết bởi trí tuệ nhân tạo và sử dụng chúng để đào tạo các mô hình lớn hơn, thuyết phục hơn, mà con người có thể sử dụng để tạo ra thêm nhiều thông tin vô nghĩa trước khi nó lại bị thu thập lần nữa và lần nữa, đến mức khiến người ta buồn nôn.

Vấn đề này – trí tuệ nhân tạo nuốt chửng chính nó và sản xuất ra đầu ra ngày càng bẩn – cũng lan rộng đến hình ảnh. “Internet bây giờ đã bị nhiễm bẩn vĩnh viễn bằng các hình ảnh được tạo ra bởi trí tuệ nhân tạo,” Mike Cook, một nhà nghiên cứu trí tuệ nhân tạo tại King’s College London, nói với đồng nghiệp của tôi Will Douglas Heaven trong bài viết mới nhất về tương lai của các mô hình trí tuệ nhân tạo tạo ra. “Những hình ảnh mà chúng ta tạo ra trong năm 2022 sẽ trở thành một phần của bất kỳ mô hình nào được tạo ra từ bây giờ.”

Trong tương lai, việc tìm kiếm dữ liệu đào tạo không chứa trí tuệ nhân tạo, chất lượng và đáng tin cậy sẽ trở nên khó khăn hơn và khó khăn hơn, theo Daphne Ippolito, một nhà nghiên cứu cấp cao tại Google Brain, bộ phận nghiên cứu về học sâu của công ty. Không còn đủ tốt để chỉ mù quáng thu thập văn bản từ internet nữa, nếu chúng ta muốn ngăn các mô hình trí tuệ nhân tạo trong tương lai khỏi việc tích hợp độc đáo và thông tin sai lệch đến mức cực độ.

“Điều quan trọng thực sự là xem xét liệu chúng ta cần phải đào tạo trên toàn bộ internet hay có cách nào đó chúng ta có thể lọc những điều chất lượng và sẽ mang lại cho chúng ta mô hình ngôn ngữ mà chúng ta mong muốn,” Ippolito nói.

Việc xây dựng các công cụ để phát hiện văn bản được tạo ra bởi trí tuệ nhân tạo sẽ trở nên quan trọng hơn bao giờ hết khi mọi người không thể tránh khỏi việc thử nghiệm viết các bài nghiên cứu khoa học hoặc bài báo học thuật bằng trí tuệ nhân tạo, hoặc sử dụng trí tuệ nhân tạo để tạo ra tin tức giả mạo hoặc thông tin sai lệch.

Các công cụ kỹ thuật có thể giúp, nhưng con người cũng cần trở nên thông thái hơn.

Ippolito cho biết có một số dấu hiệu tiêu biểu của văn bản được tạo ra bởi trí tuệ nhân tạo. Con người viết chữ không gọn gàng. Văn bản của chúng ta thường đầy lỗi chính tả và lóng, và việc tìm kiếm những lỗi và sự tinh vi như vậy là một cách tốt để xác định văn bản được viết bởi con người. Ngược lại, các mô hình ngôn ngữ lớn hoạt động bằng cách dự đoán từ tiếp theo trong một câu, và họ có xu hướng sử dụng các từ thông thường như “the,” “it,” hoặc “is” thay vì các từ kỳ lạ và hiếm. Và mặc dù họ gần như không bao giờ viết sai chính tả, họ vẫn mắc sai lầm. Ippolito nói rằng người ta nên chú ý đến những sự không nhất quán tinh tế hoặc lỗi về sự thật trong các văn bản được trình bày như là sự thật, ví dụ.

Thú vị là nghiên cứu của cô cho thấy rằng với việc luyện tập, con người có thể tự rèn luyện để nhận biết văn bản được tạo ra bởi trí tuệ nhân tạo tốt hơn. Có lẽ còn hi vọng cho chúng ta tất cả.

Học Sâu

Một chiếc Roomba đã ghi lại một người phụ nữ đang ở trong nhà vệ sinh. Làm thế nào mà các ảnh chụp màn hình lại xuất hiện trên Facebook?

Câu chuyện này làm cho tôi cảm thấy rùng mình. Trước đó trong năm nay, đồng nghiệp của tôi, Eileen Guo, đã có trong tay 15 bức ảnh chụp màn hình từ các bức ảnh riêng tư được chụp bởi một robot hút bụi, bao gồm các hình ảnh của người nào đó đang ngồi trên bồn cầu, được đăng trên các nhóm mạng xã hội đóng cửa.

i đang theo dõi? iRobot, công ty phát triển chiếc robot hút bụi Roomba, cho biết những hình ảnh này không đến từ những ngôi nhà của khách hàng mà là “các người thu thập được trả tiền và nhân viên” đã ký thỏa thuận bằng văn bản thừa nhận rằng họ đang gửi dòng dữ liệu, bao gồm cả video, trở lại cho công ty để đào tạo mục đích. Nhưng không rõ liệu những người này đã biết rằng con người, cụ thể là con người, sẽ xem xét những hình ảnh này để đào tạo trí tuệ nhân tạo hay không.

Tại sao điều này quan trọng: Câu chuyện này minh họa cho việc ngày càng phổ biến của việc chia sẻ dữ liệu có thể nhạy cảm để đào tạo các thuật toán, cũng như hành trình bất ngờ bao quát toàn cầu mà một hình ảnh duy nhất có thể thực hiện – trong trường hợp này, từ các ngôi nhà ở Bắc Mỹ, châu Âu và châu Á đến máy chủ của công ty iRobot đặt tại Massachusetts, rồi từ đó đến Scale AI đặt tại San Francisco, và cuối cùng đến các công nhân dữ liệu của Scale trên toàn thế giới. Các hình ảnh cùng nhau tiết lộ một chuỗi cung ứng dữ liệu toàn diện – và các điểm mới mà thông tin cá nhân có thể rò rỉ ra khỏi – mà ít người tiêu dùng thậm chí không biết đến. Đọc câu chuyện tại đây.

Những Tin Tức Công Nghệ

Người sáng lập OpenAI, Sam Altman, chia sẻ những gì ông học được từ DALL-E 2 Altman kể cho Will Douglas Heaven biết tại sao ông nghĩ rằng DALL-E 2 đã trở thành một thành công lớn, những bài học ông học được từ sự thành công của nó, và những mô hình giống như nó có ý nghĩa gì đối với xã hội. (MIT Technology Review)

Nghệ sĩ có thể chọn không tham gia phiên bản tiếp theo của Stable Diffusion Quyết định này đến sau một cuộc tranh luận công khai sôi nổi giữa các nghệ sĩ và các công ty công nghệ về cách đào tạo các mô hình trí tuệ nhân tạo chuyển đổi văn bản thành hình ảnh. Kể từ khi Stable Diffusion được ra mắt, các nghệ sĩ đã tỏ ra bất bình, lập luận rằng mô hình này đã lấy cắp các tác phẩm được bảo vệ bản quyền của họ mà không trả tiền hoặc ghi công. (MIT Technology Review)

Trung Quốc đã cấm nhiều loại deepfake Cơ quan Quản lý Không gian Mạng của Trung Quốc đã cấm các deepfake được tạo ra mà không có sự cho phép của chủ thể và vi phạm các giá trị xã hội chủ nghĩa hoặc lan truyền “thông tin bất hợp pháp và có hại.” (The Register)

Công việc của vị trí hỗ trợ cho chatbot Là một sinh viên và người viết, Laura Preston đã có một công việc khá độc đáo: thay thế khi một chatbot trí tuệ nhân tạo về bất động sản có tên Brenda bị lệch kịch bản. Mục tiêu là để khách hàng không nhận ra sự khác biệt. Câu chuyện này cho thấy rõ hơn về việc trí tuệ nhân tạo hiện nay có thể ngốc nghếch trong các tình huống thực tế, và cần có bao nhiêu công việc của con người để duy trì sự ảo tưởng về máy móc thông minh. (The Guardian)