Tác giả: Aayush Mittal

ngày 8 tháng 5 năm 2024

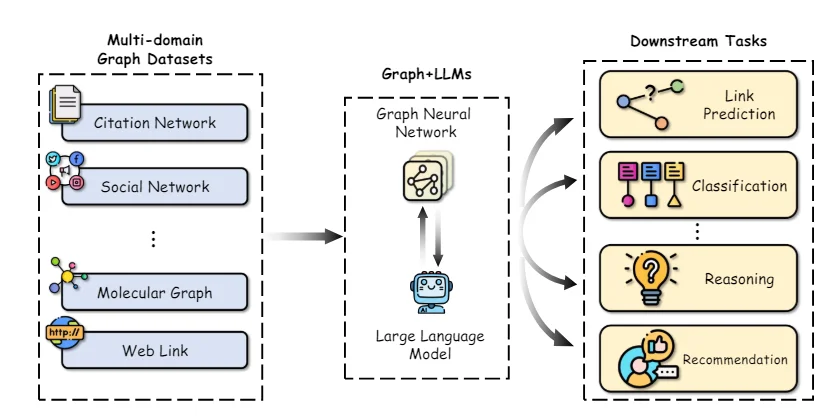

Các đồ thị là cấu trúc dữ liệu biểu diễn các mối quan hệ phức tạp trên một loạt các lĩnh vực, bao gồm mạng xã hội, cơ sở dữ liệu kiến thức, hệ thống sinh học và nhiều hơn nữa. Trong những đồ thị này, các thực thể được biểu diễn dưới dạng các nút, và mối quan hệ của chúng được mô tả dưới dạng các cạnh.

Khả năng biểu diễn và suy luận một cách hiệu quả về những cấu trúc quan hệ phức tạp này là rất quan trọng để thúc đẩy sự tiến bộ trong các lĩnh vực như khoa học mạng, hóa học thông tin, và hệ thống gợi ý.

Mạng neural đồ thị (GNNs) đã xuất hiện như một khung làm việc học sâu mạnh mẽ cho các nhiệm vụ học máy trên đồ thị. Bằng cách tích hợp topologia đồ thị vào kiến trúc mạng neural thông qua tổng hợp hàng xóm hoặc tích chập đồ thị, GNNs có thể học các biểu diễn vector chiều thấp mã hóa cả đặc điểm của nút và vai trò cấu trúc của chúng. Điều này cho phép GNNs đạt được hiệu suất hàng đầu trên các nhiệm vụ như phân loại nút, dự đoán liên kết và phân loại đồ thị trên các lĩnh vực ứng dụng đa dạng.

Mặc dù GNNs đã đạt được tiến bộ đáng kể, nhưng vẫn còn một số thách thức quan trọng. Việc thu thập dữ liệu được gắn nhãn chất lượng cao để huấn luyện các mô hình GNN giám sát có thể tốn kém và tốn thời gian. Ngoài ra, GNNs có thể gặp khó khăn với cấu trúc đồ thị không đồng nhất và trong các tình huống mà phân phối đồ thị tại thời gian kiểm tra khác biệt đáng kể so với dữ liệu huấn luyện (tính tổng quát ngoài phân phối).

Song song với đó, các Mô hình Ngôn ngữ Lớn (LLMs) như GPT-4 và LLaMA đã gây ra làn sóng trong cộng đồng với khả năng hiểu và tạo ra ngôn ngữ tự nhiên đáng kinh ngạc. Được huấn luyện trên các ngữ liệu văn bản khổng lồ với hàng tỷ tham số, các LLMs thể hiện khả năng học từ ít dữ liệu, tổng quát hóa qua các nhiệm vụ, và kỹ năng suy luận cùng lý lẽ thông thường mà trước đây được cho là rất khó khăn đối với các hệ thống trí tuệ nhân tạo.

Sự thành công to lớn của các LLMs đã thúc đẩy các khám phá về việc tận dụng sức mạnh của chúng cho các nhiệm vụ học máy trên đồ thị. Một mặt, khả năng kiến thức và suy luận của các LLMs mở ra cơ hội để tăng cường các mô hình GNN truyền thống. Ngược lại, các biểu diễn có cấu trúc và kiến thức thực tế tích hợp trong các đồ thị có thể đóng vai trò quan trọng trong việc giải quyết một số hạn chế chính của các LLMs, như ảo giác và thiếu tính có thể giải thích.

Trong bài viết này, chúng ta sẽ đào sâu vào các nghiên cứu mới nhất tại điểm giao của học máy trên đồ thị và các mô hình ngôn ngữ lớn. Chúng ta sẽ khám phá cách sử dụng LLMs để tăng cường các khía cạnh khác nhau của học máy trên đồ thị, đánh giá các phương pháp để tích hợp kiến thức đồ thị vào LLMs, và thảo luận về các ứng dụng mới nổi và hướng phát triển tương lai cho lĩnh vực hứng thú này.

Mạng Neural Đồ Thị và Học Không Giám Sát Tự Luyện

Để cung cấp ngữ cảnh cần thiết, trước tiên chúng ta sẽ tóm tắt ngắn gọn các khái niệm và phương pháp cơ bản trong mạng neural đồ thị và học biểu diễn đồ thị không giám sát tự luyện.

Cấu Trúc Mạng Neural Đồ Thị

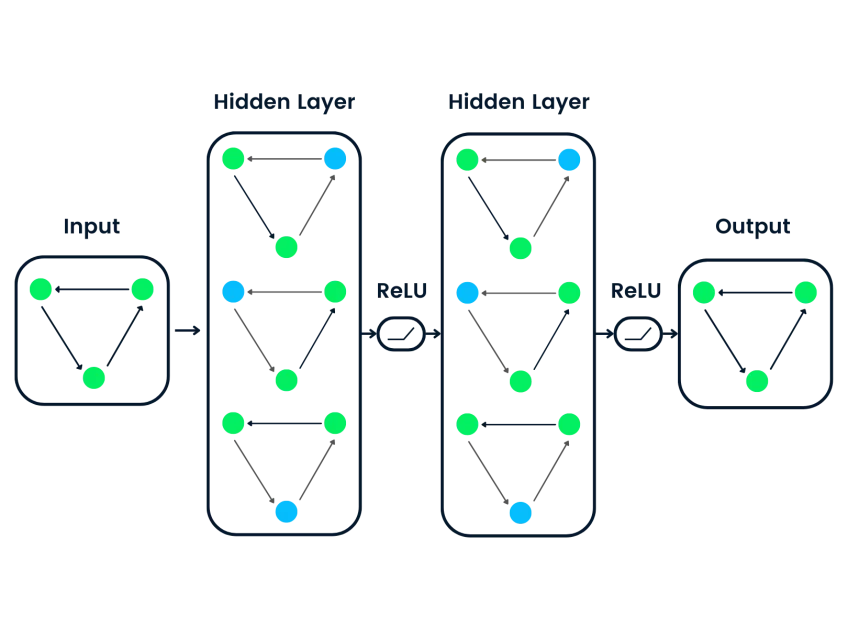

Sự khác biệt chính giữa các mạng neural sâu truyền thống và GNNs nằm ở khả năng hoạt động trực tiếp trên dữ liệu có cấu trúc đồ thị. GNNs tuân theo một mô hình tổng hợp hàng xóm, trong đó mỗi nút tổng hợp các vector đặc trưng từ các hàng xóm của nó để tính toán biểu diễn của chính nó.

Nhiều cấu trúc GNN đã được đề xuất với các biến thể khác nhau của các hàm thông điệp và cập nhật, như Mạng Tích Chập Đồ Thị (GCNs), GraphSAGE, Mạng Chú Ý Đồ Thị (GATs), và Mạng Đồ Thị Đồng Cấu (GINs) và nhiều loại khác.

Gần đây, các biến thể của bộ biến đổi đồ thị đã trở nên phổ biến bằng cách điều chỉnh cơ chế tự chú ý từ các biến đổi ngôn ngữ tự nhiên để hoạt động trên dữ liệu có cấu trúc đồ thị. Một số ví dụ bao gồm GraphormerTransformer và GraphFormers. Những mô hình này có khả năng nắm bắt các phụ thuộc xa trên đồ thị tốt hơn so với các GNNs dựa trên hàng xóm một cách hoàn toàn.

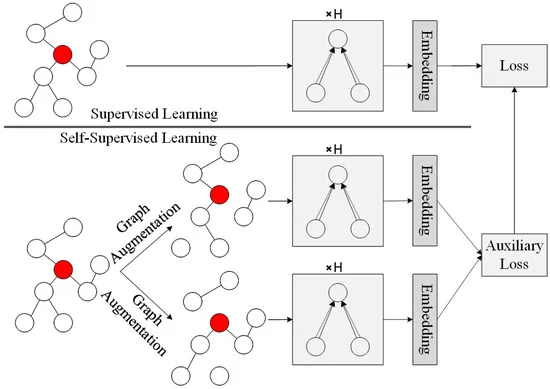

Học Không Giám Sát Tự Luyện trên Đồ Thị

Mặc dù GNNs là các mô hình biểu diễn mạnh mẽ, hiệu suất của chúng thường bị hạn chế do thiếu các tập dữ liệu lớn được gắn nhãn cần thiết cho việc huấn luyện giám sát. Học không giám sát tự luyện đã trở thành một mô hình triển vọng để tiền huấn GNNs trên dữ liệu đồ thị không được gắn nhãn bằng cách tận dụng các nhiệm vụ giả định chỉ đòi hỏi cấu trúc đồ thị nội tại và các đặc điểm của nút.

Một số nhiệm vụ giả định phổ biến được sử dụng để tiền huấn GNNs không giám sát tự luyện bao gồm:

- Dự Đoán Thuộc Tính Nút: Ngẫu nhiên che dấu hoặc làm hỏng một phần của các thuộc tính/đặc điểm của nút và yêu cầu GNN phục hồi chúng.

- Dự Đoán Cạnh/Liên Kết: Học cách dự đoán liệu có một cạnh tồn tại giữa một cặp nút hay không, thường dựa trên việc che dấu cạnh ngẫu nhiên.

- Học Phản Nghịch: Tối đa hóa sự tương đồng giữa các quan điểm đồ thị của cùng một mẫu đồ thị trong khi đẩy xa các quan điểm từ các đồ thị khác nhau.

- Tối Đa Hóa Thông Tin Lượng Tự: Tối đa hóa thông tin lượng tự giữa các biểu diễn nút cục bộ và một biểu diễn mục tiêu như nhúng đồ thị toàn cầu.

Các nhiệm vụ giả định như vậy cho phép GNNs trích xuất các mẫu cấu trúc và ngữ nghĩa ý nghĩa từ dữ liệu đồ thị không được gắn nhãn trong quá trình tiền huấn. GNN được tiền huấn có thể được điều chỉnh một cách tốt trên các tập con được gắn nhãn tương đối nhỏ để xuất sắc trong các nhiệm vụ phụ thuộc như phân loại nút, dự đoán liên kết và phân loại đồ thị.

Bằng cách tận dụng tự giám sát, GNNs được tiền huấn trên các tập dữ liệu không được gắn nhãn lớn có khả năng tổng quát hóa tốt hơn, độ ổn định khi có sự thay đổi phân phối, và hiệu suất so với việc huấn luyện từ đầu. Tuy nhiên, một số hạn chế chính của các phương pháp tự giám sát dựa trên GNN truyền thống vẫn còn tồn tại, điều mà chúng ta sẽ khám phá và tận dụng LLMs để giải quyết tiếp theo.

Nâng cao Học Máy Trên Đồ Thị với Các Mô Hình Ngôn Ngữ Lớn

Các khả năng đáng kinh ngạc của các LLM trong việc hiểu ngôn ngữ tự nhiên, suy luận, và học từ ít dữ liệu mở ra cơ hội để cải thiện nhiều khía cạnh của các ống dẫn học máy trên đồ thị. Chúng ta khám phá một số hướng nghiên cứu chính trong lĩnh vực này:

Một thách thức quan trọng khi áp dụng GNNs là việc thu thập các biểu diễn đặc trưng chất lượng cao cho các nút và cạnh, đặc biệt là khi chúng chứa các thuộc tính văn bản phong phú như mô tả, tiêu đề, hoặc tóm tắt. Theo truyền thống, các mô hình biểu diễn từ đơn giản hoặc các mô hình nhúng từ được tiền huấn đã được sử dụng, nhưng thường không thể nắm bắt được ngữ nghĩa tinh tế.

Các công trình gần đây đã chứng minh sức mạnh của việc tận dụng các mô hình ngôn ngữ lớn như bộ mã hóa văn bản để xây dựng các biểu diễn đặc trưng tốt hơn cho nút/cạnh trước khi đưa chúng vào GNN. Ví dụ, Chen và cộng sự sử dụng các LLMs như GPT-3 để mã hóa các thuộc tính văn bản của nút, cho thấy sự tăng hiệu suất đáng kể so với các mô hình nhúng từ truyền thống trên các nhiệm vụ phân loại nút.

Ngoài các bộ mã hóa văn bản tốt hơn, các LLMs có thể được sử dụng để tạo ra thông tin mở rộng từ các thuộc tính văn bản gốc một cách bán giám sát. TAPE tạo ra các nhãn/giải thích tiềm năng cho các nút bằng cách sử dụng một LLM và sử dụng chúng như các đặc trưng mở rộng bổ sung. KEA trích xuất các thuật ngữ từ các thuộc tính văn bản bằng cách sử dụng một LLM và thu được các mô tả chi tiết cho các thuật ngữ này để mở rộng các đặc trưng.

Bằng cách cải thiện chất lượng và sự biểu hiện của các đặc trưng đầu vào, các LLMs có thể truyền đạt khả năng hiểu ngôn ngữ tự nhiên vượt trội của chúng cho GNNs, tăng cường hiệu suất trên các nhiệm vụ phụ thuộc.

Giảm Sự Phụ Thuộc vào Dữ Liệu Đã Gắn Nhãn

Một ưu điểm chính của các LLMs là khả năng thực hiện tương đối tốt trên các nhiệm vụ mới với ít hoặc không có dữ liệu được gắn nhãn, nhờ vào việc tiền huấn trên các ngữ liệu văn bản rộng lớn. Khả năng học từ ít dữ liệu này có thể được tận dụng để giảm sự phụ thuộc của GNNs vào các tập dữ liệu đã được gắn nhãn lớn.

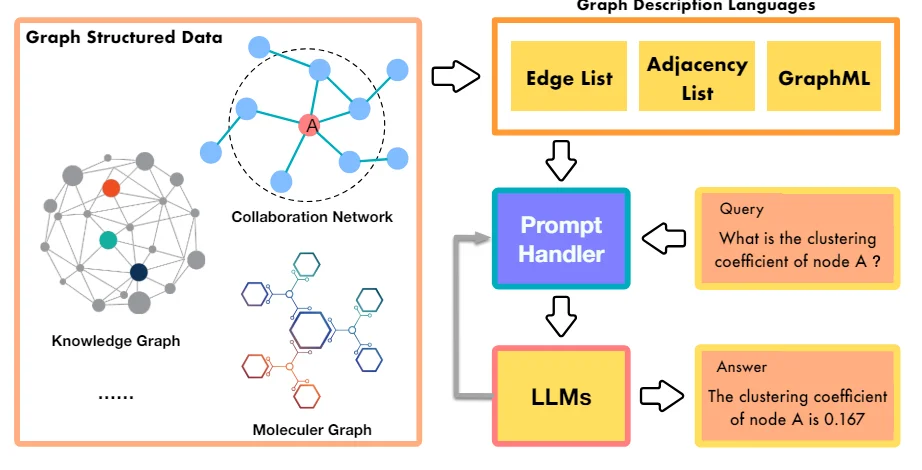

Một phương pháp là sử dụng các LLMs để trực tiếp đưa ra dự đoán trên các nhiệm vụ đồ thị bằng cách mô tả cấu trúc đồ thị và thông tin về nút trong các lời nhắc ngôn ngữ tự nhiên. Các phương pháp như InstructGLM và GPT4Graph điều chỉnh lại các LLMs như LLaMA và GPT-4 bằng cách sử dụng các lời nhắc được thiết kế cẩn thận tích hợp các chi tiết về topologia đồ thị như các kết nối của nút, hàng xóm v.v. Các LLM được điều chỉnh có thể tạo ra các dự đoán cho các nhiệm vụ như phân loại nút và dự đoán liên kết một cách không cần dữ liệu gắn nhãn trong quá trình suy luận.

Mặc dù việc sử dụng các LLMs như các bộ dự đoán hộp đen đã cho thấy sự hứa hẹn, hiệu suất của chúng giảm đối với các nhiệm vụ đồ thị phức tạp hơn nơi mô hình hóa rõ ràng của cấu trúc là có lợi. Một số phương pháp do đó sử dụng các LLMs cùng với GNNs – GNN mã hóa cấu trúc đồ thị trong khi các LLM cung cấp hiểu biết ngữ nghĩa nâng cao về các nút từ các mô tả văn bản của chúng.

GraphLLM khám phá hai chiến lược: 1) LLMs-như-Cải thiện nơi các LLMs mã hóa các thuộc tính văn bản nút trước khi chuyển cho GNN, và 2) LLMs-như-Dự đoán nơi LLMs lấy biểu diễn trung gian của GNN làm đầu vào để đưa ra dự đoán cuối cùng.

GLEM đi xa hơn bằng cách đề xuất một thuật toán EM biến thể thay đổi giữa việc cập nhật các thành phần LLM và GNN để cùng nhau cải thiện.

Bằng cách giảm sự phụ thuộc vào dữ liệu đã được gắn nhãn thông qua khả năng học từ ít dữ liệu và bổ sung bán giám sát, các phương pháp học đồ thị được cải thiện bởi các LLM có thể mở ra các ứng dụng mới và cải thiện hiệu suất sử dụng dữ liệu.

Nâng cao LLMs với Đồ thị

Mặc dù các LLMs đã đạt được thành công lớn, chúng vẫn gặp phải các hạn chế quan trọng như ảo giác (tạo ra các tuyên bố không có thực), thiếu tính có thể giải thích trong quá trình suy luận của chúng, và không thể duy trì tri thức thực tế nhất quán.

Các đồ thị, đặc biệt là các đồ thị tri thức đại diện cho thông tin thực tế được cấu trúc từ các nguồn đáng tin cậy, mở ra những lối đi triển vọng để giải quyết những hạn chế này. Chúng ta khám phá một số phương pháp mới nổi trong hướng này:

Tiền Huấn LLM Tăng Cường Bằng Đồ Thị Tri Thức

Tương tự như cách LLMs được tiền huấn trên các tập dữ liệu văn bản lớn, các công trình gần đây đã khám phá việc tiền huấn chúng trên các đồ thị tri thức để trang bị khả năng nhận biết thực tế và suy luận tốt hơn.

Một số phương pháp sửa đổi dữ liệu đầu vào bằng cách đơn giản là nối hoặc sắp xếp các bộ ba tri thức của KG với văn bản ngôn ngữ tự nhiên trong quá trình tiền huấn. E-BERT sắp xếp các vector thực thể của KG với các nhúng từ wordpiece của BERT, trong khi K-BERT xây dựng các cây chứa câu gốc và các bộ ba tri thức KG liên quan.

Vai trò của LLMs trong Học Máy Trên Đồ Thị:

Các nhà nghiên cứu đã khám phá nhiều cách để tích hợp LLMs vào ống dẫn học máy trên đồ thị, mỗi cách đều có những ưu điểm và ứng dụng độc đáo của riêng nó. Dưới đây là một số vai trò nổi bật mà LLMs có thể đóng:

- LLM như một Bổ sung: Trong phương pháp này, LLMs được sử dụng để làm giàu các thuộc tính văn bản liên kết với các nút trong một TAG. Khả năng của LLMs trong việc tạo ra giải thích, thực thể tri thức, hoặc giả nhãn có thể bổ sung thông tin ngữ nghĩa có sẵn cho GNN, dẫn đến cải thiện biểu diễn của nút và hiệu suất của các nhiệm vụ phụ thuộc.

Ví dụ, mô hình TAPE (Text Augmented Pre-trained Encoders) tận dụng ChatGPT để tạo ra giải thích và giả nhãn cho các bài báo trong mạng trích dẫn, sau đó được sử dụng để điều chỉnh một mô hình ngôn ngữ. Các nhúng kết quả được đưa vào một GNN để phân loại nút và dự đoán liên kết, đạt được kết quả hàng đầu.

- LLM như Một Bộ Dự Đoán: Thay vì cải thiện các đặc trưng đầu vào, một số phương pháp sử dụng trực tiếp LLMs như là thành phần dự đoán cho các nhiệm vụ liên quan đến đồ thị. Điều này bao gồm chuyển đổi cấu trúc đồ thị thành một biểu diễn văn bản có thể được xử lý bởi LLM, sau đó LLM tạo ra kết quả mong muốn, như nhãn nút hoặc dự đoán cấp đồ thị.

Một ví dụ đáng chú ý là mô hình GPT4Graph, đại diện cho các đồ thị bằng Ngôn Ngữ Mô Hình Hóa Đồ Thị (GML) và tận dụng sức mạnh của LLM mạnh mẽ GPT-4 cho các nhiệm vụ suy luận đồ thị không cần dữ liệu gắn nhãn.

- Sự Căn chỉnh GNN-LLM: Một dòng nghiên cứu khác tập trung vào việc căn chỉnh không gian nhúng của GNNs và LLMs, cho phép tích hợp thông tin cấu trúc và ngữ nghĩa một cách liền mạch. Các phương pháp này xem xét GNN và LLM như là các dạng biểu diễn riêng biệt và sử dụng các kỹ thuật như học phản biện hoặc rút trích để căn chỉnh các biểu diễn của họ.

Ví dụ, mô hình MoleculeSTM sử dụng một mục tiêu phản biện để căn chỉnh các nhúng của một GNN và một LLM, cho phép LLM tích hợp thông tin cấu trúc từ GNN trong khi GNN được hưởng lợi từ kiến thức ngữ nghĩa của LLM.

Thách thức và Giải pháp

Mặc dù việc tích hợp LLMs và học đồ thị mang lại tiềm năng lớn, nhưng có một số thách thức cần được giải quyết:

- Hiệu suất và Khả năng Mở Rộng: LLMs thường đòi hỏi tài nguyên lớn, thường cần hàng tỷ tham số và sức mạnh tính toán lớn để huấn luyện và suy luận. Điều này có thể là một rào cản đáng kể đối với việc triển khai các mô hình học đồ thị được tăng cường bằng LLMs trong các ứng dụng thực tế, đặc biệt là trên các thiết bị có tài nguyên hạn chế.

Một giải pháp triển vọng là luyện chuyển giao tri thức, trong đó kiến thức từ một LLM lớn (mô hình giáo viên) được chuyển sang một GNN nhỏ hơn, hiệu quả hơn (mô hình học sinh).

- Rò rỉ Dữ liệu và Đánh giá: LLMs được tiền huấn trên lượng lớn dữ liệu công khai, có thể bao gồm các tập kiểm tra từ các tập dữ liệu thử nghiệm phổ biến, dẫn đến nguy cơ rò rỉ dữ liệu và đánh giá hiệu suất được đánh giá cao hơn thực tế. Các nhà nghiên cứu đã bắt đầu thu thập các tập dữ liệu mới hoặc lấy mẫu dữ liệu kiểm tra từ các giai đoạn thời gian sau khi cắt quá trình huấn luyện của LLM để giảm thiểu vấn đề này.

Ngoài ra, việc thiết lập các tiêu chuẩn đánh giá công bằng và toàn diện cho các mô hình học đồ thị được tăng cường bằng LLMs là rất quan trọng để đo lường khả năng thực sự của chúng và thực hiện các so sánh có ý nghĩa.

- Khả năng Chuyển giao và Khả năng Giải thích: Mặc dù LLMs xuất sắc trong việc học từ ít hoặc không có dữ liệu, khả năng của chúng trong việc chuyển giao tri thức qua các lĩnh vực và cấu trúc đồ thị đa dạng vẫn là một thách thức mở. Cải thiện khả năng chuyển giao của các mô hình này là một hướng nghiên cứu quan trọng.

Hơn nữa, việc nâng cao khả năng giải thích của các mô hình học đồ thị dựa trên LLMs là cực kỳ quan trọng để xây dựng sự tin tưởng và cho phép chúng được áp dụng trong các ứng dụng quan trọng. Tận dụng khả năng suy luận tự nhiên có sẵn của LLMs thông qua các kỹ thuật như khuyến nghị chuỗi suy luận có thể góp phần cải thiện khả năng giải thích.

- Tích hợp Đa dạng Modal: Đồ thị thường chứa nhiều hơn chỉ thông tin văn bản, với các nút và cạnh có thể liên quan đến các dạng modal khác nhau, chẳng hạn như hình ảnh, âm thanh, hoặc dữ liệu số. Mở rộng việc tích hợp của LLMs vào các cài đặt đồ thị đa dạng modal này là một cơ hội hấp dẫn cho nghiên cứu tương lai.

Ứng dụng Thực tế và Các Nghiên cứu Thực tế

Sự tích hợp giữa LLMs và học máy trên đồ thị đã cho thấy kết quả hứa hẹn trong các ứng dụng thực tế khác nhau:

- Dự Đoán Tính Chất Molecul: Trong lĩnh vực hóa học tính toán và phát hiện thuốc, LLMs đã được sử dụng để cải thiện dự đoán các tính chất của phân tử bằng cách tích hợp thông tin cấu trúc từ các đồ thị phân tử. Ví dụ, mô hình LLM4Mol tận dụng ChatGPT để tạo ra các giải thích cho các biểu diễn SMILES (Simplified Molecular-Input Line-Entry System) của các phân tử, sau đó được sử dụng để cải thiện độ chính xác của các nhiệm vụ dự đoán tính chất.

- Hoàn thành và Suy luận Đồ Thị Tri Thức: Các đồ thị tri thức là một loại đồ thị đặc biệt đại diện cho các thực thể và mối quan hệ của chúng. LLMs đã được khám phá cho các nhiệm vụ như hoàn thành và suy luận đồ thị tri thức, nơi cấu trúc đồ thị và thông tin văn bản (ví dụ: mô tả thực thể) cần được xem xét cùng nhau.

- Hệ thống Gợi Ý: Trong lĩnh vực hệ thống gợi ý, các cấu trúc đồ thị thường được sử dụng để đại diện cho tương tác người dùng-vật phẩm, với các nút đại diện cho người dùng và vật phẩm, và các cạnh biểu thị các tương tác hoặc tương đồng. LLMs có thể được sử dụng để cải thiện các đồ thị này bằng cách tạo ra thông tin phụ cho người dùng/vật phẩm hoặc củng cố các cạnh tương tác.

Kết Luận

Sự tương tác giữa các Mô hình Ngôn Ngữ Lớn và Học Máy Trên Đồ Thị mở ra một lãnh vực nghiên cứu hứa hẹn trong trí tuệ nhân tạo. Bằng cách kết hợp đặc tính cá thể của GNNs với khả năng hiểu ngữ nghĩa mạnh mẽ của các LLMs, chúng ta có thể mở ra những khả năng mới trong các nhiệm vụ học trên đồ thị, đặc biệt là đối với các đồ thị có thuộc tính văn bản.

Mặc dù đã đạt được tiến bộ đáng kể, nhưng vẫn còn những thách thức trong các lĩnh vực như hiệu suất, khả năng mở rộng, khả năng chuyển giao và khả năng giải thích. Các kỹ thuật như luyện chuyển giao tri thức, các tiêu chuẩn đánh giá công bằng và tích hợp đa dạng modal đang mở đường cho việc triển khai thực tế của các mô hình học đồ thị được tăng cường bằng LLMs trong các ứng dụng thực tế.