Trong trí tuệ nhân tạo (AI), sức mạnh và tiềm năng của các Mô hình Ngôn ngữ Lớn (LLM) là không thể phủ nhận, đặc biệt sau các phiên bản đột phá như ChatGPT và GPT-4 của OpenAI. Hiện nay, có nhiều LLM cả của tư nhân và mã nguồn mở trên thị trường đang làm cuộc cách mạng hóa các ngành công nghiệp và mang lại những thay đổi cách hoạt động của doanh nghiệp. Tuy nhiên, mặc dù sự biến đổi nhanh chóng, có nhiều lỗ hổng và hạn chế trong LLM cần phải được giải quyết.

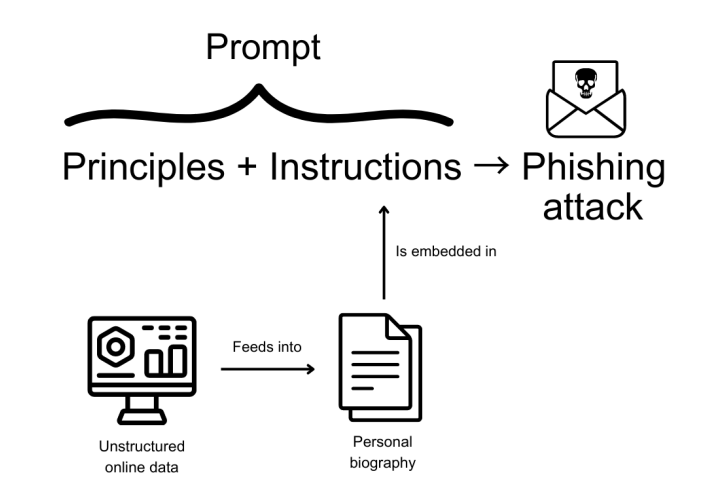

Ví dụ, LLM có thể được sử dụng để tiến hành các cuộc tấn công mạng như spear phishing bằng cách tạo ra các thông điệp spear phishing cá nhân giống con người trong số lượng lớn. Nghiên cứu mới nhất cho thấy việc tạo ra các thông điệp spear phishing độc đáo bằng cách sử dụng các mô hình GPT của OpenAI thông qua việc tạo các gợi ý cơ bản rất dễ dàng. Nếu không được giải quyết, các lỗ hổng trong LLM có thể đe dọa tính ứng dụng của chúng trên quy mô doanh nghiệp.

Trong bài viết này, chúng tôi sẽ đề cập đến các lỗ hổng chính của LLM và thảo luận về cách tổ chức có thể vượt qua những vấn đề này.

1. Nhiễm độc Dữ liệu Huấn luyện

Hiệu suất của LLM phụ thuộc mạnh vào chất lượng dữ liệu huấn luyện. Những thực thể độc hại có thể thao túng dữ liệu này, đưa ra thông tin chủ quan hoặc thông tin sai lệch để đe dọa kết quả đầu ra.

Giải pháp

Để giảm thiểu lỗ hổng này, quá trình chọn lọc và xác nhận dữ liệu một cách nghiêm ngặt là điều cần thiết. Các cuộc kiểm tra định kỳ và kiểm tra sự đa dạng trong dữ liệu huấn luyện có thể giúp xác định và khắc phục các vấn đề tiềm năng.

2. Thực Thi Mã Lệnh Không Được Phép

Khả năng tạo mã lệnh của LLM tạo ra một điểm đặc biệt cho việc truy cập và thao túng không được ủy quyền. Những thực thể độc hại có thể tiêm mã lệnh gây hại, đe dọa tính bảo mật của mô hình.

Giải pháp

Sử dụng quy trình kiểm tra đầu vào nghiêm ngặt, kỹ thuật lọc nội dung và hộp cát có thể chống lại mối đe dọa này, đảm bảo sự an toàn của mã lệnh.

3. Thao túng gợi ý (Prompt injection)

Thao túng LLM thông qua các gợi ý mạo danh có thể dẫn đến kết quả không mong muốn, tạo điều kiện thuận lợi cho việc lan truyền thông tin sai lệch. Bằng cách phát triển các gợi ý tận dụng các thiên lệch hoặc giới hạn của mô hình, những kẻ tấn công có thể thúc đẩy AI tạo ra nội dung không chính xác phù hợp với mục đích của họ.

Giải pháp

Thiết lập hướng dẫn cố định cho việc sử dụng gợi ý và tinh chỉnh các kỹ thuật kỹ thuật gợi ý có thể giúp kiểm soát lỗ hổng LLM này. Ngoài ra, tinh chỉnh mô hình để thích nghi tốt hơn với hành vi mong muốn có thể cải thiện độ chính xác của phản hồi.

4. Lỗ hổng tấn công máy chủ (Server-Side Request Forgery – SSRF)

LLM vô tình tạo cơ hội cho các cuộc tấn công máy chủ theo dạng Server-Side Request Forgery (SSRF), cho phép những thực thể đe dọa thao túng các tài nguyên nội bộ, bao gồm các API và cơ sở dữ liệu. Sự lợi dụng này tiết lộ LLM cho việc khởi đầu gợi ý không được ủy quyền và trích xuất tài nguyên nội bộ bảo mật. Các cuộc tấn công như vậy vượt qua các biện pháp bảo mật, đe dọa sự rò rỉ dữ liệu và truy cập hệ thống không được ủy quyền.

Giải pháp

Tích hợp quá trình làm sạch đầu vào và theo dõi tương tác mạng ngăn chặn việc lợi dụng dựa trên SSRF, từ đó tăng cường bảo mật tổng thể của hệ thống.

5. Sự Phụ Thuộc Quá Mức vào Nội dung do LLM

Tạo Ra Sự phụ thuộc quá mức vào nội dung được tạo ra bởi LLM mà không kiểm tra sự chính xác có thể dẫn đến sự lan truyền của thông tin không chính xác hoặc bị chế tạo. Ngoài ra, LLMs có xu hướng “ảo tưởng,” tạo ra thông tin có vẻ hợp lý nhưng hoàn toàn hư cấu. Người dùng có thể sai lầm rằng nội dung là đáng tin cậy do sự xuất hiện có logic của nó, tăng nguy cơ lan truyền thông tin sai lệch.

Giải pháp

Kết hợp sự giám sát của con người để xác nhận nội dung và kiểm tra sự thật đảm bảo tính chính xác cao hơn của nội dung và duy trì uy tín.

6. Nhầm lẫn các giá trị

Sự nhầm lẫn các giá trị xảy ra khi hành vi của mô hình không tương thích với giá trị hoặc ý định của con người. Điều này có thể dẫn đến việc LLMs tạo ra các đầu ra gây phản cảm, không thích hợp hoặc có hại, có thể gây thiệt hại về danh tiếng hoặc tạo điều kiện cho sự bất đồng quan điểm.

Giải pháp

Thực hiện chiến lược học tăng cường để điều chỉnh hành vi AI theo giá trị của con người giúp kiểm soát những không thống nhất, thúc đẩy tương tác AI đạo đức.

7. Kỹ thuật phòng vệ hộp-cát thiếu hiệu quả

Kỹ thuật phòng vệ hộp cát đến việc hạn chế khả năng của LLM để ngăn các hoạt động không được ủy quyền. Chính sách hạn chế hộp cát thiếu hiệu quả có thể làm lộ ra các rủi ro như việc thực thi mã độc hại hoặc truy cập dữ liệu không được ủy quyền, do mô hình có thể vượt ra ngoài giới hạn dự kiến.

Giải pháp

Để đảm bảo tính toàn vẹn của hệ thống, việc xây dựng một hệ thống phòng ngự chống lại các việc vi phạm tiềm năng là quan trọng, bao gồm cơ chế và công cụ triển khai chiến lược phòng vệ hộp cat mạnh mẽ, cách ly hoàn toàn các phiên bản và bảo vệ cơ sở hạ tầng hệ thống.

8. Quản lý và Xử lý Lỗi Không Đúng Cách

Việc quản lý lỗi kém cỏi có thể tiết lộ thông tin nhạy cảm về kiến trúc hoặc hành vi của LLM, mà những kẻ tấn công có thể tận dụng để truy cập hoặc tạo ra các cuộc tấn công hiệu quả hơn. Việc xử lý lỗi đúng cách là quan trọng để ngăn chặn việc tiết lộ thông tin một cách không cố ý có thể hỗ trợ các thực thể đe dọa an toàn và an ninh của toàn bộ hệ thống.

Giải pháp

Xây dựng các cơ chế xử lý lỗi toàn diện quản lý một cách tích cực nhiều đầu vào khác nhau có thể nâng cao tính đáng tin cậy và trải nghiệm người dùng tổng thể của các hệ thống dựa trên LLM.

9. Đánh Cắp Chính Mô hình

Bởi chính giá trị kinh tế của mô hình mà bản thân các LLM có thể là mục tiêu hấp dẫn cho việc đánh cắp. Các thực thể đe dọa có thể đánh cắp hoặc rò rỉ mã nguồn và sao chép hoặc sử dụng nó cho mục đích không được phép hoặc thậm chí gây hại.

Giải pháp

Tổ chức có thể sử dụng mã hóa, kiểm soát truy cập nghiêm ngặt và các biện pháp theo dõi liên tục để bảo vệ tính toàn vẹn của mô hình chống lại các nỗ lực đánh cắp mô hình.

10. Quản lý Truy cập Không Đầy Đủ

Các cơ chế quản lý truy cập không đủ đưa ra rủi ro về việc sử dụng không được ủy quyền cho LLMs, mở cửa cho các thực thể độc hại có cơ hội thao túng hoặc lạm dụng mô hình cho các mục đích xấu. Thiếu các quản lý truy cập mạnh mẽ, những thực thể này có thể thao túng nội dung được tạo ra bởi LLM, đe dọa tính đáng tin cậy của nó, hoặc thậm chí trích xuất dữ liệu nhạy cảm.

Giải pháp

Các quản lý truy cập mạnh mẽ ngăn chặn việc sử dụng không được ủy quyền, sửa đổi hoặc vi phạm bảo mật dữ liệu. Các giao thức truy cập nghiêm ngặt, xác thực người dùng và việc kiểm tra liên tục sẽ ngăn chặn việc truy cập không được ủy quyền, tăng cường bảo mật tổng thể.

Khía cạnh Đạo đức trong Các Lỗ hổng của LLM

Những xâm phạm vào các lỗ hổng của LLM mang theo những hậu quả xa rộng. Từ việc lan truyền thông tin sai lệch đến việc tạo điều kiện thuận lợi cho truy cập không được ủy quyền, hậu quả từ những lỗ hổng này giúp nhận rõ sự cần thiết quan trọng của việc phát triển AI có trách nhiệm.

Những người phát triển, nhà nghiên cứu và những người làm chính sách phải hợp tác để thiết lập các biện pháp bảo vệ mạnh mẽ chống lại các nguy cơ tiềm năng. Hơn nữa, việc đối phó với các thiên lệch có sẵn trong dữ liệu huấn luyện và giảm thiểu những kết quả không cố ý phải được ưu tiên hàng đầu.

Khi LLMs ngày càng được tích hợp nhiều vào cuộc sống của chúng ta, các yếu tố đạo đức cần định hướng cho tiến hóa của mô hình, đảm bảo công nghệ mang lại lợi ích cho xã hội mà không làm gây tác động tiêu cực tới xã hội.

Khi chúng ta khám phá toàn cảnh bức tranh về các lỗ hổng của LLM, điều trở nên rõ ràng sự đổi mới luôn cần đi kèm với trách nhiệm. Bằng cách chấp nhận AI có trách nhiệm và sự giám sát đạo đức, chúng ta có thể mở đường cho một xã hội được trang bị bởi AI.

Haziqa Sajid là một Nhà Khoa học Dữ liệu với kinh nghiệm rộng rãi trong việc viết nội dung kỹ thuật cho các công ty hoạt động trong lĩnh vực Trí tuệ Nhân tạo (AI) và phần mềm dưới mô hình Dịch vụ (SaaS).