ngày 12 tháng 10 năm 2023

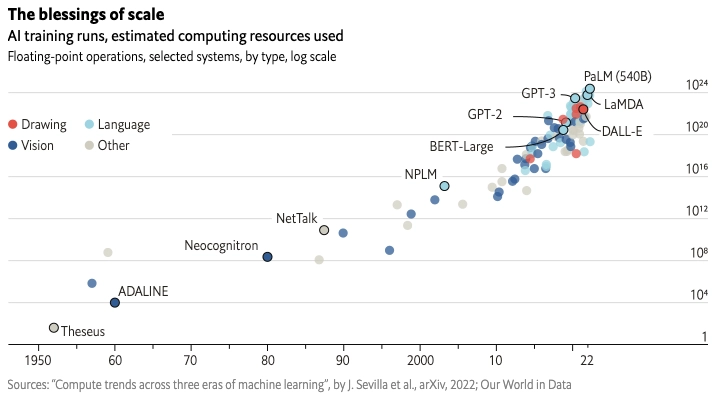

Như hình ảnh ở trên mô tả, số lượng tham số (do đó bề rộng và độ sâu) của các mạng nơ-ron và do đó kích thước của mô hình đang tăng lên. Để xây dựng các mô hình học sâu tốt hơn và cung cấp sức mạnh cho các ứng dụng Trí tuệ Nhân tạo (AI) sinh sáng, các tổ chức cần nhiều sức mạnh tính toán và băng thông bộ nhớ hơn.

Các chip mạnh mẽ đa dụng (như CPU) không thể hỗ trợ các mô hình học sâu được song song hóa mạnh mẽ. Do đó, các chip AI cho phép khả năng tính toán song song đang được tăng cầu, và theo McKinsey, xu hướng này sẽ tiếp tục.

Tuy nhiên, ngay cả Intel, có nhiều kỹ sư hàng đầu thế giới và lịch sử nghiên cứu mạnh mẽ, cũng cần ba năm làm việc để phát triển chip AI riêng của họ. Do đó, đối với hầu hết các công ty, việc mua chip từ các nhà cung cấp này hoặc thuê công suất từ các nhà cung cấp GPU điện toán đám mây là cách duy nhất để phát triển các mô hình học sâu mạnh mẽ. Bài viết này sẽ giới thiệu các nhà cung cấp chip AI hàng đầu để giúp các công ty lựa chọn đúng lựa chọn.

Các nhà sản xuất chip Trí tuệ Nhân tạo (AI) hàng đầu là:

1. Nvidia

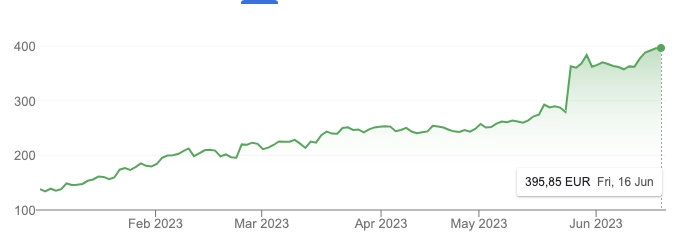

Nvidia đã sản xuất các đơn vị xử lý đồ họa (GPU) cho lĩnh vực trò chơi từ thập kỷ 1990. PlayStation 3 và Xbox đều sử dụng mảng đồ họa của Nvidia. Công ty cũng sản xuất các chip AI như Volta, Xavier và Tesla. Nhờ sự bùng nổ của Trí tuệ Nhân tạo sinh sáng, NVIDIA đã có kết quả xuất sắc trong Quý 2 năm 2023, đạt tỷ đô về giá trị và củng cố vị trí dẫn đầu trên thị trường GPU và phần cứng AI.

Các bộ vi xử lý của NVIDIA được thiết kế để giải quyết các vấn đề kinh doanh trong các ngành công nghiệp khác nhau. Xavier, ví dụ, là cơ sở cho một giải pháp lái xe tự động, trong khi Volta hướng đến các trung tâm dữ liệu. DGX™ A100 và H100 là các chip AI cơ bản của Nvidia, được thiết kế cho việc đào tạo và suy luận AI trong các trung tâm dữ liệu. A100 tích hợp 8 GPU và lên đến 640GB bộ nhớ GPU. Nvidia Grace là mẫu chip AI mới mà công ty phát hành cho thị trường HPC vào năm 2023.

Đối với công việc AI trên đám mây, Nvidia gần như độc quyền với hầu hết các nhà cung cấp đám mây đều cung cấp GPU Nvidia như GPU đám mây. Nvidia cũng đã ra mắt dịch vụ DGX Cloud cung cấp cơ sở hạ tầng GPU đám mây trực tiếp cho các doanh nghiệp.

2. Advanced Micro Devices (AMD)

AMD là một nhà sản xuất chip có các sản phẩm bộ xử lý CPU, đồ họa GPU và sản phẩm gia tốc Trí tuệ Nhân tạo (AI). Ví dụ, thẻ gia tốc trung tâm dữ liệu Alveo U50 của AMD có 50 tỷ transistor. Thẻ gia tốc này có khả năng chạy 10 triệu bộ dữ liệu nhúng và thực hiện các thuật toán đồ thị trong vài mili giây.

Vào tháng 6 năm 2023, AMD đã ra mắt sản phẩm MI300 dành cho công việc đào tạo AI và sẽ cạnh tranh với NVIDIA để chia sẻ thị trường trong lĩnh vực này. Có một số công ty khởi nghiệp đã sử dụng phần cứng AMD vào năm 2023 vì phần cứng AI của Nvidia khó mua do nhu cầu tăng vọt với sự bùng nổ của Trí tuệ Nhân tạo sinh sáng, như đã thể hiện bởi ChatGPT.

3. Intel

Intel là nhà sản xuất chip CPU lớn nhất và có lịch sử phát triển bán dẫn dài hơi. Vào năm 2017, Intel đã trở thành công ty sản xuất chip AI đầu tiên trên thế giới vượt qua mốc doanh số bán hàng 1 tỷ đô la.

Bộ xử lý Xeon của Intel, phù hợp cho nhiều công việc, bao gồm xử lý trong các trung tâm dữ liệu, đã có ảnh hưởng đến thành công thương mại của công ty. So với các thế hệ trước, dòng sản phẩm Xeon platinum thế hệ thứ ba có tới 40 lõi và băng thông bộ nhớ lớn gấp 1.6 lần, và dung lượng bộ nhớ lớn gấp 2.66 lần so với thế hệ trước.

Gaudi là bộ gia tốc đào tạo mạng nơ-ron từ Intel. Sản phẩm này có khả năng tỷ lệ khi các mô hình trở nên lớn hơn và có chi phí sở hữu tổng cộng tương đối thấp. Đối với công việc suy luận, Intel có sản phẩm Goya, được tối ưu hóa cho hiệu suất và độ trễ.

Intel® NCS2 là chip Trí tuệ Nhân tạo mới nhất từ Intel và đã được phát triển đặc biệt cho học sâu.

4. Alphabet / Google Cloud Platform

Google Cloud TPU là chip gia tăng máy học được xây dựng đặc biệt để cung cấp sức mạnh máy học cho các sản phẩm của Google như Dịch, Ảnh, Tìm kiếm, Trợ lý và Gmail. Nó cũng có thể được sử dụng thông qua Google Cloud. Google đã thông báo về TPUs vào năm 2016.

Edge TPU, một chip gia tăng khác từ Alphabet của Google, nhỏ hơn một xu duy nhất và được thiết kế cho các thiết bị ở cạnh như điện thoại thông minh, máy tính bảng và các thiết bị IoT.

5. AWS

AWS sản xuất chip Tranium cho việc đào tạo mô hình và chip Inferentia cho việc suy luận. Mặc dù AWS là người dẫn đầu thị trường đám mây công cộng, nhưng họ bắt đầu xây dựng các chip riêng sau Google.

6. IBM

IBM đã thông báo về chip học sâu mới nhất của họ, đơn vị Trí tuệ Nhân tạo (AIU), vào năm 2022. IBM đang xem xét việc sử dụng các chip này để cung cấp sức mạnh cho nền tảng Trí tuệ Nhân tạo sinh sáng watson.x của họ.

AIU được xây dựng trên “Bộ xử lý IBM Telum” cung cấp khả năng xử lý AI cho các máy chủ chính IBM Z. Khi ra mắt, các trường hợp sử dụng nổi bật của bộ xử lý Telum bao gồm phát hiện gian lận.

“Những startup công nghệ chip trí tuệ nhân tạo hàng đầu là ai?

Chúng tôi cũng muốn giới thiệu một số startup trong ngành công nghệ chip trí tuệ nhân tạo, mà chúng ta có thể nghe tên thường xuyên hơn trong tương lai gần. Mặc dù những công ty này mới thành lập gần đây, họ đã huy động được hàng triệu đô la.”

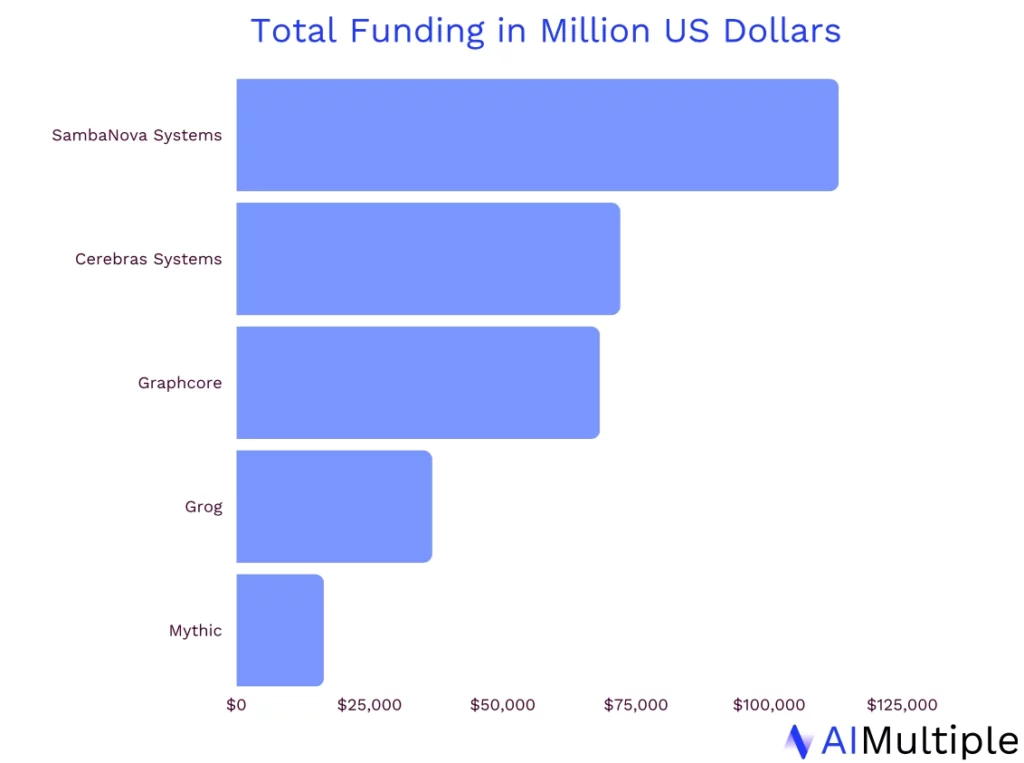

7. SambaNova Systems

SambaNova Systems được thành lập vào năm 2017 với mục tiêu phát triển các hệ thống phần cứng-phan mềm hiệu suất cao, chính xác cao cho các tải công việc trí tuệ nhân tạo tạo ra dự án lớn. Công ty đã phát triển chip SN40L và đã huy động hơn 1,1 tỷ đô la trong quỹ đầu tư.

Đáng chú ý, SambaNova Systems cũng cho thuê nền tảng của họ cho các doanh nghiệp. Phương pháp cung cấp nền tảng trí tuệ nhân tạo dưới dạng dịch vụ của SambaNova Systems giúp hệ thống của họ dễ dàng áp dụng và thúc đẩy việc sử dụng lại phần cứng để ủng hộ nền kinh tế vòng tròn.

8. Cerebras Systems

Cerebras Systems được thành lập vào năm 2015. Vào tháng 4 năm 2021, công ty đã thông báo mẫu chip trí tuệ nhân tạo mới của họ, Cerebras WSE-2, với 850.000 lõi và 2,6 tỷ transistor. Không thể phủ nhận rằng WSE-2 là một bước tiến lớn so với WSE-1, có 1,2 tỷ transistor và 400.000 lõi xử lý.

Hệ thống của Cerebras được sử dụng bởi nhiều công ty dược phẩm như AstraZeneca và GlaxoSmithKline vì công nghệ hiệu quả của WSE-1 gia tăng tốc quá trình nghiên cứu di truyền và genom và giúp rút ngắn thời gian tìm kiếm thuốc.

9. Groq

Groq được thành lập bởi các cựu nhân viên của Google. Công ty đại diện cho một mô hình mới về kiến trúc chip trí tuệ nhân tạo nhằm làm cho việc các công ty áp dụng hệ thống của họ dễ dàng hơn. Startup này đã huy động được khoảng 350 triệu đô la và đã sản xuất các mẫu sản phẩm đầu tiên như GroqChip™ Processor, GroqCard™ Accelerator, và nhiều sản phẩm khác.

Vào ngày 1 tháng 3 năm 2022, Groq đã mua lại Maxeler, một công ty có các giải pháp máy tính hiệu năng cao (HPC) cho dịch vụ tài chính.

10. Mythic

Mythic được thành lập vào năm 2012. Công ty đã phát triển các sản phẩm như M1076 AMP, MM1076 key card, và đã huy động được khoảng 150 triệu đô la trong quỹ đầu tư.

Các nhà sản xuất chip trí tuệ nhân tạo khác bao gồm

Alibaba

Alibaba sản xuất các chip như Hanguang 800 dùng cho việc suy diễn. Họ được liệt kê trong danh mục này do một số tổ chức ở Mỹ và EU (ví dụ: các tổ chức trong ngành công nghiệp quốc phòng) có thể không ưa dùng Alibaba Cloud vì lý do địa chính trị.

Microsoft Azure

Theo báo cáo, Microsoft đang làm việc trên các chip trí tuệ nhân tạo riêng của họ, dự kiến sẽ ra mắt vào năm 2023.

Graphcore

Graphcore là một công ty Anh thành lập vào năm 2016. Công ty đã thông báo sản phẩm chính là chip trí tuệ nhân tạo IPU-POD256. Graphcore đã huy động được khoảng 700 triệu đô la.

Công ty có các đối tác chiến lược với các công ty lưu trữ dữ liệu như DDN, Pure Storage và Vast Data. Graphcore hợp tác với các viện nghiên cứu trên toàn cầu như Viện Tài chính Lượng tử Oxford-Man, Đại học Bristol và Đại học California Berkeley là các tổ chức nghiên cứu đáng tin cậy khác sử dụng chip trí tuệ nhân tạo của Graphcore.

Vào tháng 10 năm 2023, sự bền vững dài hạn của công ty có nguy cơ vì họ đang mất khoảng 200 triệu đô la mỗi năm và có tài sản khoảng 160 triệu đô la tính đến ngày 1 tháng 1 năm 2023.