Tác giả: Ravi Annavajjhala

Ngày 19 tháng 10 năm 2023

Sự xuất hiện của ChatGPT và Trí tuệ Nhân tạo (Generative AI) nói chung là một bước ngoặt quan trọng trong lịch sử công nghệ và được ví như sự mở đầu của Internet và điện thoại thông minh. Trí tuệ Nhân tạo Sinh sáng đã thể hiện tiềm năng vô tận trong khả năng tham gia vào cuộc trò chuyện thông minh, vượt qua các kỳ thi, tạo ra các chương trình/mã nguồn phức tạp và tạo ra hình ảnh và video đẹp mắt. Mặc dù các GPU chạy hầu hết các mô hình Trí tuệ Nhân tạo trong điện toán đám mây – cả để đào tạo và suy luận – nhưng đây không phải là một giải pháp có tính bền vững trong dài hạn, đặc biệt là đối với suy luận, do những yếu tố bao gồm chi phí, năng lượng, độ trễ, quyền riêng tư và bảo mật. Bài viết này đề cập đến mỗi trong những yếu tố này cùng với các ví dụ thúc đẩy việc di chuyển khối lượng công việc tính toán Trí tuệ Nhân tạo Sinh sáng đến biên (Edge)..

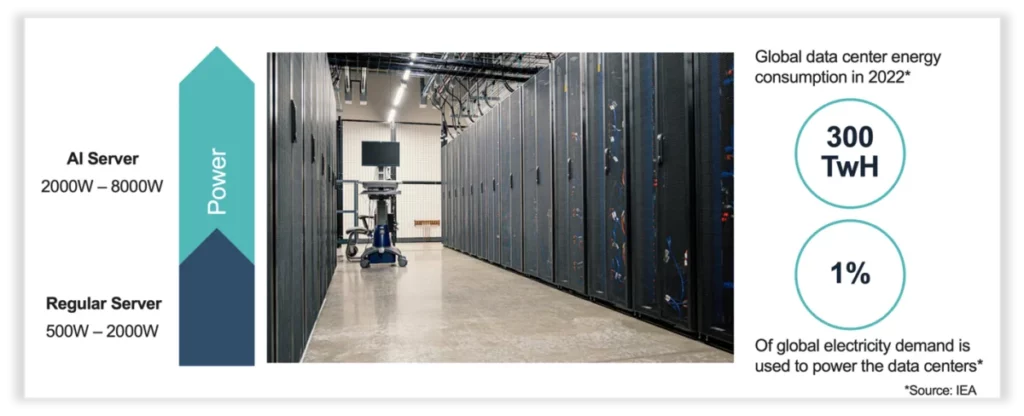

Hầu hết các ứng dụng chạy trên các bộ xử lý hiệu năng cao – hoặc trên thiết bị (ví dụ, điện thoại thông minh, máy tính để bàn, máy tính xách tay) hoặc trong trung tâm dữ liệu. Khi tỷ lệ ứng dụng sử dụng Trí tuệ Nhân tạo mở rộng, những bộ xử lý chỉ với CPU trở nên không đủ. Hơn nữa, sự mở rộng nhanh chóng trong khối lượng công việc Trí tuệ Nhân tạo đang tạo ra một nhu cầu tăng cấp mạnh mẽ cho các máy chủ hỗ trợ Trí tuệ Nhân tạo với GPU đắt tiền và tiêu thụ năng lượng lớn, đồng thời đẩy cao chi phí cơ sở hạ tầng. Những máy chủ hỗ trợ Trí tuệ Nhân tạo này có thể có giá gấp đến 7 lần giá của một máy chủ thông thường và GPU chiếm 80% của tổng chi phí này.

Hơn nữa, một máy chủ dựa trên đám mây tiêu thụ từ 500W đến 2000W, trong khi một máy chủ hỗ trợ Trí tuệ Nhân tạo tiêu thụ từ 2000W đến 8000W – nhiều hơn gấp 4 lần! Để hỗ trợ những máy chủ này, trung tâm dữ liệu cần các mô-đun làm mát bổ sung và nâng cấp cơ sở hạ tầng – điều này có thể đắt hơn cả đầu tư tính toán. Trung tâm dữ liệu hiện nay đã tiêu thụ 300 tỷ kilowatt-giờ mỗi năm, gần 1% tổng nhu cầu năng lượng trên toàn thế giới. Nếu xu hướng sử dụng Trí tuệ Nhân tạo tiếp tục, đến năm 2030, cứ tới 5% tổng nhu cầu năng lượng trên toàn thế giới có thể được sử dụng bởi các trung tâm dữ liệu. Ngoài ra, có một sự đầu tư chưa từng có vào các trung tâm dữ liệu Trí tuệ Nhân tạo Sinh sáng. Ước tính rằng đến năm 2027, các trung tâm dữ liệu có thể tiêu thụ lên đến 500 tỷ đô la cho các khoản chi phí vốn, chủ yếu do yêu cầu cơ sở hạ tầng Trí tuệ Nhân tạo.

Chi phí tính toán Trí tuệ Nhân tạo cũng như tiêu thụ năng lượng sẽ ngăn cản việc tiếp nhận rộng rãi của Trí tuệ Nhân tạo Sinh sáng. Những thách thức về quy mô có thể được vượt qua bằng cách di chuyển tính toán Trí tuệ Nhân tạo đến biên (Edge) và sử dụng các giải pháp xử lý được tối ưu hóa cho khối lượng công việc Trí tuệ Nhân tạo. Với cách tiếp cận này, khách hàng cũng thu được những lợi ích khác, bao gồm độ trễ, quyền riêng tư, đáng tin cậy, cũng như khả năng tăng cường.

Năng lực tính toán sẽ tiếp nối dữ liệu đến biên (Edge)

Tính từ khoảng một thập kỷ trước, khi Trí tuệ Nhân tạo nổi lên từ thế giới học thuật, việc đào tạo và suy luận của các mô hình Trí tuệ Nhân tạo đã diễn ra trong điện toán đám mây/trung tâm dữ liệu. Với hầu hết dữ liệu được tạo ra và tiêu thụ tại biên – đặc biệt là video – việc di chuyển suy luận của dữ liệu đến biên đã trở nên hợp lý, từ đó cải thiện tổng chi phí sở hữu (TCO) cho các doanh nghiệp do giảm chi phí mạng và tính toán. Trong khi chi phí suy luận Trí tuệ Nhân tạo trên điện toán đám mây là chi phí định kỳ, chi phí suy luận tại biên là một khoản chi phí phần cứng đầu tư một lần. Theo cách này, việc bổ sung hệ thống với một bộ xử lý Trí tuệ Nhân tạo tại biên giảm thiểu chi phí hoạt động tổng thể. Tương tự như việc di chuyển khối lượng công việc Trí tuệ Nhân tạo truyền thống đến biên (ví dụ: thiết bị cầm tay, máy móc tại biên), khối lượng công việc Trí tuệ Nhân tạo cũng sẽ làm điều tương tự. Điều này sẽ mang lại sự tiết kiệm đáng kể cho các doanh nghiệp và người tiêu dùng.

Sự di chuyển đến biên kết hợp với việc sử dụng một bộ gia tốc Trí tuệ Nhân tạo hiệu quả để thực hiện các chức năng suy luận đem lại những lợi ích khác nữa. Đầu tiên trong số chúng là độ trễ. Ví dụ, trong các ứng dụng chơi game, các nhân vật không phải của người chơi (NPC) có thể được kiểm soát và bổ sung bằng cách sử dụng Trí tuệ Nhân tạo Sinh sáng. Bằng cách sử dụng các mô hình LLM chạy trên các bộ gia tốc Trí tuệ Nhân tạo tại biên trong một hệ thống chơi game hoặc máy tính cá nhân, người chơi có thể đặt cho những nhân vật này mục tiêu cụ thể, để họ có thể tham gia vào câu chuyện một cách có ý nghĩa. Độ trễ thấp từ suy luận tại biên sẽ cho phép lời thoại và hành động của NPC phản ứng theo lệnh và hành động của người chơi trong thời gian thực. Điều này sẽ mang lại trải nghiệm chơi game cực kỳ sâu rộng một cách hiệu quả về chi phí và năng lượng.

Trong các ứng dụng như chăm sóc sức khỏe, quyền riêng tư và độ tin cậy rất quan trọng (ví dụ: đánh giá bệnh nhân, đề xuất thuốc). Dữ liệu và các mô hình Gen AI liên quan phải được cài đặt trên nơi để bảo vệ dữ liệu bệnh nhân (quyền riêng tư) và mọi sự cố mạng có thể gây chặn trở trong việc truy cập các mô hình Trí tuệ Nhân tạo ở đám mây có thể có hậu quả thảm khốc. Một thiết bị Trí tuệ Nhân tạo tại “Edge” chạy một mô hình Trí tuệ Nhân tạo Sinh sáng được thiết kế mục đích cho từng khách hàng doanh nghiệp – trong trường hợp này là một nhà cung cấp dịch vụ chăm sóc sức khỏe – có thể giải quyết một cách liền mạch vấn đề về quyền riêng tư và độ tin cậy trong khi giảm độ trễ và chi phí.

Nhiều mô hình Gen AI chạy trên đám mây có thể có đến gần một nghìn tỷ tham số – những mô hình này có thể giải quyết hiệu quả các truy vấn tổng quan. Tuy nhiên, các ứng dụng cụ thể cho doanh nghiệp đòi hỏi mô hình phải cung cấp kết quả liên quan đến trường hợp sử dụng. Hãy xem ví dụ của một trợ lý dựa trên Gen AI được xây dựng để nhận đặt hàng tại một nhà hàng thức ăn nhanh – để có một tương tác liền mạch với khách hàng, mô hình Gen AI cơ bản phải được đào tạo với các mục thực đơn của nhà hàng, biết cả về các dị ứng và thành phần. Kích thước mô hình có thể được tối ưu hóa bằng cách sử dụng một mô hình Ngôn ngữ Lớn (LLM) toàn bộ để đào tạo một LLM nhỏ tương đối, với 10-30 tỷ tham số và sau đó sử dụng sự điều chỉnh cụ thể khách hàng với dữ liệu. Một mô hình như vậy có thể cung cấp kết quả với độ chính xác và khả năng tăng cường. Và với kích thước mô hình nhỏ hơn, nó có thể được triển khai một cách hiệu quả trên bộ gia tốc Trí tuệ Nhân tạo tại biên.

Trí tuệ Nhân tạo sẽ chiến thắng tại biên (Edge)

Luôn luôn sẽ có nhu cầu cho Trí tuệ Nhân tạo Sinh sáng chạy trong đám mây, đặc biệt là đối với các ứng dụng tổng quan như ChatGPT và Claude. Nhưng khi đến các ứng dụng cụ thể cho doanh nghiệp, chẳng hạn như việc tạo ra nội dung trong Adobe Photoshop hoặc hệ thống hỗ trợ code trên Github, Trí tuệ Nhân tạo Sinh sáng tại biên (Edge) không chỉ là tương lai, mà còn là hiện tại. Các bộ gia tốc Trí tuệ Nhân tạo được xây dựng mục đích là chìa khóa để làm cho điều này trở nên có thể thực hiện.