H200 mới, dẫn đầu trong danh mục, có dung lượng bộ nhớ và băng thông lớn hơn, giúp tăng tốc quá trình làm việc với trí tuệ tạo sinh và mô hình ngôn ngữ lớn.

Ngày 13 tháng 11 năm 2023,

Tác giả: Jacob Kastrenakes, một biên tập viên phó giám đốc chịu trách nhiệm về bản tin công nghệ và tin tức. Kể từ khi gia nhập The Verge vào năm 2012, anh đã xuất bản hơn 5,000 câu chuyện và là biên tập sáng lập bộ phận tác giả.

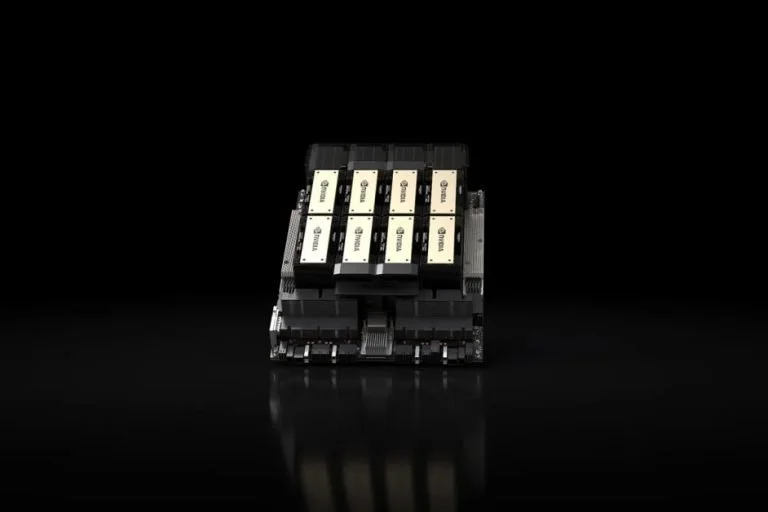

Nvidia đang giới thiệu một vi xử lý trí tuệ nhân tạo mới hàng đầu, đó là chip HGX H200. GPU mới nâng cấp từ phiên bản H100 đang rất được thị trường chờ đón với băng thông bộ nhớ tăng lên 1.4 lần và dung lượng bộ nhớ tăng lên 1.8 lần, cải thiện khả năng xử lý công việc trí tuệ tạo sinh mạnh mẽ.

Câu hỏi lớn là liệu các công ty có thể có được những chip mới hay không, hay liệu chúng sẽ bị giới hạn cung cấp như H100 hay không – và Nvidia chưa có câu trả lời chính xác cho điều đó. Những chip H200 đầu tiên sẽ được phát hành vào quý 2 năm 2024, và Nvidia cho biết họ đang hợp tác với “các nhà sản xuất hệ thống toàn cầu và các nhà cung cấp dịch vụ đám mây” để làm cho chúng có sẵn. Người phát ngôn của Nvidia, Kristin Uchiyama, từ chối bình luận về số lượng sản xuất.

Dường như H200 giữ nguyên nhiều tính năng so với H100 ngoại trừ bộ nhớ. Nhưng những thay đổi trong bộ nhớ tạo ra một bản nâng cấp đáng kể. GPU mới là sản phẩm đầu tiên sử dụng một loại bộ nhớ mới, nhanh hơn, được gọi là HBM3e. Điều này đưa băng thông bộ nhớ của GPU lên 4,8 terabytes mỗi giây, tăng từ 3,35 terabytes mỗi giây trên H100, và dung lượng bộ nhớ tổng cộng lên 141GB so với 80GB của phiên bản trước đó.

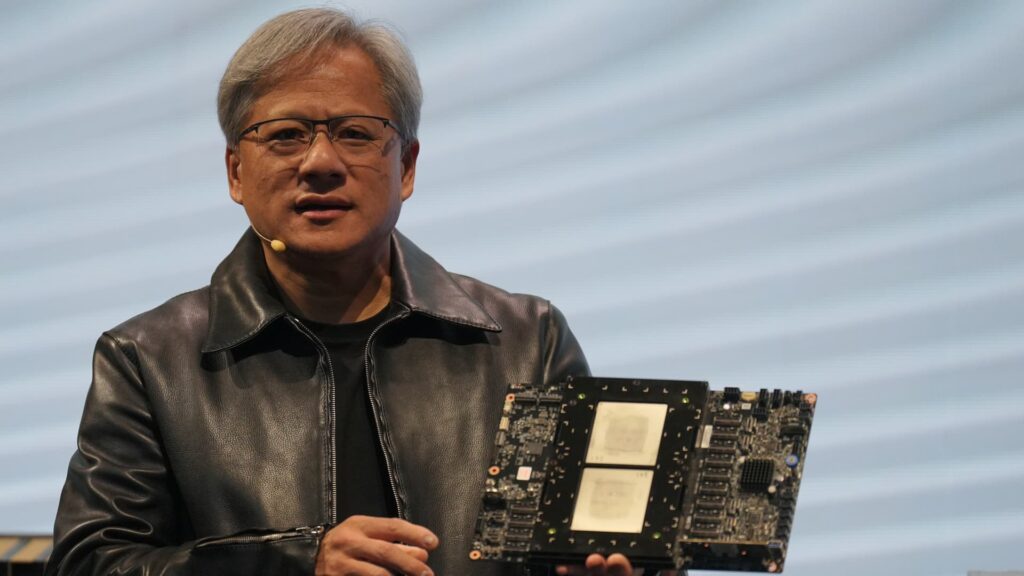

“Việc tích hợp bộ nhớ HBM nhanh hơn và rộng lớn hơn giúp tăng tốc hiệu suất trong các nhiệm vụ đòi hỏi tính toán cao bao gồm mô hình trí tuệ tạo sinh và ứng dụng máy tính hiệu suất cao, đồng thời tối ưu hóa sự sử dụng và hiệu quả của GPU,” Ian Buck, Phó Chủ tịch sản phẩm máy tính hiệu suất cao của Nvidia, nói trong buổi trình bày video sáng nay.

H200 cũng được thiết kế để tương thích với các hệ thống hiện đã hỗ trợ H100. Nvidia cho biết các nhà cung cấp dịch vụ đám mây sẽ không cần thực hiện bất kỳ thay đổi nào khi họ tích hợp H200 vào hệ thống của họ. Các đơn vị đám mây của Amazon, Google, Microsoft và Oracle sẽ là một trong những đơn vị đầu tiên cung cấp GPU mới này vào năm sau.

Khi ra mắt, các chip mới chắc chắn sẽ có giá cao. Nvidia không công bố giá cụ thể, nhưng CNBC cho biết rằng các chip H100 thế hệ trước được ước tính sẽ bán với giá từ 25,000 đến 40,000 đô la mỗi chiếc, với cần hàng nghìn chiếc để hoạt động ở mức độ cao nhất. Uchiyama cho biết giá được đặt bởi đối tác của Nvidia.

Thông báo của Nvidia đến trong khi các công ty trí tuệ nhân tạo vẫn đang tuyệt vọng tìm kiếm chip H100 của họ. Các chip của Nvidia được xem là lựa chọn tốt nhất để xử lý một lượng lớn dữ liệu cần thiết để đào tạo và vận hành các công cụ hình ảnh tạo sinh và các mô hình ngôn ngữ lớn. Những chip này đủ quý giá đến mức các công ty sử dụng chúng như tài sản thế chấp cho các khoản vay. Việc ai sở hữu H100 đã trở thành đề tài của những cuộc nói chuyện tại Silicon Valley, và các công ty startup đã hợp tác chỉ để chia sẻ quyền truy cập vào chúng.

Uchiyama cho biết sự xuất hiện của H200 sẽ không ảnh hưởng đến quá trình sản xuất của H100. “Bạn sẽ thấy chúng tôi tăng tổng cung cấp trong suốt năm và chúng tôi đang tiếp tục mua sắm cung ứng để dài hạn,” Uchiyama viết trong một email gửi đến The Verge.

Năm tới dường như sẽ là một thời điểm thuận lợi hơn cho người mua GPU. Vào tháng 8, Financial Times đưa tin Nvidia đang kế hoạch tăng ba lần sản xuất của H100 vào năm 2024. Mục tiêu là sản xuất tới 2 triệu chiếc vào năm sau, tăng lên từ khoảng 500,000 chiếc vào năm 2023. Nhưng với trí tuệ tạo sinh vẫn mạnh mẽ ngày nay như ở đầu năm, nhu cầu có thể chỉ tăng lên – và điều này là trước khi Nvidia tung ra một chip mới mạnh mẽ hơn.